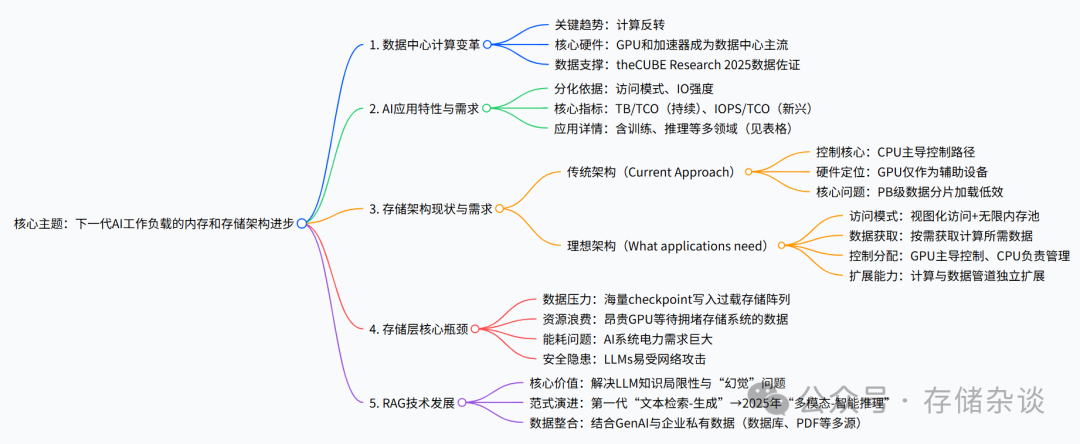

AI是2025 FMS上一个焦点话题,涉及到数据中心、大模型、存储等诸多话题。基于FMS相关topic,感谢豆包帮忙整理如下思维导图,本文以此展开相关讨论。

一、数据中心变天:计算反转成主流,GPU 主导数据中心方兴未艾

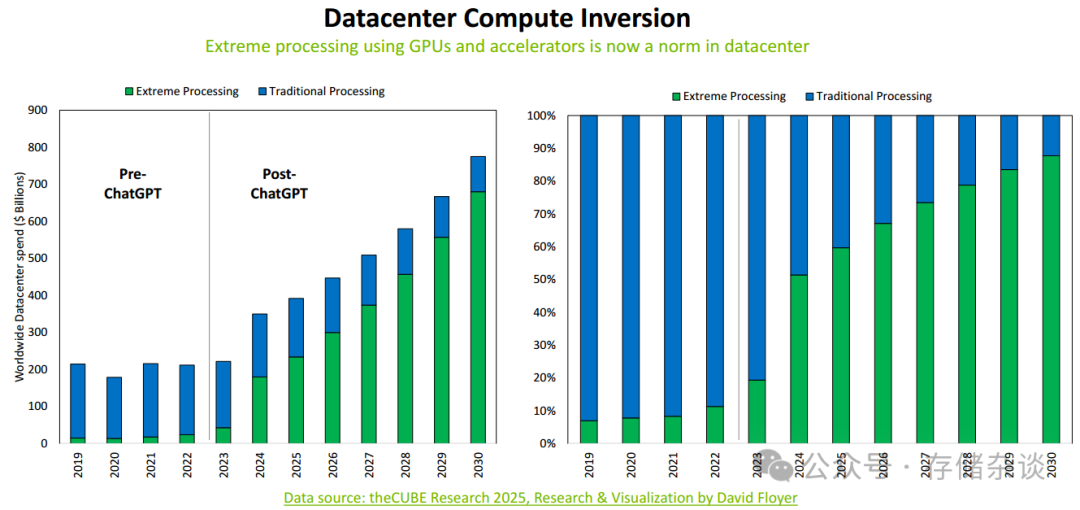

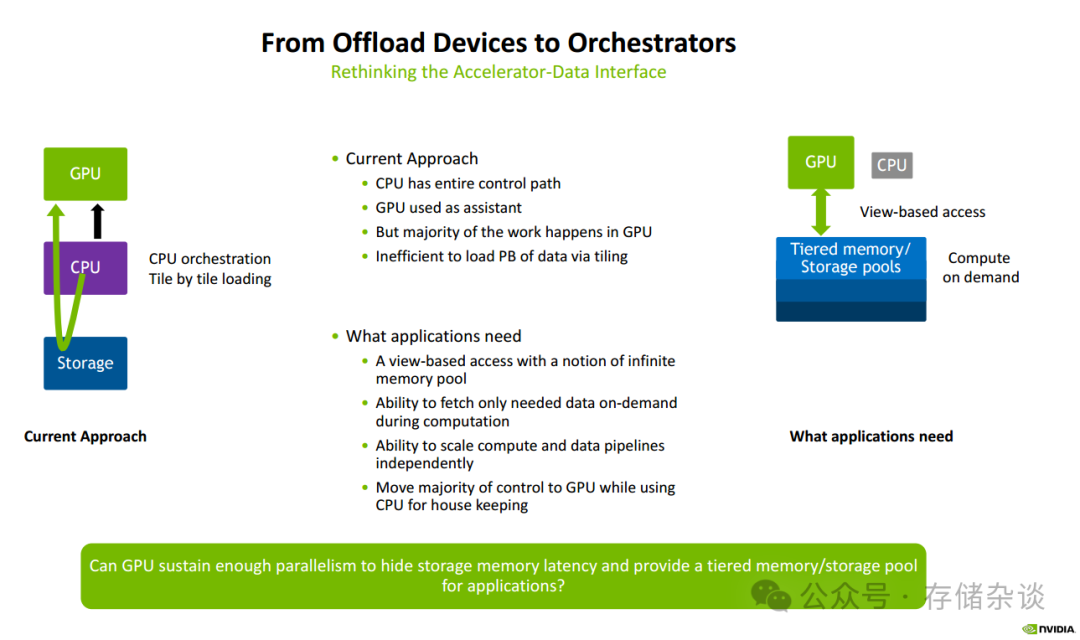

传统的、或者说我们大家熟知的数据中心架构,是基于CPU为核心的计算和存储体系,CPU在上层业务响应、数据流管理、底层数据管理等占据核心作用。下一代 AI 工作负载推动数据中心发生计算反转,以GPU 为核心的处理模式取代传统 CPU 主导的处理模式,成为数据中心的普遍选择。来自theCUBE Research 2025的研究数据显示,ChatGPT 等 AI 应用普及后,GPU 与加速器的应用占比大幅提升,传统处理模式占比显著下降。

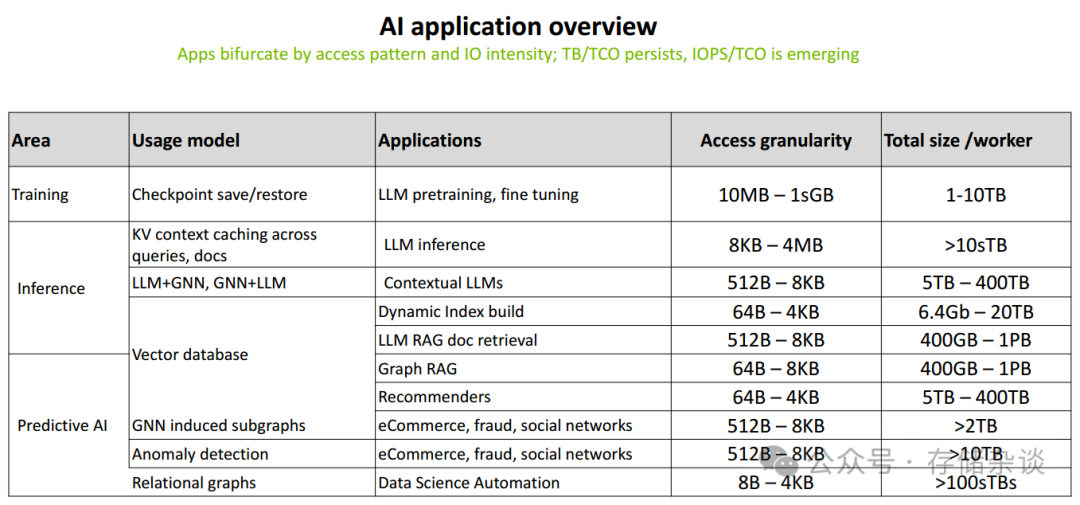

二、AI 应用的 “差异化需求”:从访问模式到数据规模,存储面临多元挑战

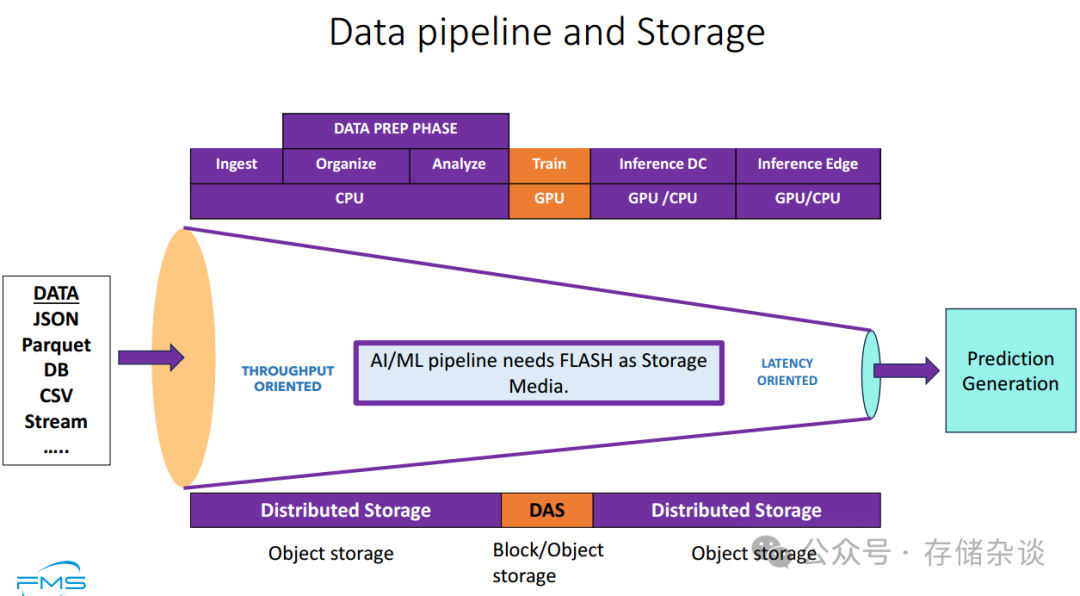

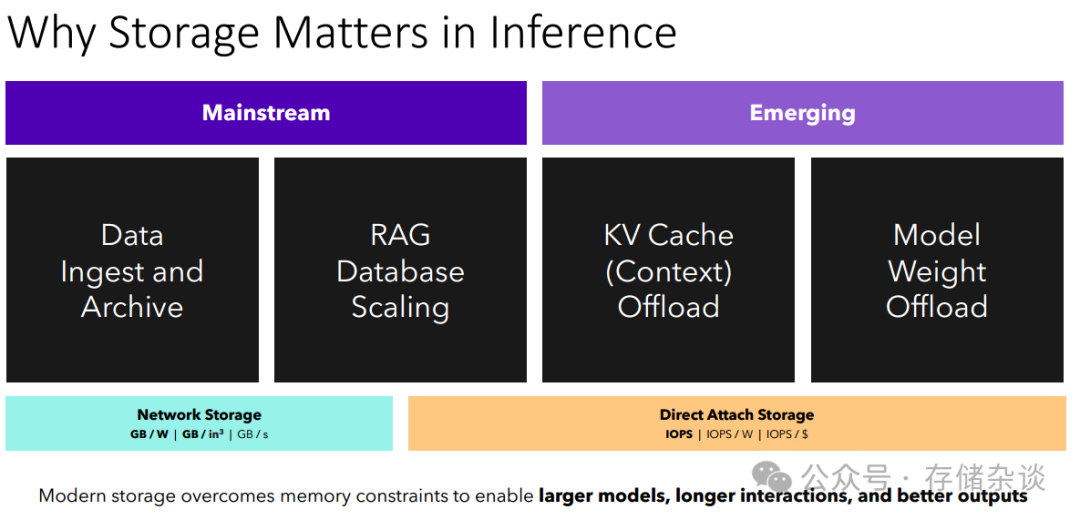

AI 应用并非 “一刀切”,而是根据访问模式和IO 强度呈现明显分化,对存储的要求也千差万别。FMS分享的应用特性表清晰揭示了不同场景的存储需求差异。

在数据流处理中,将从传统 CPU 主导到 GPU 核心,GPU 将从 “辅助设备” 升级为 “协调者”,重构加速器与数据的交互接口。

三、一切源于数据

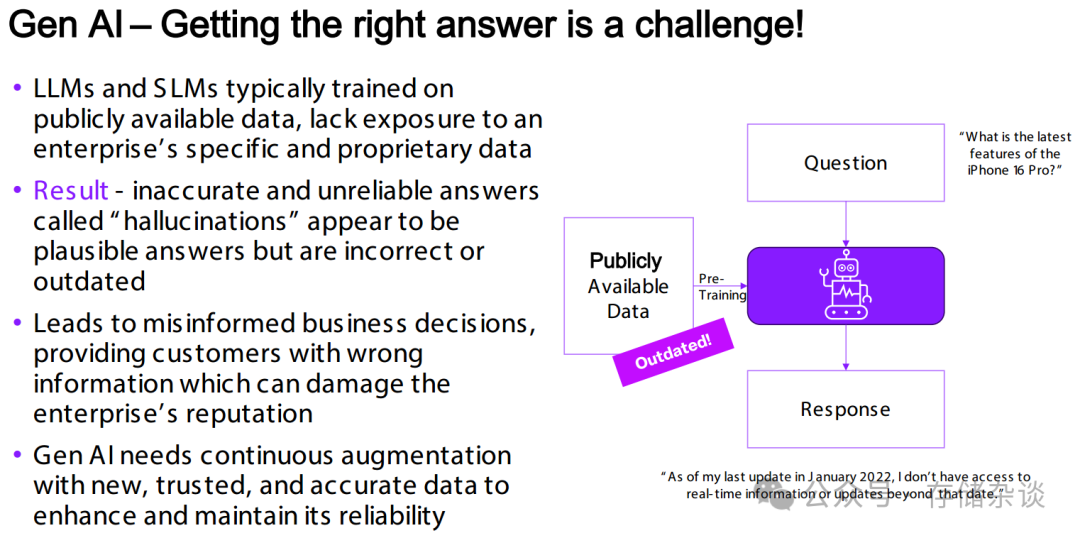

RAG 技术:从 “文本检索” 到 “多模态推理”,终结 LLM “幻觉”

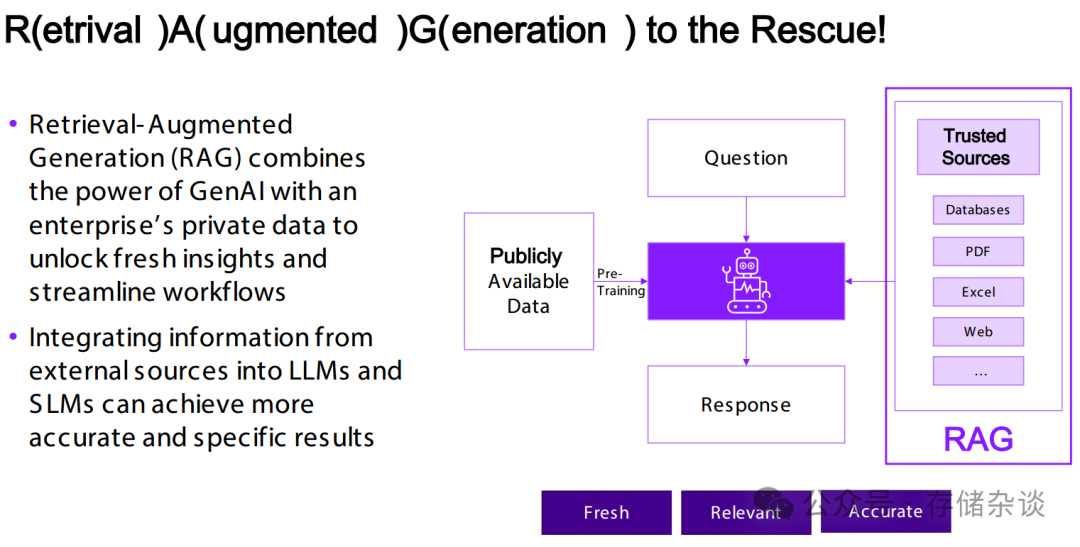

LLM “幻觉” 源于其仅依赖公开可用的训练数据(易过时、缺乏企业私有信息),而 RAG 通过整合企业私有数据(如数据库、PDF、Excel、网页等可信外部来源) 与 GenAI 能力,让 LLM 在生成输出前先检索实时、精准的特定数据,补充知识盲区,从而减少错误或过时答案的产生,提升输出准确性。

2025 年 RAG 技术迎来了深刻的范式演进:从第一代 “文本检索 - 生成” 模式,升级为下一代 “多模态 - 智能推理” 模式 —— 突破了单一文本数据的局限,可整合多类型、多格式数据,并具备更深度的智能推理能力,进一步强化了对企业复杂业务场景的适配性。

2025 年 AI 的规模化落地,离不开 “存储架构革新” 与 “RAG 技术进化” 的双轮驱动:存储架构解决 “数据高效流转” 问题,让 GPU 算力充分释放;RAG 技术解决 “知识可靠” 问题,让 AI 输出精准可用。

对于企业而言,把握这场存储与 RAG 的变革浪潮,不仅是技术升级的选择,更是在 AI 时代构建核心竞争力的关键。毕竟,当 AI 的算力不再受限于存储,知识不再困于 “幻觉”,才能真正释放数据驱动的价值。

RAG技术破解LLM幻觉

RAG技术破解LLM幻觉

661

661

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?