在之前的章节中,我们已经系统学习了vLLM的部署方法、推理机制和优化策略。今天,让我们进入第十三讲:vLLM案例研究,聚焦vLLM在企业级服务中的三大核心应用场景:可视化部署、RAG本地化部署与Agent应用开发,带你真正实现从“实验室”到“生产环境”的技术跨越。

一、 可视化部署:打破技术壁垒的关键一步

尽管vLLM凭借PagedAttention和连续批处理技术在高并发场景中表现出色,但在实际业务落地中仍面临两大挑战:

-

操作门槛高:非技术用户难以通过命令行调用模型;

-

调试不透明:缺乏实时监控与中间结果可视化能力。

可视化部署正是解决这些问题的关键。它通过图形化界面降低操作复杂度,通过监控面板提升交互透明度,并通过集成RAG、Agent等模块构建统一的业务开发框架。

1. Open WebUI:可视化部署利器

Open WebUI 是一款专为大模型设计的开源可视化工具,具备四大优势:

-

✅ 多框架兼容(Ollama、OpenAI API、vLLM)

-

✅ 本地化安全运行

-

✅ 模块化扩展(RAG、Python函数、插件)

-

✅ 用户友好(多终端适配、Markdown渲染)

图1 Open WebUI界面

2. Open WebUI + vLLM实战部署

下面我们以DeepSeek-LLM-7B-Chat模型为例,演示如何实现可视化部署:

环境准备(硬件建议):

-

GPU:RTX 3090(24GB)

-

内存:80GB

-

软件:Open-WebUI==0.6.5, vllm==0.8.4, Python==3.11

部署步骤:

-

环境准备:安装Miniconda并创建独立环境

-

模型下载:可通过魔搭社区或HuggingFace下载

-

启动vLLM服务:配置IP、端口、密钥等参数

-

部署Open WebUI:安装并启动Web服务

-

配置连接:在WebUI中添加vLLM服务地址与密钥

-

功能测试:在图形界面中完成模型对话

这一方案的优势十分明显:部署流程标准化、资源占用优化、交互体验提升,真正实现了“模型即服务”的本地化应用价值。

二、 vLLM实现RAG本地部署

大模型在问答中常面临“幻觉”问题,而RAG(检索增强生成) 技术通过实时检索外部知识库,为模型提供最新、可信的数据支撑,成为关键解决方案。

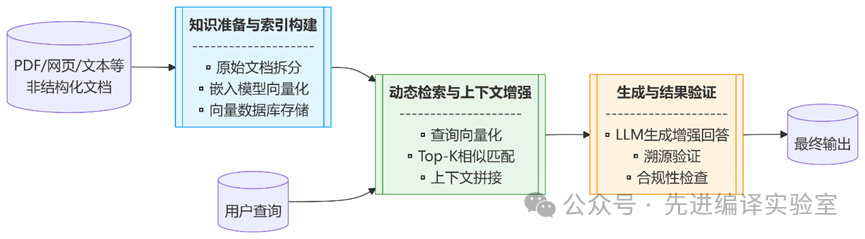

1. RAG技术原理

RAG工作流程包含三个核心模块:

-

知识准备与索引构建:文档切块、向量化、存入向量数据库

-

动态检索与上下文增强:查询向量化、相似度匹配、上下文拼接

-

生成与结果验证:基于增强信息生成回答,并进行溯源验证

图2 RAG技术工作流程

2. RAG本地知识库搭建实战

前提:已完成Open-WebUI与vLLM基础部署

配置步骤:

-

启用嵌入模型服务:以bge-m3模型为例,启动vLLM服务

-

Open WebUI端配置:设置文本分块、向量模型、检索参数等

-

知识库文件上传:创建知识库并上传文档

-

模型类配置与测试:建立含知识库的模型类并进行问答测试

关键参数解析:

-

Chunk Size:文本块大小,影响信息完整性与检索效率

-

Chunk Overlap:块间重叠区域,保留上下文关联

-

Top K:返回的最相似向量数量,平衡丰富性与计算成本

三、 vLLM构建Agent应用

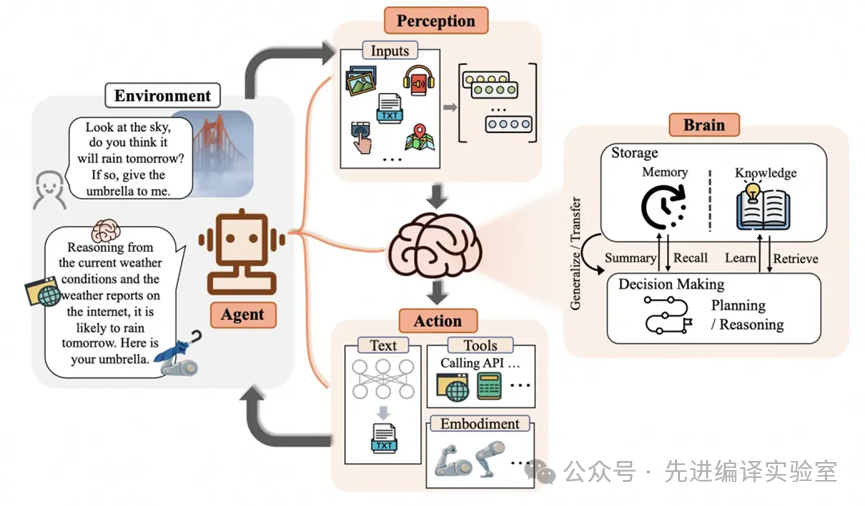

1. Agent:自主智能体核心框架

Agent 是具备自主感知、规划、执行与适应能力的软件实体,其核心价值在于:

-

🧠 自主决策:基于环境感知自主规划行动路径

-

🛠️ 工具调用:通过标准化接口调用外部资源

-

🔄 迭代优化:通过多轮交互持续优化输出质量

图3 Agent概念框架

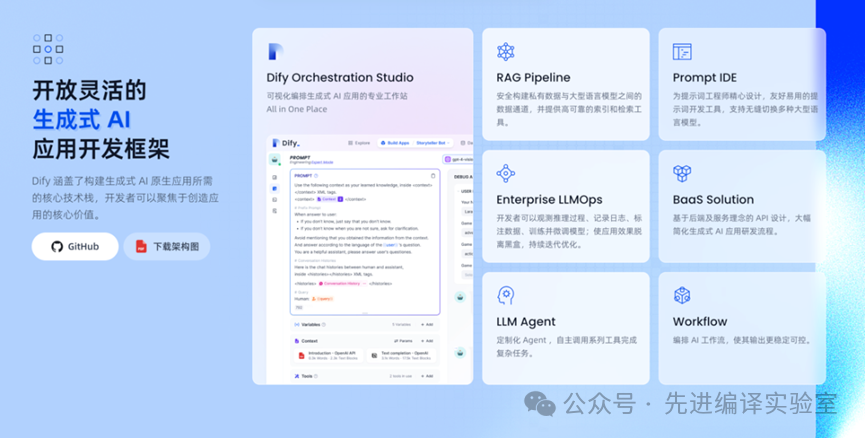

2. Dify:Agent开发利器

Dify 是一款开源的大模型应用开发平台,核心特性包括:

-

低代码可视化开发

-

模块化架构设计

-

多模型支持(GPT、Llama2、Claude3等)

-

私有化部署能力

-

丰富工具集成(50+工具,支持自定义)

图4 Dify平台功能概览

3. Dify + vLLM协同构建Agent应用

实战场景:构建能调用高德地图API查询天气的Agent

实现步骤:

-

本地部署Dify平台:依赖WSL2+Docker环境

-

远程部署vLLM:选用支持MCP协议的Qwen3-8B模型

-

申请高德API:获取密钥,配置MCP Server

-

构建Agent应用:在Dify中配置模型服务、定义Agent逻辑、集成工具

核心配置要点:

-

安装OpenAI-API-compatible插件

-

配置vLLM模型服务

-

使用“支持MCP工具的Agent React”策略

-

设置迭代次数以优化输出质量

四、总结

本讲通过三大实战场景,系统展示了vLLM在企业级应用中的完整路径:

-

可视化部署:通过Open WebUI降低使用门槛,提升交互体验

-

RAG本地部署:通过动态知识检索解决幻觉问题,保障数据安全

-

Agent应用开发:通过Dify平台构建具备工具调用能力的智能体

这些案例不仅验证了vLLM在生产环境中的实用价值,也为读者提供了可复用的技术框架。无论是企业开发者还是技术爱好者,都能基于这些方案快速搭建属于自己的AI应用系统。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?