训练语料库规模达 22T Token,其中包含 15T 通用数据和 7T 代码/推理专用数据。采用分组查询注意力(GQA)+ 部分旋转位置编码(RoPE)来提升长上下文处理效率和推理任务准确性。

GLM-4.5核心特性概览:

•MoE 架构

•混合推理模型

•总参数 355B(激活参数 32B)

•GQA + 部分 RoPE

•多 Token 预测

•Muon 优化器 + QK 归一化

•22T Token 训练语料

•Slime RL 基础设施

•原生工具调用

图片

图片

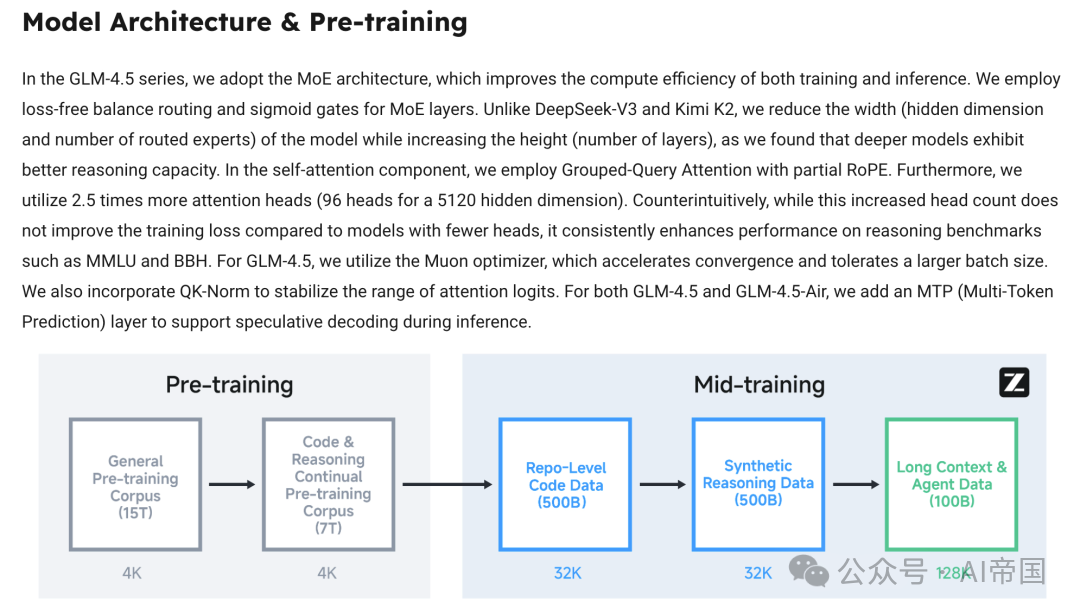

模型架构与预训练:GLM-4.5 总参数规模达 355B(激活参数 32B),采用更深但更窄的模型设计,通过增加层数和 96 个注意力头来优化推理能力。轻量版 GLM-4.5-Air 为 106B 参数(激活参数 12B)。

图片

训练语料库规模达 22T Token,其中包含 15T 通用数据和 7T 代码/推理专用数据。采用分组查询注意力(GQA)+ 部分旋转位置编码(RoPE)来提升长上下文处理效率和推理任务准确性。

中期训练的关键作用: "与早期在大规模通用文档上进行预训练不同,这些阶段采用中等规模的领域特定数据集,包括指令数据。"

其他设计亮点:多 Token 预测(MTP):支持推测解码,实现更快的推理速度。;Muon 优化器 + QK 归一化:提升大批量训练的稳定性和可扩展性。

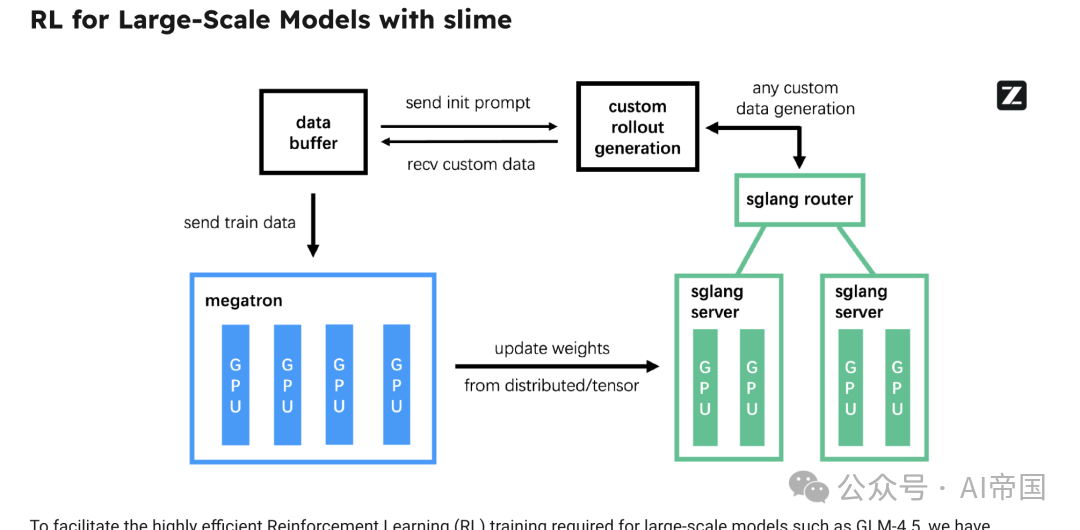

Slime RL 基础设施

•支持agent强化学习的异步推出与训练分离

•混合精度推出(FP8 推理,BF16 训练)提升效率

图片

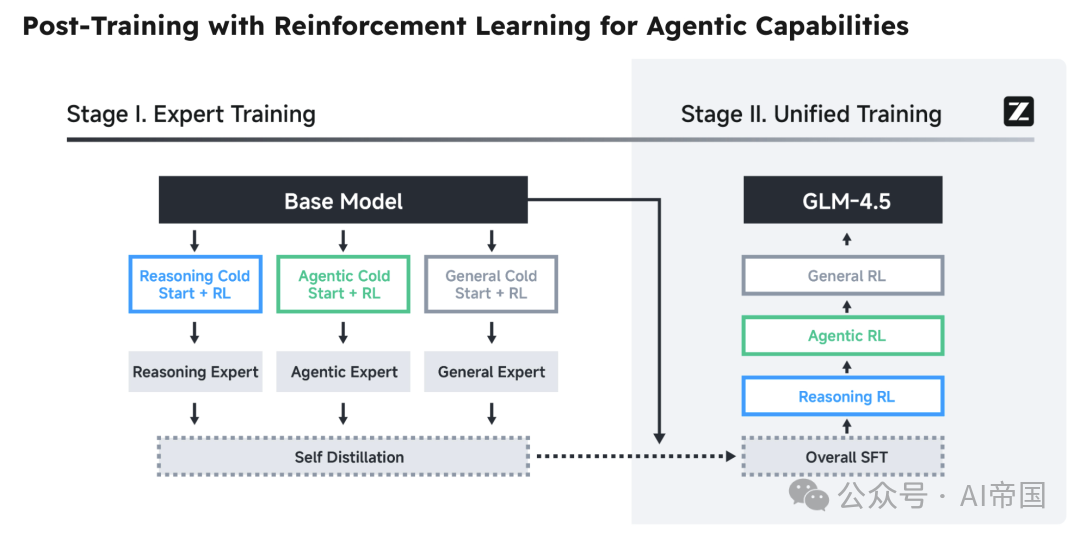

后训练流程:

•在推理和agent场景上进行监督微调

•针对推理(含课程学习)和agent任务(信息检索问答和代码执行)的强化学习

•专家蒸馏以整合专业技能

图片

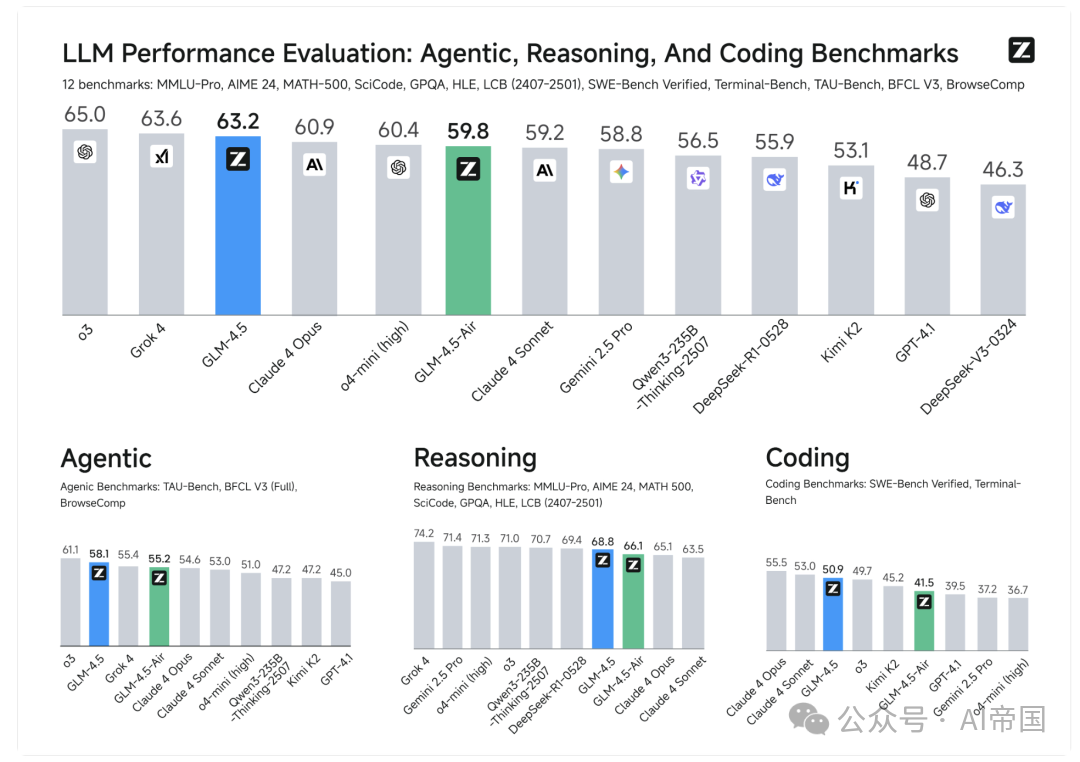

整体性能表现:GLM-4.5 总排名第三,GLM-4.5 Air 排名第六。

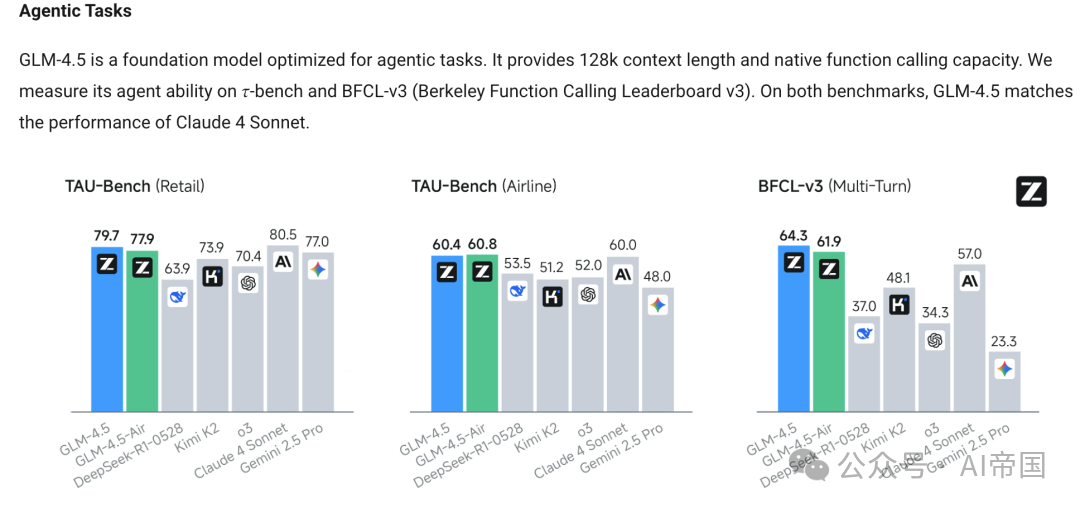

agent能力:这是个令人兴奋的结果!GLM-4.5 提供 128K 上下文长度和原生函数调用能力,性能可媲美 Claude 4 Sonnet!

测试时扩展:GLM-4.5 在 BrowseComp 上的测试时扩展准确率呈现健康的增长曲线。

推理性能:GLM-4.5 在多个推理基准测试中表现极具竞争力。这种稳定的性能表现尤为重要,因为统一各种能力是很难做到的。

编程能力:虽未达到 Claude 4 Opus 或 o3 的水平,但仍极具竞争力,明显优于 DeepSeek-R1-0528,与 Kimi-K2 处于同一水准。

帕累托前沿分析:"GLM-4.5 和 GLM-4.5-Air 相比同等规模的模型展现出卓越性能,在性能-规模权衡边界上实现了最优效率。"

真实场景表现:GLM-4.5 在真实开发场景中的agent编程表现令人印象深刻,相比 Kimi K2 和 Qwen-3 Code 的胜率表现亮眼。

其他能力特性

原生工具调用:通过集成函数调用和agent规划,工具调用成功率达 90.6%。

全栈开发agent:通过类似 Claude Code 的界面实现多轮agent编程,支持前端/后端开发、幻灯片制作和产出物生成。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

772

772

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?