最近deepseek热的飞起,那么我也来搭建一个本地的DeepSeek吧。(跟着热闹)

个人博客同步:DeepSeek本地部署(个人版) – 付的技术小窝

电脑配置是Win11,显卡4060

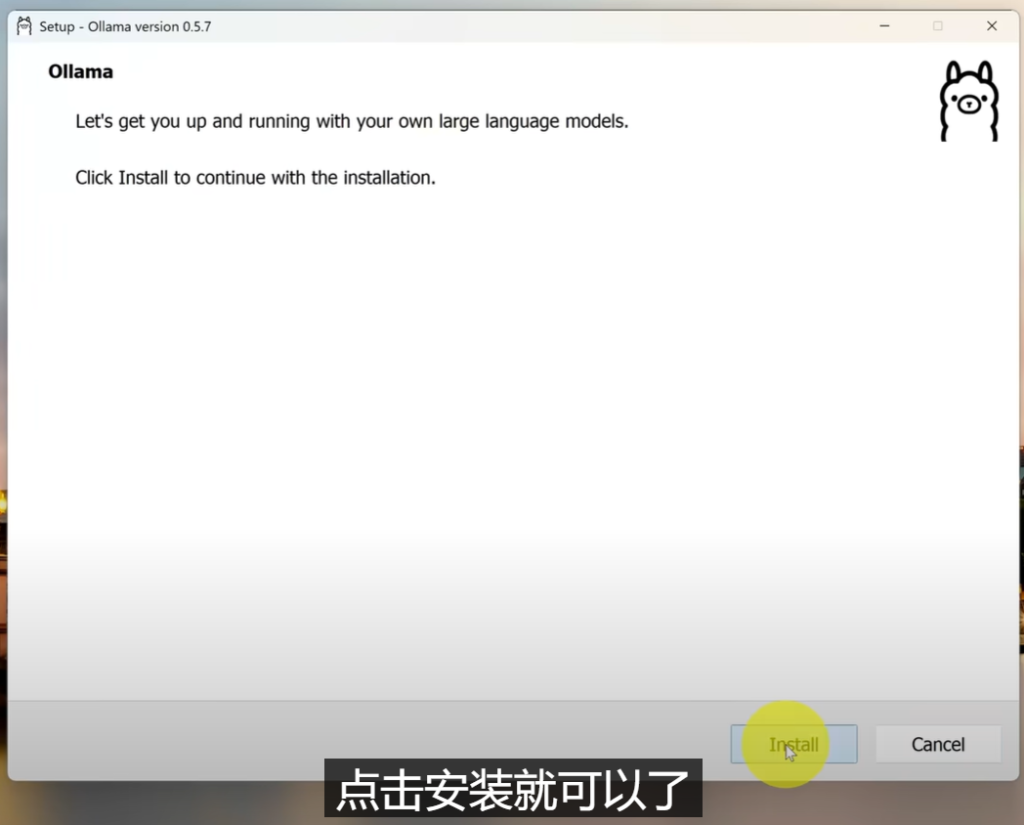

第一步:下载ollama。

官方地址:https://ollama.com/

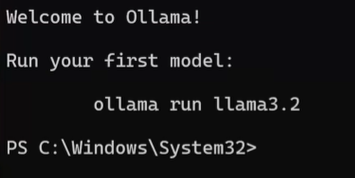

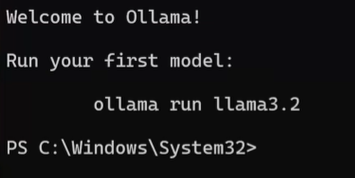

下载安装成功后会出现指令界面

会提示:Run your first model:

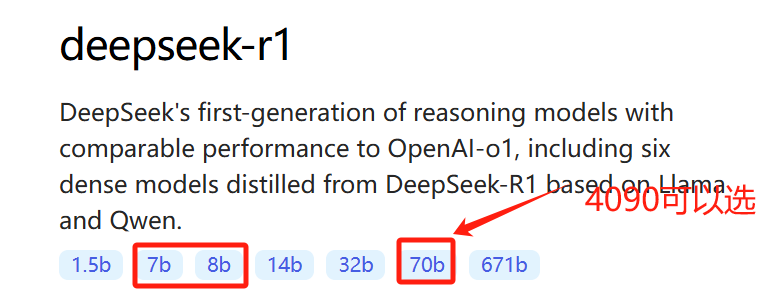

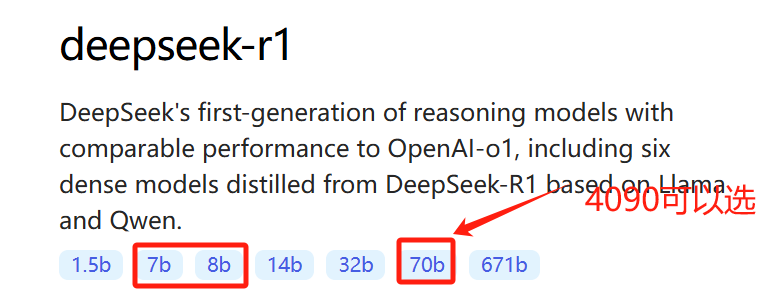

根据自己的电脑去选择适配的:

我选的是里面7b和14b的:ollama run deepseek-r1:7b

最近deepseek热的飞起,那么我也来搭建一个本地的DeepSeek吧。(跟着热闹)

个人博客同步:DeepSeek本地部署(个人版) – 付的技术小窝

电脑配置是Win11,显卡4060

第一步:下载ollama。

官方地址:https://ollama.com/

下载安装成功后会出现指令界面

会提示:Run your first model:

根据自己的电脑去选择适配的:

我选的是里面7b和14b的:ollama run deepseek-r1:7b

2172

2172

2672

2672

1790

1790

4681

4681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?