一 目标检测问题

目标检测问题是模式识别问题的一种,它主要解决从图像中获取需要的物体类型以及位置的问题,输入一幅图像或者一帧视频,要输出图像中要求物体的类别和位置,其中的位置通常用一个框标记出来。在研究目标检测问题时,通常只考虑感兴趣的物体,比如人脸检测检测人脸,交通检测检测车辆等,而例如建筑物,天空之类的则不在考虑范围之列。

二 设计思想

目标检测有两种实现,一种是one-stage,另一种是two-stage,它们的区别如名称所体现的,two-stage有一个region proposal过程,可以理解为网络会先生成目标候选区域,然后把所有的区域放进分类器分类,而one-stage会先把图片分割成一个个的image patch,然后每个image patch都有M个anchor box,把所有的anchor送进分类器输出分类和检测位置。很明显可以看出,后一种方法的速度会比较快。

YOLO算法是一种典型的one-stage方法,它是You Only Look Once 的缩写,意思是神经网络只需要看一次图片,就能输出结果。

YOLO到目前为止总共发布了五个版本,其中YOLOv1奠定了整个YOLO系列的基础,后面的YOLO算法是对其的不断改进创新。

三 发展历程

1 YOLOv1

YOLOv1发布于2015年,是one-stage detection的开山之作,在此之前的目标检测都是采用two-stage的方法,虽然准确率较高,但是运行速度慢。

1 主要思想

YOLOv1的检测方法如下:

- 将输入图像划分成S*S的网格,如果物体中心落入某个网格内,就由该网格单元负责检测该目标。

- 每个网格预测B个边界框和它们的置信度,置信度是预测框和真实物体IOU和网格是否包含物体01值之积

- 每个边界框都包含5个预测值,x,y,w,h,confidence,分别代表中心坐标,宽高和IOU值,这里的坐标是相对于网格左上角的偏移量,宽高是相对于整幅图像的占比

对于单个网格而言,还要预测C个条件概率Pr(Classi|Object),即在一个网格包含一个物体t的前提下,他是某种物体的概率,这个概率属于网格而非预测框。

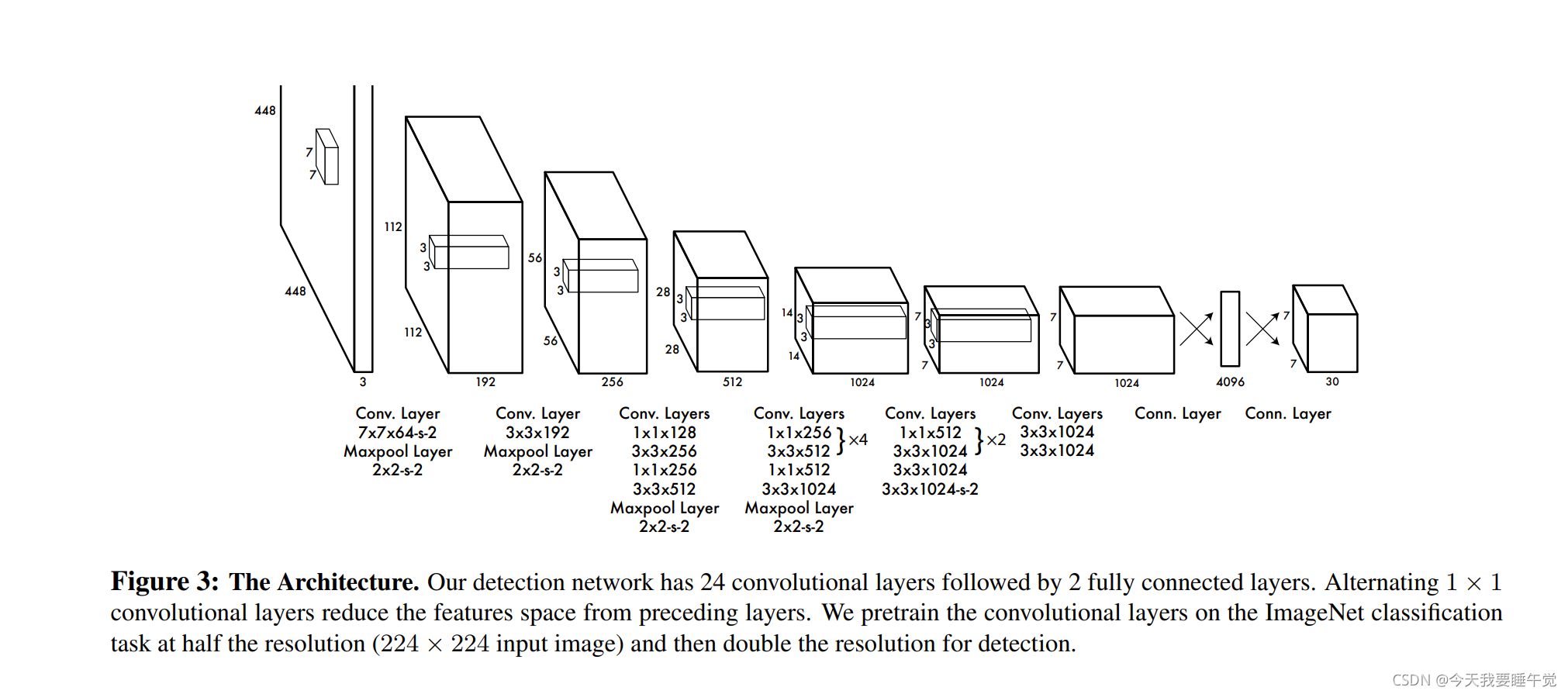

将YOLO用于PASCAL VOC数据集时,论文使用的 S=7,即将一张图像分为7×7=49个网格每一个栅格预测B=2个bounding boxe(每个box有 x,y,w,h,confidence,5个预测值),同时C=20,也就是说分20个类别。因此,最后的预测结果是7×7×30 的张量。

2 网络结构

Y

YOLO算法的演进:从YOLOv1到YOLOv5

YOLO算法的演进:从YOLOv1到YOLOv5

这篇博客详细介绍了YOLO(You Only Look Once)算法从第一版到第五版的发展历程。YOLO作为一种目标检测方法,从YOLOv1的one-stage检测思想开始,通过不断改进如YOLOv2的Batch Normalization和Anchor Boxes,再到YOLOv3引入Darknet-53和FPN架构,YOLOv4和YOLOv5在数据增强、损失函数和网络结构上的优化,逐步提升了检测的精度和速度。

这篇博客详细介绍了YOLO(You Only Look Once)算法从第一版到第五版的发展历程。YOLO作为一种目标检测方法,从YOLOv1的one-stage检测思想开始,通过不断改进如YOLOv2的Batch Normalization和Anchor Boxes,再到YOLOv3引入Darknet-53和FPN架构,YOLOv4和YOLOv5在数据增强、损失函数和网络结构上的优化,逐步提升了检测的精度和速度。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?