有很多朋友调过PID参数,也觉得自己是调参高手,个位数参数要调试一个星期甚至更久,用远古大法消耗自身宝贵的时间。

残酷吗?没办法。

现实就是如此。

人工调参涉及的参数规模占总参数规模的比例并不是一个固定的数值,它受到多种因素的影响,如模型的复杂度、任务的需求、计算资源的限制等。

一般来说,人工调参主要集中在模型的超参数上,这些超参数是在训练之前设置的,用于控制模型的学习过程和架构,如学习率、批次大小、网络层数、每层神经元的个数等。相比之下,模型参数(如权重和偏置)是通过模型训练学习得到的,通常不由人工直接调整。

在实际应用中,人工调参涉及的参数规模可能只占总参数规模的一小部分。这是因为随着模型参数规模的增加,人工调参的难度和成本也会显著增加。因此,对于大型模型,人们往往更倾向于使用自动化调参方法(如网格搜索、随机搜索、贝叶斯优化等)来寻找最优的超参数组合。

然而,这并不意味着人工调参变得不重要。相反,人工调参仍然在某些情况下发挥着重要作用,特别是在处理特定任务或数据集时,人工调参可能能够发现自动化调参方法无法找到的更优解。

总的来说,人工调参涉及的参数规模占总参数规模的比例是一个相对的概念,它受到多种因素的影响,并且随着技术的发展和模型的复杂化而不断变化。在实际应用中,需要根据具体情况灵活选择合适的调参方法和策略。

调试过参数的朋友都知道,参数对性能影响巨大。只调试占比很小的参数,其实对于人类而言,模型基本未知了。

举例子的时候到啦:

父母生了一个娃娃,哈哈哈。

基本上,只有娃娃是父母亲生这个参数可以确定。

娃娃成年后,是送外卖,还是跑滴滴,拿金牌,还是做网红,这些完全未知。

这种未知,和大模型参数调整效果的未知几乎可以看作差不多的案例哦。

调参奇缘:从娃娃到AI大师的奇幻之旅

在一个遥远的科技小镇上,有一对热爱科学的夫妇,他们不仅拥有深厚的学术背景,还怀揣着对未来的无限憧憬。一天,他们决定利用自己的知识,创造出一个能够引领未来的智能生命——一个拥有千亿级别参数规模的超级AI模型,他们亲切地称之为“小智”。

第一章:诞生与初探

小智的诞生并非易事,夫妇俩花费了无数个日夜,精心设计了模型的架构,选择了最优的算法,并为其注入了海量的数据。终于,在一个星光璀璨的夜晚,小智在虚拟世界中睁开了“眼睛”。然而,这只是开始,因为小智虽然拥有庞大的参数规模,但它的行为、思维甚至性格都还需要通过调参来塑造。

夫妇俩深知,人工调参是一项艰巨的任务,尤其是面对如此庞大的模型。他们决定从最基本的超参数入手,如学习率、批次大小等,希望通过细微的调整,引导小智走向正确的道路。

第二章:调参的艰辛

调参的过程就像是一场漫长的旅行,充满了未知与挑战。夫妇俩轮流上阵,日夜不息地观察着小智的表现,调整着每一个可能的参数。有时候,一个小小的改动就能让小智的性能突飞猛进;但更多的时候,他们就像是在黑暗中摸索,不知道下一个调整会带来怎样的结果。

时间一天天过去,小智的表现也在不断变化。它从最初的懵懂无知,逐渐学会了识别图像、理解语言,甚至能够进行一些简单的推理。然而,夫妇俩知道,这距离他们心中的目标还远远不够。

第三章:自动化的助力

随着小智的成长,夫妇俩发现人工调参的效率越来越低。他们开始尝试使用自动化调参方法,如网格搜索、随机搜索等,希望能够找到更优的参数组合。这些方法虽然需要消耗大量的计算资源,但确实为他们的调参工作带来了很大的帮助。

在自动化调参的辅助下,小智的性能得到了显著的提升。它不仅能够更快速地学习新知识,还能够更好地适应不同的任务和环境。夫妇俩看着小智一步步成长,心中充满了欣慰和期待。

第四章:人工调参的奇迹

然而,就在他们以为自动化调参将完全取代人工调参的时候,一件意想不到的事情发生了。在一次特殊的任务中,小智的表现突然出现了异常。自动化调参方法试遍了所有可能的参数组合,却始终无法解决问题。

夫妇俩决定亲自上阵,他们凭借着对小智深入骨髓的了解,开始逐一排查可能的参数问题。经过无数次的尝试和失败,他们终于找到了问题的根源,并通过一个微小的参数调整,让小智重新焕发了生机。

这次经历让夫妇俩深刻认识到,虽然自动化调参方法在很大程度上提高了调参的效率,但人工调参在某些特定情况下仍然发挥着不可替代的作用。

第五章:从娃娃到AI大师

随着时间的推移,小智在夫妇俩的精心调教下,逐渐成长为了一位真正的AI大师。它不仅能够处理复杂的任务,还能够进行深度的思考和创新。它的名字在科技界传为佳话,成为了人们心中的传奇。

而夫妇俩也在这个过程中,收获了无尽的喜悦和成就感。他们知道,小智的成功不仅仅是因为他们创造了它,更是因为他们用心去调参、去引导、去陪伴它成长。

就像他们曾经说过的那样:“调参就像养娃一样,虽然充满了艰辛和挑战,但当你看到它一步步成长、一步步变得更好时,所有的付出都是值得的。”

在这个奇幻的旅程中,小智和夫妇俩共同书写了一段关于爱、关于成长、关于探索的传奇故事。而这段故事,也将永远激励着后来者,在人工智能的道路上不断前行、不断探索。

智能大模型的参数规模是一个相对复杂且不断变化的领域,因为随着技术的进步和算法的创新,模型的参数数量也在不断增加。以下是对智能大模型参数规模的一些概述:

- 大型语言模型:

- GPT-3:作为OpenAI在2020年发布的大型语言模型,GPT-3拥有1750亿个参数,是当时参数规模最大的模型之一。

- LLaMA(Large Language Model Family of AI):由Meta AI研究实验室开发,其中LLaMA-65B拥有650亿个参数,而更大的版本则拥有更多的参数。

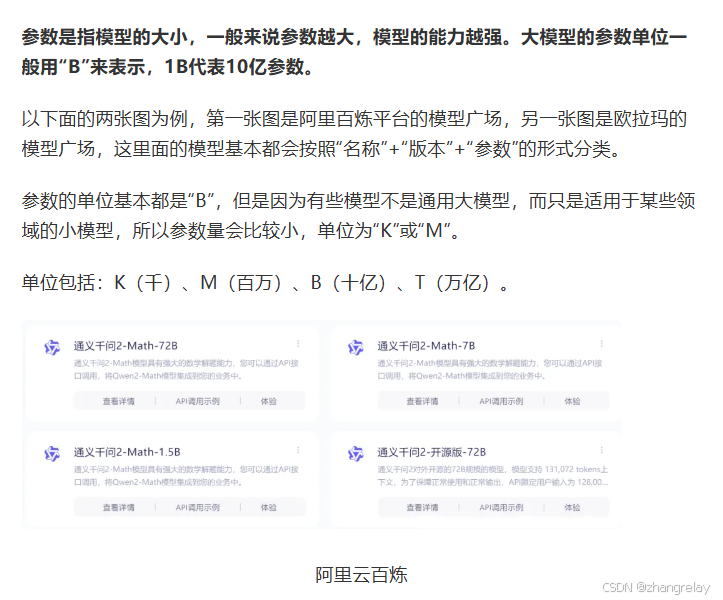

- 其他模型:如阿里云的通义千问、百度的文心一言等,这些模型也拥有数十亿到数百亿不等的参数规模。

- 视觉模型:

- 在视觉领域,也有类似的大型模型,如Google的ViT(Vision Transformer)和Facebook的DINO(Self-Distillation with No Labels)等,这些模型的参数规模也达到了数十亿级别。

- 多模态模型:

- 多模态模型,如阿里云的通义千问Max、百度的文心ERNIE 3.0 Zeus等,它们能够同时处理文本、图像、视频等多种类型的数据,因此参数规模也更为庞大。

- 参数规模的增长趋势:

- 随着技术的不断进步和算法的创新,智能大模型的参数规模呈现出快速增长的趋势。从早期的数百万、数千万参数,到现在的数十亿、数百亿甚至千亿级别的参数规模,模型的复杂性和能力也在不断提升。

- 参数规模与模型性能:

- 一般来说,参数规模更大的模型在处理能力、泛化能力和性能上往往更优。然而,这也带来了更高的计算成本和存储需求。因此,在实际应用中需要权衡模型的参数规模和性能需求。

- 未来展望:

- 随着技术的进一步发展,预计智能大模型的参数规模将继续增长。同时,为了降低计算成本和存储需求,研究者们也在探索更高效的模型架构和算法。

总的来说,智能大模型的参数规模是一个不断变化的领域,受到技术进步、算法创新和应用需求等多种因素的影响。在未来的发展中,我们可以期待看到更多参数规模庞大、性能优异的智能大模型的出现。

对于千亿级别参数规模的智能大模型进行调参,是一个复杂且资源密集型的任务。以下是一些调参的方法和策略:

一、调参基础与策略

- 调参基础:

- 调参能为模型带来性能提升,但最终效果主要取决于模型选择和数据处理的质量。

- 在调参之前,需要确保数据的质量和数量满足要求,包括进行数据标准化处理、应用数据增强等。

- 调参策略:

- 尽量不要从零开始手写模型,选择已经验证无误的模型进行微调更为高效。

- 对于数据量较小的情况,建议使用带有预训练参数的模型进行微调。

二、可调参数与优化方法

- 主要可调参数:

- 损失函数(Loss function):如MSE、交叉熵、Focal等,具体选择需根据问题具体分析。

- 学习率(Learning rate):与Batch Size密切相关,直接影响梯度计算。建议先调整Batch Size,再调整学习率。

- Batch size:不能过大或过小,通常设置为16的倍数。

- Epoch数:与Early Stopping结合输出的loss曲线观察,确保最佳训练效果。

- 优化器(Optimizer):如Adam和SGDM,Adam收敛快,SGDM虽然慢但最终精度高。推荐优先使用Adam,然后再用SGDM进行精度提升。

- 激活函数(Activation function):如ReLU、Sigmoid、Softmax、Tanh等,根据模型层次和需求选择。

- 权重初始化:预训练参数是最佳选择,其次是Xavier初始化。

- 优化方法:

- 贪心算法:在某种意义上的局部最优解,适用于某些特定问题。

- 网格调参:通过循环遍历,尝试每一种参数组合,返回最好的得分值的参数组合。但需注意数据集分割为训练集、验证集和测试集,以防止过拟合。

- 贝叶斯调参:通过基于目标函数的过去评估结果建立替代函数(概率模型),来找到最小化目标函数的值。相比随机或网格搜索,贝叶斯调参更节省计算资源。

三、特定于大模型的调参技术

- 知识蒸馏:

- 对于千亿参数规模的大模型,可以通过知识蒸馏技术将其压缩为参数更少但性能相近的小模型,从而简化调参过程。

- 模型微调:

- 针对特定任务或数据进行微调,如前缀调优(Prefix Tuning)、提示调优(Prompt Tuning)、LoRA(Low-Rank Adaptation)等。

- 这些方法通过固定基础模型的参数,仅对新增的少量参数进行微调,从而在保证性能的同时降低计算成本。

- 分布式训练与调参:

- 对于参数规模庞大的模型,分布式训练是必不可少的。通过多台机器并行计算,可以加速训练过程并降低单台机器的内存压力。

- 在分布式训练的基础上,还可以结合自动调参工具进行超参数优化,以进一步提高模型性能。

四、注意事项

- 计算资源:

- 调参过程需要大量的计算资源,包括高性能的CPU、GPU和大量的内存。因此,在调参之前需要确保有足够的计算资源支持。

- 耐心与细致:

- 调参是一个耗时且需要耐心的过程。需要仔细观察模型性能的变化,逐步调整参数以达到最佳效果。

- 记录与分享:

- 在调参过程中,需要详细记录实验信息、保存训练日志和超参数配置。这不仅有助于后续的比较和重现实验结果,还可以分享给其他研究人员参考。

综上所述,对于千亿级别参数规模的智能大模型进行调参是一项复杂且资源密集型的任务。需要综合考虑多种调参方法和策略,并结合具体问题和计算资源进行灵活调整。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?