Data Processing for AI: Applications, Techniques, and Systems

摘要

随着深度学习技术的演进,特别是大语言模型(LLM)的广泛应用,人工智能系统的开发范式正经历从“以模型为中心(Model-Centric)”向“以数据为中心(Data-Centric)”的深刻变革。在这一新范式下,数据的质量、语义丰富度及检索效率成为决定模型性能上限的关键因素。

本文旨在系统性地综述面向AI的数据处理体系。首先,我们将探讨非结构化数据(如PDF、HTML)的解析与清洗技术,重点分析文档布局分析与语义去噪的挑战;其次,深入研究现代AI数据系统的架构设计,对比传统ETL与面向向量计算(Vector Computing)的新型流水线差异;最后,结合检索增强生成(RAG)等实际应用场景,展示高效数据处理系统如何解决大模型的幻觉与知识时效性问题。

1. 引言 (Introduction)

1.1 背景:从模型竞赛到数据工程

过去十年,AI社区的聚光灯主要集中在模型架构的创新上,从卷积神经网络(CNN)到 Transformer,算法的迭代推动了行业的爆发。然而,正如人工智能专家 Andrew Ng 所提出的观点:“AI = Code + Data”。在模型架构逐渐趋同且开源化的今天,代码(Code)已不再是唯一的壁垒,数据(Data)成为了新的护城河。

在“以数据为中心”的AI开发中,工程师花费在数据准备、清洗、标注和特征工程上的时间往往超过项目周期的 80%。特别是对于依赖海量预训练数据的大语言模型(LLM),“Garbage In, Garbage Out”(垃圾进,垃圾出)的定律表现得尤为残酷。微小的噪音或格式错误,经过模型的放大,都可能导致严重的推理偏差。

1.2 挑战:传统大数据栈的局限性

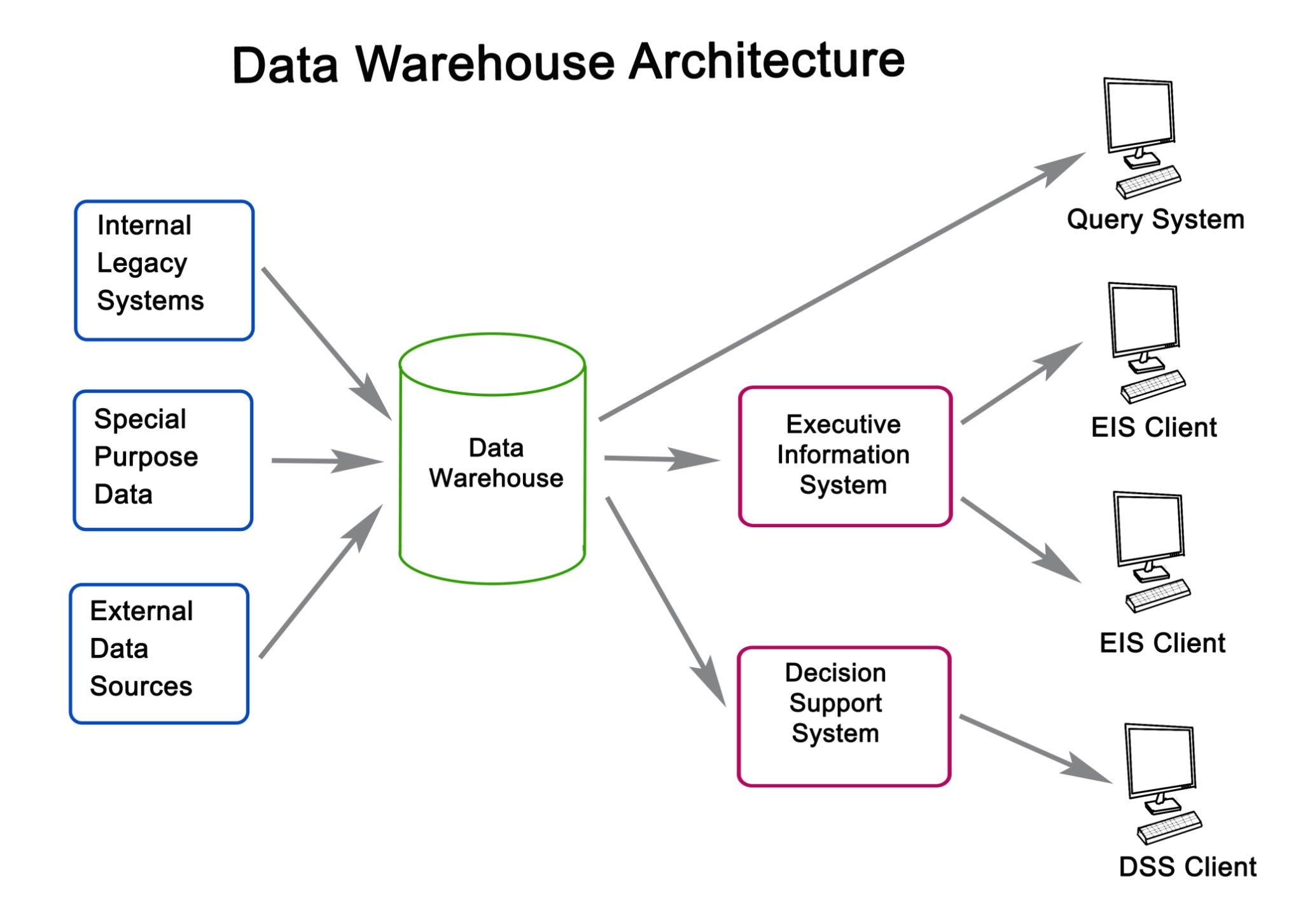

传统的企业级数据处理(Data Engineering)主要服务于商业智能(BI)和报表分析。其处理对象通常是高度结构化的表格数据(Relational Data),核心操作是精确查询(Exact Match)和聚合计算(Aggregation)。

然而,面向AI的数据处理面临截然不同的挑战:

-

非结构化为主: AI 的“燃料”更多来自 PDF 文档、图像、音视频和自由文本。这些数据缺乏预定义的 Schema,需要复杂的解析算法提取信息。

-

语义模糊性: 传统数据库查询基于关键词匹配,而 AI 需要理解数据的语义(Semantics)。这要求引入 Embedding 技术,将离散的数据映射到连续的向量空间 $\mathbb{R}^d$ 中。

-

高维计算需求: 数据不再仅仅被存储,还需要被计算。向量索引构建、相似度搜索等操作对计算资源和存储架构提出了新的要求。

1.3 现代 AI 数据流水线 (The Modern AI Data Pipeline)

为了应对上述挑战,一套全新的技术栈正在形成。一个典型的面向 AI 的数据处理流水线通常包含以下几个关键阶段:

-

数据获取与解析 (Ingestion & Parsing): 处理多源异构数据,解决 OCR、布局分析等底层难题。

-

清洗与分块 (Cleaning & Chunking): 去除噪音(如页眉页脚、乱码),并根据语义边界将长文本切分为适合模型上下文窗口的片段。

-

向量化 (Embedding): 利用预训练模型将文本片段转化为向量。

-

存储与索引 (Storage & Indexing): 使用向量数据库(Vector Database)进行持久化存储,并构建 HNSW 等索引以加速检索。

2. 关键处理技术 (Key Processing Techniques)

在面向 AI 的数据流水线中,处理过程不再是简单的字符串操作,而是演变成了一系列结合了计算机视觉(CV)和自然自然语言处理(NLP)的复合工程任务。我们将该流程解构为以下四个核心技术环节。

2.1 非结构化文档解析 (Unstructured Document Parsing)

企业知识库中约 80% 的数据以非结构化格式存在(如 PDF, Docx, PPT)。其中,PDF 格式因其“重展示、轻结构”的特性,成为数据解析的最大痛点。

-

布局分析 (Layout Analysis): 传统的

PyPDF2等工具仅能提取线性文本,容易丢失表格结构和多栏排版信息。现代解析技术采用了基于深度学习的视觉模型(如 LayoutLM, YOLO-based models)。这些模型将文档视为图片,通过目标检测(Object Detection)识别标题、段落、表格、图片和公式的边界框(Bounding Boxes)。通过布局分析,系统能够保留文档的层级结构(Hierarchy),这对于后续让 LLM 理解上下文至关重要。

-

表格还原 (Table Extraction): 表格数据的扁平化是 RAG 系统中的常见难题。先进的处理方案通常采用“HTML 还原”策略,即识别表格结构后,将其重构为 HTML

<table>标签或 Markdown 格式,从而最大程度保留行列对应的语义关系。

2.2 语义清洗与去重 (Semantic Cleaning & De-duplication)

“Garbage In, Garbage Out” 在大模型时代依然适用。无效的字符、重复的段落以及隐私敏感信息必须在进入向量库前被剔除。

-

基于规则与模型的清洗: 除了基础的正则替换(Regex),现代清洗流程引入了启发式规则。例如,根据困惑度(Perplexity)过滤掉 OCR 产生的乱码片段,或使用命名实体识别(NER)模型检测并脱敏 PII(个人身份信息),如邮箱、电话和身份证号。

-

模糊去重 (Fuzzy De-duplication): 在预训练和微调阶段,重复数据会导致模型过拟合。针对海量文本,直接的字符串比对效率极低。通常采用 MinHash 结合 LSH (Locality Sensitive Hashing) 算法,计算文档间的 Jaccard 相似度。

2.3 智能分块策略 (Intelligent Chunking Strategies)

由于 LLM 的上下文窗口(Context Window)有限,且为了提高检索的精准度,长文档必须被切分为较小的片段(Chunks)。分块策略直接影响 RAG 系统的检索质量。

-

固定窗口分块 (Fixed-size Chunking): 最基础的方法,设定固定的 Token 数(例如 512 tokens)进行切分。缺点是极易打断句子语义,导致检索片段上下文缺失。

-

语义感知分块 (Semantic Chunking):

-

递归切分 (Recursive Splitting): 优先在段落分隔符(

\n\n)切分,其次在句号(。)切分,最后才强制截断。 -

基于 Embedding 的切分: 计算相邻句子的向量相似度,当相似度突变(即语义发生转移)时进行切断。这种方法虽然计算成本高,但生成的 Chunk 语义聚合度最高。

-

-

滑动窗口与重叠 (Overlapping): 为了保持上下文的连贯性,相邻 Chunk 之间通常会保留 10%-20% 的重叠区域(Overlap),确保跨片段的信息不会丢失。

2.4 向量化与表征 (Vectorization & Representation)

这是连接数据与算法的桥梁。通过 Embedding 模型,我们将离散的文本映射到连续的高维向量空间 $\mathbb{R}^d$。

-

多语言与领域适应性: 通用模型(如 OpenAI text-embedding-3)在多语言表现上均衡,但在特定垂直领域(如医疗、法律)可能缺乏区分度。此时,使用领域数据对 BERT 架构模型进行对比学习(Contrastive Learning)微调是常见的优化手段。

-

维度权衡: 向量维度通常在 768 到 4096 之间。高维向量包含更丰富的语义信息,但会显著增加向量数据库的存储成本和检索延迟。在实际工程中,需根据数据规模和精度要求进行权衡,有时需使用 PCA 或 Matryoshka Embedding 技术进行降维处理。

3. 系统架构与基础设施 (System Architecture & Infrastructure)

面向 AI 的数据处理对底层基础设施提出了全新的要求。与传统的 ETL 任务不同,AI 数据流水线通常是计算密集型(Compute-intensive)与I/O 密集型混合的负载,且严重依赖 GPU 加速(如 Embedding 推理)。因此,我们需要构建一套支持异构计算、具备高吞吐量且低延迟的系统架构。

3.1 分布式计算框架:从 Spark 到 Ray

虽然 Apache Spark 长期统治着大数据处理领域,但在 AI 数据处理场景下,Ray 正逐渐成为首选框架。

-

异构计算调度 (Heterogeneous Resource Scheduling):

-

Spark 是为 CPU 上的大规模数据并行设计的,虽然可以通过插件支持 GPU,但在任务调度粒度和资源隔离上不够灵活。

-

Ray 原生支持异构资源。在同一个流水线中,它可以调度 CPU Actor 进行文档解析(PDF OCR),同时调度 GPU Actor 进行模型推理(Embedding)。这种精细化的资源管理显著提升了硬件利用率。

-

-

流式执行 (Streaming Execution):

Ray Data 采用了流式执行引擎。与 Spark 的批处理(Batch)模式不同,Ray 可以在第一个数据分片(Partition)处理完毕后立即传递给下游,无需等待整个 Stage 完成。这种机制大幅降低了端到端的延迟,并减少了内存峰值压力。

3.2 存储层:向量数据库与 Lakehouse 的融合

数据经过处理后,最终归宿通常是向量数据库。

-

向量索引机制 (Vector Indexing): 为了在十亿级向量规模下实现毫秒级查询,必须构建近似最近邻(ANN)索引。

-

IVF (Inverted File Index): 基于聚类的倒排索引,内存占用较小,适合超大规模数据集,但可能牺牲少量召回率。

-

-

Lakehouse 架构的演进: 现代架构倾向于将原始向量数据存储在低成本的对象存储(如 S3)上的数据湖格式(Delta Lake, Iceberg)中,而将向量索引加载到高性能的向量数据库(如 Milvus, Pinecone)或内存中。这种分离架构实现了存储成本与查询性能的最优解。

3.3 编排与观测 (Orchestration & Observability)

复杂的 AI 数据流水线往往是一个有向无环图(DAG)。

-

工作流编排: 使用 Airflow 或 Prefect 管理数据流的依赖关系。例如:只有当“文档解析”任务成功率超过 95% 时,才触发后续的“向量化”任务。

-

数据版本控制 (Data Versioning): 类似于代码的 Git,数据处理需要通过 DVC (Data Version Control) 或 LakeFS 进行版本管理。这确保了每次模型训练所使用的数据集快照(Snapshot)都是可追溯、可复现的。

4. 典型应用场景 (Case Studies)

前述的数据处理技术与架构并非空中楼阁,它们在实际业务中有着广泛的应用。其中,检索增强生成 (Retrieval-Augmented Generation, RAG) 是目前最典型的落地场景。

4.1 企业级 RAG 知识库构建

在大模型应用中,通用的预训练模型缺乏企业内部的私有知识(如产品手册、技术文档)。RAG 通过外挂知识库解决了这一问题,而数据处理质量直接决定了 RAG 的效果。

Getty Images

-

全流程数据流转:

-

解析与清洗: 系统自动抓取企业 Wiki 和 SharePoint 中的 PDF 文档,使用 Layout Analysis 模型去除页眉页脚,保留核心内容。

-

语义分块: 采用滑动窗口策略(Window Size: 512, Overlap: 50),确保跨段落的上下文完整

-

重排序 (Reranking): 检索出的 Top-50 片段通过 Cross-Encoder 模型进行精细打分,筛选出 Top-5 输入 LLM。

-

4.2 多模态数据预处理 (Multimodal Data Preprocessing)

随着 GPT-4V 和 Gemini 等多模态模型的兴起,数据处理对象扩展到了图像和视频。

-

图像-文本对清洗: 在训练 CLIP 等模型时,需要处理

<Image, Text>对。关键步骤包括剔除低分辨率图片、使用 OCR 过滤含有过多文字的图片,以及使用 CLIP Score 过滤图文不匹配的样本。

5. 挑战与未来展望 (Challenges & Future Work)

尽管面向 AI 的数据处理技术已取得长足进步,但仍面临诸多挑战,这也指明了未来的研究方向。

-

多模态融合的复杂性: 目前的处理流程多是模态隔离的。未来需要构建统一的 Embedding 空间,能够同时处理视频流、音频和文本,实现真正的跨模态检索(例如:用文本搜索视频中的某个动作片段)。

-

实时流式处理 (Real-time Streaming): 当前大多数 Embedding 任务仍是批处理(Batch)。随着 AI Agent 需要实时感知环境,构建低延迟的流式 Embedding 系统(如基于 Flink + Ray)将成为刚需。

-

自动化评估指标 (Automated Evaluation): "数据质量"目前仍缺乏统一的量化标准。未来将出现更多基于 AI 的评估框架(AI-as-a-Judge),自动评估分块的合理性和检索的相关性(如 RAGAS 指标体系)。

6. 结论 (Conclusion)

本文系统性地探讨了面向人工智能的数据处理技术体系。我们从非结构化数据的解析痛点出发,详细阐述了语义清洗、智能分块及向量化等关键技术,并分析了以 Ray 和向量数据库为核心的现代基础设施架构。

随着人工智能从 "Model-Centric" 向 "Data-Centric" 范式转型,数据处理不再仅仅是后台的辅助工作,而是构建智能系统的核心竞争力。构建高效、可扩展且语义感知的数据流水线,将是未来企业落地 AGI(通用人工智能)应用的基石。

7. 参考文献 (References)

-

Vaswani, A., et al. (2017). "Attention Is All You Need". Advances in Neural Information Processing Systems.

-

Lewis, P., et al. (2020). "Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks". NeurIPS.

-

Ng, A. (2021). "A Chat with Andrew on MLOps: From Model-centric to Data-centric AI". DeepLearning.AI.

-

Liaw, R., et al. (2018). "Ray: A Distributed Framework for Emerging AI Applications". OSDI.

-

Johnson, J., et al. (2019). "Billion-scale similarity search with GPUs". IEEE Big Data.

806

806

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?