提前声明这篇文章中的图片来源这篇稿子!!强推!!!易学易懂!!

零基础入门深度学习(2) - 线性单元和梯度下降_零基础入门深度学习 线性单元和梯度下降-优快云博客

传送门:小白学习machine learning的第一天-优快云博客

小白学习machine learning的第二天-优快云博客

小白学习machine learning的第三天-优快云博客

小白学习machine learning的第四天-优快云博客

小白学习machine learning的第五天-优快云博客

小白学习machine learning的第六天-优快云博客

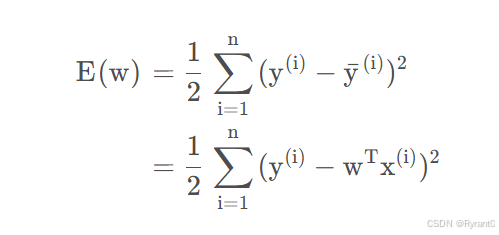

从类似吴恩达老师说的cost function开始:

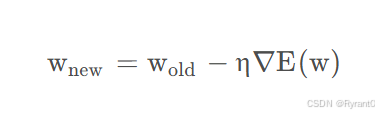

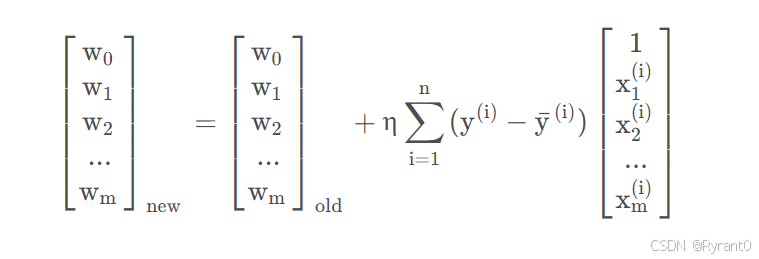

然后在用学习速率 * 有梯度的cost function就得到了梯度下降的公式啦!如下:

图一

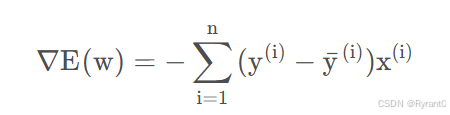

图一 图二(详细推导过程见title的那篇稿子啦)

图二(详细推导过程见title的那篇稿子啦)

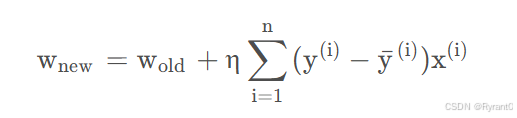

图一加上图二就会得到这个:

其实w(i)就是特征:口语化一点就是这个人或者这个产品的出场日期,颜色,喜好,从事IT……这类的呢。

图三

图三

上述的是BGD (批量梯度下降算法)

下面的是SGD(随机梯度下降算法)

怎么说呢,emmmmm好处在于SGD 效率更高且由于是随机的不容易困在局部最小值里面。

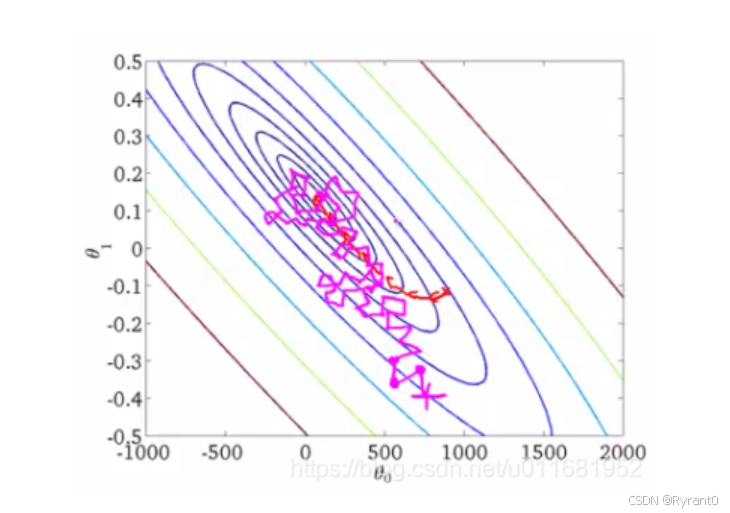

当然了,SGD的图像就非常的“躁动”了,见下:

椭圆表示的是函数值的等高线,椭圆中心是函数的最小值点。红色是BGD的逼近曲线,而紫色是SGD的逼近曲线。

这里奉上title那篇稿子的线性单元实现代码:

#!/usr/bin/env python

# -*- coding: UTF-8 -*-

from perceptron import Perceptron

#定义激活函数f

f = lambda x: x

class LinearUnit(Perceptron):

def __init__(self, input_num):

'''初始化线性单元,设置输入参数的个数'''

Perceptron.__init__(self, input_num, f)

def get_training_dataset():

'''

捏造5个人的收入数据

'''

# 构建训练数据

# 输入向量列表,每一项是工作年限

input_vecs = [[5], [3], [8], [1.4], [10.1]]

# 期望的输出列表,月薪,注意要与输入一一对应

labels = [5500, 2300, 7600, 1800, 11400]

return input_vecs, labels

def train_linear_unit():

'''

使用数据训练线性单元

'''

# 创建感知器,输入参数的特征数为1(工作年限)

lu = LinearUnit(1)

# 训练,迭代10轮, 学习速率为0.01

input_vecs, labels = get_training_dataset()

lu.train(input_vecs, labels, 10, 0.01)

#返回训练好的线性单元

return lu

def plot(linear_unit):

import matplotlib.pyplot as plt

input_vecs, labels = get_training_dataset()

fig = plt.figure()

ax = fig.add_subplot(111)

ax.scatter(map(lambda x: x[0], input_vecs), labels)

weights = linear_unit.weights

bias = linear_unit.bias

x = range(0,12,1)

y = map(lambda x:weights[0] * x + bias, x)

ax.plot(x, y)

plt.show()

if __name__ == '__main__':

'''训练线性单元'''

linear_unit = train_linear_unit()

# 打印训练获得的权重

print linear_unit

# 测试

print 'Work 3.4 years, monthly salary = %.2f' % linear_unit.predict([3.4])

print 'Work 15 years, monthly salary = %.2f' % linear_unit.predict([15])

print 'Work 1.5 years, monthly salary = %.2f' % linear_unit.predict([1.5])

print 'Work 6.3 years, monthly salary = %.2f' % linear_unit.predict([6.3])

plot(linear_unit)

(真的没得说,代码太好看了且干净!!)

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?