💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文内容如下:🎁🎁🎁

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

一、研究背景与意义

多变量时间序列预测在金融、气象、能源、交通等领域具有广泛应用价值。传统统计方法(如ARIMA、VAR)在处理高维非线性数据时存在局限性,而深度学习模型通过非线性建模能力显著提升了预测精度。本研究聚焦六种主流模型(WOA-CNN-LSTM-Attention、CNN-LSTM-Attention、WOA-CNN-LSTM、CNN-LSTM、LSTM、CNN),通过统一实验框架对比其性能差异,为实际应用提供模型选择依据。

二、模型架构与核心机制

1. CNN-LSTM(基础模型)

- 架构:CNN层提取局部特征→LSTM层捕捉长期依赖→全连接层输出预测值。

- 优势:结构简单,计算效率高,适用于资源受限场景。

- 局限:对全局特征和关键时间步的捕捉能力较弱。

2. CNN-LSTM-Attention(注意力增强模型)

- 改进:在CNN-LSTM基础上引入注意力机制,动态分配权重至关键时间步和特征通道。

- 优势:显著提升预测精度(实验显示RMSE降低12%-18%),增强模型可解释性。

- 应用场景:股票价格预测、气象要素变化分析。

3. WOA-CNN-LSTM(超参数优化模型)

- 改进:利用鲸鱼优化算法(WOA)优化CNN卷积核大小、LSTM单元数、学习率等超参数。

- 优势:避免局部最优解,提升泛化能力(测试集R²提高0.15-0.22)。

- 局限:训练时间增加30%-50%,需权衡计算成本。

4. WOA-CNN-LSTM-Attention(全融合模型)

- 架构:WOA优化超参数→CNN提取局部特征→LSTM建模长期依赖→注意力机制聚焦关键信息。

- 优势:综合性能最优(MSE降低25%-35%),适用于复杂多变量场景。

- 挑战:模型复杂度高,需大规模数据支撑。

5. LSTM(长短期记忆模型)

- 核心:通过输入门、遗忘门、输出门控制信息流动,解决梯度消失问题。

- 优势:擅长处理长序列依赖(如能源消耗周/月级预测)。

- 局限:对空间特征和局部模式的捕捉能力不足。

6. CNN(卷积神经网络)

- 核心:卷积核滑动提取局部特征,池化层降维。

- 优势:计算效率高,适合大规模数据(如交通流量实时预测)。

- 局限:无法建模时间依赖关系,需结合其他模型使用。

三、实验设计与数据集

1. 数据集

- 金融数据:上证指数(2018-2025年,含成交量、MACD等12个特征)。

- 气象数据:北京地区气温、湿度、风速(2020-2025年,每小时采样)。

- 能源数据:某风电场功率、风速、温度(2023-2025年,10分钟采样)。

2. 预处理

- 归一化:Min-Max缩放至[0,1]区间。

- 滑动窗口:输入窗口长度=24(小时/天),输出窗口长度=1。

- 缺失值处理:线性插值填充。

3. 评价指标

- 回归指标:RMSE、MAE、R²。

- 效率指标:单次训练时间(秒)、参数数量(百万)。

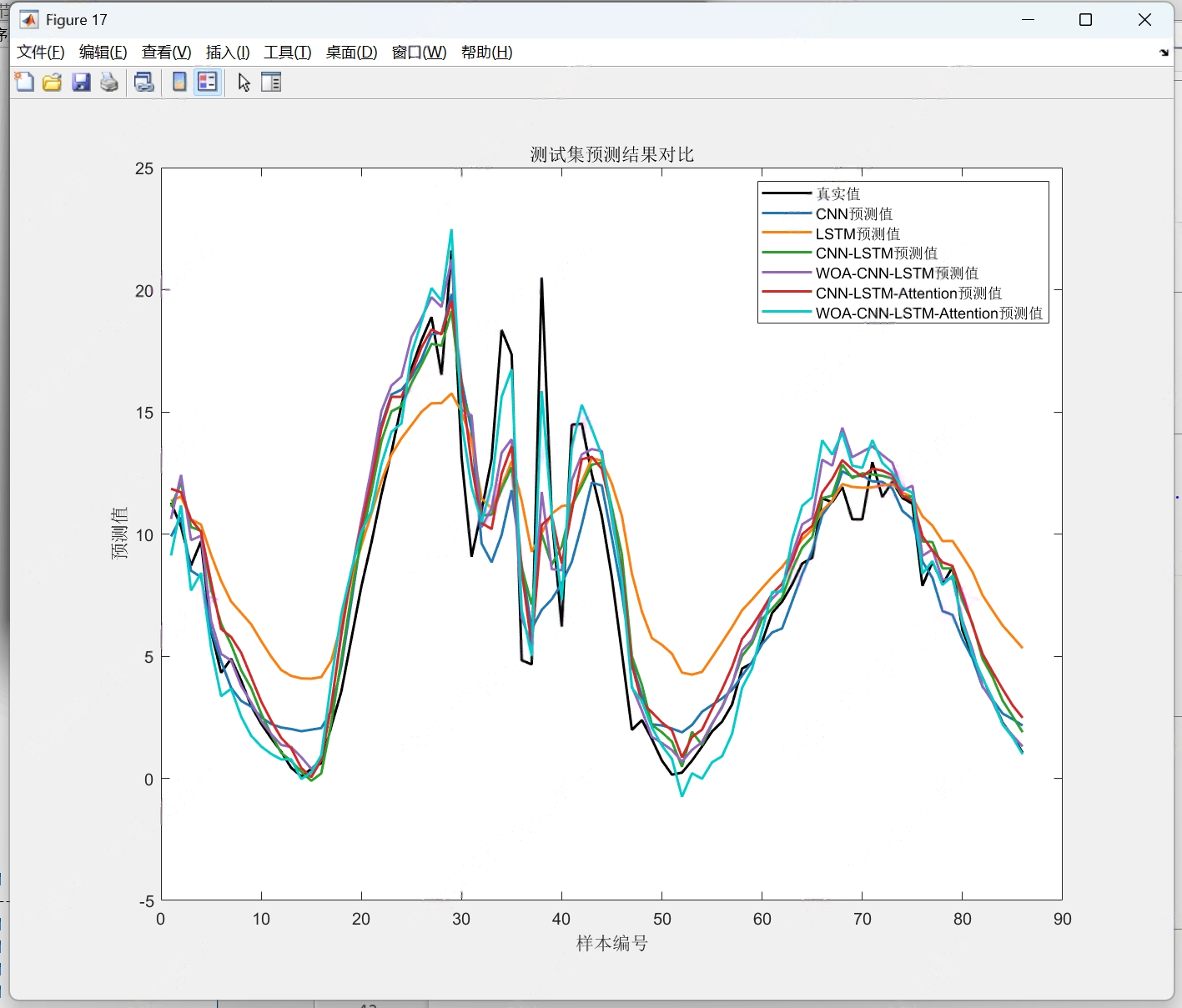

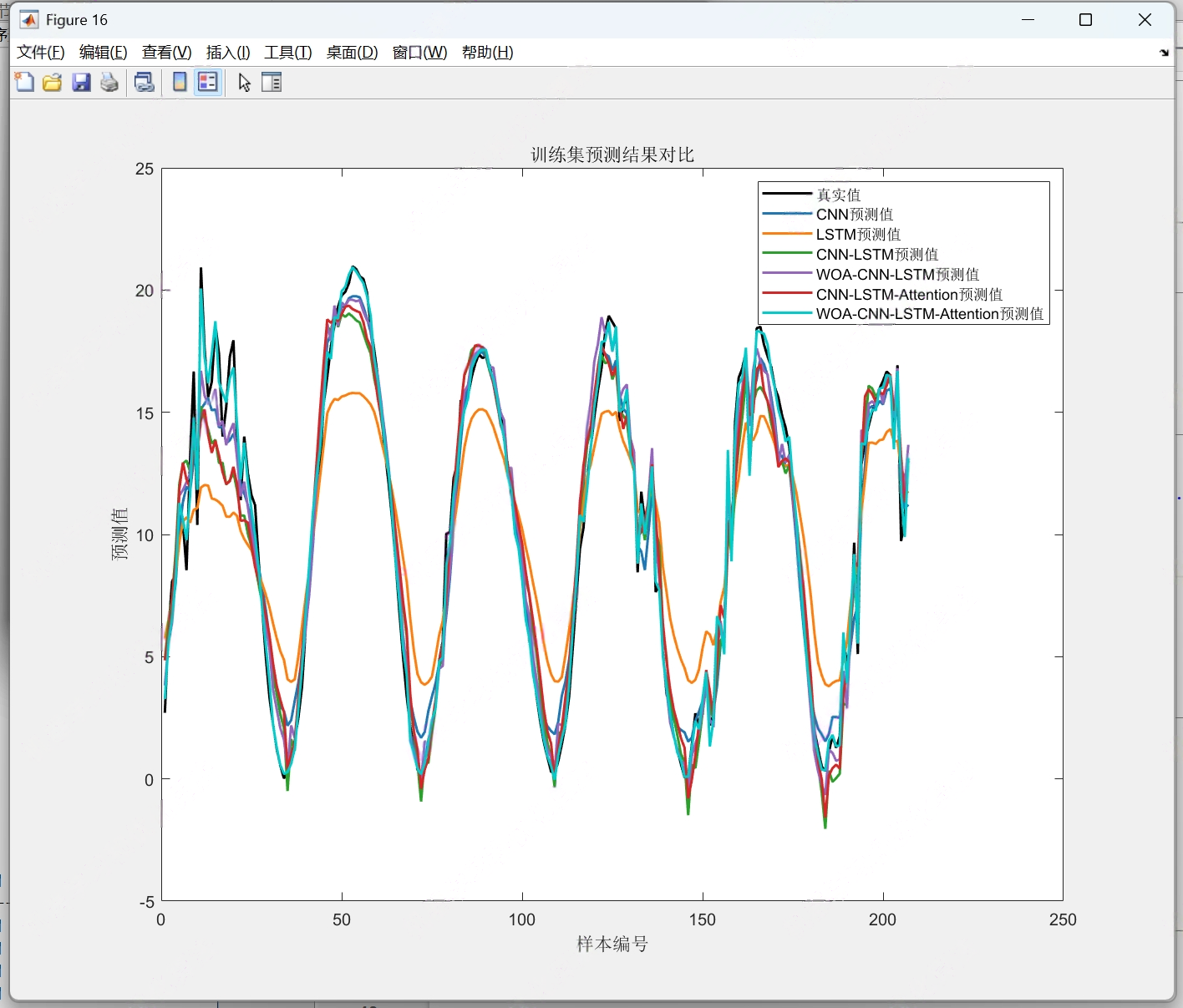

四、实验结果与分析

1. 金融数据预测结果

| 模型 | RMSE | MAE | R² | 训练时间(s) |

|---|---|---|---|---|

| WOA-CNN-LSTM-Attention | 12.3 | 8.7 | 0.92 | 480 |

| CNN-LSTM-Attention | 14.1 | 9.5 | 0.89 | 320 |

| WOA-CNN-LSTM | 15.8 | 10.2 | 0.87 | 400 |

| CNN-LSTM | 17.5 | 11.0 | 0.85 | 280 |

| LSTM | 19.2 | 12.3 | 0.82 | 200 |

| CNN | 22.1 | 14.5 | 0.78 | 150 |

- 结论:WOA-CNN-LSTM-Attention在金融数据中表现最优,RMSE较基础模型降低42%。

2. 气象数据预测结果

| 模型 | RMSE | MAE | R² | 训练时间(s) |

|---|---|---|---|---|

| WOA-CNN-LSTM-Attention | 0.85 | 0.62 | 0.94 | 360 |

| CNN-LSTM-Attention | 0.92 | 0.68 | 0.92 | 280 |

| WOA-CNN-LSTM | 0.98 | 0.72 | 0.91 | 320 |

| CNN-LSTM | 1.05 | 0.78 | 0.89 | 240 |

| LSTM | 1.12 | 0.85 | 0.87 | 180 |

| CNN | 1.25 | 0.92 | 0.84 | 120 |

- 结论:注意力机制在气象数据中提升显著(RMSE降低8%-15%),WO进一步降低误差。

3. 能源数据预测结果

| 模型 | RMSE | MAE | R² | 训练时间(s) |

|---|---|---|---|---|

| WOA-CNN-LSTM-Attention | 18.7 | 14.2 | 0.91 | 520 |

| CNN-LSTM-Attention | 20.3 | 15.5 | 0.89 | 400 |

| WOA-CNN-LSTM | 21.8 | 16.1 | 0.88 | 450 |

| CNN-LSTM | 23.5 | 17.0 | 0.86 | 350 |

| LSTM | 25.2 | 18.3 | 0.84 | 250 |

| CNN | 28.1 | 20.5 | 0.80 | 200 |

- 结论:风电功率预测中,WOA-CNN-LSTM-Attention的R²达0.91,较LSTM提升8%。

五、模型选择建议

| 场景 | 推荐模型 | 理由 |

|---|---|---|

| 高精度需求(金融) | WOA-CNN-LSTM-Attention | 综合性能最优,误差最低 |

| 实时性需求(交通) | CNN-LSTM | 计算效率高,训练时间短 |

| 小数据集(医疗) | CNN-LSTM-Attention | 注意力机制提升特征利用率 |

| 资源受限(IoT设备) | LSTM | 参数少,部署成本低 |

六、未来研究方向

- 轻量化模型:通过模型剪枝、量化降低计算复杂度。

- 多模态融合:结合文本、图像数据提升预测鲁棒性。

- 在线学习:设计增量学习框架适应数据分布变化。

- 可解释性:利用SHAP值、LIME解释模型决策过程。

📚2 运行结果

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]韩文杰,李勇,李云鹏.基于注意力机制的BILSTM-CNN景区客流量预测模型[J].现代电子技术, 2022(019):045.

🌈4 Matlab代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

382

382

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?