Datawhale干货

技术报告:DeepSeek v3.2

部分内容:DeepSeek、量子位

就在刚刚,DeepSeek 正式发布其最新版本:

DeepSeek-V3.2

DeepSeek-V3.2-Speciale

两个模型,两种体验。

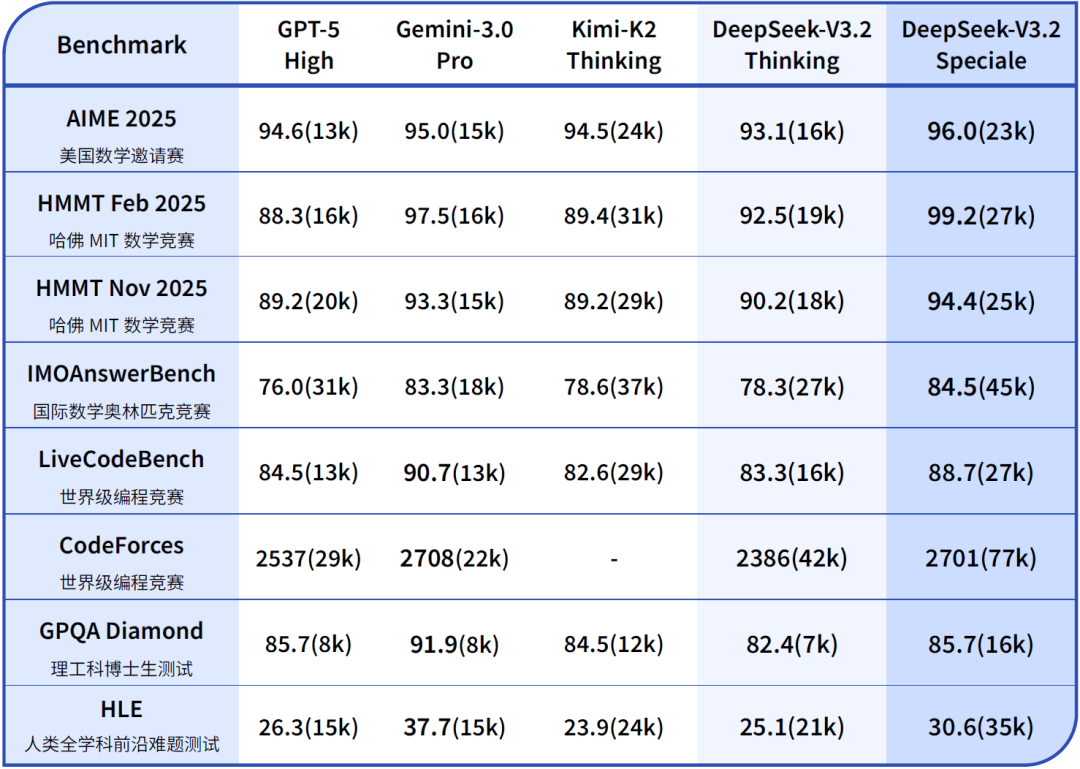

前者聚焦平衡实用,适用于日常问答、通用Agent任务、真实应用场景下的工具调用。推理达GPT-5水平,略低于Gemini-3.0-Pro。

后者主打极致推理,在数学和编码竞赛中展现出超越 Gemini-3.0-Pro 的性能。还一把斩获IMO 2025 和 IOI 2025金牌。

与两个模型一同发布的,还有配套的技术报告。

技术报告地址:https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.2/resolve/master/assets/paper.pdf

DeepSeek V3 系列的发展历程

先从技术角度,快速梳理一下新模型的三大升级点。

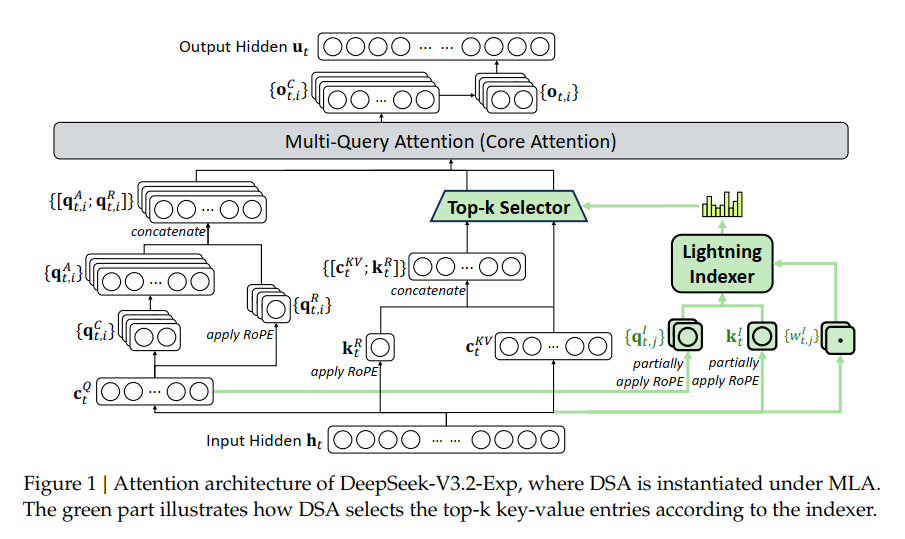

首先是 DeepSeek Sparse Attention(DSA)。这一稀疏注意力机制是 V3.2 相比 V3/V3.1 最大的架构升级,它将注意力计算的复杂度降到接近线性,在长文本推理场景下,推理成本大约降低了 50%。

其次是 可扩展的强化学习框架(Scalable RL Framework)。在后训练阶段投入了超过预训练 10% 的额外计算资源,用于强化学习,大幅提升了模型的整体能力。

第三是 大规模智能体任务合成管线(Agentic Task Synthesis Pipeline),专门用于在复杂、交互式环境中训练模型使用工具、遵循指令,从而增强其在各种 Agent 场景下的鲁棒性。

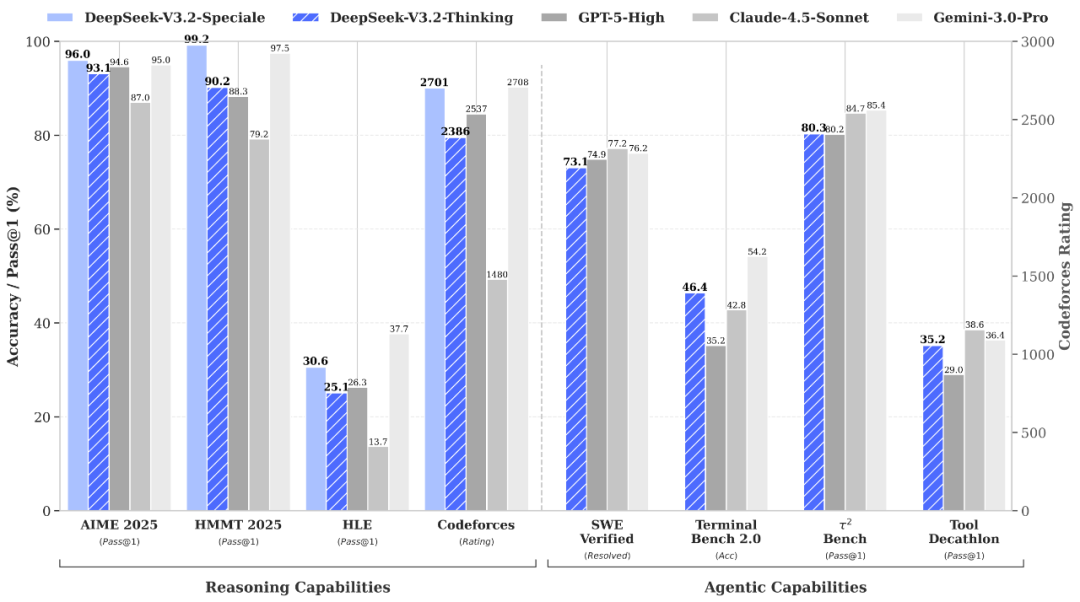

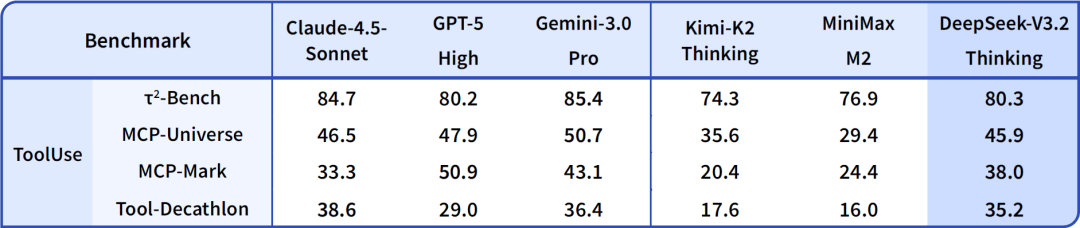

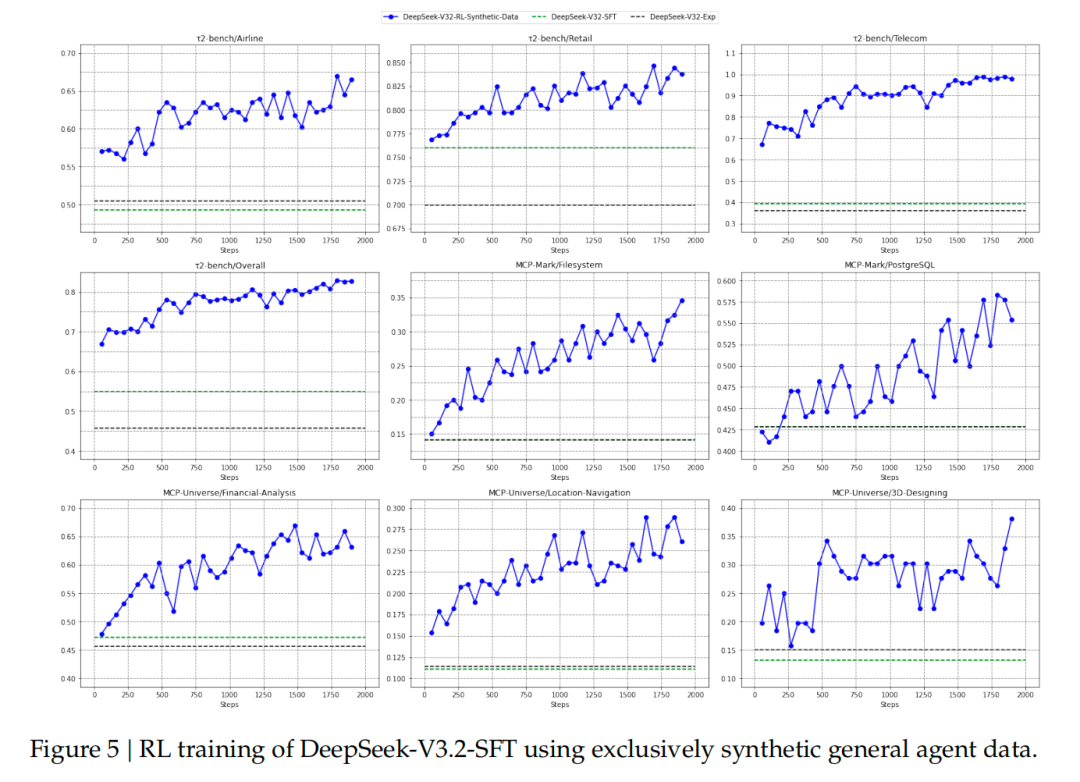

下图展示的是DeepSeek-V3.2与其他模型在各类Agent工具调用评测集上的得分:

放到DeepSeek V3的整个系列来看,去年年底DeepSeek V3的出现,首次采用了 MoE 和 MLA(密集注意力)。

再到 V3.1,引入了「混合推理模式」,并进一步增强了 Agent 能力。

随后推出的 V3.1-Terminus,主要是基于 V3.1 的用户反馈,重点解决了语言风格一致性和 Agent 稳定性方面的问题。

V3.2-Exp 可以看作是 DSA 架构的实验性试水版本;在此基础上,V3.2 则是在采用 DSA 架构的前提下,叠加更大规模的强化学习训练和 Agentic 任务合成,形成的正式、稳定版本。

图源:Founder Park

所以得益于 DSA 的引入,V3.2 解决了 V3/V3.1 在长上下文推理中的效率与成本瓶颈,同时也带来了显著的推理成本优势。

这次发布的还有第二个专注于高计算量推理的实验变体模型:DeepSeek-V3.2-Speciale。

在指令跟随、数学证明、逻辑验证方面,DeepSeek-V3.2-Speciale能力出众,推荐用来完成高度复杂数学推理、编程竞赛、学术研究类任务。

特别注明!这个版本目前没有针对日常对话与写作做专项优化。

而且仅供研究使用,不支持工具调用。

在高度复杂任务上,Speciale模型大幅优于标准版本,但消耗的Tokens也显著更多,成本更高。

接下来,基于技术报告,我们详细来看本次升级的三大核心。

核心一:提出DSA机制,长文本不再是负担

回顾 DeepSeek 从 V3 到 V3.1-Terminus 再到 V3.2 的迭代,V3.2 最大的架构创新就是引入 DeepSeek Sparse Attention (DSA) 机制。

传统的注意力机制在处理长序列时计算复杂度是O(L²),严重制约了模型的部署效率和后续训练的可扩展性。

DSA让计算复杂度降低到O(L·k),k远小于L。

与此同时,DSA让模型在长上下文任务中显著加速推理,且无明显性能损失。

支持FP8精度,适配MLA(Multi-Query Attention)架构,训练友好。

怎么做到的?

DSA主要包含两个组件,一个叫lightning indexer(闪电索引器),另一个叫fine-grained token selection(细粒度token选择)机制。

闪电索引器负责快速计算查询token和历史token之间的相关性分数,然后只选择top-k个最相关的token进行注意力计算。

团队特意选用了ReLU激活函数来提升吞吐量。

DeepSeek-V3.1-Terminus开始继续训练时,团队采用了两阶段策略。

第一阶段是Dense Warm-up,保持密集注意力,只训练lightning indexer,让它学会对齐主注意力的分布。

这个阶段只用了1000步,处理了21亿个tokens。

第二阶段才引入稀疏机制,每个查询token选择2048个键值对,训练了15000步,总共处理了9437亿个tokens。

实测效果相当给力——

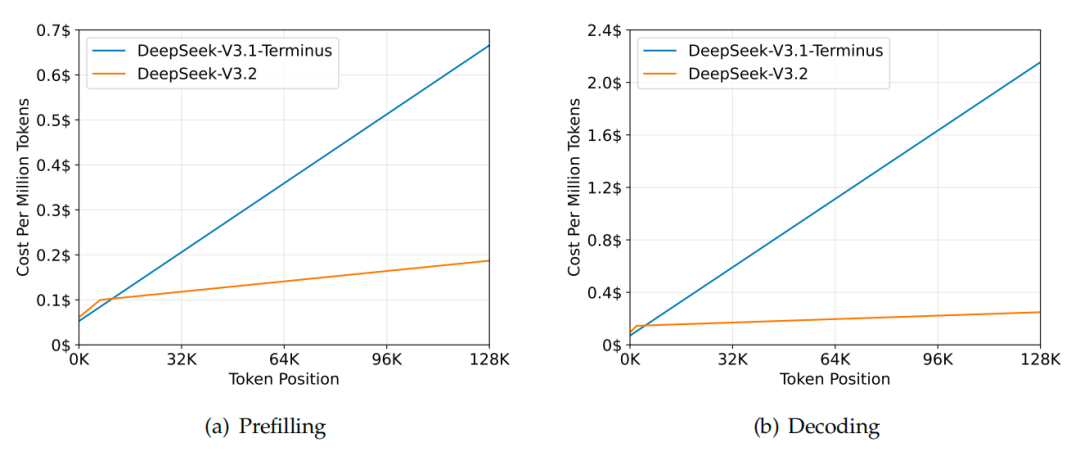

在128k长度的序列上,DeepSeek-V3.2的推理成本比V3.1-Terminus降低了好几倍。

H800集群上的测试显示,当序列长度达到128K时,预填充阶段每百万token的成本从0.7美元降到了0.2美元左右,解码阶段从2.4美元降到了0.8美元。

核心二:后训练算力超过预训练的10%

值得注意的是,DeepSeek团队这次在强化学习上下了血本。

论文里明确提到,RL训练的计算预算已经超过了预训练成本的10%,这在开源模型里相当罕见。

DeepSeek在技术报告中提到,开源模型在post-training阶段的计算资源投入不足,限制了其在困难任务上的性能。

为此,团队开发了稳定、可扩展的RL协议,使训练后阶段的计算预算超过了预训练成本的10%,从而解锁了模型的先进能力。

展开讲讲——

为了稳定地扩展RL计算规模,团队在GRPO(Group Relative Policy Optimization)算法基础上做了好几项改进。

首先是无偏KL估计,修正了原始的K3估计器,消除了系统性误差。

原来的估计器在某些情况下会给出无界的梯度权重,导致训练不稳定。

其次是离线序列掩码策略。

在实际训练中,为了提高效率通常会生成大批量的rollout数据,然后分成多个mini-batch进行梯度更新。这种做法本身就引入了off-policy行为。

团队通过计算数据采样策略和当前策略之间的KL散度,把那些偏离太远的负样本序列给mask掉,避免它们干扰训练。

团队还特别针对MoE模型设计了Keep Routing操作。

推理框架和训练框架的实现差异可能导致同样的输入激活不同的专家,这会造成参数空间的突变。通过保存推理时的路由路径并在训练时强制使用相同路径,确保了参数优化的一致性。

在具体训练上,团队采用了专家蒸馏的策略。

先为每个任务训练专门的模型,包括数学、编程、通用逻辑推理、通用Agent任务、Agent编程和Agent搜索这6个领域,每个领域都支持思考和非思考两种模式。

然后用这些专家模型生成特定领域的数据来训练最终模型。

核心三:Agent能力的突破

此外,此次新模型在Agent任务上的突破也让人眼前一亮。

这次团队找到了让模型同时具备推理和工具使用能力的方法。

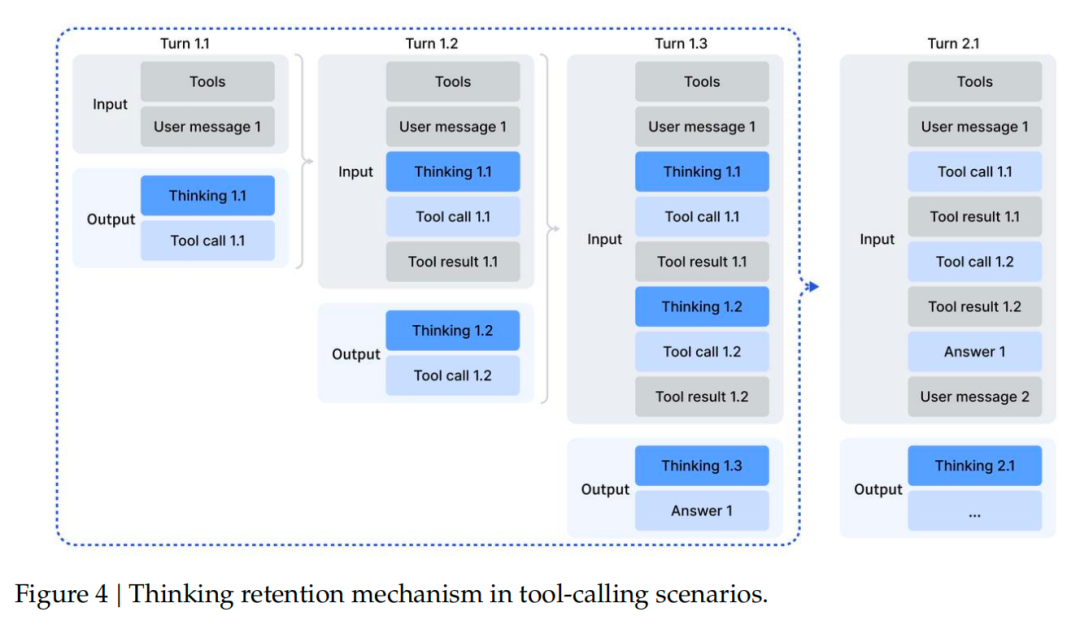

在思考上下文管理方面,团队发现DeepSeek-R1那种每次开启新对话就丢弃推理内容的策略,实在是太——浪费token了。

于是设计了新的管理机制:

只有在引入新的用户消息时才丢弃历史推理内容,如果只是添加工具相关消息,推理内容会被保留。即使推理痕迹被删除,工具调用历史和结果也会保留在上下文中。

冷启动阶段,DeepSeek-V3.2团队采用了巧妙的prompt设计。

团队通过精心设计的系统提示,让模型学会在推理过程中自然地插入工具调用。

比如在处理编程竞赛题目时,系统会明确要求模型先思考再给出答案,并用特殊标签标记推理路径。

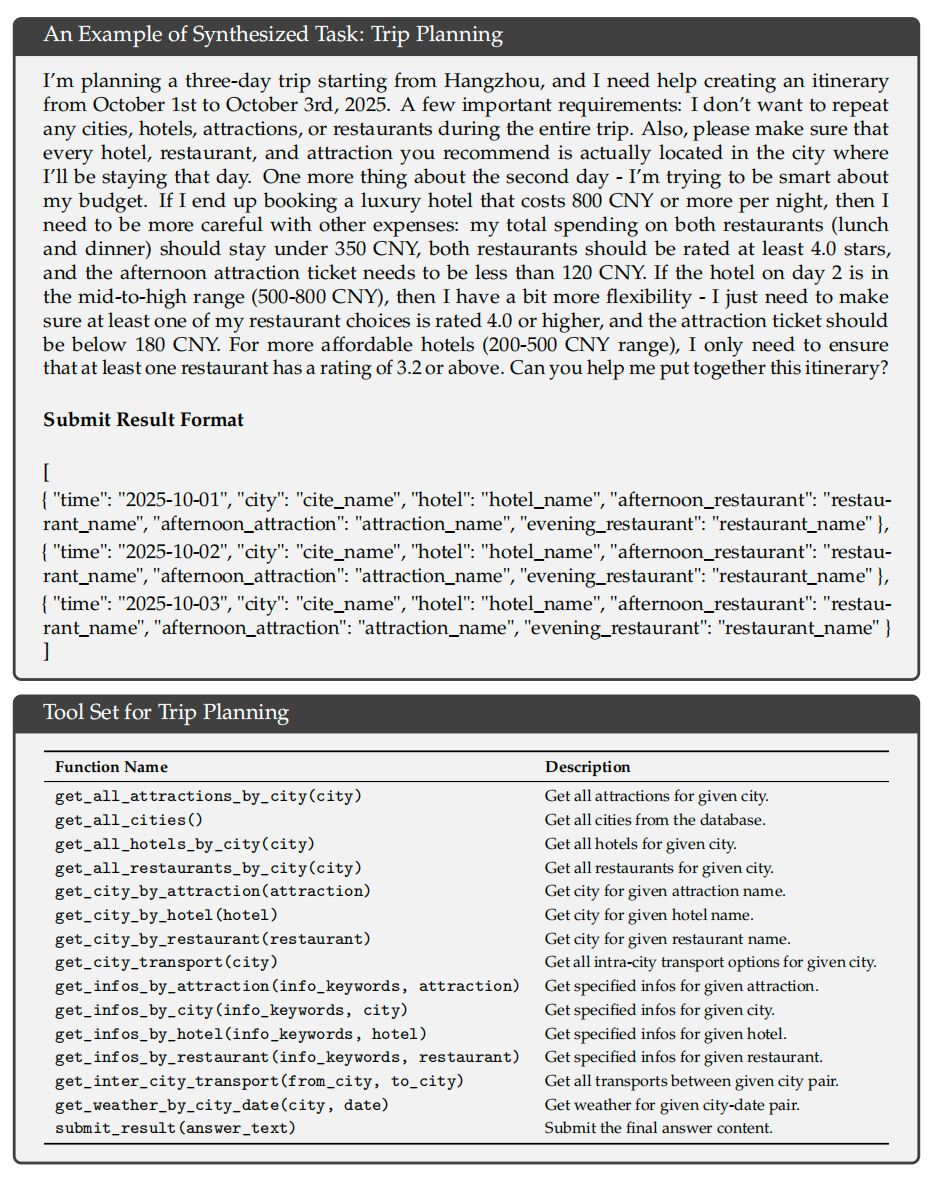

最硬核的是团队开发了一个自动环境合成pipeline,生成了1827个任务导向的环境和85000个复杂提示。

以旅行规划为例,模型需要在满足各种约束条件下规划三天的行程,包括不重复城市、根据酒店价格调整餐厅和景点预算等复杂逻辑。

虽然在巨大的组合空间中找到满足所有约束的方案很困难,但验证给定方案是否满足约束相对简单,这种”难解易验”的特性非常适合RL训练。

在代码Agent方面,团队从GitHub挖掘了数百万个issue-PR对,经过严格筛选和自动环境构建,成功搭建了数万个可执行的软件问题解决环境,涵盖Python、Java、JavaScript等多种语言。

搜索Agent则采用多Agentpipeline生成训练数据,先从大规模网络语料中采样长尾实体,再通过问题构建、答案生成和验证等步骤产生高质量数据。

评测结果显示,DeepSeek-V3.2在SWE-Verified上达到73.1%的解决率,在Terminal Bench 2.0上准确率46.4%,都大幅超越了现有开源模型。

在MCP-Universe和Tool-Decathlon等工具使用基准测试上,DeepSeek-V3.2也展现出了接近闭源模型的性能。

这些提升,证明了模型能够将推理策略泛化到训练时未见过的Agent场景。

一起“点赞”三连↓

626

626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?