一、Llama-factory安装

1、通过github下载最新版本的llama-factory代码包

2、在GPU服务器上解压

| unzip Llama-factory-main.zip |

3、创建一个虚拟环境

| conda create -n llama-factory --offline --clone base |

4、安装llama-factory依赖包

| cd Llama-factory-main pip install -e “.[torch, metrics]” |

5、安装过程中可能存在报错,根据报错信息进行解决,例如:

| import _soundfile_data # ImportError if this doesn’t exist 解决方案: yum install libsndfile |

6、检查llama-factory是否安装成功

| llamafactory-cli version |

显示内容如下,说明llama-factory安装成功。

二、数据集及训练模型准备

1、数据集准备

这里使用测试团队提供的训练数据集,共计477条数据。该数据集由测试团队自行整理,内容为“测试用例生成脚本”的数据集,期望微调后模型能够根据“测试指令”生成相应的“测试脚本”。其中“input”为输入,“output”为期望输出。

-

这里将数据进行3:7分,其中137条作为评估数据集,340条作为训练数据集。

-

将训练及测试数据上传至:./Llama-factory/data目录,并修改目录下面的dataset_info.json文件,增加以下内容(方便后续llama-factory识别到新增数据集):

| “testcase_pred”: { “file_name”: “data_json_0710_pred.json” }, “testcase_train”: { “file_name”: “data_json_0710_train.json” }, |

2、训练模型准备

我们使用的基础模型为qwen3-8b,直接从魔搭社区(modelscope)下载对应的模型(safetensors格式),下载模型放置到服务器的目录,例如:

/data/1/models/Qwen/qwen3-8b。

三、基于llamfa-factory webui进行微调

Llama-factory支持命令行直接训练,并提供webui进行可视化操作。这里在对微调过程及命令行不熟悉的情况下,新手使用webui进行微调训练即可,非常简单。webui启动命令如下:

| cd /data/1/models/Llama-factory CUDA_VISIBLE_DEVICES=2,3 GRADIO_SERVER_PORT=9582 llamafactory-cli webui # 使用2、3号GPU进行模型训练,webui端口号为**9852 |

启动成功后,登陆http://IP:9852查看web页面,后续可基于此页面进行模型微调。

模型训练整个过程包含了:**训练****/****微调、评估、对话、导出**四个主要内容。

1、模型微调

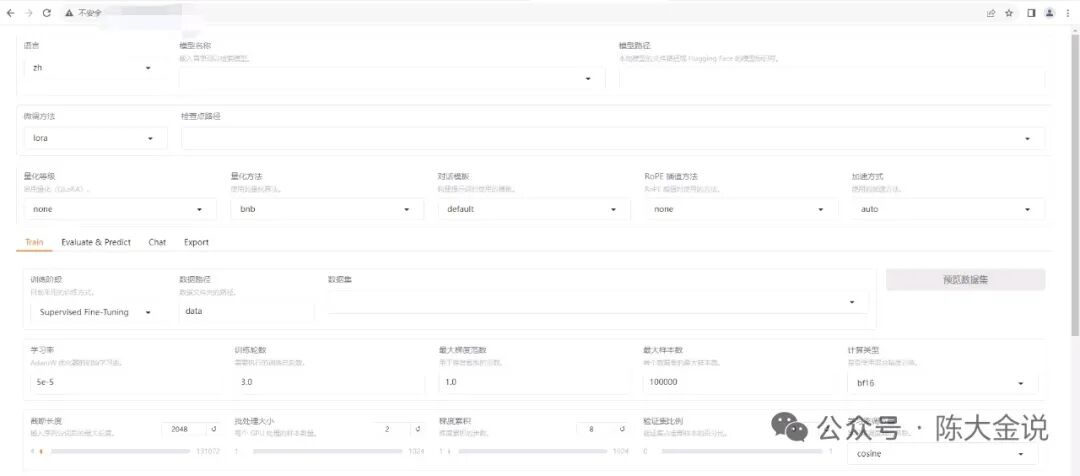

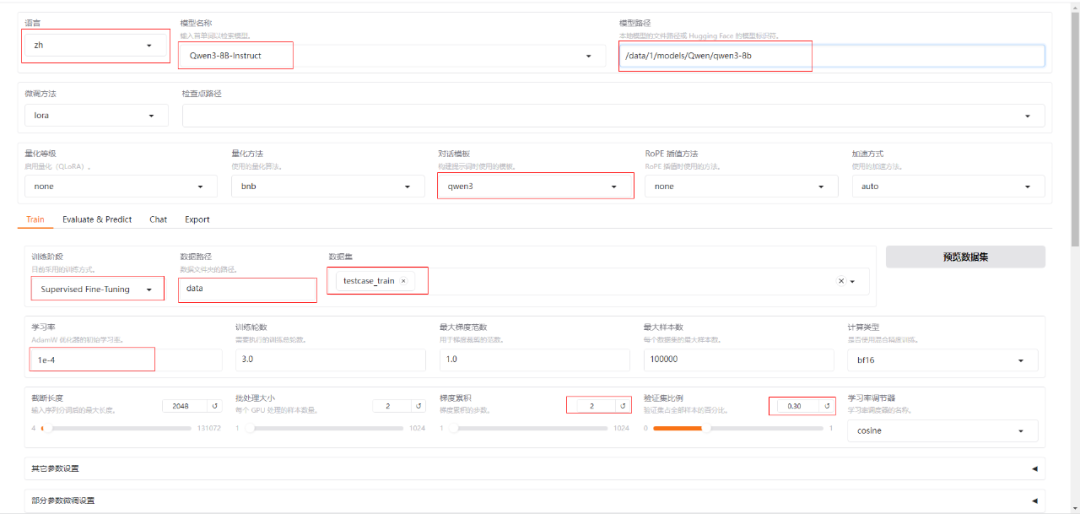

1) 对页面内容进行配置如下(这里选择本地模型作为基础模型,并选择testcase_train作为训练数据集):

2) 这里优化方案暂时未配置,使用默认方式(后续需进一步学习,这里面涉及到一些训练优化算法的配置)。

3)点击预览命令,可查看本次的训练完整命令;

4)点击保存训练参数,可将本次配置参数保存至本地;

5)点击开始按钮,启动模型微调

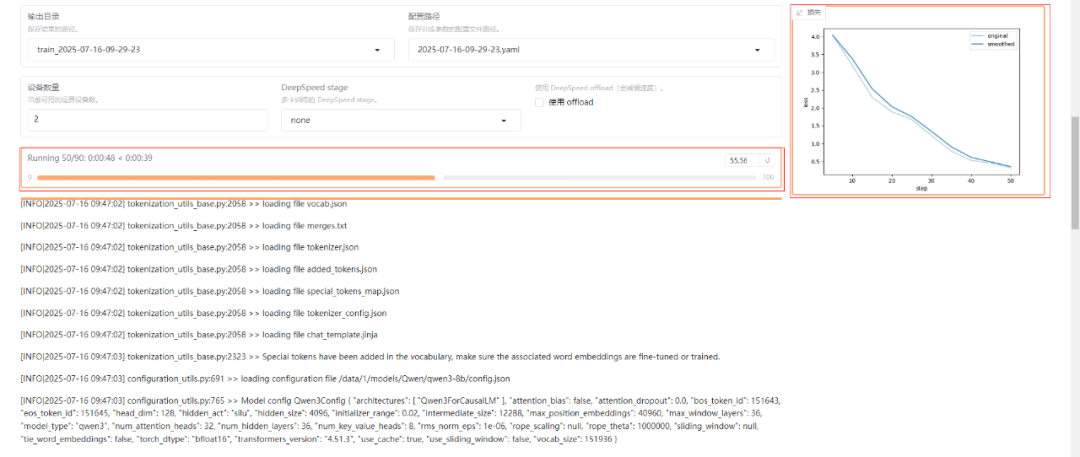

6)模型训练启动成功后,可查看模型训练进度以及损失函数降低情况:

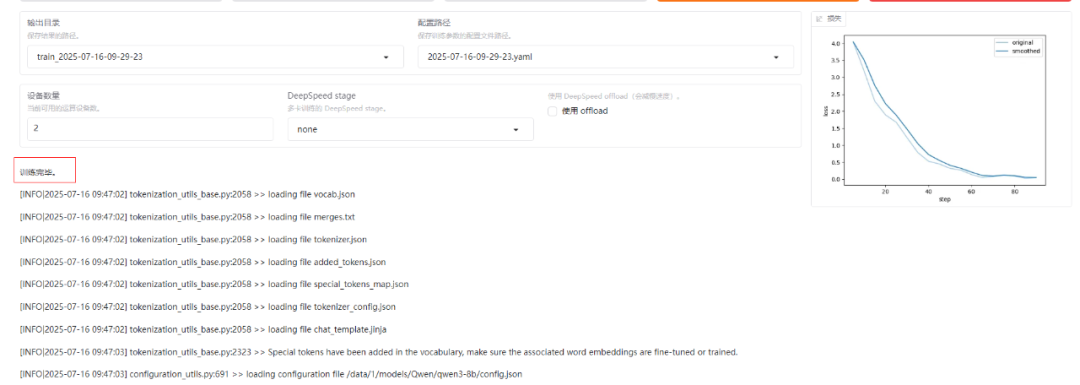

7)训练完毕后,页面有明显的提示信息

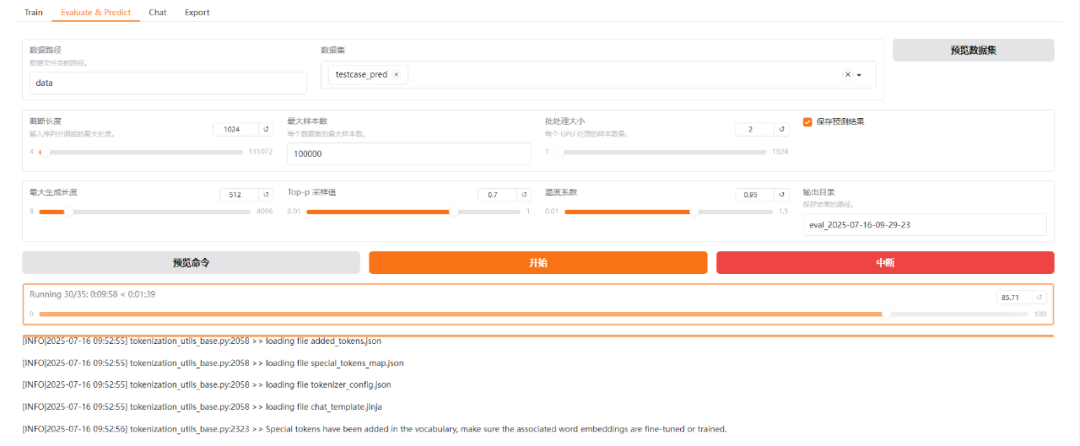

2、模型评估

1)切换到Evaluate&Predict页面,选择之前准备的评估数据集,启动模型评估过程

2)同样有进度条,可查看任务进度

3)当前评估结果如下所示(指标项很差):

| { “predict_bleu-4”: 4.891540000000001, “predict_model_preparation_time”: 0.0064, “predict_rouge-1”: 7.424934285714286, “predict_rouge-2”: 2.1897800000000003, “predict_rouge-l”: 4.195487857142858, “predict_runtime”: 725.8749, “predict_samples_per_second”: 0.189, “predict_steps_per_second”: 0.048 } |

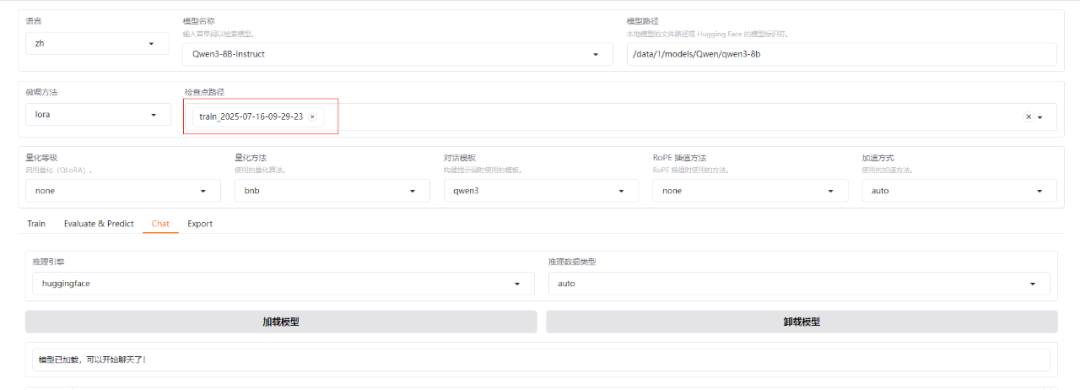

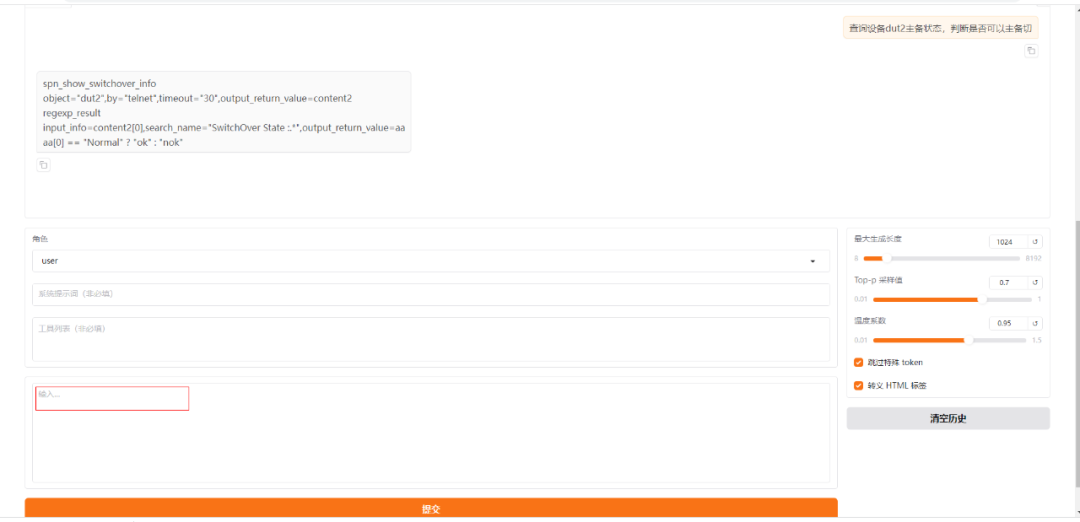

3、模型对话

1)切换至Chat,选择之前训练的检查点,点击加载模型

2)模型加载完成后,输入部分内容,查看输出结果是否满足预期

3)此时可以看到,微调后的模型能够针对特定的对话,给出期望的输出结果

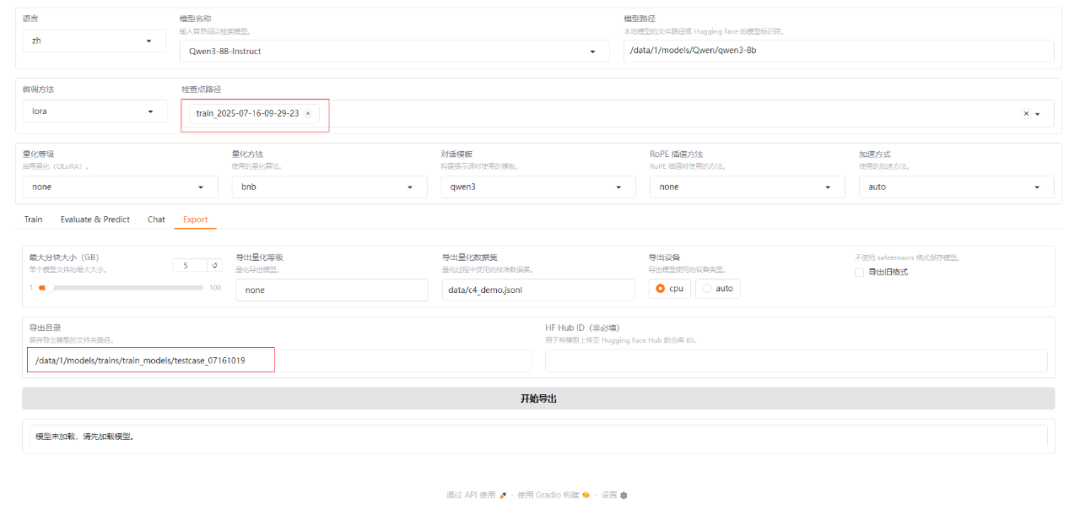

4、模型导出

1)切换到Export页面,

2)输入导出目录,点击开始导出,此时llama-factory将合并基础模型与微调检查点内容,并输出完整模型。

3)导出完成后,页面会有明显提示信息

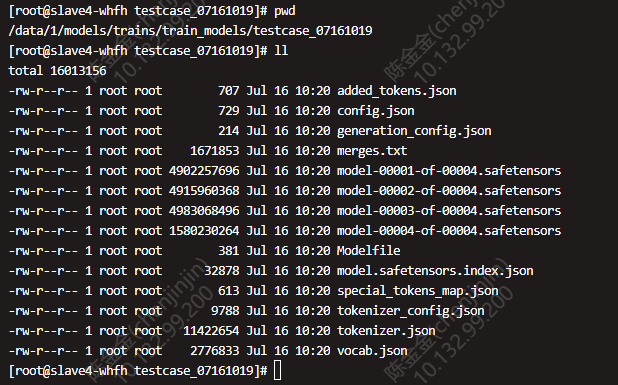

4)此时进入到对应的服务器目录,可查看当前训练完成的完整模型。

四、写在最后

至此,完成一次完整的模型微调过程。从操作上来说已经非常简化了,至少能够完整地跑通一遍微调过程。虽然从模型评估数值结果来看,模型微调效果较差,需要进一步研究与调整模型微调方法。

那么,如何系统的去学习大模型LLM?

作为一名深耕行业的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

1608

1608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?