Reasoning Model,或者叫推理模型,大概是从OpenAI 的 o1-preview 模型[1](2024-09-12)开始广泛受到关注的。OpenAI 在博客中明确指出了这种模型与传统 LLM 的主要区别:

We’ve developed a new series of AI models designed tospend more time thinkingbefore they respond.

The o1 model series is trained withlarge-scale reinforcement learning to reason using chain-of-thought.

After training with the same high-compute reinforcement learning (RL) pipeline as o1, o1‑mini achieves comparable performance on many useful reasoning tasks, while being significantly more cost efficient.

随后,市场涌现了一批推理模型,例如热度颇高的 DeepSeek R1、Gemini 2.0 Flash Thinking、Gemini 2.5 Pro 以及 Claude 3.7 Sonnet Thinking 等。那么,它们和传统 LLM 到底有什么具体区别呢?

一、传统 LLM 与推理模型的使用方式

首先回想一下,我们通常如何使用传统的 LLM:

这是最简单的方式,直接输入问题,获得答案,不满意再继续交流。

后来出现了链式思考(Chain-of-Thought,CoT[2]),通过明确告诉模型中间的推理步骤,大幅提升了推理性能,再结合 few-shot 等 prompt 技术,让 LLM 使用体验提升了一个层次:

甚至我们还可以加入一个“验证器”,让模型自己检查输出的正确性,例如运行代码看是否报错或效果达标,不正确则自我修正:

然而,手动管理这些过程过于繁琐。那能否将这些推理过程内置到模型中呢?当然可以。推理模型便是通过在训练过程中引入链式思考和验证步骤,使其能够自主生成、执行并检查推理过程,从而诞生了:

二、推理模型内部到底做了什么?

从训练角度看,推理模型实际上就是把 CoT 和验证环节内置到模型中,再通过大规模的强化学习进行训练。因此,推理模型的回答通常包含一长串“思考”过程(当然,它们并非真正的思考,而是模型生成的 token 序列)。

实际上,推理模型在训练中使用的链式思考往往比我们人工设计的更加复杂。具体来说,模型在推理时会:

- • 仔细分解复杂问题,逐步解决每个子问题。

- • 评估自己的部分解决方案,定位错误并纠正。

- • 探索并比较多个可能的替代方案。

然而,这些思考过程与普通 token 的生成机制本质上并无区别。

同时,由模型生成的推理过程往往不便于人类阅读,这在 DeepSeek R1 的论文中有所提及。也正因此,OpenAI 的 o 系列模型选择不展示完整的思考过程,而是提供摘要,以改善使用体验。

三、思考过程越长,模型准确性越高?

一般而言,是的。DeepSeek R1 的论文指出,模型倾向于对复杂问题使用更长的思考过程,而且这一过程是模型自行发展出来的,不是规则写的:

然而最近发表的一篇论文《Concise Reasoning via Reinforcement Learning》[3]却提出了不同的观点:

- • RL 模型偏爱长输出只是优化目标的副作用。当奖励信号较弱或为负时,模型倾向于生成更长的答案来试图减少损失,而不是因为长答案本身更有效。

- • 实际上,短答案往往更准确。统计分析表明,正确答案的平均长度明显短于错误答案。换句话说,模型正确回答时倾向简洁,错误回答时更可能冗长。

在这里插入图片描述

- • 长输出更易进入“死胡同”(deadend)。更多的 token 意味着更高的概率走入错误且难以纠正的推理路径。

因此,推理过程变长并不一定意味着模型变聪明了,这种现象更像是一种刻意设计的结果。

四、思考长度可控且收费

值得一提的是,OpenAI 的 reasoning model 提供了思考长度可调节的机制,用户可选择 low、medium(默认)或 high 三种reasoning effort[4]:

the

reasoning_effortparameter is used to give the model guidance on how many reasoning tokens it should generate before creating a response to the prompt.

这些推理产生的 token 被称为 reasoning token,并且是收费的。

- • Reasoning token 以 output token 价格计费,都属于 completion token。

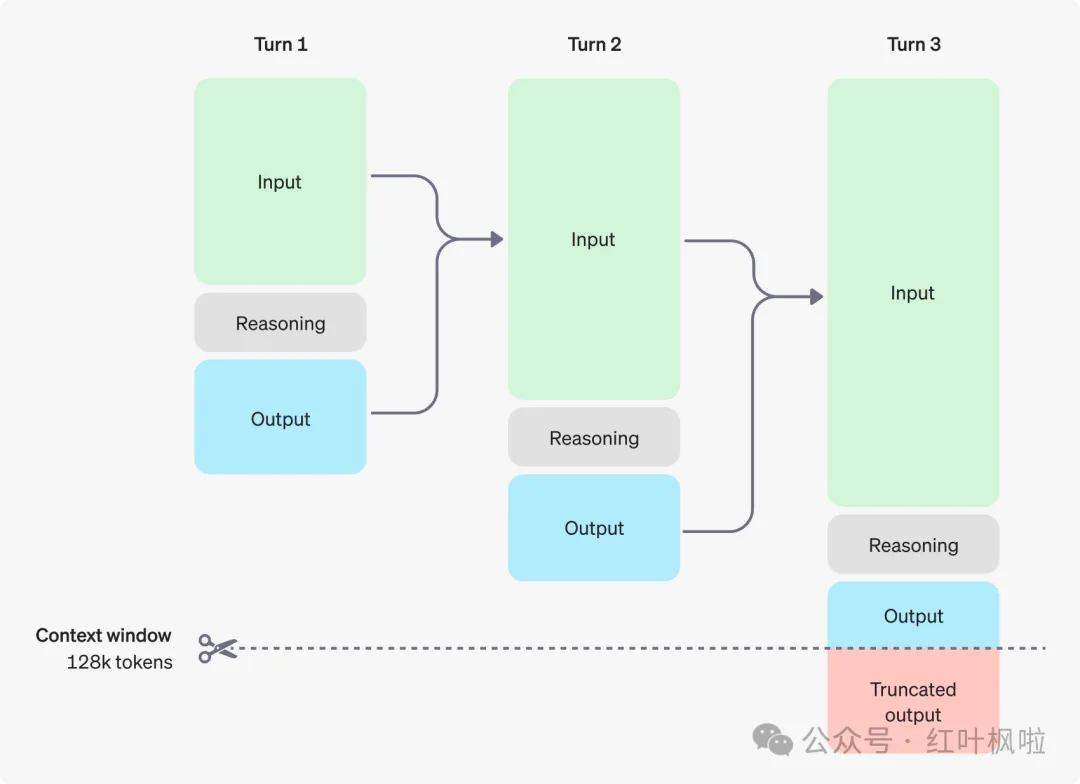

- • 在多轮对话中,reasoning token 不会放入下一轮的 input 中,但是是要计入 context window 的:

总之,推理模型在能力提升的同时,也引入了更多的复杂性和成本考量,因此在使用时需要明确自己的实际需求与预算约束。我个人觉得在大部分企业生产场景下(需要大规模调用的)是用不到推理模型的。

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

引用链接

[1]OpenAI 的 o1-preview 模型:https://openai.com/index/introducing-openai-o1-preview/

[2]CoT:https://arxiv.org/abs/2201.11903

[3]论文《Concise Reasoning via Reinforcement Learning》:https://arxiv.org/abs/2504.05185

[4]reasoning effort:https://platform.openai.com/docs/guides/reasoning#reasoning-effort

[5]https://cameronrwolfe.substack.com/p/demystifying-reasoning-models

1180

1180

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?