会自检的ReflectDrive:我的轨迹我做主,安全感拉满!

端到端自动驾驶已成为一个重要且快速发展的研究领域。通过大规模数据集学习类人驾驶策略具有相当大的潜力。但是在多模态性能以及长尾场景,没有可持续解决问题的框架。如果仅依赖强化学习来加强,那么reward hack又成为了棘手的问题,很难写出一个全面的reward可以适用连续轨迹复杂的三维空间。所以近年来大语言模型的泛化能力突破让大家看到了希望,是否能够利用模型scaling以及数据scaling去激发模型的泛化性能,也就是vla模型的兴起。

大家都想利用上vlm的泛化能力,用更少的数据去解决few shot/zero shot的场景。下面是对于目前自动驾驶方案vla方案的痛点分析:

常见的vla结构,例如diffvla[1],由一个vlm模型输出决策和驾驶指导,作为条件输入给diffusion生成轨迹,这样语义决策、驾驶指导和动作模块就被分割成了两个系统,多个系统的结果不能保证一致性,存在脑裂问题。

目前的模仿学习安全性不能得到保证,例如碰撞,强化学习也只是尝试教会模型因果关系,但很难平衡好效率和安全。Diffusion planner[2] 也需要求解reward 梯度对轨迹进行指导修正,而这个梯度在复杂场景下也较难计算准确。

现在vla的难点是在于算力限制,直接输出traj(token数过多)耗时太长,所以一般会再接一个单独的traj decoder,从vlm传递出一个隐特征给到traj decoder,可以是diffusion或者一个小的ar模型。但是一旦增加traj decoder就涉及中间传递信息不足的问题,pi0.5也提出了深层信息交互的思路,但是实际效果提升有限。也可以是WALL-OSS[3]的思路,将action FFN分开,加快decoder的速度,从而实现更加高效的AR。不过这些都是基于AR,生成效率仍是主要问题。

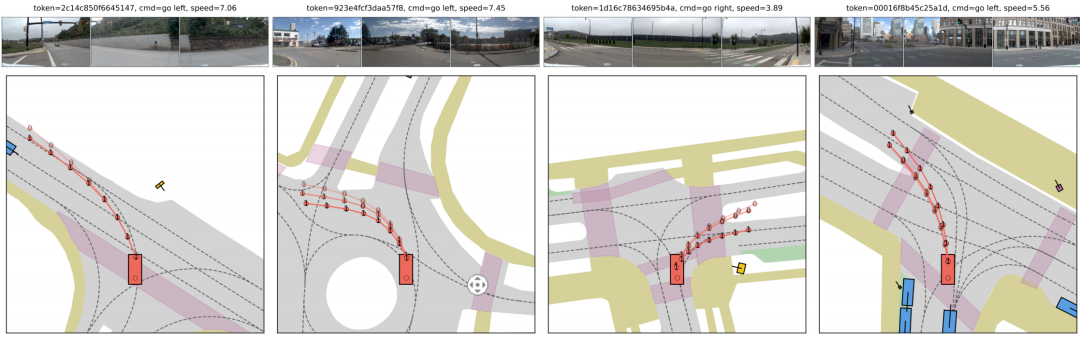

基于上面的描述,可以看出目前迫切需要做到的是L模态和A模态的融合,一种更容易scaling的统一的架构,同时还要做到高效生成。为应对这些挑战,理想和清华的团队提出ReflectDrive——一种新型学习框架,通过离散扩散的反思机制实现安全轨迹生成。我们首先将二维驾驶空间离散化以构建动作代码本,从而能够通过微调将预训练扩散语言模型用于规划任务。该框架的核心是安全感知的反思机制,无需梯度计算即可实现迭代自校正,我们的灵感来源于时空联合规划迭代式搜索的思路,将优化的过程变成了离散扩散模型:首先生成目标条件轨迹以建模多模态驾驶行为,随后基于局部搜索方法识别不安全标记并确定可行解,这些解将作为基于修复式再生成的安全锚点。在NAVSIM基准测试中,ReflectDrive展现出显著的安全关键轨迹生成优势,为自动驾驶系统提供了可扩展且可靠的解决方案。

论文链接:https://arxiv.org/pdf/2509.20109

Github链接:https://github.com/pixeli99/ReflectDrive

一、引言

自动驾驶正引领交通行业迈向更安全、更高效的未来。在这一趋势下,端到端(E2E)系统已成为传统模块化设计的主流替代方案——传统模块化设计在相互依赖的模块间易产生误差累积;同时,端到端系统也在很大程度上取代了基于规则的方法,这类方法往往需要大量人力工程投入。与此同时,视觉-语言-动作(VLA)模型通过融合视觉-语言模型(VLM)的预训练知识,提供了一种新的解决方案。凭借更强的泛化能力,VLA模型能够理解视觉场景和人类指令,并直接输出规划轨迹,从而提升在复杂场景中的适应性。

然而,现有基于学习的方法并未解决基于模仿学习的驾驶系统中的核心难题。具体而言,行为克隆无法自然编码不可违背的物理规则,例如避撞或保持在可行驶区域内。这导致模型生成的轨迹可能在其概率分布内具有较高可能性,却仍违反关键安全约束。因此,现有已部署的解决方案通常依赖大量人类先验知识,例如轨迹锚点或基于规则生成的路径。这些先验知识为学习系统提供了可靠的初始解,但也需要大量后处理操作,尤其是在复杂场景中。

与此同时,更先进的解决方案也在不断涌现。部分方法将强化学习与人工设计的奖励函数相结合,以增强因果推理能力。然而,大多数现有研究仍局限于仿真层面。从部署角度来看,这些方法通常需要进行具有安全风险的在线rollouts,并且存在训练不稳定性问题,在大规模模型中该问题尤为突出。尽管扩散模型中的引导机制通过在推理阶段实现可控生成,提供了一种颇具潜力的替代方案,但这类方法往往因梯度计算导致采样速度缓慢,且对参数调优高度敏感,易引发数值不稳定性。

为解决上述挑战,我们率先将离散扩散应用于规划任务,以满足可验证、可控制的端到端驾驶系统需求。该方法的核心优势在于其在离散动作空间中运行,能够在轨迹生成过程中通过搜索、掩码和采样技术,无缝融入关键安全约束。这形成了一种混合框架:在该框架中,学习到的行为可通过先验知识进行严格引导,从而从“黑箱式规划”转向“可信且可解释的决策”。基于这些见解,我们提出了ReflectDrive——一种新型基于学习的框架,该框架集成反思机制,通过离散扩散实现安全轨迹生成。

具体而言,我们首先对二维驾驶空间进行离散化处理,构建动作码本,从而能够通过离散码本嵌入表示车辆轨迹。这种表示方式使我们能够通过微调,将预训练扩散语言模型(DLM)应用于规划任务。该方法支持在统一架构内进行并行解码和双向特征融合,从而实现可扩展训练。

以该微调模型为基础,我们的反思机制从目标条件生成开始:目标点引导生成过程,以捕捉多样的多模态驾驶行为。此外,该框架还集成安全指标,用于评估生成的多模态轨迹。对于不安全的路径点,我们通过局部搜索确定可行解,该可行解随后将作为轨迹修复的安全锚点令牌。整个过程无需梯度计算,能够在轨迹再生过程中实现并行生成和安全约束注入。

在真实世界自动驾驶基准测试集NAVSIM上的评估结果验证了将离散扩散应用于轨迹生成的可行性。配备反思机制后,ReflectDrive实现了接近人类水平的闭环性能。我们的贡献总结如下:

首次将离散扩散应用于端到端自动驾驶轨迹生成,并将其集成到VLA模型中以实现可扩展训练。

提出反思机制——一种专为离散扩散去噪过程设计的新型推理阶段引导框架,将外部安全验证与高效离散令牌优化相结合。

在真实世界驾驶基准测试集上对该方法进行评估,证明该框架能够在不影响行为连贯性的前提下,强制满足严格的安全约束。

二、预备知识回顾

自动驾驶规划

我们将自动驾驶规划任务表述为学习条件分布 ,其中目标是生成未来轨迹 。每个路径点均在自车坐标系下表示,且以场景上下文 为条件——场景上下文包括多视图图像、指令和自车状态。规划任务的核心挑战在于,轨迹必须遵守交通规则和安全约束,而基于模仿学习的方法由于缺乏确保严格遵守这些要求的显式信号,难以应对这一挑战。

离散扩散

离散扩散模型已成为生成结构化序列的强大非自回归范式。该过程由前向损坏过程和学习到的反向去噪过程定义。

前向与反向过程

前向过程在 个时间步内对离散令牌的干净序列 进行损坏。在每个时间步 ,通过对序列 中的部分令牌进行掩码操作,生成序列的含噪版本 。具体而言,首先采样一个二进制掩码

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6612

6612

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?