视觉-语言-动作(Vision Language Action, VLA)模型的出现,标志着机器人技术从传统基于策略的控制向通用机器人技术的范式转变,同时也将视觉-语言模型(Vision Language Models, VLMs)从被动的序列生成器重新定位为在复杂、动态环境中执行操作与决策的主动智能体。

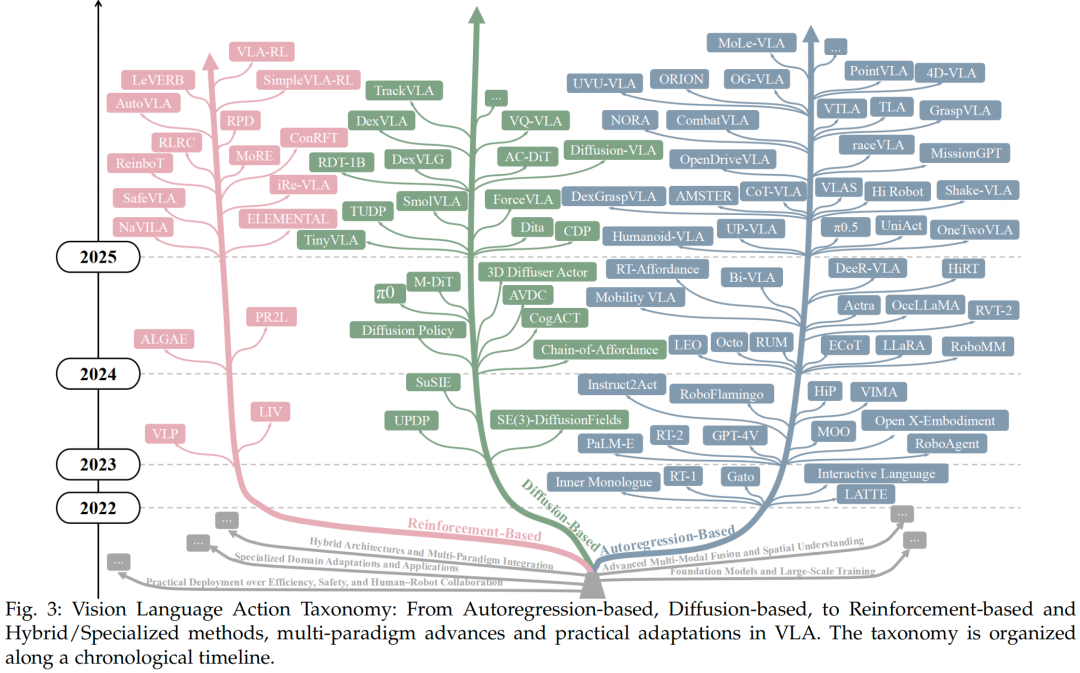

为此,兰州大学、中科院和新加坡国立大学的团队深入探讨了先进的VLA方法,旨在提供清晰的分类体系,并对现有研究进行系统、全面的综述。文中全面分析了VLA在不同场景下的应用,并将VLA方法划分为多个范式:自回归、扩散模型、强化学习、混合方法及专用方法;同时详细探讨了这些方法的设计动机、核心策略与实现方式。

此外,本文还介绍了VLA研究所需的基础数据集、基准测试集与仿真平台。基于当前VLA研究现状,综述进一步提出了该领域面临的关键挑战与未来发展方向,以推动VLA模型与通用机器人技术的研究进展。通过综合300多项最新研究的见解,本综述勾勒出这一快速发展领域的研究轮廓,并强调了将塑造可扩展、通用型VLA方法发展的机遇与挑战。

论文标题:Pure Vision Language Action (VLA) Models: A Comprehensive Survey

论文链接:https://arxiv.org/abs/2509.19012

如果您也对VLA领域很感兴趣,欢迎加入我们自动驾驶之心&具身智能之心知识星球!内部会第一时间分享前沿技术领域的最新进展,我们准备了大额国庆节&中秋节优惠~

一、引言

机器人技术长期以来一直是科学研究的重要领域。在历史发展进程中,机器人主要依赖预编程指令和设计好的控制策略来完成任务分解与执行。这些方法通常应用于简单、重复性的任务,例如工厂装配线作业和物流分拣。近年来,人工智能技术的快速发展使研究人员能够利用深度学习在多种模态(包括图像、文本和点云)下的特征提取与轨迹预测能力。通过整合感知、检测、跟踪和定位等技术,研究人员将机器人任务分解为多个阶段,以满足执行需求,进而推动了具身智能与自动驾驶技术的发展。然而,目前大多数机器人仍以“孤立智能体”的形式运行——它们专为特定任务设计,缺乏与人类及外部环境的有效交互。

为解决这些局限性,研究人员开始探索整合大型语言模型(Large Language Models, LLMs)与视觉-语言模型(VLMs),以实现更精准、灵活的机器人操作。现代机器人操作方法通常采用视觉-语言生成范式(如自回归模型或扩散模型),并结合大规模数据集与先进的微调策略。我们将这类模型称为VLA基础模型,它们显著提升了机器人操作的质量。对生成内容的细粒度动作控制为用户提供了更高的灵活性,释放了VLA在任务执行中的实际应用潜力。

尽管VLA方法前景广阔,但针对纯VLA方法的综述仍较为匮乏。现有综述要么聚焦于VLMs基础模型的分类体系,要么对机器人操作技术进行整体的宽泛概述。首先,VLA方法是机器人领域的新兴方向,目前尚未形成公认的方法体系与分类标准,这使得系统总结这类方法面临挑战。其次,当前综述要么基于基础模型的差异对VLA方法进行分类,要么对机器人应用领域的整个发展历程进行全面分析,且往往侧重于传统方法,而对新兴技术关注不足。虽然这些综述提供了有价值的见解,但它们要么对机器人模型的探讨较为浅显,要么主要聚焦于基础模型,导致在纯VLA方法的研究文献中存在明显空白。

本文对VLA方法及相关资源进行了深入研究,针对现有方法提供了聚焦且全面的综述。我们的目标是提出清晰的分类体系、系统总结VLA研究成果,并阐明这一快速发展领域的演进轨迹。在简要概述LLMs与VLMs之后,本文重点关注VLA模型的策略设计,突出以往研究的独特贡献与显著特征。我们将VLA方法分为五类:自回归型、扩散型、强化学习型、混合型及专用方法,并详细分析了各类方法的设计动机、核心策略与实现机制(如图2所示,本文展示了这些方法的VLA框架结构)。

此外,本文还探讨了VLA的应用领域,包括机械臂、四足机器人、人形机器人和轮式机器人(自动驾驶车辆),全面评估了VLA在不同场景下的部署情况。考虑到VLA模型对数据集与仿真平台的高度依赖,本文还简要概述了这些关键资源。最后,基于当前VLA研究现状,本文指出了该领域面临的关键挑战,并勾勒了未来研究方向——包括数据局限性、推理速度与安全性等问题——以加速VLA模型与通用机器人技术的发展。

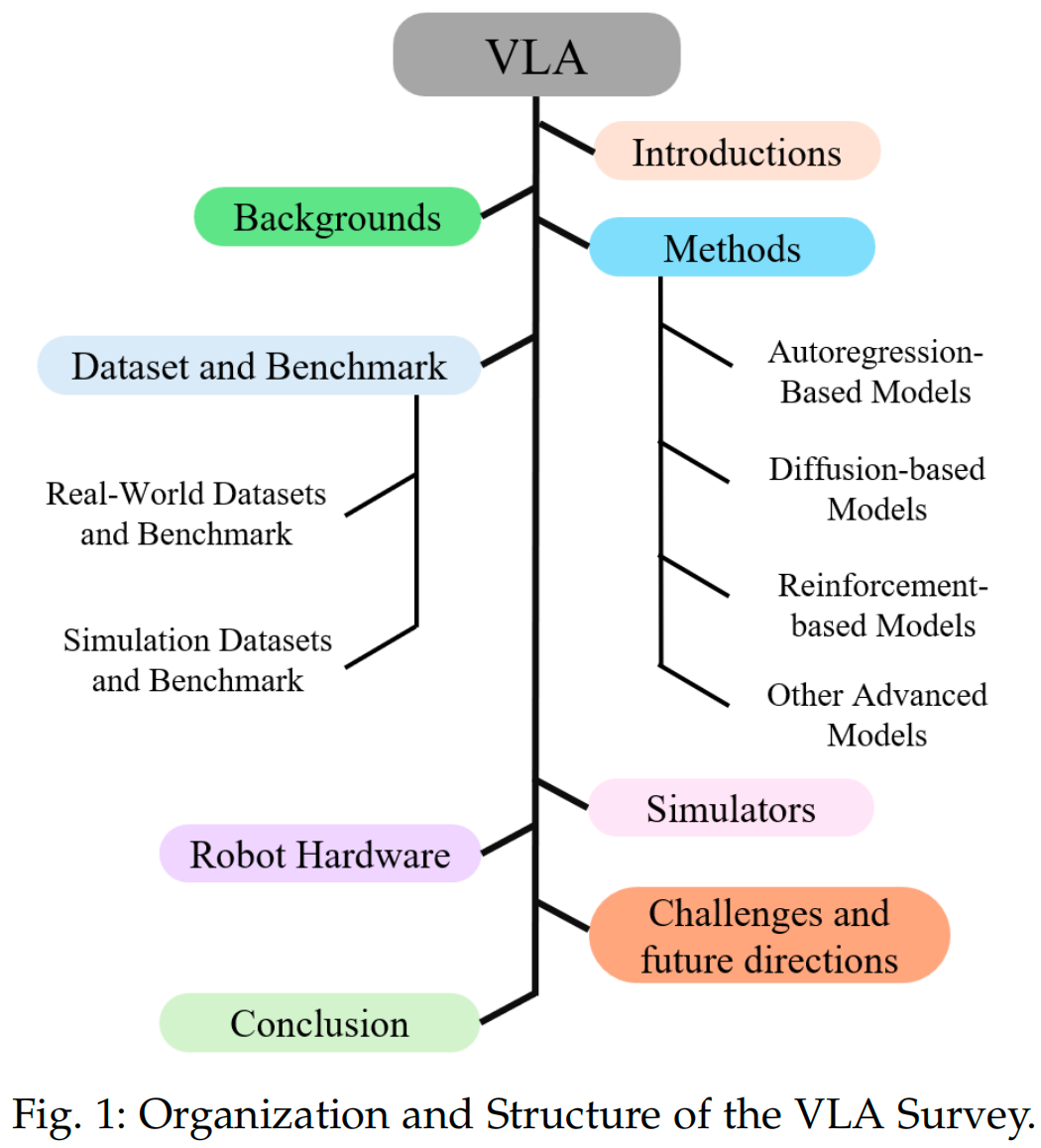

本综述的整体结构如图1所示:第2章概述VLA研究的背景知识;第3章介绍机器人领域现有的VLA方法;第4章阐述VLA方法所使用的数据集与基准测试集;第5章与第6章分别讨论仿真平台与机器人硬件;第7章进一步探讨基于VLA的机器人方法面临的挑战与未来方向;最后,对全文进行总结,并对未来发展提出展望。

综上,本文的主要贡献如下:

提出了结构清晰的纯VLA方法分类体系,根据其动作生成策略对方法进行分类。这一分类体系有助于理解现有方法,并突出该领域的核心挑战。

综述强调了每类方法与技术的显著特征及方法创新,为当前研究提供了清晰的视角。

全面概述了用于VLA模型训练与评估的相关资源(数据集、基准测试集与仿真平台)。

探讨了VLA在机器人领域的实际应用价值,指出了现有技术的关键局限性,并提出了潜在的进一步研究方向。

二、背景

视觉-语言-动作(VLA)模型的出现,标志着机器人技术从传统基于策略的控制向通用机器人技术迈出了重要一步,同时也将视觉-语言模型(VLMs)从被动的序列生成器转变为能够在复杂动态环境中进行操作和决策的主动智能体。本章将从单模态基础模型的发展、VLA模型的演进,以及通用具身智能的未来方向三个维度,梳理VLA研究的技术背景。

早期:LLM/VLM基础模型

单模态建模的突破为多模态融合奠定了方法学和工程基础。在不同模态领域,一系列里程碑式的模型为VLA的诞生积累了关键技术能力:

计算机视觉领域

计算机视觉领域的核心进展在于建立了从局部卷积到深度表征学习的范式,并通过注意力机制进一步提升了模型的迁移性和泛化能力:

卷积神经网络(CNNs):AlexNet首次证明了深度CNN在图像分类任务中的优越性,开启了深度视觉学习的时代;ResNet通过残差连接解决了深度网络训练中的梯度消失问题,进一步推动了网络深度的提升。

视觉Transformer(ViT):ViT将自注意力机制引入图像领域,将图像分割为固定大小的“图像块”(image patches)并将其视为序列输入,大幅提升了模型对全局信息的捕捉能力,为跨模态序列建模提供了重要参考。

自然语言处理领域

自然语言处理(NLP)领域的突破源于Transformer架构的提出,该架构支持大规模预训练和模态对齐技术,催生出具备强大推理、指令跟随和上下文学习能力的大型语言模型(LLMs):

代表性模型包括BERT(双向Transformer预训练模型,擅长理解任务)、GPT系列(生成式预训练Transformer,从GPT-1到GPT-4,逐步提升了长文本生成和复杂推理能力)、T5(文本到文本统一框架,支持多种NLP任务)。

这些模型通过海量文本数据的预训练,掌握了丰富的语义知识和语言逻辑,为后续融合视觉信息、生成动作指令奠定了语言理解基础。

强化学习领域

强化学习领域的进展聚焦于策略优化和序列决策能力的提升,从早期的深度Q网络(DQN)、近端策略优化(PPO),到后来的决策Transformer(Decision Transformer),形成了通过序列建模统一控制任务的新视角。决策Transformer将强化学习中的“状态-动作-奖励”序列视为文本序列进行建模,为VLA中“感知-语言-动作”的统一序列处理提供了思路。

视觉-语言模型

VLMs作为连接单模态学习与具身智能的关键桥梁,经历了从模态对齐到复杂跨模态理解的发展过程:

早期对齐模型:ViLBERT、VisualBERT通过双流或单流Transformer架构实现图像与文本的对齐和融合,初步解决了跨模态表征问题。

对比学习模型:CLIP(对比语言-图像预训练)通过大规模图像-文本对的对比学习,将两种模态映射到共享嵌入空间,支持零样本和少样本识别与检索,为VLA的“视觉-语言”基础对齐提供了核心技术。

指令微调模型:BLIP-2、Flamingo、LLaVA等模型通过指令微调,强化了开放域跨模态理解、细粒度接地(grounding)和多轮推理能力,能够更好地理解人类语言指令与视觉场景的关联,为VLA模型的“动作生成”环节奠定了跨模态理解基础。

现状:VLA模型的发展

从LLM/VLM到VLA模型的演进

随着LLM和VLM技术的成熟,研究自然地向“视觉-语言-动作”一体化方向推进。VLA模型将视觉感知、语言理解和可执行控制统一在单一序列建模框架中,其核心设计思路包括:

模态token化:将图像(如通过ViT编码为视觉token)、语言指令(如通过LLM编码为文本token)、机器人状态(如关节角度、传感器反馈)和动作(如控制指令)均转换为统一的token格式。

自回归动作生成:以视觉token、文本token和状态token为前缀或上下文,自回归生成动作token序列,最终解码为机器人可执行的控制指令,从而闭合“感知-语言-动作”循环。

与传统的“感知-规划-控制”分阶段流水线相比,VLA的优势在于:

端到端跨模态对齐,无需手动设计模态间的转换模块;

继承VLMs的语义泛化能力,能够理解模糊或开放域语言指令;

通过显式的状态耦合和动作生成,提升对环境干扰的鲁棒性和长任务执行能力。

这一演进路径——从单模态到多模态,再到“多模态+可执行控制”——为机器人“看见、理解并行动”提供了方法论基础。

数据与仿真的支撑作用

VLA模型在机器人领域的发展高度依赖高质量数据集和能够仿真真实场景复杂度的仿真平台,二者共同解决了深度学习驱动的机器人技术“数据稀缺”和“实机测试风险高”的核心问题:

(1)数据集:真实与通用的双重支撑

当前VLA模型多基于数据驱动,数据集的规模、多样性和标注质量直接决定模型性能:

真实世界数据集:采集过程需大量人力和资金投入,但能反映真实环境的复杂性。例如:

-

BridgeData涵盖10个环境中的71项任务,支持跨领域机器人技能迁移;

Open X-Embodiment(OXE)整合了21个机构的22个机器人数据集,包含527项技能和160266个任务,通过标准化数据格式促进VLA研究的可复现性。

互联网视频数据集:为解决真实机器人数据稀缺问题,研究人员利用互联网上的大规模人类操作视频(如日常家务、工业装配视频)作为通用数据,为VLA模型提供辅助监督,提升对“人类动作-语言指令”关联的理解。

数据集挑战:现有数据仍存在标注成本高、长尾场景(如罕见物体操作、突发环境变化)覆盖不足的问题,限制了VLA模型的泛化能力。

(2)仿真平台:安全与高效的测试环境

仿真平台通过生成大规模带标注数据、提供可控环境,成为VLA模型训练和评估的关键工具,其核心优势包括:

多样化环境与传感器配置:支持自定义场景(如家庭、工厂、户外)和传感器(RGB-D相机、IMU、触觉传感器),仿真真实机器人的感知条件;

物理真实性:通过精确的物理引擎(如MuJoCo的刚体动力学、Isaac Gym的GPU加速物理仿真)仿真物体碰撞、力反馈等物理交互,确保生成的“动作-效果”关联符合真实世界规律;

代表性平台:

-

THOR:提供接近照片级真实感的3D室内场景,支持导航和物体交互任务;

Habitat:专注于具身智能导航,支持大规模场景和多智能体交互;

MuJoCo/Isaac Gym:擅长机器人动力学仿真,适用于机械臂操作、四足机器人 locomotion 等任务;

CARLA:面向自动驾驶,提供真实城市交通场景和多传感器数据生成。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

124

124

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?