作者 | 我要吃鸡腿 来源 | 青稞AI

点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

本文只做学术分享,如有侵权,联系删文

作者:我要吃鸡腿

原文:https://zhuanlan.zhihu.com/p/1963658684765833212

引言:当 AI 睁开双眼,我们看到了一个怎样的未来?

曾几何时,我们对人工智能的印象还停留在那个聪慧但略显“盲目”的“数字大脑”上——它能写诗、能编程、能回答深奥的哲学问题,但这一切都局限于冰冷的文本世界。然而,就在最近两年,一场深刻的变革正在悄然发生。

您或许已经惊叹于 GPT-5 那般流畅自如的实时图片对话,它能“看到”您房间的布局并给出整理建议;又或者,您可能对 Qwen3-VL 直接“注视”着手机屏幕、精准地点击按钮、操作应用程序的能力感到不可思议。AI 不再仅仅是一个“只会读书”的语言模型,它正在进化成一个能听、会看、可交互的“智能体”,真正地睁开了双眼,开始感知和理解我们所处的这个五彩斑斓的物理世界。

这场从“符号”到“感知”的飞跃,背后究竟隐藏着怎样的技术密码?AI 是如何跨越数字与现实的鸿沟,实现从纯文本“思考”到图文视频并茂的“感知与交互”的?

答案,就蕴藏在多模态大模型 (Multimodal Large Models, MLLM) 的架构革命之中。而在 MLLM 这条充满创新与探索的赛道上,涌现出了两条截然不同但都极其成功的技术演进路线。本文将聚焦于这两条路线的杰出代表:以“大道至简”为核心逻辑的 LLaVA 系列,以及奉行“深度融合”设计思想的 Qwen3-VL。

在接下来的内容中,我们将一同踏上这场解构之旅。我们首先会搭建起 MLLM 通用的“三位一体”黄金架构蓝图,理解其运作的基础;随后,我们将深入一个所有 MLLM 都必须面对的核心矛盾——如何让模型在不牺牲效率的前提下,看得更“清晰”? 最终,我们将通过全景式地剖析 LLaVA 与 Qwen3-VL 的架构演进与核心技术,看它们如何分别给出了两条路径迥异却同样精彩的答案。

第一部分:蓝图与基石 —— MLLM 的“三位一体”黄金架构

在深入探讨 LLaVA 和 Qwen3-VL 的具体实现之前,我们必须先搭建一个稳固的认知框架。幸运的是,尽管实现细节千差万别,当前绝大多数主流的多模态大模型都遵循着一个共同的、优雅的“三位一体”黄金架构。我们可以将其生动地比喻为为 AI 打造一套完整的“感知-思考”系统:

• AI 的“眼睛” (视觉编码器): 负责最前端的感知。它的任务是将输入的像素世界——无论是静态图片还是动态视频,转化为机器能够理解的、蕴含丰富语义的数学表达(即特征向量)。

• AI 的“大脑” (大语言模型): 负责最后端的认知。它拥有强大的语言理解、逻辑推理和内容生成能力,是整个系统的“思考中枢”。

• 灵魂之桥 (连接器): 负责最关键的沟通。它像一位精湛的“翻译官”,将“眼睛”看到的视觉信息,精准地翻译成“大脑”能够听懂的“语言”,实现两大模态的无缝对接。

这三个部分协同工作,构成了一幅完整的 MLLM 架构蓝图。接下来,我们将逐一拆解这三大核心组件,首先从为 AI 提供视觉能力的那块革命性基石——Vision Transformer (ViT)开始。

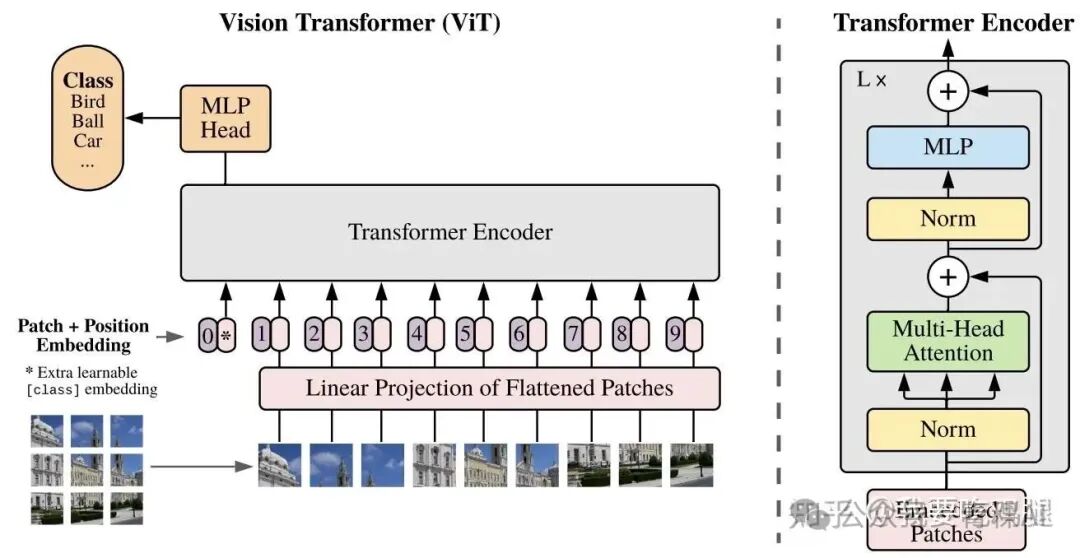

1.1 AI 的“眼睛”:Vision Transformer (ViT)

要让 AI 看懂世界,首先要解决一个根本问题:计算机眼中的图像本质上只是一个由像素值构成的巨大数字矩阵,而语言模型处理的则是离散的、一维的词元(Token)序列。如何跨越这两种数据形态的鸿沟?

2020 年,Google 提出的 Vision Transformer (ViT) 给出了一个颠覆性的答案。它摒弃了传统卷积神经网络 (CNN) 依赖局部卷积核的设计,开创性地将图像视为“序列化的文本”。ViT 的核心思想简单而强大:如果 Transformer 能够通过理解单词序列来读懂一篇文章,那它为什么不能通过理解图像块序列来“读懂”一张图片呢?

如上图所示,ViT 的工作流程可以清晰地分解为以下几个步骤:

第一步:图像分块 (Image Patching)

ViT 的第一步,是将连续的二维图像进行“离散化”。它会将输入的图像像切蛋糕一样,分割成一系列固定大小、不重叠的小方块,这些小方块被称为 “Patches”。这个过程是后续所有处理的基础。

举一个具体的例子:一张分辨率为 224x224 像素的彩色图像,如果被设定为使用 16x16 大小的图块进行分割,那么在水平和垂直方向上都将被切成 224 / 16 = 14 份。最终,这张完整的图像就被转换成了一个 14x14 的网格,总计 196 个图像块。至此,一张复杂的、连续的二维图片,就被巧妙地转换成了一个由 196 个元素组成的一维序列,完美适配了 Transformer 模型的输入要求。

第二步:展平与线性投影 (Flatten & Linear Projection)

得到了图像块序列后,下一步是将其转换为模型能够处理的数学表示——向量。

首先,每个二维的图像块(例如,一个 16x16 的彩色图块,其数据维度为 16x16x3,3 代表 RGB 通道)会被“压平”(Flatten),变成一个长长的一维向量。在这个例子中,向量的维度就是 16 * 16 * 3 = 768。

随后,这个原始的像素向量会通过一个标准的可学习线性投影层(本质上是一个全连接神经网络层),被映射到模型预设的、更具语义意义的隐藏维度(Embedding Dimension)中,例如 768 维。这个关键的过程被称为 Patch Embedding。它将每一个物理上的、具体的图像块,都转换成了一个数学上抽象的、蕴含了初步内容信息的“视觉词元”(Visual Token),其作用完全等同于自然语言处理中的“词嵌入”。

第三步:添加上下文信息 (Position & Class Embedding)

这是 ViT 能够真正“理解”图像空间布局的灵魂所在。标准的 Transformer 架构对序列顺序不敏感(“猫追老鼠”和“老鼠追猫”在它看来输入的内容向量是相同的)。为了让模型理解每个图像块在原始图片中的空间位置,我们必须为每个“视觉词元”注入位置信息。

此外,为了完成图像分类等需要全局信息的任务,ViT 还借鉴了 BERT 的思想,在序列的最前面加入一个额外的、可学习的 [class] Token。这个特殊的 Token 如同一个“信息汇聚器”,将在 Transformer 内部与所有图像块信息进行交互,最终其对应的输出向量将作为整张图像的“总结陈词”,送入分类头(MLP Head)进行预测。

对于位置信息,现代 ViT 架构(如 Qwen-VL 系列)广泛采用了精巧的旋转位置编码 (Rotary Position Embedding, RoPE)。

核心思想与工作原理:

RoPE 的思想极其巧妙,它不再是像传统方法那样给内容向量“加上”一个独立的位置向量。相反,它是在自注 意力机制内部,通过旋转的方式,将位置信息动态地融入到查询(Query)和键(Key)向量中。

我们可以这样直观理解:将每个“视觉词元”向量的高维空间,看作由许多个二维平面组成。RoPE 会根据这个词元(Patch)在图像中的绝对二维坐标 (h, w)(h 代表高度,w 代表宽度),计算出一组特定的旋转角度。

然后,在计算注意力分数之前,它会用这些角度,将 Query 向量和 Key 向量在那些二维平面上进行相应的旋转。这样做的神奇之处在于,当计算任意两个 Patch 之间的注意力分数时(本质上是计算它们旋转后的 Query 和 Key 的点积),点积的结果会自然而然地只与它们的相对位置有关,而与它们的绝对位置无关。

这使得 RoPE 具备了极强的尺寸泛化能力:无论输入图像被分割成多大的网格,模型都能通过旋转角度的差异,准确地捕捉到任意两个图像块之间的相对空间关系(例如“左上方”、“右侧相邻”)。

与 LLM 的核心区别:

虽然现代大语言模型(LLM)也普遍使用 RoPE,但 ViT 中的 2D-RoPE 与 LLM 中的 1D-RoPE 存在根本性的区别。LLM 处理的是一维的文本序列,只需编码单一的先后顺序;而 ViT 处理的是二维的图像网格,必须同时编码高度 h 和宽度 w 两个维度的信息。

因此,2D-RoPE 的实现会更为复杂,需要将特征向量的维度进行划分,分别用于编码两个空间轴的位置,甚至采用像 Qwen3-VL 的 MRoPE-Interleave 这样的先进交错技术,来更鲁棒地编码多维空间信息。

第四步:核心处理引擎 (Transformer Encoder)

经过上述所有准备工作,我们最终得到了一个既包含丰富内容信息,又蕴含了精确空间位置的“视觉词元”序列。这个序列将被送入一个由多个相同模块堆叠而成的标准 Transformer Encoder 中进行深度处理和全局信息融合。

每个 Encoder 模块内部主要包含两个核心子层:

• 多头自注意力机制 (Multi-Head Attention): 这是 ViT 的精髓所在。它赋予了序列中每一个图像块去“关注”所有其他图像块(包括自身)的能力,并根据内容和相对位置计算出彼此间的关联强度。通过这种全局的、无限制的“信息交互”,ViT 能够轻松捕捉到图像中跨越很远距离的依赖关系,例如,精准地将画面左上角孩童的视线,与右下角滚动的皮球联系起来。

• 前馈网络 (Feed-Forward Network): 在所有图像块完成一轮“集体讨论”(自注意力)后,每个位置的输出都会独立地经过一个简单的全连接前馈网络(通常是两层 MLP)。这个过程可以被看作是对融合了全局上下文信息后的每个图像块,进行一次独立的、深度的特征“提纯”和非线性变换。

通过这一系列步骤,ViT 成功地为 AI 装上了一双能够“阅读”图像的“眼睛”,将复杂的像素世界转换成了下游模型(如 LLM)可以进一步处理的、结构化的、蕴含了丰富语义和空间关系的特征序列。这正是后续所有精彩的多模态故事的开端。

1.2 AI 的“大脑”:大语言模型 (LLM) 的思考中枢

如果说 ViT 是 MLLM 的“眼睛”,负责感知世界,那么大语言模型 (LLM) 毫无疑问就是其负责认知、推理和表达的“大脑”。在整个“三位一体”的架构中,LLM 扮演着信息最终汇聚者和决策者的角色。它的核心任务,是将经过“连接器”翻译对齐后的多模态特征,与用户的文本指令深度融合,并通过强大的自回归生成能力,输出符合逻辑、切合情境的文本回复。

1.2.1 输入:一种融合后的“多模态现实”

LLM 所“看到”的输入,不再是单纯的文本序列。它接收的是一个经过精心构造的、一维的、融合了视觉与文本信息的长序列。在这个序列中,来自图像的“视觉词元”和来自文本的“语言词元”肩并肩地排列在一起,共同构成了 LLM 进行思考的完整上下文。

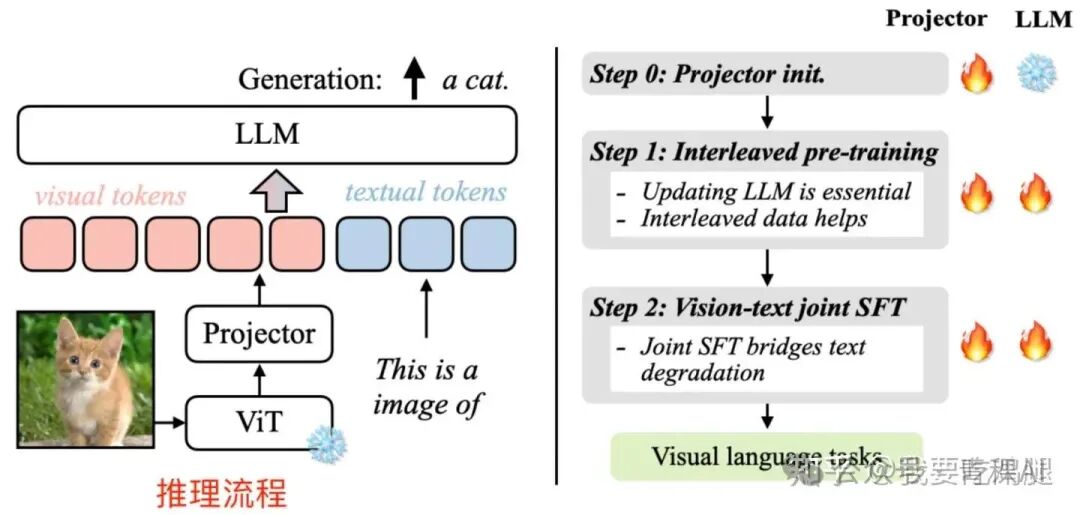

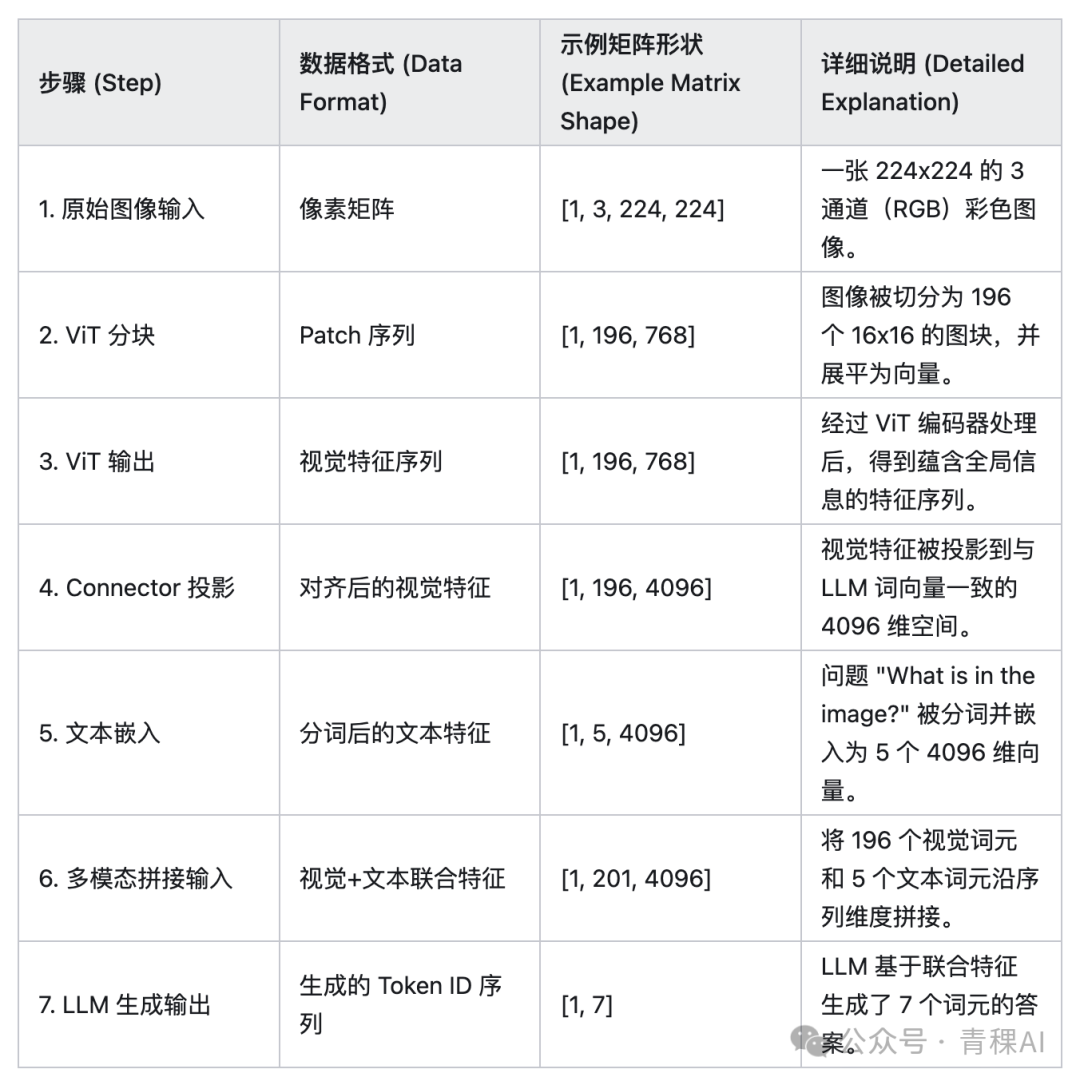

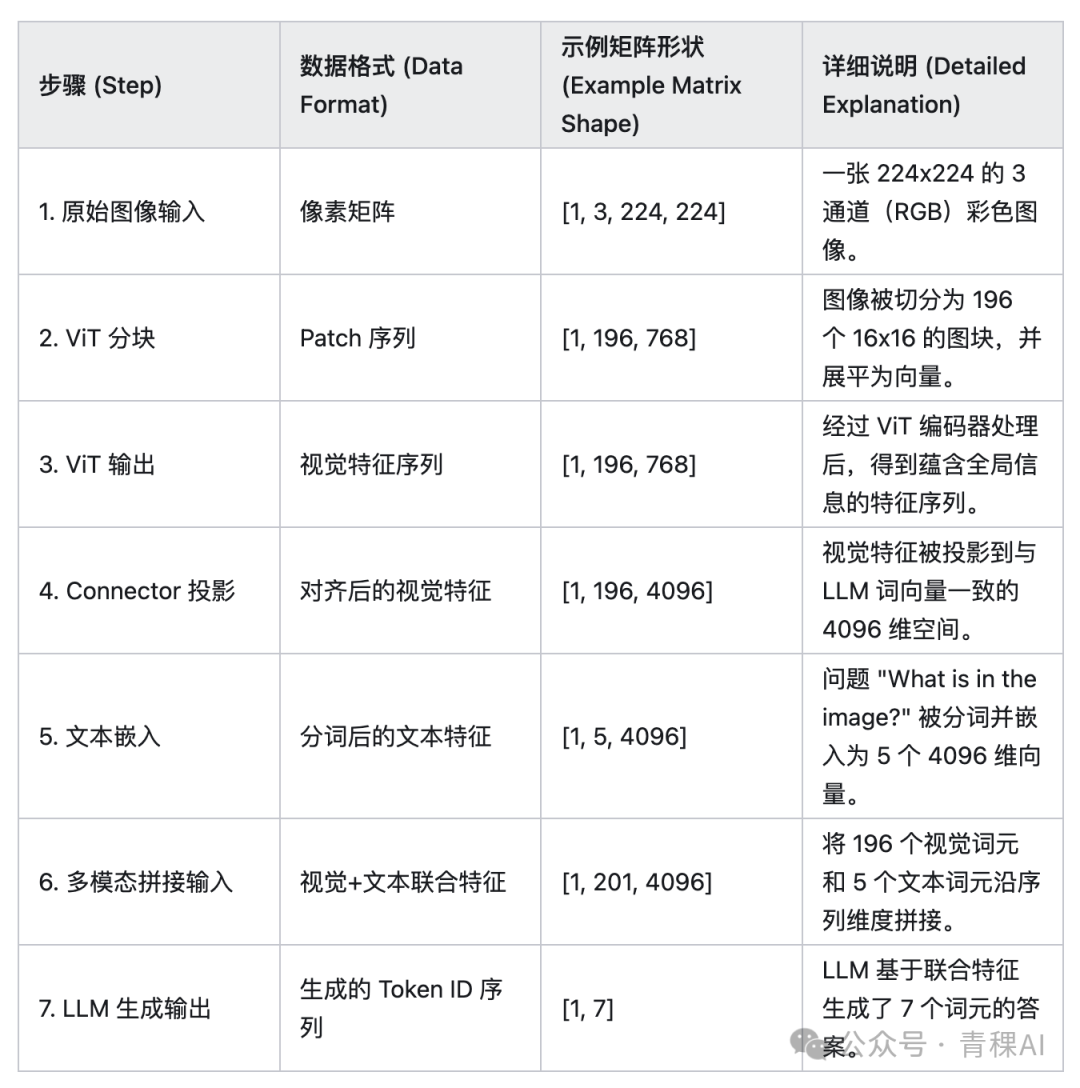

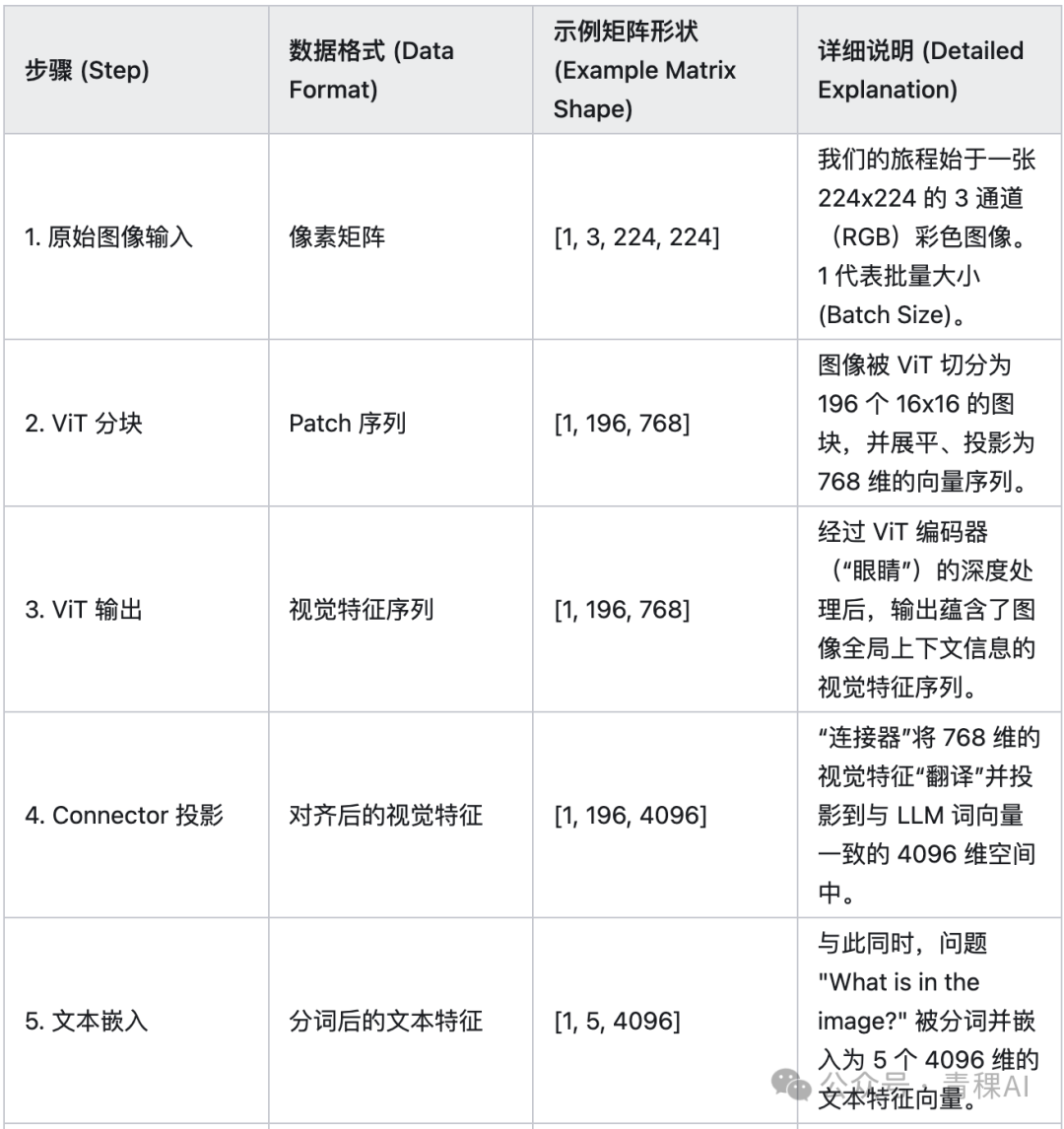

为了更清晰地理解这个从像素到融合输入的完整旅程,我们可以通过下面这个表格来分解每一步的数据形态和维度变换:

正如表格第 6 步所示,最终送入 LLM 的,是一个全新的、更长的序列。在这个例子中,序列的总长度变成了 196 + 5 = 201。这个序列的前 196 个位置,承载着图像的全部视觉信息;而紧随其后的 5 个位置,则明确了用户的意图和问题。LLM 的自注意力机制将在这个统一的序列上运作,使得文本词元可以“关注”到视觉词元,反之亦然,从而实现了真正意义上的图文理解。

例如,当用户输入一张图片并提问“What is in the image?”时,LLM 的最终输入会是 [视觉词元1, ..., 视觉词元196, "What", "is", "in", "the", "image", "?"] 这样拼接后的形态。

对于更先进的模型如 Qwen3-VL,这个输入序列的构造会更加复杂和动态。它不仅仅是图文的简单拼接,甚至可以是图、文、视频帧交错排列的复杂序列,其中还巧妙地插入了精确的时间戳文本(如 <0.8 seconds>),为 LLM 提供了前所未有的、理解动态世界的丰富信息。

1.2.2 核心机制:基于多模态上下文的自回归生成

拿到这个融合了丰富视觉信息的序列后,LLM 的核心工作机制——**自回归生成 (Autoregressive Generation)**便开始启动。这个过程与纯文本 LLM 的工作方式在本质上是相同的:模型会基于当前已有的全部上下文(现在包含了视觉信息),来预测下一个最有可能出现的词元 (Token)。

这个过程会像滚雪球一样持续进行:

1.模型根据 [视觉序列 + 问题序列] 预测出第一个答案词元,例如 "A"。

2.然后,将 "A" 追加到输入序列的末尾,形成新的、更长的上下文。

3.模型再根据 [视觉序列 + 问题序列 + "A"] 预测出第二个答案词元,例如 "cat"。

4.这个过程不断迭代,直到模型生成一个特殊的终止符(如 <EOS>)或达到预设的最大长度限制为止。

1.2.3 输出艺术:如何选择下一个词?—— 解码策略

虽然“预测下一个词”的原理很简单,但在每一步如何从成千上万个候选词元的概率分布中做出最终选择,却是一门艺术。不同的解码策略 (Decoding Strategy) 会直接影响生成结果的质量、速度和多样性,使其能够适应从精准问答到创意写作的各种任务。

根据上图,我们可以总结出三种主流的解码策略:

• 贪婪解码 (Greedy Decoding): 这是最简单直接的策略。在每一步,模型都会毫不犹豫地选择当前概率最高的那个 Token 作为输出。它的优点是速度极快,适用于对实时性要求很高的简单任务。但缺点是容易“鼠目寸光”,可能会因为眼前的最优选择而错失全局更优的答案,陷入局部最优。

• 束搜索 (Beam Search): 为了克服贪婪解码的短视问题,束搜索在每一步都会保留 k 个(k 称为束宽 'beam width')概率最高的候选序列。在下一步,模型会基于这 k 个序列分别进行扩展,然后从所有扩展出的新序列中再次选出总概率最高的 k 个。这种方法通过保留更多的可能性,在生成质量和计算成本之间取得了很好的平衡,因此广泛应用于视觉问答(VQA)、图像描述等大多数生成任务中。

• 采样 (Top-p): 与前两种确定性策略不同,采样策略引入了随机性。它不会总是选择概率最高的词,而是根据概率分布进行随机抽样,通常会限定在一个较小的、高质量的候选词集合内(例如 Top-p 采样)。这极大地增加了生成文本的多样性和创造性,使其非常适合需要“灵感迸发”的场景,如根据图片写故事、创作诗歌等。

1.2.4 架构演进:从“稠密”到“稀疏”——MoE 的崛起

值得注意的是,作为“大脑”的 LLM 自身也在不断进化。传统的 LLM 通常是“稠密”的,即在推理时需要激活模型的所有参数。而以 Qwen3-VL 为代表的新一代 MLLM,其语言模型部分已经开始采用更先进的混合专家 (Mixture of Experts, MoE) 架构。

Qwen3VLMoeForConditionalGeneration(

(model): Qwen3VLMoeModel( (visual): Qwen3VLMoeVisionModel( (patch_embed): Qwen3VLMoeVisionPatchEmbed( (proj): Conv3d(3, 1152, kernel_size=(2, 16, 16), stride=(2, 16, 16)) ) (pos_embed): Embedding(2304, 1152) (rotary_pos_emb): Qwen3VLMoeVisionRotaryEmbedding() (blocks): ModuleList( (0-26): 27 x Qwen3VLMoeVisionBlock( (norm1): LayerNorm((1152,), eps=1e-06, elementwise_affine=True) (norm2): LayerNorm((1152,), eps=1e-06, elementwise_affine=True) (attn): Qwen3VLMoeVisionAttention( (qkv): Linear(in_features=1152, out_features=3456, bias=True) (proj): Linear(in_features=1152, out_features=1152, bias=True) ) (mlp): Qwen3VLMoeVisionMLP( (linear_fc1): Linear(in_features=1152, out_features=4304, bias=True) (linear_fc2): Linear(in_features=4304, out_features=1152, bias=True) (act_fn): PytorchGELUTanh() ) ) ) (merger): Qwen3VLMoeVisionPatchMerger( (norm): LayerNorm((1152,), eps=1e-06, elementwise_affine=True) (linear_fc1): Linear(in_features=4608, out_features=4608, bias=True) (act_fn): GELU(approximate='none') (linear_fc2): Linear(in_features=4608, out_features=4096, bias=True) ) (deepstack_merger_list): ModuleList( (0-2): 3 x Qwen3VLMoeVisionPatchMerger( (norm): LayerNorm((4608,), eps=1e-06, elementwise_affine=True) (linear_fc1): Linear(in_features=4608, out_features=4608, bias=True) (act_fn): GELU(approximate='none') (linear_fc2): Linear(in_features=4608, out_features=4096, bias=True) ) ) ) (language_model): Qwen3VLMoeTextModel( (embed_tokens): Embedding(151936, 4096) (layers): ModuleList( (0-93): 94 x Qwen3VLMoeTextDecoderLayer( (self_attn): Qwen3VLMoeTextAttention( (q_proj): Linear(in_features=4096, out_features=8192, bias=False) (k_proj): Linear(in_features=4096, out_features=512, bias=False) (v_proj): Linear(in_features=4096, out_features=512, bias=False) (o_proj): Linear(in_features=8192, out_features=4096, bias=False) (q_norm): Qwen3VLMoeTextRMSNorm((128,), eps=1e-06) (k_norm): Qwen3VLMoeTextRMSNorm((128,), eps=1e-06) ) (mlp): Qwen3VLMoeTextSparseMoeBlock( (gate): Qwen3VLMoeTextRouter(in_features=4096, out_features=128, bias=False) (experts): Qwen3VLMoeTextExperts( (act_fn): SiLU() ) ) (input_layernorm): Qwen3VLMoeTextRMSNorm((4096,), eps=1e-06) (post_attention_layernorm): Qwen3VLMoeTextRMSNorm((4096,), eps=1e-06) ) ) (norm): Qwen3VLMoeTextRMSNorm((4096,), eps=1e-06) (rotary_emb): Qwen3VLMoeTextRotaryEmbedding() ) ) (lm_head): Linear(in_features=4096, out_features=151936, bias=False)

)在 MoE 架构中,模型内部包含多个“专家”子网络。对于每一个输入的词元,一个“门控网络”会智能地选择激活一小部分最相关的专家来进行计算,而其他专家则保持“沉默”。这种“稀疏激活”的策略,使得模型可以在大幅增加总参数量的同时,保持推理计算量不变,从而在性能和效率之间取得了更好的平衡。

综上所述,LLM 在多模态架构中扮演着不可或缺的“认知核心”。它不仅需要理解语言,更要学会在一个融合了视觉信息的全新语境中进行思考,并借助灵活的解码策略和先进的自身架构,生成精准、多样且富有创造力的回答。

1.3 灵魂之桥:“连接器” (Connector)

我们现在有了能够“看”的眼睛 (ViT) 和能够“想”的大脑 (LLM),但一个至关重要的问题摆在面前:它们二者之间如何沟通?ViT 输出的视觉特征向量,与 LLM 理解的文本嵌入向量,尽管都是高维向量,但它们处于完全不同的“语义空间”,好比一个说法语,一个说中文,无法直接交流。

为了解决这个“模态鸿沟”(Modality Gap),连接器 (Connector) 应运而生。它在整个架构中扮演着“灵魂之桥”或“同声传译官”的角色,其核心使命只有一个:将 ViT 输出的视觉特征,精准地投影 (Project) 或翻译 (Translate) 到 LLM 能够理解的同一个向量空间中,实现视觉与语言的无缝对齐。

如上图表格的第 3 步和第 4 步所示,连接器接收了 ViT 输出的 [1, 196, 768] 维特征,并将其转换为了 [1, 196, 4096] 维的“对齐后视觉特征”。这不仅仅是维度的改变,更是一次深刻的语义空间映射。

然而,“翻译”这门艺术本身也有着不同的流派和哲学。在 MLLM 的世界里,连接器的设计主要分为两大流派:

流派一:极简主义翻译官 —— 线性投影层 (Linear Projection)

这是目前最主流,也是以 LLaVA 系列为代表的经典实现方式。它奉行“大道至简”的哲学,认为只要“大脑” (LLM) 足够强大,那么“翻译官”的工作就可以尽可能地简单直接。

工作原理:

这种连接器在结构上通常是一个非常简单的多层感知机 (MLP),甚至可以只是一个单层的全连接网络。它的核心任务就是进行一次线性的维度变换,将输入的视觉特征向量(如 768 维)映射到 LLM 的隐藏空间维度(如 4096 维)。

这种方法并不试图对视觉信息进行复杂的预处理或提炼,而是相信在海量的图文数据对的训练下,这个简单的线性层足以学习到两个模态空间之间的映射关系。它将大部分的理解和融合压力都交给了后续更为强大的 LLM。LLaVA 的巨大成功证明了,在正确的训练策略下,这种极简设计的有效性。

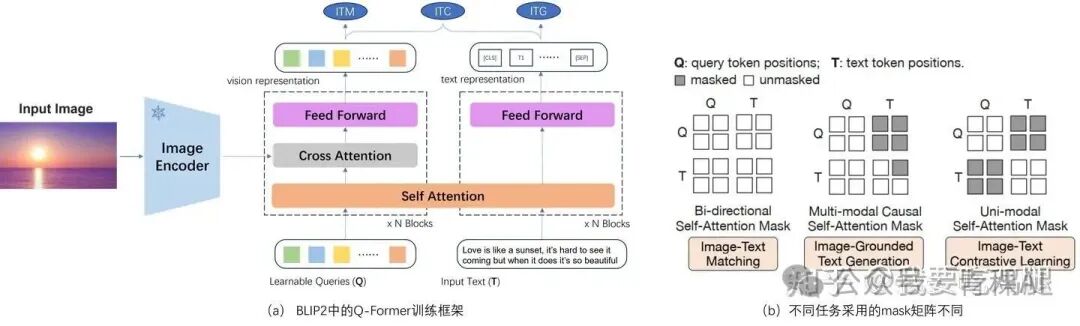

流派二:主动型信息提炼师 —— Q-Former

与 LLaVA 的极简主义形成鲜明对比的是以 BLIP-2 模型为代表的精巧设计——Q-Former。它认为,“翻译官”不应该只是一个被动的“传声筒”,而应该是一个能够主动思考、提炼关键信息的“专家”。

首先,我们必须明确 Q-Former 要解决的核心问题。

• ViT (眼睛) 在看完一张图片后,会输出一个非常长的特征序列。例如,一张 224x224 的图片会被转换成 196 个“视觉词元”。

• 这 196 个词元是“未经加工的原始素材”。它们包含了图像中的一切——重要的物体(比如一只猫)、物体的细节(猫的胡须)、次要的背景(一片草地),以及大量冗余和无用的信息(比如 100 个几乎一模一样的草地块)。

• LLaVA 的方案 (流派一):把这 196 个词元全部“翻译”一下,然后原封不动地丢给“大脑”(LLM)。这极大地增加了 LLM 的计算负担。LLM 就像一个 CEO,现在却被迫阅读一份 196 页的、未经筛选的原始数据报告。

Q-Former (Querying Transformer) 的设计理念是:不应该让 CEO (LLM) 去读原始报告,我们应该先成立一个“专家分析团队”,由他们去阅读那 196 页的原始报告,然后提炼出一份 32 页的、信息高度浓缩的“执行摘要”。

这个“专家分析团队”就是 Q-Former。

核心机制 (一):Learnable Queries(可学习的查询向量)

Q-Former 是如何“提炼”的呢?它靠的就是 Learnable Queries(可学习的查询向量)。

•

Learnable Queries是一组数量固定的向量(例如,BLIP-2 中使用了 32 个),在模型训练开始之前,它们不包含任何信息,只是一堆随机初始化的数字。您可以把它们想象成 32 个空白的“问题卡片”或“待填表格”。• 在海量的图文数据训练中,模型会反向传播更新这些查询向量。渐渐地,这 32 个“空白卡片”学会了各自的“职责分工”,训练完成后,这 32 个查询向量就变成了 32 个“专家分析师”:

• Query 1 (专家1) 学会了专门去寻找“主要物体”。

• Query 2 (专家2) 学会了专门去寻找“背景和场景”。

• Query 3 (专家3) 学会了专门去寻找“图像中的文字 (OCR)”。

• Query 4 (专家4) 学会了专门去寻找“物体的颜色和纹理”。

• … 以此类推。

• 这种“职责”不是我们人为设定的,而是模型在训练中为了最好地完成下游任务(如看图说话、视觉问答)而自发学习和演化出来的最高效的分工方式。

核心机制 (二):Cross Attention(交叉注意力)

现在,我们有了 196 页的原始报告(ViT 输出的视觉特征)和 32 位“专家分析师”(Learnable Queries)。他们如何开会呢?答案是交叉注意力 (Cross Attention)。

如上图 (a) 所示,这个机制是这样工作的:

1.提问 (Query): 32 位“专家”(Learnable Queries)作为 Q (Query),进入会议室。

2.报告 (Key/Value): 196 页“原始报告”(ViT 输出的视觉特征)作为 K (Key) 和 V (Value),被摊在桌面上。

3.开会过程 (Cross-Attention):

• 专家 1(负责找主要物体) 会站起来,“审视”所有的 196 个视觉词元,并大声提问:“你们谁是‘主要物体’?”

• 那 196 个视觉词元会根据自己的内容给出回应(计算注意力分数)。那些代表“猫”的词元会说:“我们是!我们是!”(高分);那些代表“草地”的词元会说:“我们不是。”(低分)。

• 专家 1 于是将所有“高分回应”(即“猫”的特征)收集起来,通过加权平均的方式,填满了自己那张空白的“问题卡片”。

• 专家 1 的最终输出向量,现在就变成了一个高度浓缩了“猫”的信息的向量。

4.生成摘要: 32 位专家各自重复上述过程,各自从 196 页原始报告中提取自己“负责”的那部分信息。

5.最终输出: 会议结束。Q-Former 输出的不再是 196 个原始词元,而是这 32 个已经被填满信息的、高度浓缩的“摘要向量”。

Q-Former 的真正优势

• 信息过滤与压缩: 它将 196 个冗余、嘈杂的原始特征,压缩成了 32 个信息密度极高、与下游任务高度相关的精华特征。

• 减轻 LLM 负担: LLM(CEO)现在只需要阅读这份 32 页的“执行摘要”。这极大地降低了计算量,使得模型可以更专注于高级的逻辑推理,而不是在 196 页的原始数据中“大海捞针”。

• 灵活性: 如图中的 (b) 部分所示,Q-Former 还可以通过不同的注意力掩码(Mask)灵活地执行多种任务(如图像-文本匹配、文本生成等), versatility 极强。

希望这个 “32位专家分析师(Queries)去审阅 196 页原始报告(ViT output),并通过开会(Cross-Attention)生成一份 32 页执行摘要(Q-Former output)”的比喻,能帮助您彻底理解 Q-Former 的工作原理。

综上所述,连接器的设计选择,深刻地反映了模型背后的设计哲学。是以 LLaVA 为代表的极简派,相信“少即是多”,依赖强大的 LLM 和海量数据完成融合;还是以 BLIP-2 为代表的精巧派,相信专业的“分工协作”,在视觉信息进入 LLM 之前就进行深度提炼。这两种思路的碰撞与演进,也正是我们将在下一部分探讨的核心主题。

1.4 从像素到文字的维度变换

至此,我们已经分别认识了 MLLM 的“眼睛” (ViT)、“大脑” (LLM) 和连接它们的“灵魂之桥” (Connector)。现在,让我们将这些独立的部件组装起来,跟随一个具体的例子,完整地走一遍数据从输入到输出的全过程。这将帮助我们直观地理解,一张普通的图片和一句简单的问题,是如何在模型内部被一步步解析、融合、思考,并最终生成一句流畅回答的。

这个旅程的本质,是一场精彩的数据形态与矩阵维度变换之旅。我们可以通过下面这张精心梳理的表格,来追踪其每一步的变化。

让我们来详细解读这个过程中的关键转变:

从空间到序列 (步骤 1 -> 2): 最根本的转变发生在这里。ViT 将一个二维的、连续的像素空间,成功地转换成了一个一维的、离散的“视觉词元”序列。这是后续所有处理的基础。

语义空间的对齐 (步骤 3 -> 4): 这是“连接器”发挥核心作用的时刻。它接收来自 ViT 的、处于“视觉语义空间”的特征,并通过一次精妙的数学投影,将其转换到了 LLM 所处的“语言语义空间”中。尽管我们看到的只是特征维度从 768 变成了 4096,但这背后是一次深刻的跨模态“翻译”。

多模态现实的构建 (步骤 4, 5 -> 6): 这是整个架构中最激动人心的时刻。两个原本独立的模态——视觉和语言在此刻被物理地拼接在一起,形成了一个全新的、统一的输入序列。对于 LLM 来说,从这一刻起,它的世界里不再有图像和文本之分,只有一个包含了丰富信息的、长达 201 个词元的“多模态现实”。LLM 的自注意力机制将在这个统一的序列上运作,使得文本词元可以“关注”到视觉词元,反之亦然,从而实现了真正意义上的图文深度理解。

从理解到生成 (步骤 6 -> 7): 最后,LLM 基于这个前所未有的丰富上下文,发挥其强大的生成能力,将它的“所见所想”以自然语言的形式表达出来,完成了一次从感知到认知的完整闭环。

至此,我们已经为后续的深入探讨打下了坚实的基础。我们不仅理解了 MLLM 的三大核心组件,更通过追踪一次完整的数据之旅,直观地感受到了它们是如何协同工作,将冰冷的像素矩阵一步步转化为有意义的文字回答。

第二部分:两条路线 —— 如何看得更“清晰”?

第一部分中搭建的“三位一体”黄金架构,为 MLLM 看懂世界提供了基础蓝图。然而,这个基础蓝图很快就面临一个严峻的现实挑战:真实世界的视觉信息远比 224x224 的标准测试图要复杂得多。

想象一下,我们要让 AI 阅读一份布满小字号文字的 PDF 文档、分析一张高清的城市航拍图,或者理解一张超长的网页截图。如果简单粗暴地沿用 ViT 的分块逻辑,将这些高分辨率图像直接切分成海量的 16x16 图块,那么生成的“视觉词元”序列长度将从几百激增到数千甚至上万。对于 LLM 内部计算复杂度呈平方级增长的自注意力机制而言,如此长的序列无异于一场计算和显存的噩梦,这在现实应用中是完全不可行的。

那么,如何在不牺牲效率的前提下,让模型拥有处理高分辨率信息、捕捉微小细节的“鹰眼”能力呢?面对这个核心矛盾,业界探索出了两条截然不同但都极其成功的技术演进路线。本章,我们将深入解构这两种设计哲学。

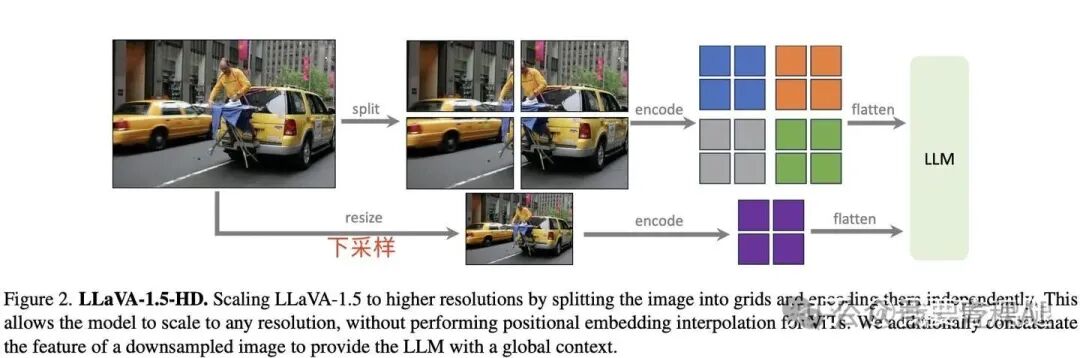

2.1 路线一:LLaVA 的 AnyRes

第一条路线的杰出代表是 LLaVA 系列。它所奉行的核心哲学可以概括为:“保持模型核心的极简性,通过在输入端进行巧妙的工程设计,来‘欺骗’模型,使其能消化远超其原始训练分辨率的信息。”。

LLaVA 的开发者们没有选择去重构模型内部复杂的融合机制,而是将智慧聚焦于数据预处理阶段,提出了一套名为 AnyRes (Any Resolution) 的解决方案。顾名思义,它的目标就是让模型能够处理“任意分辨率”的图像。

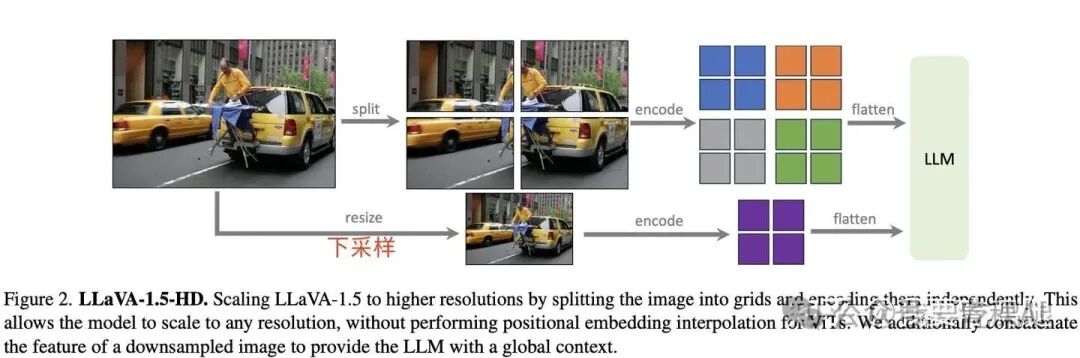

LLaVA-1.5-HD:“全局+局部”的巧妙协同

AnyRes 的思想在 LLaVA-1.5-HD 版本中得到了经典的体现。其策略的核心是“两手抓,两手都要硬”,同时兼顾图像的全局上下文和局部细节。

如上图所示,当 LLaVA-1.5-HD 接收到一张高分辨率图像时,它会兵分两路进行处理:

1.“局部细节”处理路径 (上路):

模型首先将原始的高清大图(High Resolution Image)分割 (split) 成多个较小的、但依然保持高清晰度的图块。这些图块的尺寸通常与视觉编码器(如 CLIP-ViT)原始训练时能够处理的最大分辨率(例如 336x336)相匹配。

然后,视觉编码器会独立地 (independently) 对这些高清图块进行编码 (encode)。由于每个图块都保持了足够的分辨率,图像中的微小文字、物体细节等关键信息得以被完整地保留下来。

2. “全局上下文”处理路径 (下路):

与此同时,模型会将原始的高清大图进行一次降采样 (resize / downsample),将其缩放到一个标准尺寸,形成一张低分辨率的全局概览图。

这张全局图随后也被送入视觉编码器进行编码 (encode)。虽然这个过程会损失大量细节,但它为模型提供了关于整张图片“讲的是什么”的宝贵全局上下文 (global context)。

3. 最终融合:

最后,来自“局部细节”路径的所有高清图块特征,与来自“全局上下文”路径的单一全局特征,会被拼接(concatenate) 在一起,形成一个更长的视觉序列,共同送入 LLM。

通过这种巧妙的协同,LLM 最终得到的输入,既包含了来自各个局部的高保真细节,又具备了对整张图片布局和主题的宏观理解,从而实现了对高分辨率图像的精准解析。

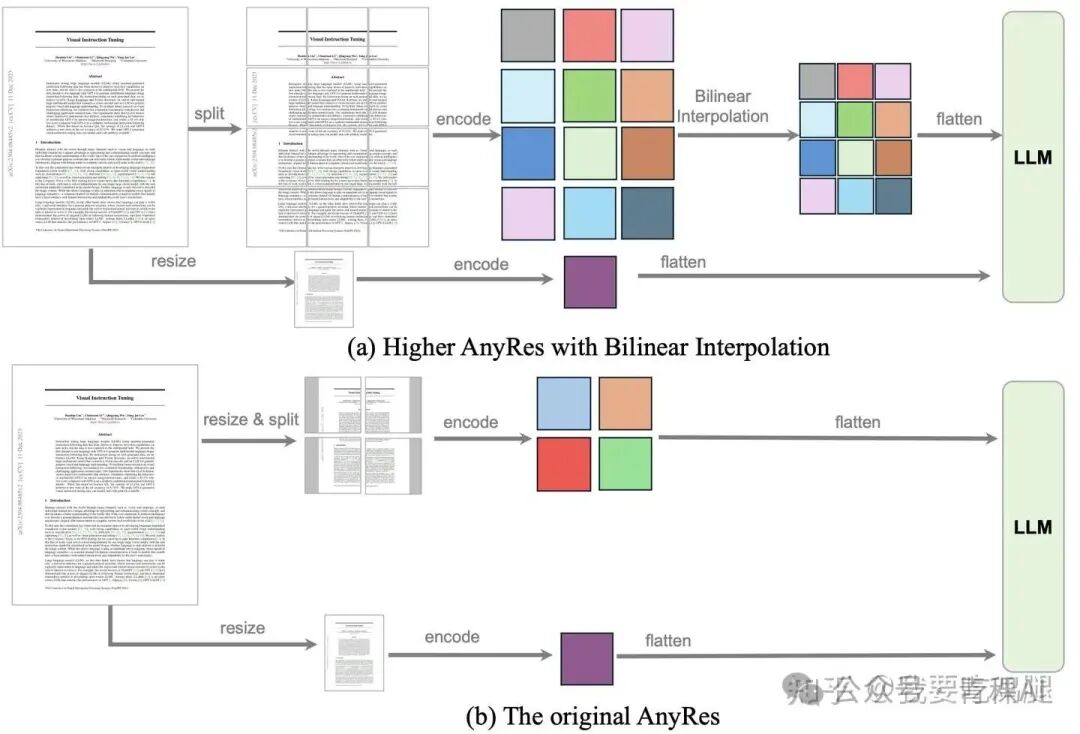

LLaVA-OneVision 的进阶:为文档而生的高级 AnyRes

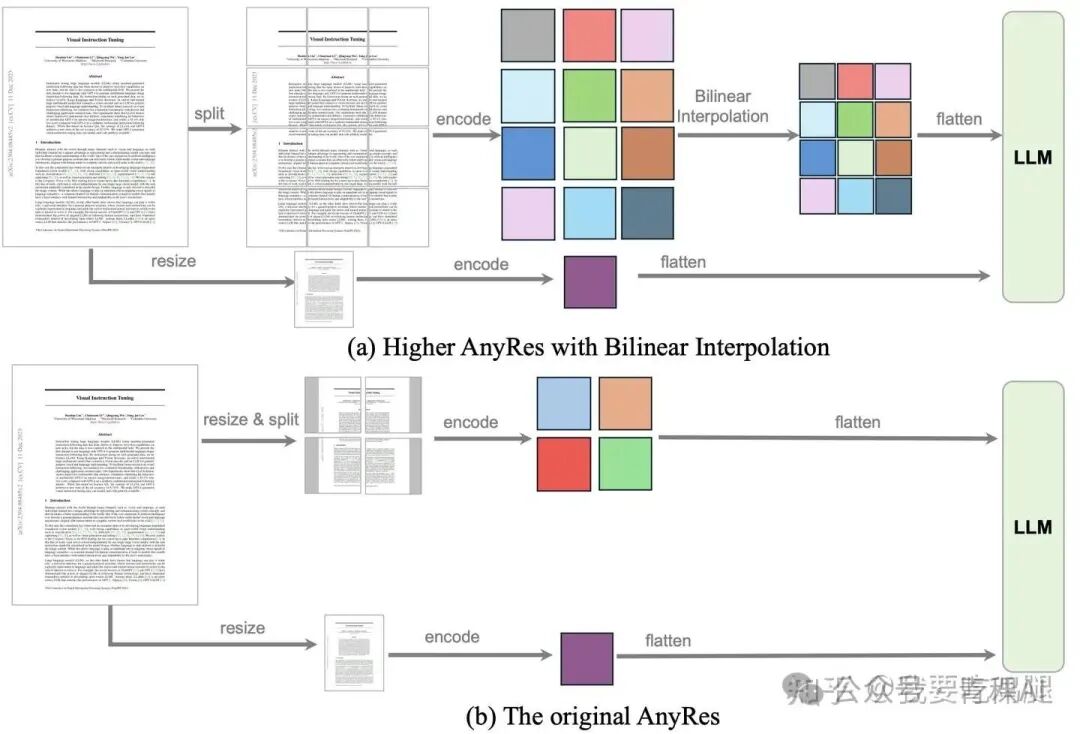

随着任务的复杂化,尤其是在处理 PDF 文档、学术论文这类信息密度极高的场景时,简单的特征拼接已经不足以完美地保留图块之间的空间关系。为此,LLaVA-OneVision 提出了更先进的 Higher AnyRes 策略。

对比上图中的 (a) 和 (b) 两种方案,我们可以清晰地看到其核心区别:

• 原始 AnyRes (The original AnyRes): 如图 (b) 所示,它在编码各个图块后,直接将得到的特征向量展平 (flatten) 并拼接。这种方式虽然简单,但可能会丢失图块之间精细的二维布局信息。

• 高级 AnyRes (Higher AnyRes with Bilinear Interpolation): 如图 (a) 所示,它在编码完各个高清图块后,增加了一个关键步骤——双线性插值 (Bilinear Interpolation)。它不再是将特征向量粗暴地拼接,而是尝试在特征空间中,通过插值的方式将这些离散的特征图块“缝合”起来,重新构建一个更高分辨率的特征图 (Feature Map)。然后再将这个融合了空间信息的完整特征图展平送入 LLM。这种方式能更好地保留文档的布局、表格的结构等至关重要的空间关系,极大地提升了模型在文档视觉问答 (DocVQA) 等任务上的表现。

小结一下,LLaVA 系列的演进之路,充分展现了其“扩展输入边界”的设计哲学。它通过不断迭代 AnyRes 这一核心前端技术,在不改动模型核心架构的前提下,聪明地解决了高分辨率视觉信息的处理难题,证明了优秀的工程设计与数据处理策略,同样是推动模型能力飞跃的关键力量。

2.2 路线二:Qwen3-VL 的 DeepStack

与 LLaVA 系列在“输入边界”上做文章的哲学不同,另一条演进路线则将目光投向了模型内部,提出了一种更为激进和深刻的解决方案。这条路线的集大成者,便是以 Qwen3-VL 为代表的、采用 DeepStack 技术的模型。

其核心哲学可以概括为:“与其在入口处一次性‘喂’给模型所有信息,不如对模型的核心架构进行改造,构建一条多层次的‘视觉-语言信息高速公路’,在模型思考的不同阶段,动态地、深度地注入视觉信息。”。

2.2.1 DeepStack 技术:一种全新的融合范式

DeepStack 技术的提出,旨在解决传统方法为了提供细粒度视觉信息而不得不牺牲计算和显存开销的根本性难题。它另辟蹊径,不再纠结于输入序列的长度,而是通过将视觉词元深度堆叠 (deeply stacking) 或注入 (infusing) 到模型内部的不同层级,实现了一种高效的深度融合。

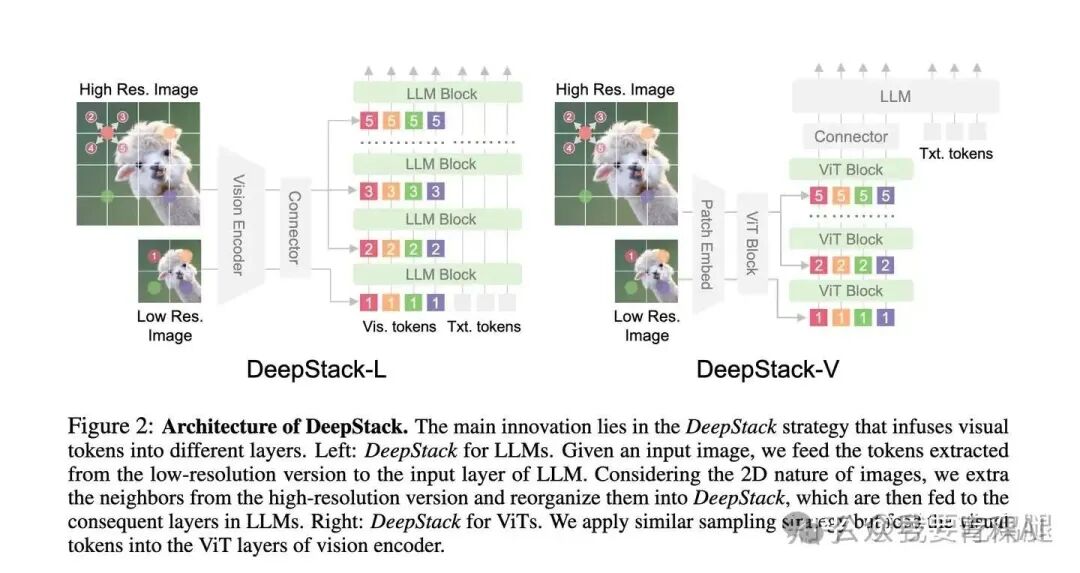

如上图所示,DeepStack 的原始论文提出了两种核心实现模式:

• DeepStack-L (for LLMs): 这是将视觉信息注入到语言模型中的版本。它的工作流程是:首先,低分辨率图像的特征作为初始视觉输入,与文本词元一起送入 LLM 的第一层。随后,从高分辨率图像中提取的、更精细的视觉特征,被逐层添加到 LLM 的后续层(如图中的 LLM Block 2, 3, 5)的隐藏状态中。

• DeepStack-V (for ViTs): 这是将视觉信息注入到视觉编码器(ViT)自身的版本。整个注入过程都发生在 ViT 内部,旨在视觉编码阶段就构建一个多尺度的层次化视觉表征。

Qwen3-VL 采用的正是 DeepStack-L 的核心思想,即将视觉信息深度注入到 LLM 的处理流程中。

2.2.2 设计背后的科学依据:为何是 LLM 的“浅层”?

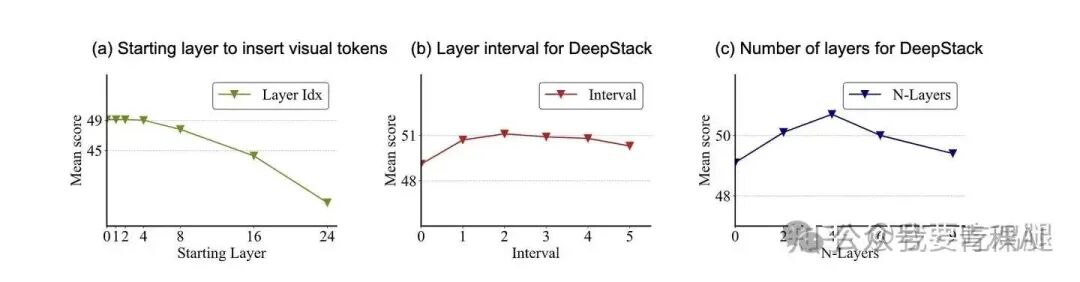

DeepStack 的设计并非空穴来风,其背后有坚实的实验数据作为支撑。

上图中的消融实验结果,清晰地回答了关于注入策略的三个关键问题:

1.(a) 应该从哪一层开始注入? 实验表明,注入视觉词元的起始层越靠前(越浅),模型得分越高。当从第 0~4 层开始注入时性能最佳,而当起始层推迟到 16 层以后,性能会急剧下降。这有力地证明了,LLM 的浅层更适合处理和融合相对原始的视觉特征,而深层则更专注于基于已融合信息的抽象推理。

2.(b) 注入的间隔应该是多少? 性能在注入间隔为 2 或 3 层时达到峰值。这说明并非注入得越密集越好,需要给模型留出一定的层数来消化和处理上一轮融合后的信息。

3.(c) 总共注入多少层比较好? 实验显示,注入约 4 个层时效果最优。注入层数过少或过多都会损害性能。

这些结论为 DeepStack 的高效实现提供了清晰的“配方”,也解释了为什么 Qwen3-VL 会选择将视觉特征注入到 LLM 的前几个层中。

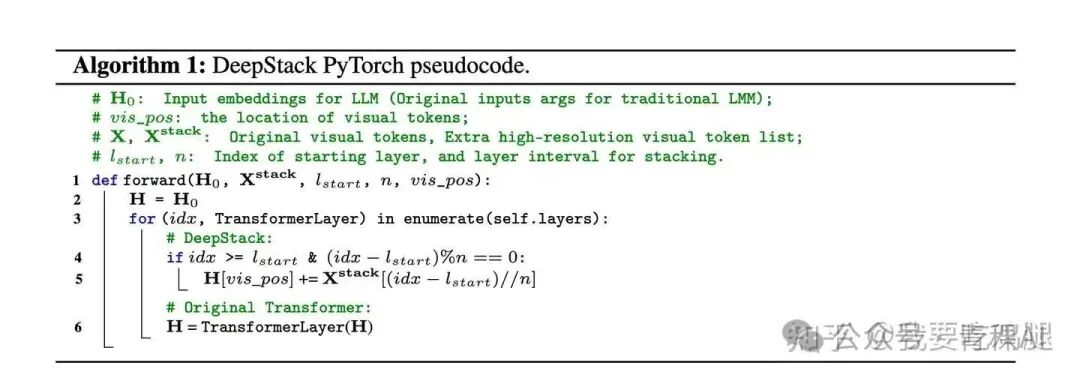

2.2.3 实现的优雅:一次简单的“原地相加”

尽管 DeepStack 的思想听起来很复杂,但其实现却异常简洁和高效。

其伪代码显示,核心逻辑仅仅是在 Transformer 层的循环中,增加一个简单的条件判断和一次原地加法 (in-place addition)。具体来说,就是找到当前层隐藏状态中属于视觉词元的部分,然后直接将待注入的额外视觉特征加到它们上面。这与 Qwen3-VL 源码中 _deepstack_process 函数的实现逻辑完全一致,计算开销极小。

2.2.4 Qwen3-VL 的独特适配与优化

值得注意的是,Qwen3-VL 并没有完全照搬原始论文的设计,而是进行了一次聪明的“本地化”适配。

原始 DeepStack-L 需要额外处理一张高分辨率图像来获取用于注入的精细特征。而 Qwen3-VL 则更为高效,它直接从处理标准输入图像的同一个 Vision Tower 的指定中间层(例如第 8, 16, 24 层)提取特征,作为注入到 LLM 浅层的“额外视觉信息”。这样做的好处是,无需增加一次额外的高分辨率图像编码过程,显著减少了计算量,同时依然能为 LLM 提供来自不同抽象层级的视觉信息。

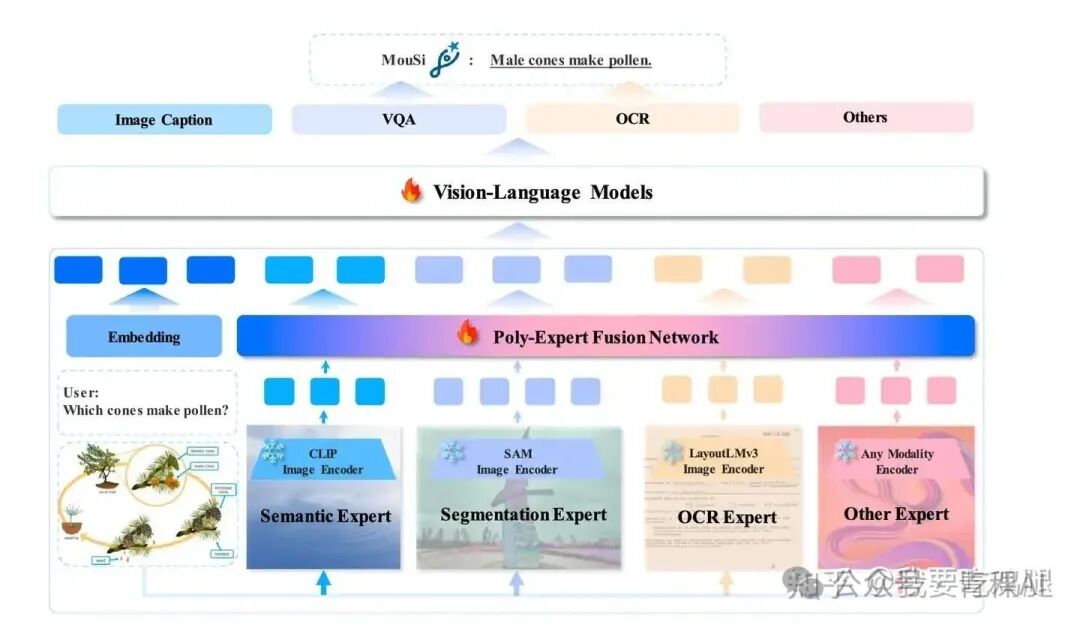

为了更好地理解 DeepStack 的独特性,我们可以将其与 MouSi 模型所代表的“多专家广度融合”路线进行对比。MouSi 采用多个并行的、专门的视觉编码器(如 CLIP, SAM)作为“专家”,分别提取不同维度的信息,然后通过一个复杂的“多专家融合网络”进行整合。如果说 MouSi 是在“广度”上做文章,那么 DeepStack 就是在“深度”上求突破,两条路线各有千秋。

小结一下,以 Qwen3-VL 的 DeepStack 为代表的第二条演进路线,通过对模型内部架构进行精巧的、有理论依据的改造,实现了一种高效、深度的多层次融合范式。它代表了 MLLM 从简单的“输入端拼接”向复杂的“处理中融合”演进的重要一步,是架构设计驱动模型能力跃迁的典范。

第三部分:两大系列模型架构全景剖析

在清晰地理解了 MLLM 的基础蓝图,并深入探讨了“如何看得更清晰”这一核心矛盾的两条主要解决路线之后,我们现在已经拥有了所有必要的工具,可以开始对这两条路线的杰出代表——LLaVA 与 Qwen3-VL进行一次全景式的架构剖析。

这将是一场精彩的“巅峰对决”。通过深入它们的内部,我们将看到两种截然不同的设计哲学是如何在实践中被贯彻、演进,并最终都取得了巨大的成功。首先,让我们从那位“大道至简”的忠实践行者——LLaVA 系列开始。

3.1 LLaVA 系列:大道至简的忠实践行者

LLaVA (Large Language and Vision Assistant) 系列的整个发展史,都是对其核心哲学——“简洁即正确 (Simplicity is Correct)”的一次完美诠释。它的出现,开创性地证明了我们并不总是需要极其复杂的融合模块来实现强大的多模态能力;相反,一个极简的架构,在海量数据和聪明工程的驱动下,同样可以迸发出惊人的力量。

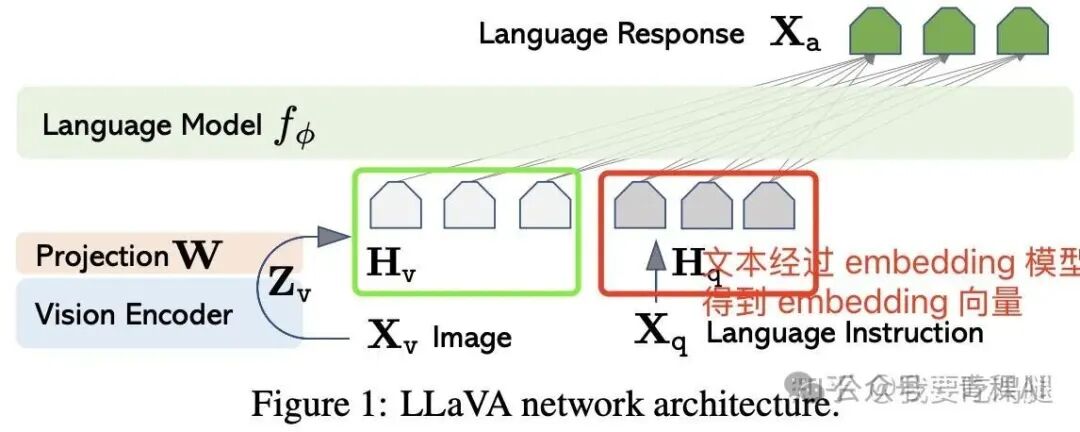

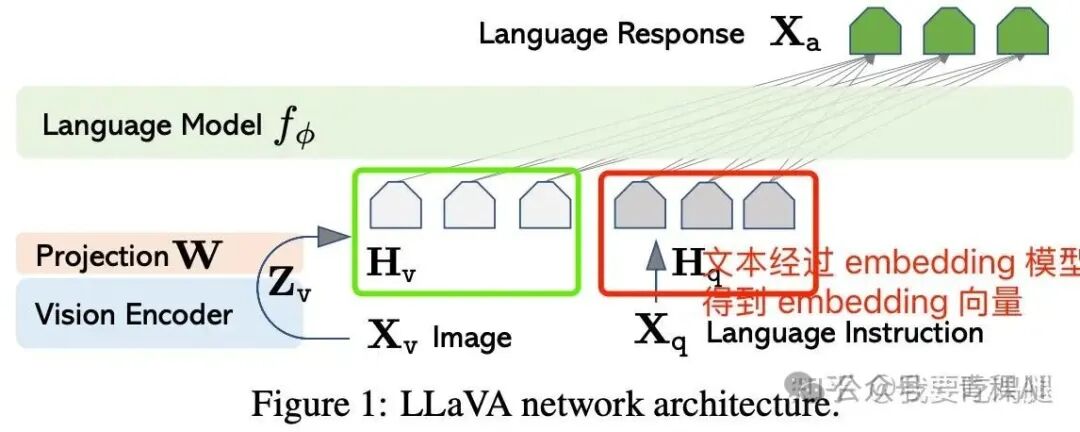

3.3.1 奠定基调的开创性架构 (LLaVA 1.0)

LLaVA 的第一个版本,就以其惊人的简洁性为整个系列奠定了基调。

如上图所示,其初代架构可以用一个非常清晰的公式来概括:

• 眼睛 (Vision Encoder): 采用当时业界领先的、预训练好的 CLIP ViT-L 模型来提取图像特征。

• 大脑 (Language Model): 基于强大的开源语言模型 LLaMA/Vicuna。

• 灵魂之桥 (Connector): 这是一个极致简洁的单层线性投影层 (Projection W)。

它的核心创新就在于这个连接器:LLaVA 勇敢地抛弃了所有复杂的融合设计,仅仅使用一个线性层来完成从视觉空间到语言空间的映射。虽然受限于当时的训练数据量,其初代版本的通用能力并不惊艳,但这个“极简连接器”的范式,如同一颗投入平静湖面的石子,为后续 MLLM 的发展激起了巨大的涟漪。

3.1.2 务实的迭代:从 1.0 到 1.5

LLaVA 的后续发展并未选择推倒重来,而是在其简洁的基座上进行了一系列务实而高效的迭代升级,这在 LLaVA-1.5 版本中体现得淋漓尽致:

• 连接器升级: 将原本的单层线性层,升级为了一个表达能力更强的两层 MLP。

• 分辨率提升: 将视觉编码器的输入分辨率从 224x224 提升至 336x336,使其能从源头捕捉更多细节。

• 数据驱动: 引入了规模更大、质量更高的视觉指令微调数据集,进一步释放了模型的潜力。

这些看似微小的改动,却带来了显著的性能提升,充分证明了 LLaVA 路线的有效性:一个好的基础架构,可以通过持续的数据和参数优化不断成长。

3.1.3 核心突破:AnyRes 技术——在“边界”上解决问题

面对“如何看得更清晰”的核心矛盾,LLaVA 给出了一个充满工程智慧的答案——AnyRes 技术,这正是其“扩展输入边界”哲学的完美体现。

如 LLaVA-1.5-HD 的架构所示,它没有改动模型内部,而是在数据预处理阶段进行了一次巧妙的“分兵”:一路将高清图像切块 (split),以保留局部细节;另一路将高清图像降采样 (resize),以提供全局上下文。最终,这两路信息被拼接在一起送入 LLM,使其既能“明察秋毫”,又能“高瞻远瞩”。

这一思想在后续的 LLaVA-OneVision 中进一步演进为 Higher AnyRes,通过引入双线性插值来更好地融合图块特征,以应对文档理解等对空间布局要求极高的任务。

最终的升华:走向多模态统一 (LLaVA-OneVision)

LLaVA 的演进最终在 LLaVA-OneVision 上达到了一个高峰。它依然坚守着简洁的核心架构,但通过引入海量的、多样化的数据(包括单图、多图和视频),并结合优化的 Higher AnyRes 技术,成功地将这一简洁的理念从静态图像无缝扩展到了动态视频领域,成为了首批实现图像与视频统一处理的开源模型之一。

综上所述,LLaVA 系列的整个发展历程,是一部关于“简洁”与“迭代”的成功史。它向我们展示了,一个清晰、简洁的初始设计,通过持续的数据优化和聪明的输入端工程创新(如 AnyRes),完全有能力攀登到多模态性能的顶峰。

3.2 Qwen3-VL:深度融合的集大成者

如果说 LLaVA 系列的演进史是一部关于“大道至简”的优雅叙事,那么 Qwen3-VL 的崛起则是一篇关于“精巧设计,架构致胜”的宏伟史诗。它所代表的路线,不满足于仅仅在模型的入口处进行一次性的“翻译”和拼接,而是对模型的核心架构进行了深度改造,旨在构建一个视觉与语言在处理过程中就能持续、深度交互的协同系统。

3.2.1 全新范式:从“入口拼接”到“多层注入”

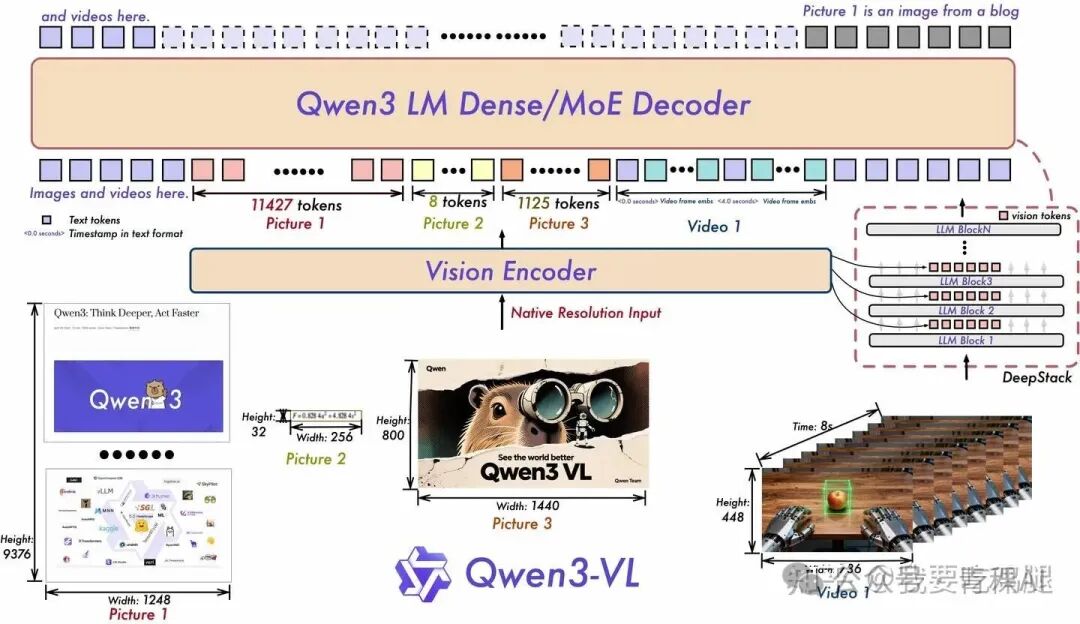

Qwen3-VL 的架构图本身就展示了其与 LLaVA 的根本不同。

如上图所示,Qwen3-VL 的设计显然更为复杂和精巧。它不仅能原生处理包括超高分辨率长图和视频在内的混合输入,其核心创新更在于视觉信息的处理和融合方式上。在 LLaVA 中,视觉信息在进入 LLM 之后就不再有新的补充;而在 Qwen3-VL 中,这仅仅是个开始。

3.2.2 核心技术:DeepStack 的革命性实现

在 Qwen3-VL 架构的心脏地带,跳动着其最具革命性的创新——DeepStack 技术。这是一种全新的融合范式,我们可以将其理解为:从视觉编码器到语言模型的一次“单向握手”,升级为了一场贯穿始终的“多层次深度对话”。

上图右侧清晰地展示了 DeepStack 的工作原理。传统的 MLLM 仅将 Vision Encoder 最后一层的输出特征送入 LLM 的输入层。而 Qwen3-VL 则不同,它的 Vision Encoder 会像一个“信息分发站”,从其多个不同深度的中间层(例如第 8、16、24 层)提取出不同抽象层次的视觉特征。然后,这些特征会被精准地注入 (inject) 到 LLM 解码器相对应的前几个层(如 LLM Block 1, Block 3, ...)中。

这种设计的精妙之处在于:

• 信息层次匹配:它让 LLM 的浅层(更侧重于处理局部和基础特征)接收来自 ViT 中间层的、相对不那么抽象的视觉特征;而 LLM 的深层则可以专注于基于更高阶的、已融合的信息进行推理。这背后有坚实的实验数据支撑,证明了 LLM 的浅层更适合处理视觉信息。

• 计算效率优化:值得注意的是,Qwen3-VL 的实现比原始 DeepStack 论文中的方案更为高效。它无需为获取精细特征而额外处理一张高分辨率图像,而是直接从处理标准输入的同一个 Vision Tower 中提取中间层特征,这在保证了多层次信息供给的同时,显著节约了计算资源。

3.2.3 架构演进的“石锤”:从代码看 Qwen 的进化

这种从“简单拼接”到“深度融合”的哲学转变,不仅仅停留在概念层面,更是在模型的代码实现中留下了清晰的印记。

通过对比 Qwen2.5-VL 和 Qwen3-VL 的模型定义代码,我们可以直观地看到这场深刻的进化:

1.DeepStack 模块的引入: 在 Qwen3-VL 的代码中,明确出现了 deepstack_merger_list 这一新模块。这正是负责收集并处理 ViT 中间层输出,为后续注入 LLM 做准备的核心组件,是 DeepStack 实现的直接证据。

2.语言模块 (Language Model) 的革新: Qwen3-VL 的语言模型部分升级为了 Qwen3VLMoeTextModel,其内部包含了 Qwen3VLMoeTextSparseMoeBlock 结构,表明其“大脑”已经进化为更先进、更高效的混合专家 (MoE) 架构。

3.2.4 其他前沿技术的集大成

除了革命性的 DeepStack 技术,Qwen3-VL 还集成了其他多项前沿架构创新,共同构成了其强大的技术护城河:

• MRoPE-Interleave: 一种更先进的多维旋转位置编码,通过交错 t, h, w 三个维度的频率,让模型对视频的时空信息有更鲁棒的感知。

• 文本时间戳对齐机制: 在输入端就将视频帧与精确的时间戳文本(如 <0.8 seconds>)进行绑定,让 LLM 具备了前所未有的、对视频事件进行精准时间定位的能力。

综上所述,Qwen3-VL 代表了 MLLM 演进的另一条巅峰之路。它不再满足于模态间的浅层连接,而是通过 DeepStack、MoE、MRoPE 等一系列精巧而深刻的架构创新,构建了一个真正意义上的“深度协同”系统。它雄辩地证明了,通过对模型内部信息流进行极致的、有理论依据的优化设计,同样可以,甚至更能推动多模态能力的边界,达到新的高峰。

第四部分:总结与展望:殊途同归,迈向统一的“世界模型”

我们的解构之旅至此已近尾声。从 MLLM 的“三位一体”黄金架构,到“如何看得更清晰”这一核心矛盾所引出的两条截然不同的演进之路,我们见证了 LLaVA 和 Qwen3-VL 如何用各自的智慧给出了精彩的答案。

LLaVA 和 Qwen3-VL 的发展历程,是多模态大模型领域两条并行且同样成功的探索路径的缩影:

• LLaVA 系列,向我们证明,一个极简的核心设计,通过持续的数据优化和以 AnyRes 为代表的输入端技术创新,完全有能力攀登到性能的顶峰。

• Qwen3-VL,不再满足于模态间的浅层连接,而是通过DeepStack、MoE、MRoPE 等一系列深刻的内部架构创新,构建了一个真正意义上的“深度协同”系统。

尽管它们的设计路径不同,但最终殊途同归。两条路线都极大地推动了 MLLM 的性能边界,并共同指向了一个清晰的方向:实现视觉与文本更深层次、更无缝的统一。站在当前的时间点,展望多模态大模型的未来,我们看到的不再是科幻,而是正在发生的现实。结合 Qwen3-VL 等前沿模型的最新进展,我们可以预见以下几个清晰的发展趋势:

• 从“感知”到“推理与执行” (From Perception to Execution): MLLM 的能力正在超越“看图说话”的范畴。新一代模型正发展出强大的视觉智能体 (Visual Agent) 能力,能够理解 GUI 元素、操作电脑手机界面、调用工具来完成复杂任务。AI 不再仅仅是世界的观察者,更将成为参与者。

• 拥抱动态与三维世界 (Embracing Dynamic & 3D Worlds): 静态图像的理解已趋于成熟,下一个战场是长视频和三维空间。原生支持数小时视频的完整理解、精准到秒级的时间定位,以及从 2D 图像中还原物体在真实世界中位置和大小的 3D grounding 能力,将成为未来模型的标配。

• 真正的多模态统一 (True Multimodal Unification): 当前的“拼接”和“注入”可能只是过渡阶段。未来的终极形态,或许是在预训练的最早期阶段,就将视觉、语言、音频等多种模态的数据混合在一起进行协同训练,让模型从诞生之初就在一个统一的、多模态的世界观下学习成长。GPT-5 等模型不再区分视觉和文本旗舰,也印证了这一趋势。

多模态大模型的发展,不仅是为 AI 装上了一双越来越清晰的“眼睛”,更重要的是,它正在为 AI 构建一座通往我们物理世界的、坚实而宽广的桥梁。通过这座桥梁,AI 将能够真正地“理解”我们所处的环境,并最终与我们“共存”于同一个现实之中。一个更强大、更通用、更能与我们协作的 AGI (通用人工智能) 时代,正以前所未有的速度加速到来。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

339

339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?