最近和不少刚接触自动驾驶的小伙伴聊了聊,发现很多同学都处在相对懵逼的阶段。怎么前两年还是BEV感知、3D目标检测、在线高精地图之类的方向,咋一年不到遍地都是端到端、大模型了。。。这些方向的算力要求实验室根本满足不了,有没有那种适合毕业科研并且算力要求比较低的方向?后面工作上也有应用场景?

这个方向就是三维重建领域的3D Gaussian Splatting!相比于隐式神经网络的黑盒表示,3D Gaussian的表征方式更符合直觉,更通俗易懂。3DGS之所以爆火,很大程度在于他的实时性。除此之外,Gaussian Splatting根本不涉及任何神经网络,甚至没有一个小型的 MLP,也没有什么 "神经"的东西,场景本质上只是空间中的一组点。而更重要的一点,相比自动驾驶感知任务、大模型之类的领域,3DGS所需的算力非常小,基本上单卡就能运行,训练往往只需要分钟级。在大家都在研究数十亿个参数组成的模型的人工智能世界里,这种方法越来越受欢迎,令人耳目一新。目前3DGS已经应用在SLAM、数字人体、表面重建、自动驾驶闭环仿真等等诸多领域,甚至在自动驾驶Occupancy感知、预训练等方面也也有很多优秀的工作。据自动驾驶之心了解,很多业内公司已经基于3DGS搭建了新的闭环仿真链路。可以说,3DGS是当下自动驾驶闭环仿真乃至计算机视觉领域最火的方向之一,是科研和落地的最前线!

重建效果如何?

静态场景重建:

表面场景重建:

动态场景重建:

自动驾驶场景重建:

入门学习仍然困难?

正如前文所述,3DGS发展至今已经衍生出各个子方向,3D Gaussian如何表示三维世界?又是如何渲染出二维图像?时序又如何引入进化到4D GS?整个3DGS涉及到的模块、细节众多。这类知识点琐碎,系统也比较复杂,如果没有比较好的教程带着入门,往往会踩坑,后期不知道怎么学习。新视角泛化怎么提升?场景编辑又是什么魔法?自动驾驶仿真闭环又是如何用到Gaussian Splatting的?工业界和科研还适不适合入局?这些都是阻挡新手入门以及进阶的难点。

早鸟拼团立减300!扫码加入学习!

为此,我们联合业内头部自动驾驶公司算法专家,联合展开了业内首门面向3DGS全栈实战小班课,Cover 3DGS的各个子领域,让大家真正能够学得透彻,后期配有代码实战讲解,助力大家真正从实现的角度上搞懂算法。同时作为专享福利,小班课将赠送《NeRF与自动驾驶论文带读课程》!

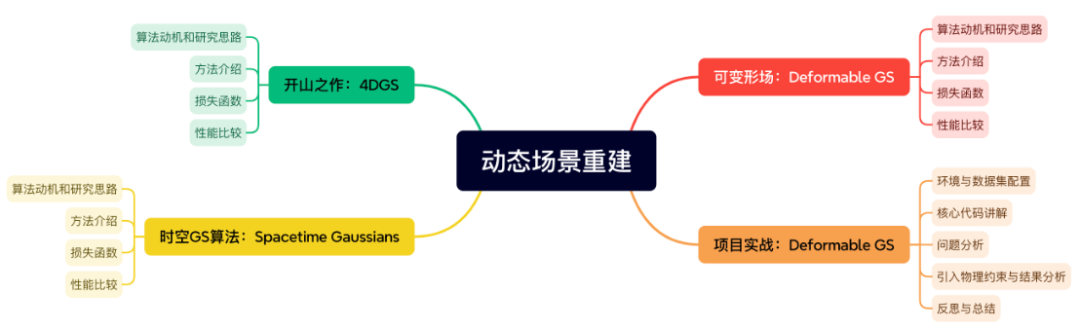

小班课完整版大纲如下:

这门课程将会如何展开

第一章:视觉重建算法基础

第一章会介绍视觉重建领域的基础算法。视觉重建属于计算机视觉和计算机图形学的交叉领域,其基础算法也会涉及到这两个研究方向。神经辐射场(NeRF)和3D高斯泼溅(3DGS)的提出就是建立在视觉重建算法的基础上。本章的内容主要包括:

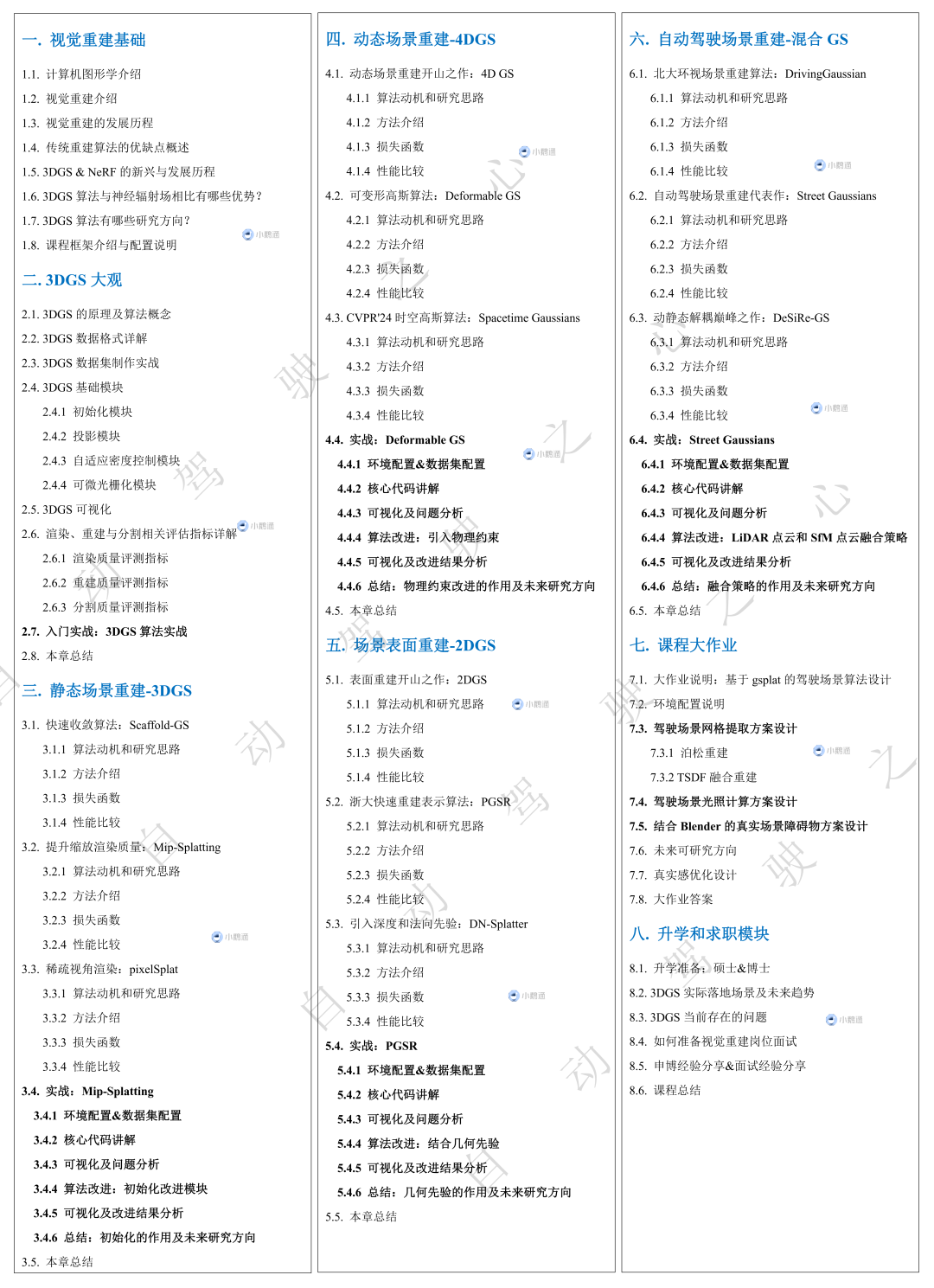

第二章:3DGS大观

第二章会详细介绍有关3DGS的技术细节。3DGS自从发表在Siggraph 2023上,由于其训练和渲染速度快的特点,在不到两年的时间内迅速发展,被大量的相关工作采用作为基础模块并且扩展到自动驾驶领域。因此第二章带大家深度入门3DGS,从数据到算法、从可视化到评测、从整体到细节模块,全面剖析!本章的内容主要包括:

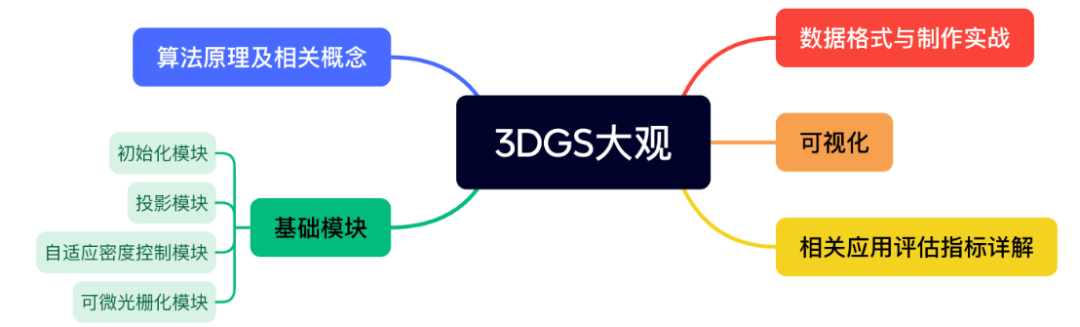

第三章:静态场景重建-3DGS

第三章会挑选有关增强3DGS在静态场景中渲染表现的三个工作进行剖析。对于项目实战,本章挑选CVPR2024的最佳学生论文Mip-Splatting作为主体。Mip-Splatting专注于对3DGS在多分辨率图像下的渲染表现进行增强。它引入的3D 平滑滤波器和2D 盒式滤波器策略有效地解决了原始3DGS在放大效果下的伪影和交叠问题,而这部分内容仍然是当下学术界研究的前沿。本章的内容主要包括:

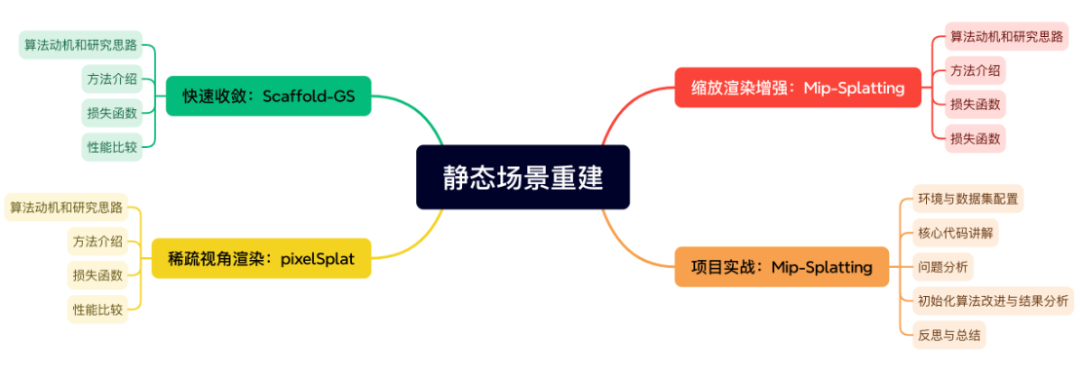

第四章:动态场景重建4DGS

第四章会讲解三个动态场景重建的工作。动态场景重建能够建模物体随时间运动的变化,世界不是静止的,物体在移动,色彩在变化。4DGS就像行走在时间上的舞者,在每个时刻都有自己独特的表现。本章选取CVPR2024的满分文章Deformable GS来作为项目实战,来让大家对可变形场有个清晰的认识,也为之后的课程大作业打好基础。本章的内容主要包括:

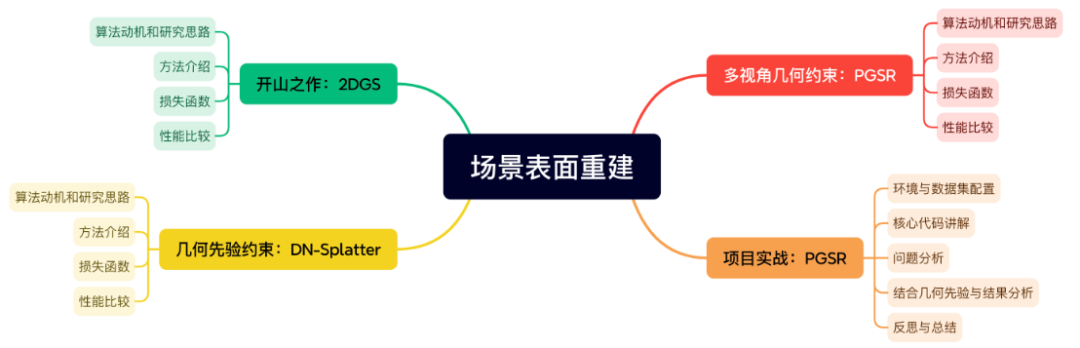

第五章:场景表面重建-2DGS

第五章会着重介绍基于3DGS进行场景表面重建的三个相关工作。通过场景的表面重建,可以对自动驾驶场景进行物理编辑,比如添加车辆,行人等物体。本章选取当前基于3DGS的SOTA方案PGSR来让大家深入了解场景表面重建的一些基本环节,本章的内容主要包括:

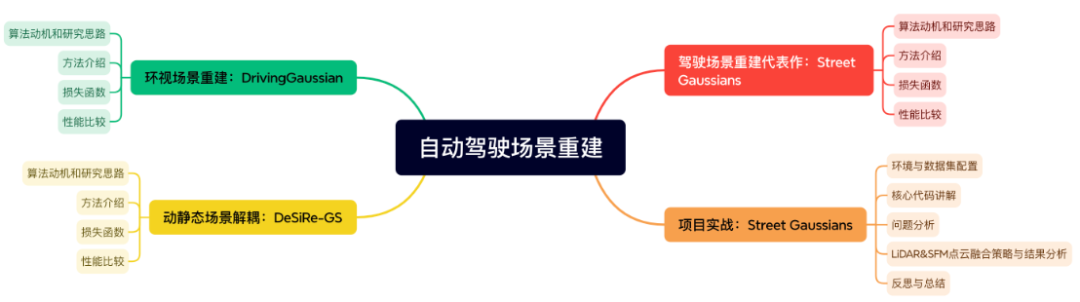

第六章:自动驾驶场景重建-混合GS

第六章则聚焦在自动驾驶场景,对将动静态场景混合情况下的3DGS进行优化的三个工作进行深度解读。只有重建出完整的场景,才能进行场景编辑,进而才能实现闭环仿真。自动驾驶场景的重建涉及到动静态物体分解,所以本章选取Street Gaussians项目作为实战来带大家熟悉基本的分解策略。本章的内容主要包括:

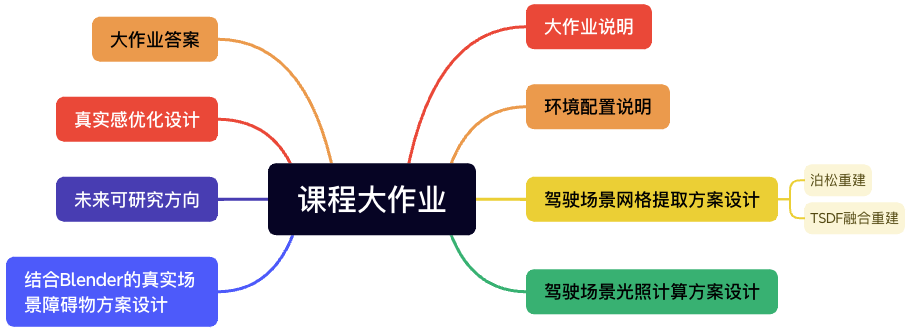

第七章:课程大作业

第七章是课程实战的精华部分,3DGS未来还有哪些研究方向?驾驶场景如何优化?工业界&科研最常用的算法框架是哪个?为此,我们选择了当下应用最广泛的gsplat,其对3DGS的pytorch版本进行了代码重构的开源项目,并提升了原版代码的训练效率,且仓库十分活跃,目前已经支持很多主流算法,非常适合科研及工程应用。本课程的大作业会带着大家从头到尾实现一个基于gsplat的驾驶场景重建的算法设计。

第八章:升学和求职模块

第八章是课程的应用模块,主打升学和求职的经验分享。工欲善其事必先利其器,有了前面七个章节的『器』,咱们在第八章终于可以做『事』了。有了算法经验和工程经验,如何进一步升学和求职呢?需要做哪些准备?3DGS在学术界的研究趋势和工业界的落地现状如何了?目前还有哪些问题仍未解决?在这一章节,老师都会毫无保留的分享给大家。

讲师介绍

Jeff,深耕三维重建算法领域多年,国内TOP院校博士毕业。目前在SIGGRAPH,CVPR和TOG等国际顶级会议和期刊上发表论文8篇,现任业内头部自动驾驶公司团队算法专家,在NeRF/3DGS算法研究方面有着丰富的经验。

适合人群

高校研究人员与学生;

初创企业技术团队;

企业技术专家、骨干;

想要转行从事三维重建的同学;

课程收获

掌握3DGS的核心理论与研究现状;

掌握2DGS/3DGS/4DGS/混合GS的前沿算法;

具备训练和优化3DGS的实际能力;

应用3DGS解决实际问题的能力;

提升科研&工作核心竞争力。

课程所需基础

一定的三维重建与计算机图形学基础;

对NeRF和3DGS有一定的了解;

Python和PyTorch基础,具备代码读写的能力;

需要自备GPU,显存不低于12G;

开课时间与课程说明

2025.1.28号正式开课,由于是在线课程,课程购买后不支持退款。购买后,1年内有效。

课程咨询

早鸟拼团立减300!扫码加入学习!

欢迎咨询小助理了解更多!

版权声明

自动驾驶之心所有课程最终版权均归自动驾驶之心团队及旗下公司所属,我们强烈谴责非法盗录行为,对违法行为将第一时间寄出律师函。也欢迎同学们监督举报,对热心监督举报的同学,我们将予以重报!

投诉微信:AIDriver004(备注:盗版举报)

301

301

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?