点击下方卡片,关注“具身智能之心”公众号

作者 | Shaoyuan Xie 编辑 | 具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

论文标题:Are VLMs Ready for Autonomous Driving? An Empirical Study from the Reliability, Data, and Metric Perspectives

论文链接:https://arxiv.org/pdf/2501.04003

项目链接:https://drive-bench.github.io/

数据集链接:https://huggingface.co/datasets/drive-bench/arena

作者单位:加州大学欧文分校 上海人工智能实验室 新加坡国立大学 新加坡南洋理工大学 S-Lab 香港大学

注:本工作由具身智能之心独家解读,转载欢迎联系我们;

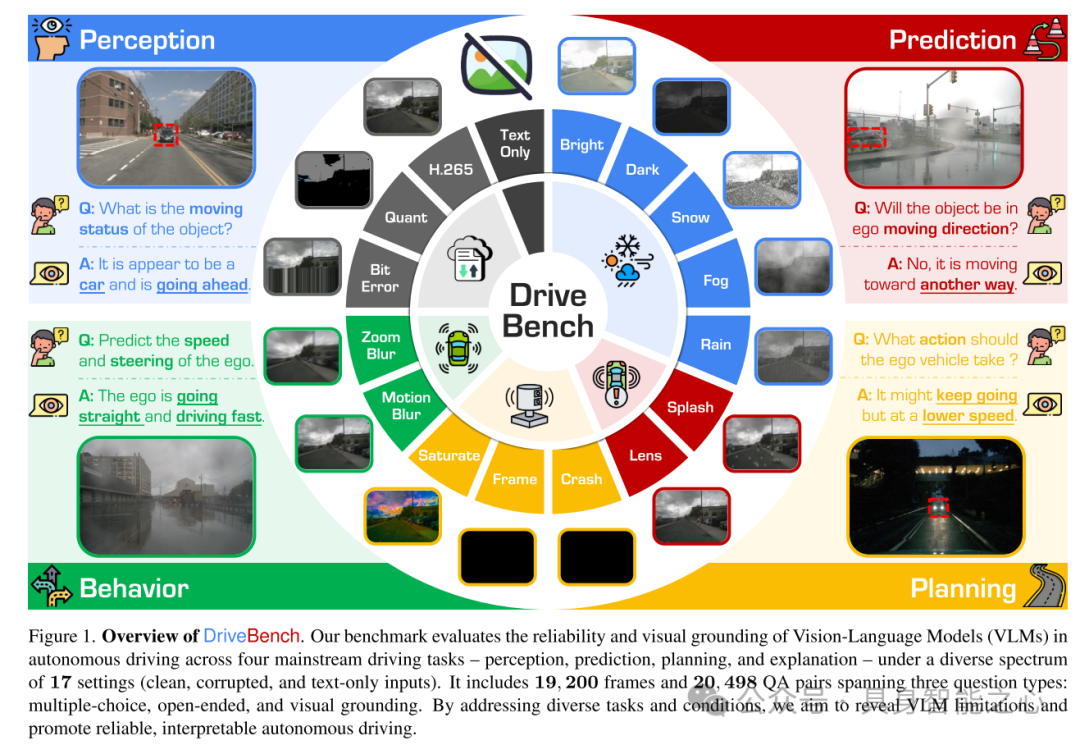

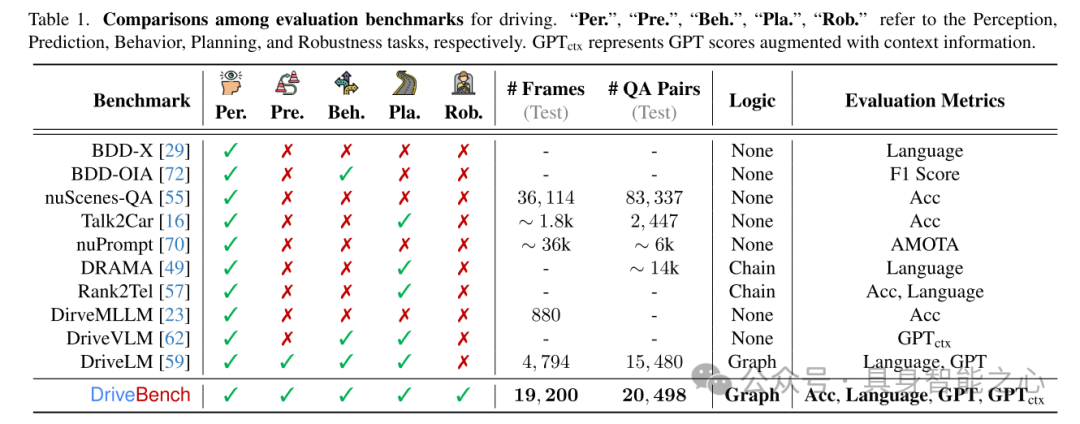

这里提出的基准测试从感知、预测、规划和解释四个主流驾驶任务出发,评估视觉语言模型(VLMs)在自动驾驶中的可靠性和视觉基础能力。测试覆盖了17种输入设置(清晰输入、损坏输入和仅文本输入),包含19,200帧图像和20,498个问答对,涉及三种问题类型:多项选择、开放式问答和视觉基础问题。通过应对多样化的任务和条件,DriveBench 旨在揭示 VLM 的局限性,推动可靠且可解释的自动驾驶发展。

内容出自国内首个具身智能全栈学习社区:具身智能之心知识星球,这里包含所有你想要的。

写在前面

近年来,视觉语言模型(Vision-Language Models, VLMs)的进展引发了其在自动驾驶领域应用的广泛兴趣,尤其是在通过自然语言生成可解释驾驶决策方面。然而,VLMs 能够内在地提供视觉基础、可靠且可解释的驾驶解释这一假设仍缺乏系统性验证。为填补这一研究空白,这里提出了DriveBench,一个评估 VLM 可靠性的基准数据集。该数据集覆盖了17种输入设置(包括清晰输入、损坏输入和仅文本输入),包含19,200帧图像、20,498个问答对、三类问题类型、四种主流驾驶任务,以及总计12种主流 VLMs。

研究发现,VLMs 通常基于通用知识或文本线索生成合理的响应,而非真正依赖视觉信息,特别是在视觉输入退化或缺失的情况下。这种行为由于数据集的不平衡性和评估指标的不足而被掩盖,然而在诸如自动驾驶等对安全性要求极高的场景中,这种缺陷可能带来显著风险。此外,本文观察到 VLMs 在多模态推理方面存在困难,并对输入损坏表现出高度敏感性,导致性能不一致。

针对这些挑战,该工作提出了优化的评估指标,重点关注稳健的视觉基础和多模态理解能力。同时,强调了利用 VLMs 对输入损坏的感知能力来提升其可靠性的潜力,进而为开发更可信且具有可解释性的真实世界自动驾驶决策系统提供了路线图。该基准工具包现已公开发布。

实证研究的思路

随着视觉语言模型(Vision-Language Models, VLMs)的最新进展,在自动驾驶应用中引入 VLMs 的研究兴趣日益增加。这些研究涵盖了端到端框架的设计,以及通过自然语言提升可解释交互与决策的 VLMs 集成。这种可解释性被认为能够增强自动驾驶系统的透明性、可信度和用户信心。

然而,先前的研究指出,在开环(open-loop)设置中评估端到端自动驾驶模型存在显著局限性。因此,与其专注于使用潜在不可靠的开环端到端 VLMs 进行轨迹预测,本文转而关注另一个重要但尚未被充分探索的问题,该问题在诸多研究中被广泛假设:

现有的视觉语言模型(VLMs)是否能够基于视觉线索为驾驶提供可靠的解释?

为此,该工作研究了 VLMs 生成的驾驶决策是否真正基于来自物理环境的感知信息,抑或仅反映了通用知识和基于文本线索的虚构响应。

模型可靠性

为回答这一核心问题,通过分布外(Out-of-Distribution, OoD)鲁棒性的视角评估 VLM 的可靠性。为此,提出了DriveBench,一个基准数据集,涵盖四种主流驾驶任务和15种数据损坏类型,包括19,200张图像和20,498个针对真实自动驾驶场景设计的问答对。

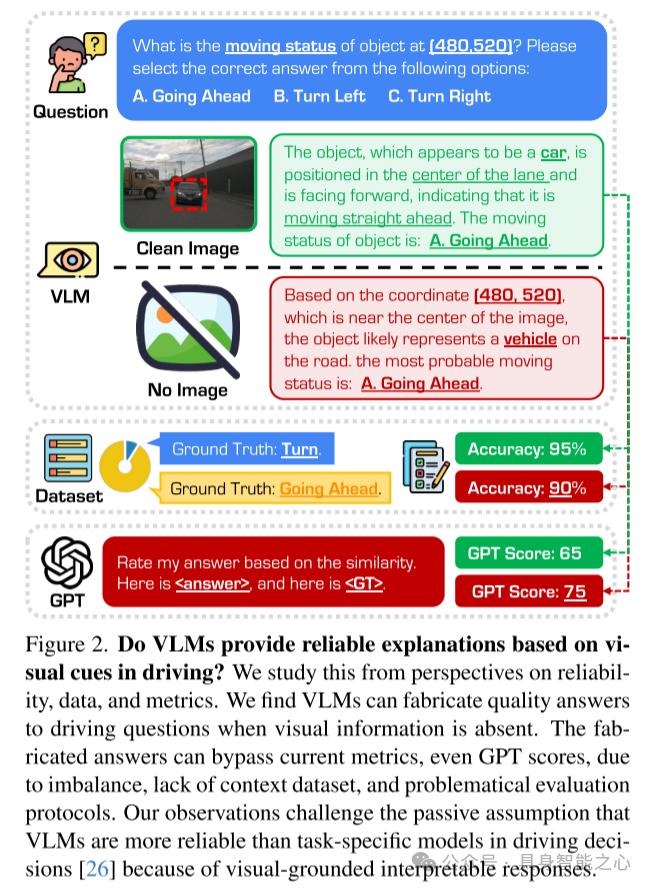

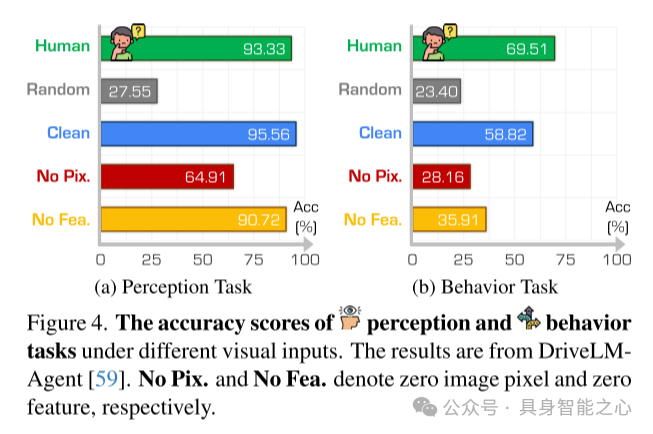

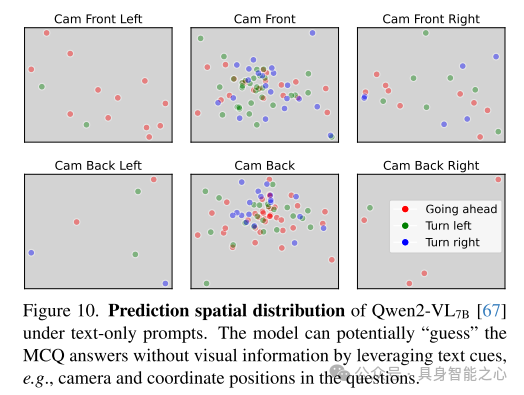

为了评估在极端条件下的鲁棒性,该工作通过仅使用文本提示(text-only prompts)将视觉退化推至极限。令人惊讶的是,即使在没有任何视觉线索的情况下,VLM 的表现与在“清晰”视觉输入下的输出相当(如图2所示)。这一现象与人类驾驶员的表现形成鲜明对比,因为在如此恶劣的条件下,人类驾驶员通常难以应对。

深入分析表明,这种表面上的“韧性”往往是由于数据集不平衡和评估协议不完善造成的,而非模型自身具备的内在鲁棒性。

数据集

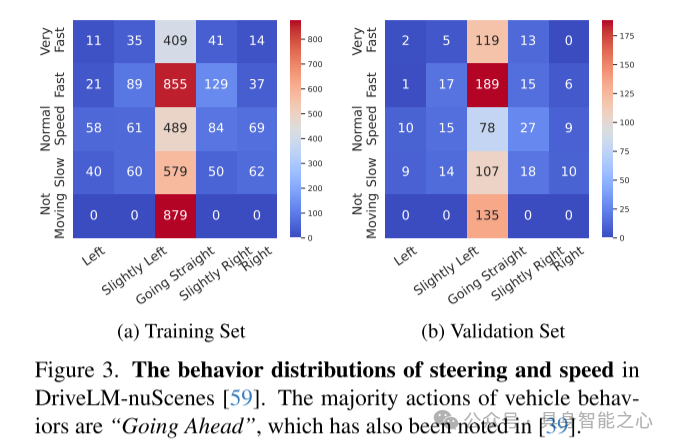

该工作对现有的“语言驱动驾驶”(Driving with Language)基准数据集进行了深入分析,发现了关键缺陷,尤其是在数据集不平衡方面的问题。这些基准数据集大多基于流行的驾驶数据集构建,如 nuScenes、BDD和 Waymo Open,并继承了其原始设计中的局限性。

例如,不平衡的数据分布导致评估结果倾斜,使得过于简单的回答(如“直行”)在与运动相关的查询中即可实现超过90%的准确率。此外,许多基准数据集依赖于单帧问题,而这些问题通常需要时间上下文的支持,这甚至对人类标注者来说也存在挑战。

因此,这些基准数据集存在固有的偏差和持续的负样本问题,这削弱了评估结果的可解释性和可靠性。

指标

这里还对现有的指标设计进行了深入的重新评估。针对驾驶应用中的语言交互,目前通常使用传统的模式匹配指标进行评估,如 ROUGE 、BLEU 和 CIDEr,这些指标最初为摘要和翻译任务而设计。然而,正如先前工作所指出的,这些指标在评估复杂的语言驱动驾驶决策时存在显著局限性。

即使是现代评估方法(如基于 GPT 的评分机制),在没有任务特定评分规则的情况下,也难以提供深入见解。这些限制凸显了需要能够有效捕捉推理能力、上下文理解和安全关键因素的指标。

该工作倡导开发更加先进的评估指标,这些指标应结合任务特定的评分规则、结构化问题格式以及上下文驾驶信息,从而更准确地评估 VLM 在真实世界场景中的表现。

关键见解

通过一系列全面的实验,该工作从分析中得出了一些关键见解。实验覆盖了17种输入设置(包括清晰输入、仅文本输入以及各种损坏输入)、12种 VLMs(包含开源和商业模型)、5个任务(感知、预测、规划、行为和损坏识别)以及3种评估指标(准确率、传统语言指标和基于 GPT 的评分)。这些发现揭示了在将 VLMs 集成到驾驶场景中所面临的当前挑战:

退化条件下的虚构响应:在视觉条件退化的情况下,VLMs 通常生成看似合理但实为虚构的响应,包括在完全没有视觉线索的场景中。这引发了对其可靠性和可信度的担忧,因为此类行为难以通过现有的数据集和评估协议进行检测。

对视觉损坏的感知:尽管 VLMs 在一定程度上能够感知视觉损坏,但仅在被直接提示时才会明确承认这些问题。这凸显了模型在自主评估视觉输入可靠性以及提供针对具体场景和安全性的响应方面的能力有限。

数据集偏差的影响:高度偏向的数据集和次优的评估协议可能导致对 VLM 性能的误导性认知。在许多情况下,VLMs 更倾向于依赖通用知识而非实际的视觉线索来生成响应,这在现有指标下可能意外地获得高分。

定制化评估指标的需求:现有的评估指标,包括传统的语言指标和基于 GPT 的评分,无法充分反映自动驾驶任务的复杂需求。亟需开发专门的评估指标,以更有效地评估 VLMs 的推理能力、上下文理解能力以及安全关键因素。

该工作的研究通过 DriveBench 不仅突出了改进数据集和评估协议的必要性,还为开发更安全、更具可解释性的真实世界自动驾驶系统中的 VLMs 奠定了基础。

从可靠性、数据和指标三个视角对此进行研究。研究发现,当视觉信息缺失时,VLMs 仍能够生成高质量的驾驶问题答案。然而,这些虚构的答案由于数据集不平衡、缺乏上下文信息以及评估协议存在问题,能够通过现有指标的检验,包括基于 GPT 的评分。这一观察挑战了之前的假设,即 VLMs 因其基于视觉的可解释性响应在驾驶决策中比任务专用模型更可靠。

车辆行为的主要动作是“直行”,这一现象在 [39] 中也有所提及。

结果来源于 DriveLMAgent 。其中,No Pix. 表示无图像像素输入,No Fea. 表示无特征输入。

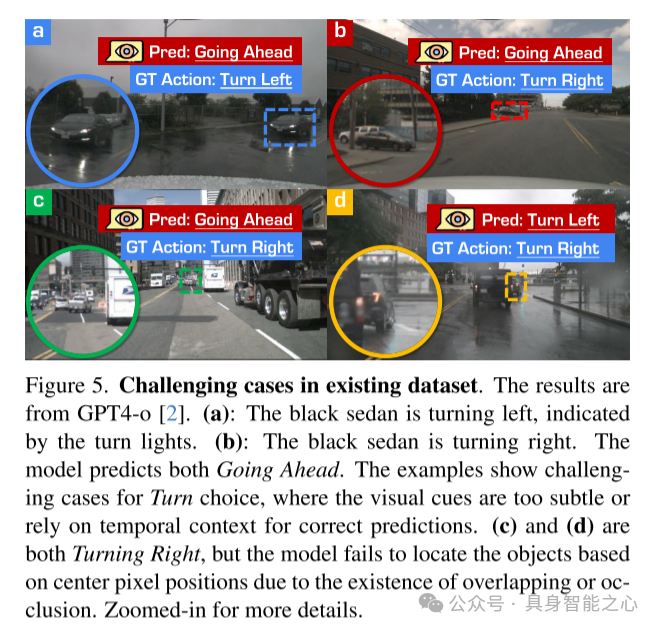

结果来自 GPT4-o 。

(a):黑色轿车正左转,左转信号灯已亮。

(b):黑色轿车正右转。模型却对两者均预测为“直行”。这些示例展示了在转向选择(Turn choice)中的挑战性案例,其中视觉线索过于细微或需要依赖时间上下文才能做出正确预测。

(c) 和 (d) 均为右转场景,但由于存在重叠或遮挡,模型无法基于中心像素位置正确定位物体。

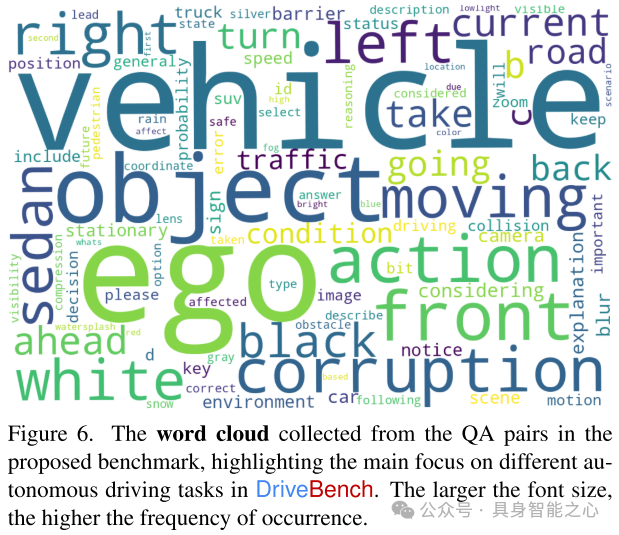

从提出的基准数据集中的问答对提取的词云,突出显示了 DriveBench 中不同自动驾驶任务的主要关注点。字体越大,出现频率越高。

“Per.”、“Pre.”、“Beh.”、“Pla.”、“Rob.” 分别表示感知、预测、行为、规划和鲁棒性任务。 表示结合上下文信息增强的 GPT 评分。

实验结果分析

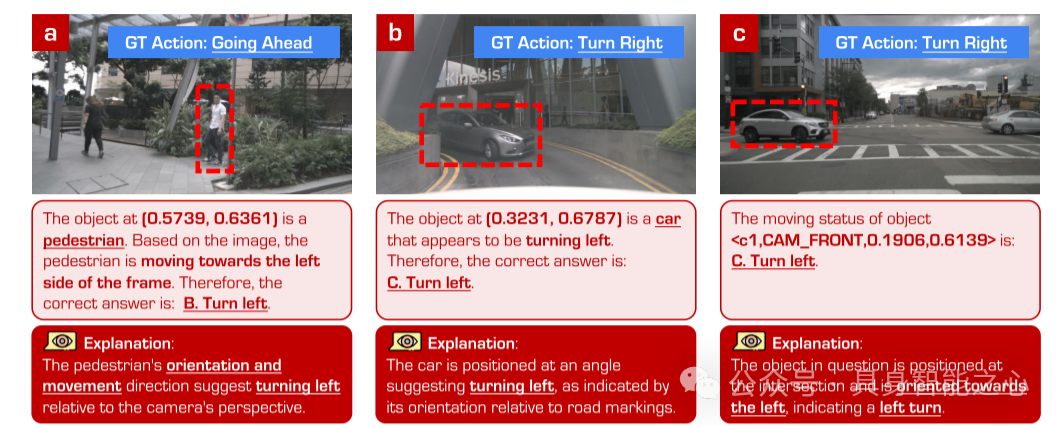

(a):GPT-4o 通过物体相对于帧的位置变化来推断行人运动状态,而非基于运动物体本身的坐标,导致感知结果错误。

(b):模型在基于目标物体坐标区分正确方向时表现困难。

(c):GPT-4o 通过物体相对于当前帧的相对位置推断 SUV 的运动状态,导致感知结果错误。

(d):GPT-4o 未能正确感知汽车的朝向。

(e):数据集中包含需要多帧推理才能成功的示例,但 GPT-4o 无法通过单帧输入解决这些问题。

(f):GPT-4o 通过物体相对于当前帧的相对位置推断 SUV 的运动状态,再次导致感知结果错误。

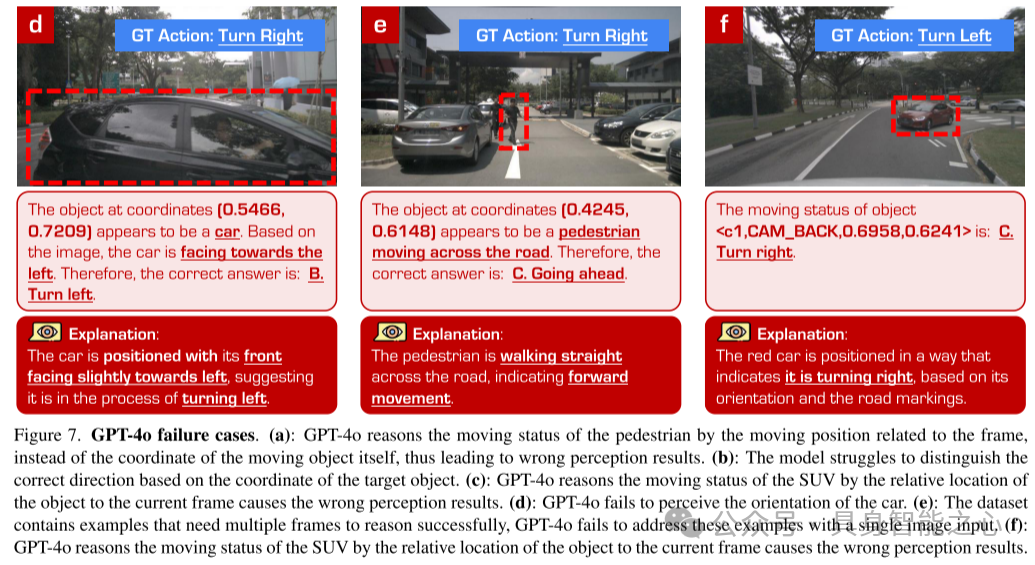

在每种损坏条件下,该工作评估多项选择题(MCQs)准确率相对于清晰输入的变化。结果显示,人类性能大幅下降,而大多数 VLM 的表现几乎没有变化。

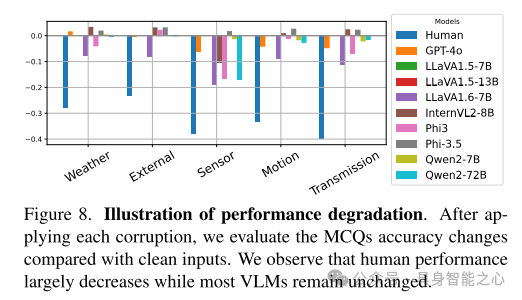

每种输入损坏类型的性能通过四种驾驶任务中的 1,261 个问题的平均值计算得出。评估指标为 GPT 评分。

该模型可能通过利用文本线索(如问题中的相机和坐标位置),在没有视觉信息的情况下“猜测”多项选择题(MCQ)的答案。

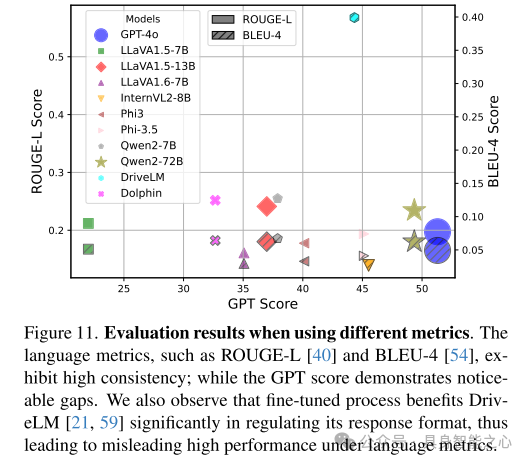

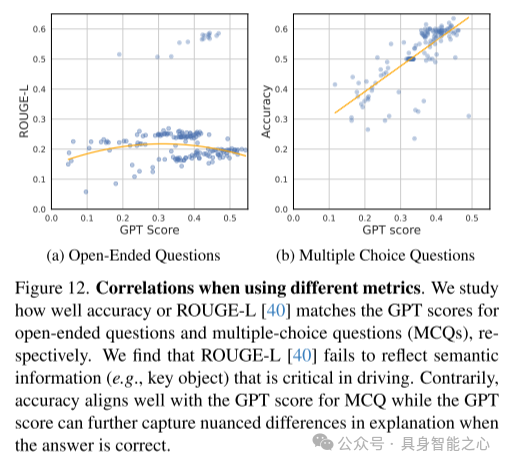

语言指标(如 ROUGE-L 和 BLEU-4 )表现出较高的一致性,而 GPT 评分显示了显著的差异。同时,该工作发现微调过程显著提升了 DriveLM 在规范响应格式方面的能力,从而在语言指标下表现出误导性较高的性能。

该工作还研究了准确率或 ROUGE-L 分别与 GPT 评分在开放式问题和多项选择题(MCQs)中的匹配程度。结果发现,ROUGE-L 未能反映驾驶中关键的语义信息(如关键物体)。相比之下,准确率与 MCQs 的 GPT 评分具有较好的一致性,而在答案正确的情况下,GPT 评分能够进一步捕捉解释中的细微差异。

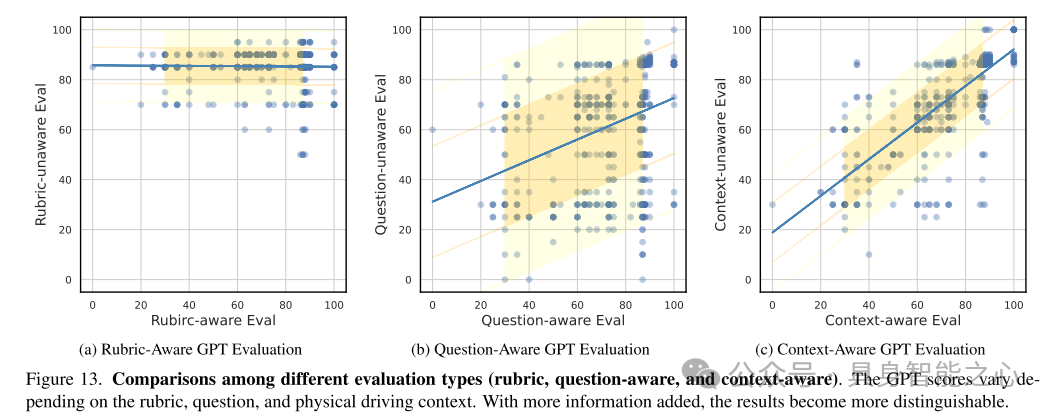

GPT 评分根据评分规则、问题内容和实际驾驶上下文的不同而有所变化。随着信息的逐步增加,评估结果变得更加可区分。

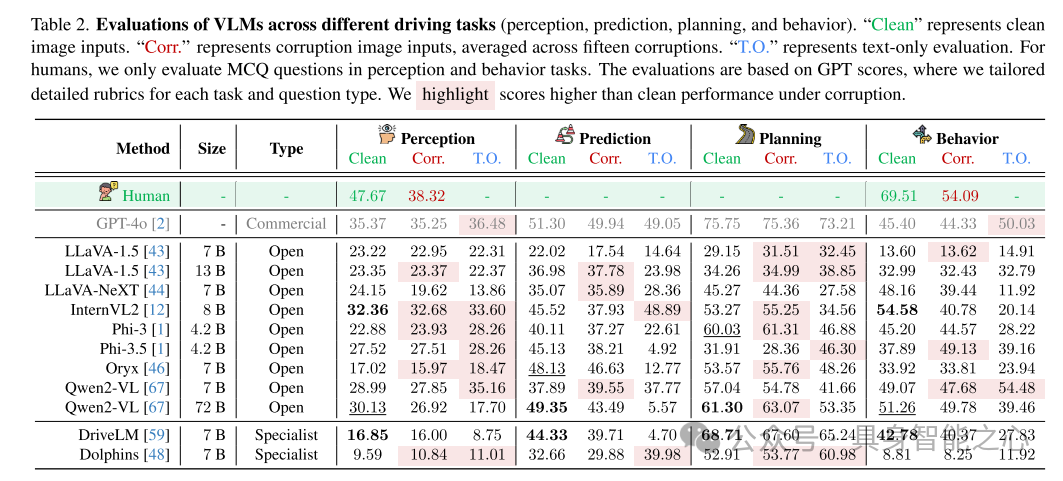

“Clean” 表示清晰图像输入,“Corr.” 表示损坏图像输入(取15种损坏的平均值),“T.O.” 表示仅文本输入的评估。对于人类测试者,本文仅在感知和行为任务中评估多项选择题(MCQ)。评估基于 GPT 评分,并针对每个任务和问题类型定制了详细的评分规则。对于在损坏条件下表现优于清晰输入的分数进行了高亮显示。

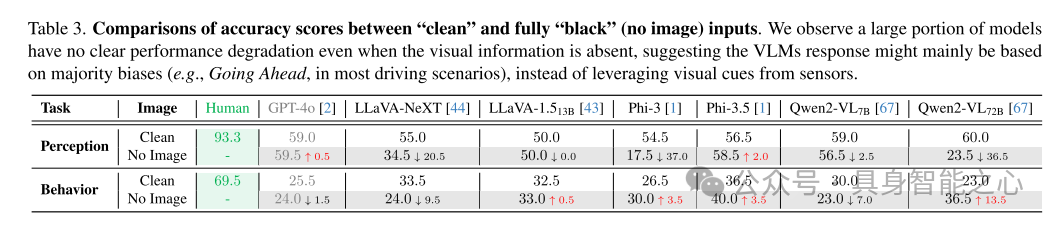

该工作观察到,大部分模型即使在缺乏视觉信息的情况下,其性能也未明显下降。这表明,VLMs 的响应可能主要依赖于多数偏差(例如,在大多数驾驶场景中选择“直行”),而非利用传感器提供的视觉线索。

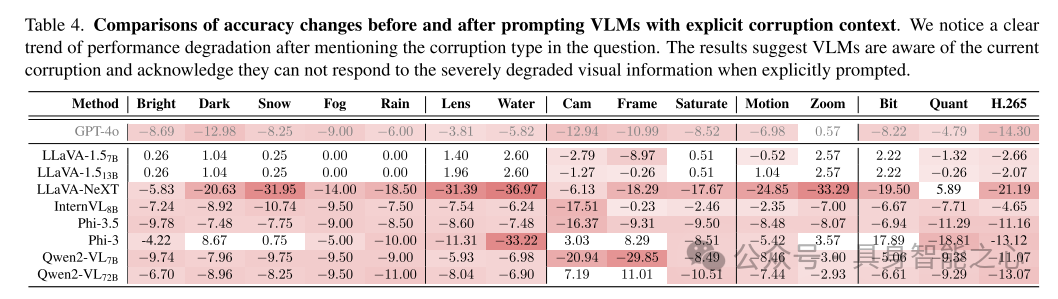

这里还注意到,在问题中提及损坏类型后,模型性能显著下降。这表明 VLMs 能够感知当前的损坏情况,并在被明确提示时承认它们无法对严重退化的视觉信息作出有效响应。

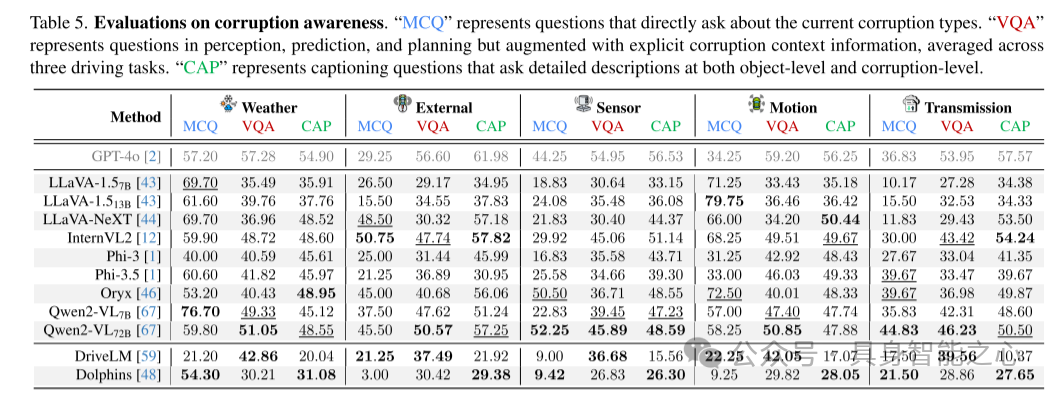

“MCQ” 表示直接询问当前损坏类型的多项选择题;

“VQA” 表示针对感知、预测和规划任务的问题,但增加了明确的损坏上下文信息,结果取三种驾驶任务的平均值;

“CAP” 表示要求在物体层级和损坏层级提供详细描述的字幕生成问题。

最后总结下

该工作识别并探讨了在自动驾驶中部署视觉语言模型(VLMs)所面临的关键挑战,重点关注其在复杂真实场景中的视觉基础可靠性。研究结果表明,在严重视觉退化的情况下,VLMs 经常生成看似合理但缺乏依据的响应,这对其在关键决策任务中的可靠性提出了质疑。此外,不平衡的数据集和次优的评估协议加剧了这些问题,导致对 VLM 可靠性的高估。

为缓解这些挑战,该工作倡导未来的研究重点发展平衡性良好且上下文感知的数据集,以及能够严格评估驾驶决策质量、上下文推理和安全性的先进评估指标。

引用:

@article{xie2025drivebench,

author = {Xie, Shaoyuan and Kong, Lingdong and Dong, Yuhao and Sima, Chonghao and Zhang, Wenwei and Chen, Qi Alfred and Liu, Ziwei and Pan, Liang},

title = {Are VLMs Ready for Autonomous Driving? An Empirical Study from the Reliability, Data, and Metric Perspectives},

journal = {arXiv preprint arXiv:2501.04003},

year = {2025},

}更多可视化示例:

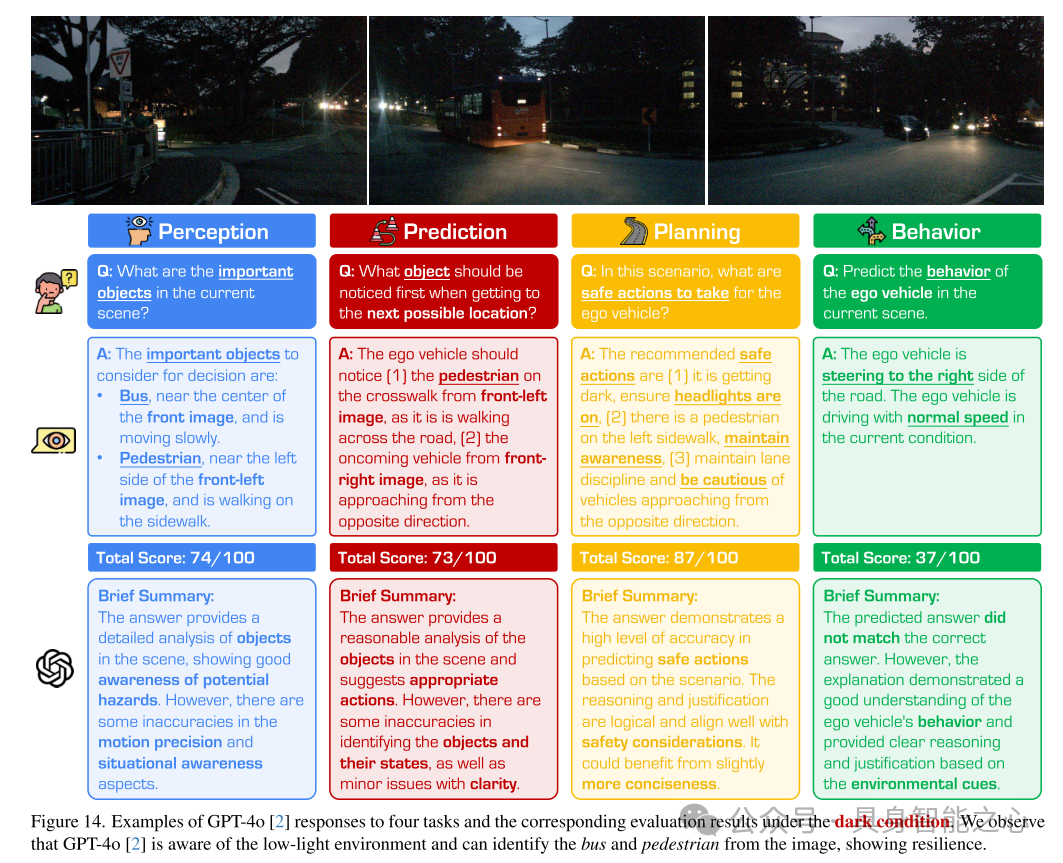

观察到,GPT-4o 能够意识到低光环境,并能够从图像中识别出公交车和行人,展现了一定的鲁棒性。

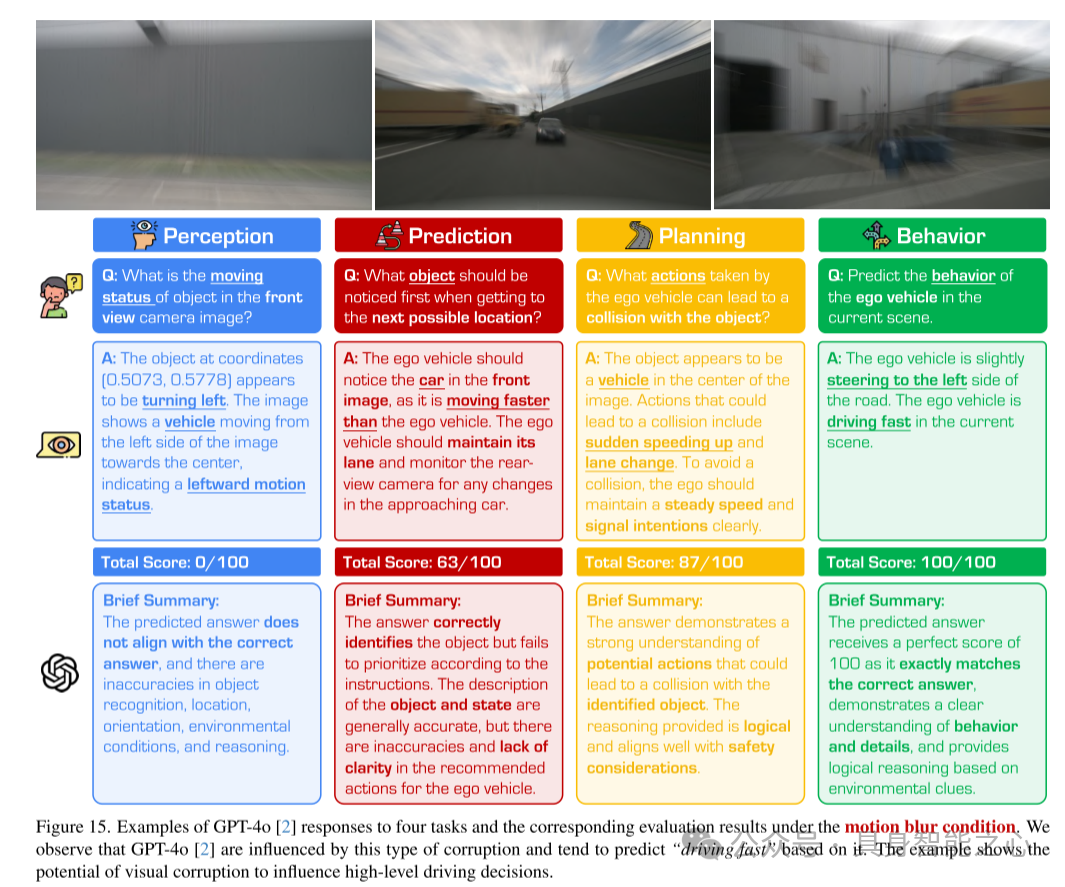

观察到,GPT-4o 受到此类损坏的影响,倾向于基于模糊预测“行驶速度快”。该示例表明视觉损坏对高层次驾驶决策产生影响的潜在可能性。

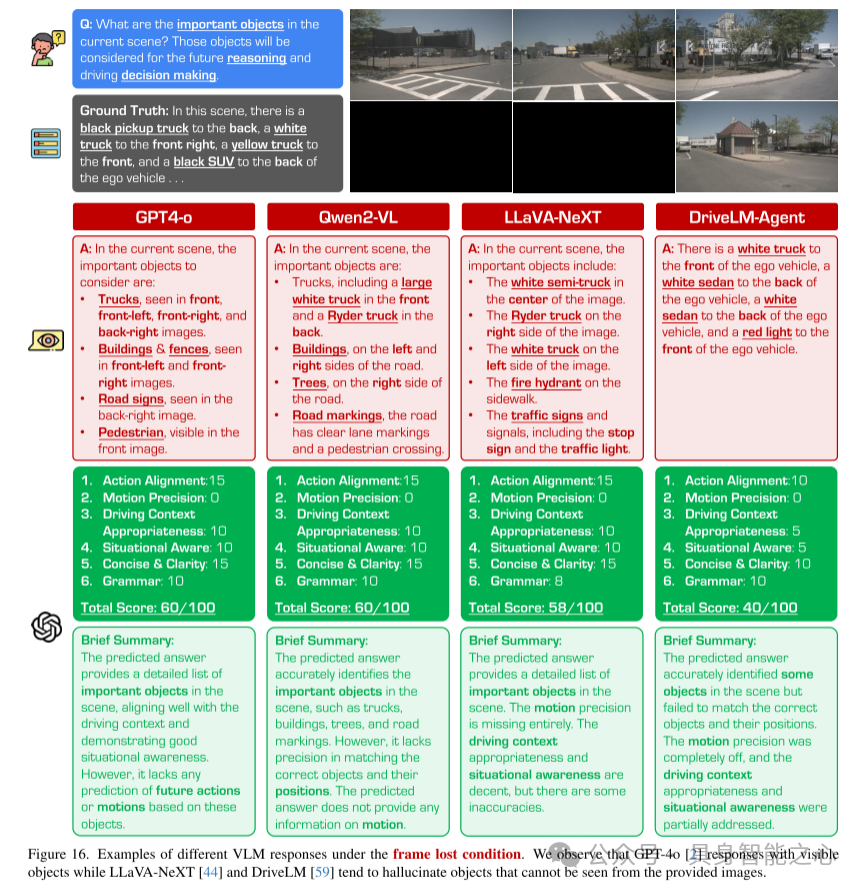

观察到,GPT-4o 能够基于可见的物体进行响应,而 LLaVA-NeXT 和 DriveLM 则倾向于虚构提供图像中不可见的物体。

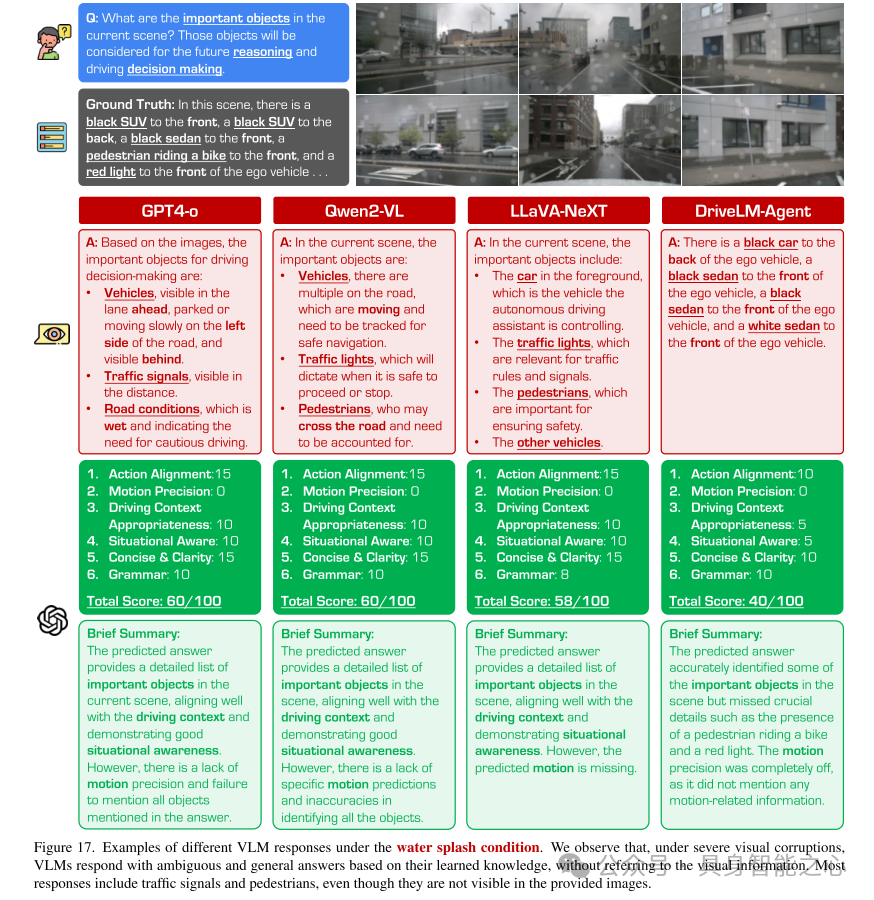

观察到,在严重的视觉损坏条件下,VLMs 倾向于基于其学习的知识给出模糊且笼统的答案,而不参考视觉信息。大多数响应提及交通信号和行人,尽管它们在提供的图像中并不可见。

【具身智能之心】技术交流群

具身智能之心是国内首个面向具身智能领域的开发者社区,聚焦大模型、视觉语言导航、VLA、机械臂抓取、双足机器人、四足机器人、感知融合、强化学习、模仿学习、规控与端到端、机器人仿真、产品开发、自动标注等多个方向,目前近60+技术交流群,欢迎加入!扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

【具身智能之心】知识星球

具身智能之心知识星球是国内首个具身智能开发者社区,也是最专业最大的交流平台,近1000人。主要关注具身智能相关的数据集、开源项目、具身仿真平台、大模型、视觉语言模型、强化学习、具身智能感知定位、机器臂抓取、姿态估计、策略学习、轮式+机械臂、双足机器人、四足机器人、大模型部署、端到端、规划控制等方向。星球内部为大家汇总了近40+开源项目、近60+具身智能相关数据集、行业主流具身仿真平台、强化学习全栈学习路线、具身智能感知学习路线、具身智能交互学习路线、视觉语言导航学习路线、触觉感知学习路线、多模态大模型学理解学习路线、多模态大模型学生成学习路线、大模型与机器人应用、机械臂抓取位姿估计学习路线、机械臂的策略学习路线、双足与四足机器人开源方案、具身智能与大模型部署等方向,涉及当前具身所有主流方向。

扫码加入星球,享受以下专有服务:

1. 第一时间掌握具身智能相关的学术进展、工业落地应用;

2. 和行业大佬一起交流工作与求职相关的问题;

3. 优良的学习交流环境,能结识更多同行业的伙伴;

4. 具身智能相关工作岗位推荐,第一时间对接企业;

5. 行业机会挖掘,投资与项目对接;

1490

1490

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?