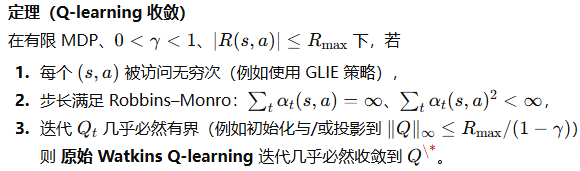

下面给出 Q-learning 收敛性的一个严谨证明(针对有限状态—动作集合、贴现因子、有界奖励)。证明路线遵循“压缩映射 + 随机逼近(stochastic approximation)/ODE 法”,并兼顾异步坐标更新的事实。所用到的关键工具是:Bellman 最优算子是

范数下的压缩、Robbins–Monro 步长条件、鞅差噪声与异步随机逼近的收敛定理

1. 设定与假设:

注:实际常见的“GLIE”策略(渐近贪心且每个 (s,a) 无穷次被探索)可保证 (A1)。

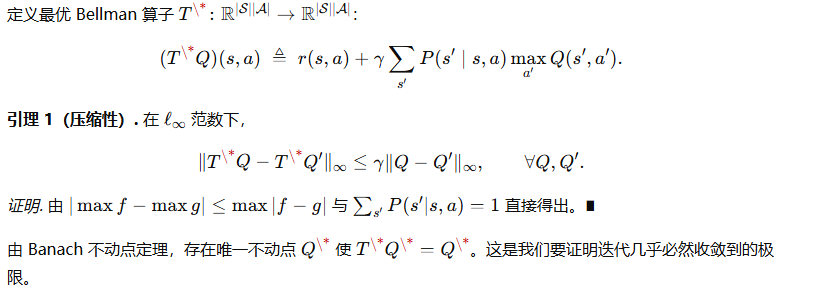

2. Bellman 最优算子与不动点:

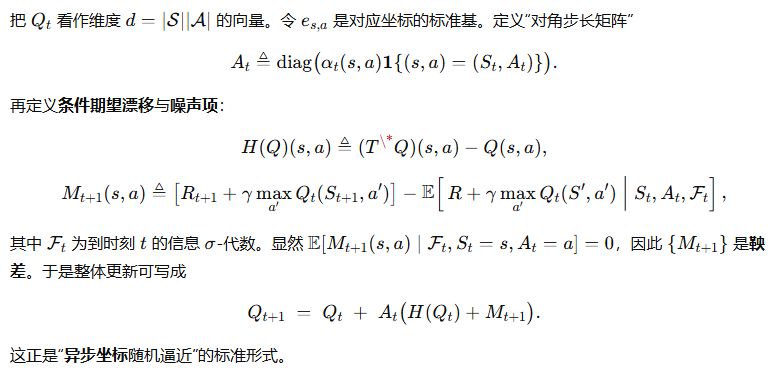

3. 将 Q-learning 写成“异步随机逼近”

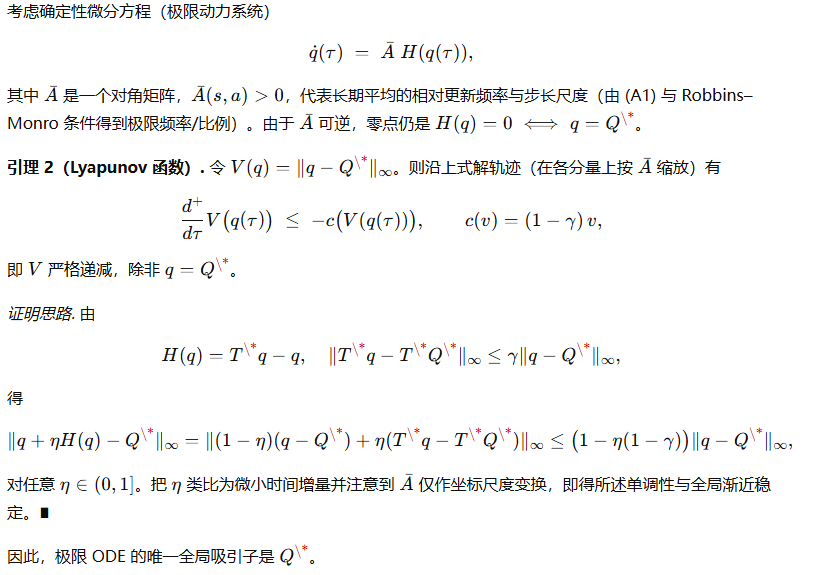

4. 极限 ODE 与全局渐近稳定:

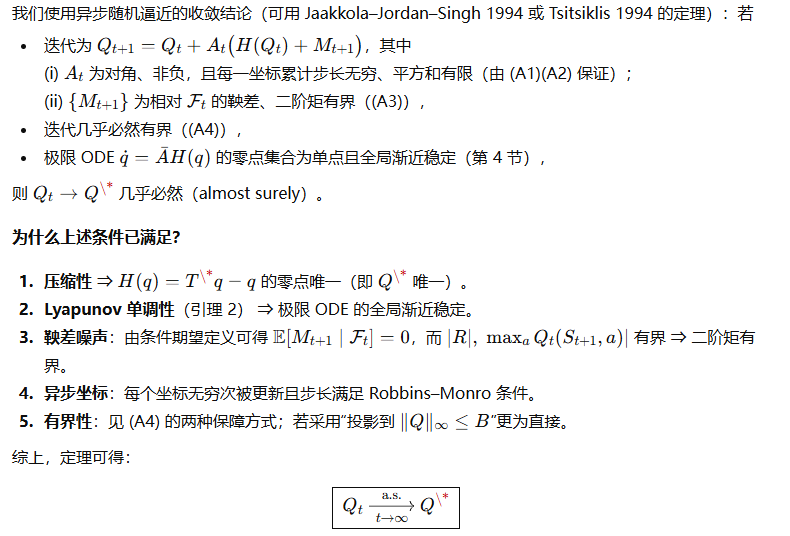

5. 随机逼近收敛定理的应用

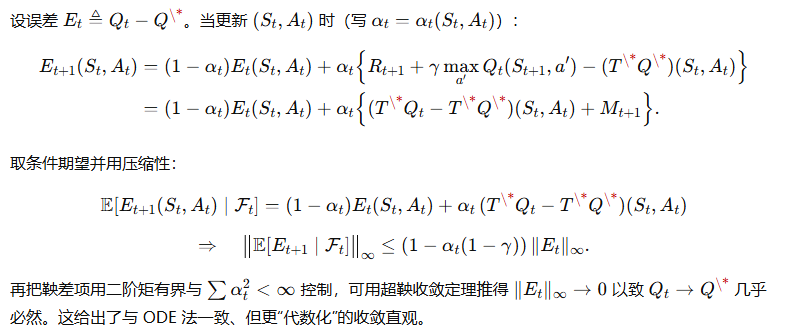

6. 用更“可计算”的不等式再看一眼(误差的超鞅收缩)

35

35

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?