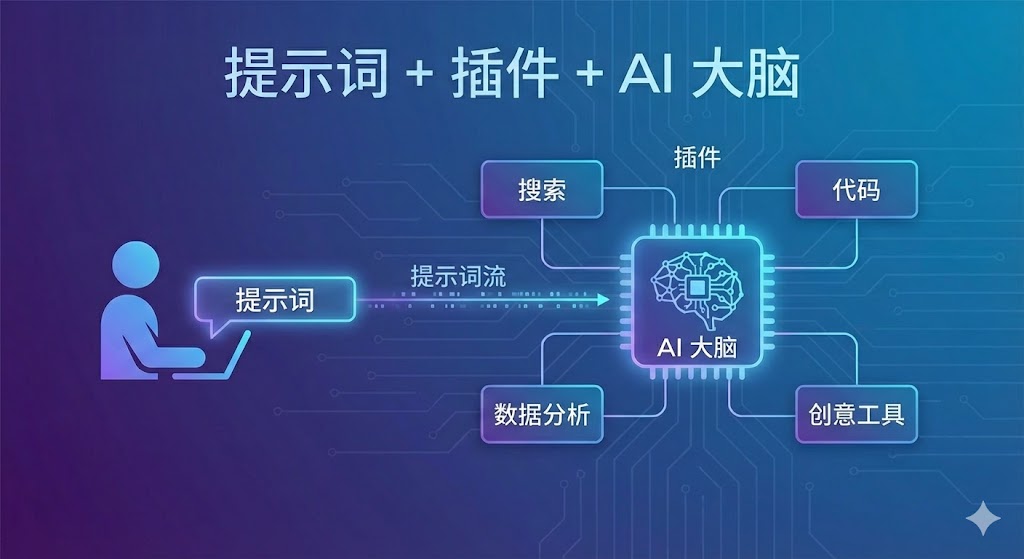

随着大模型能力不断增强,提示词(Prompt)已经成为人与 AI 之间最关键的“接口”。同样的问题,不同的提示词,往往会带来完全不同的结果。

而当提示词与插件(Plugins)结合使用时,AI 不再只是“回答问题”,而是可以真正参与到搜索、计算、自动化执行等复杂任务中。

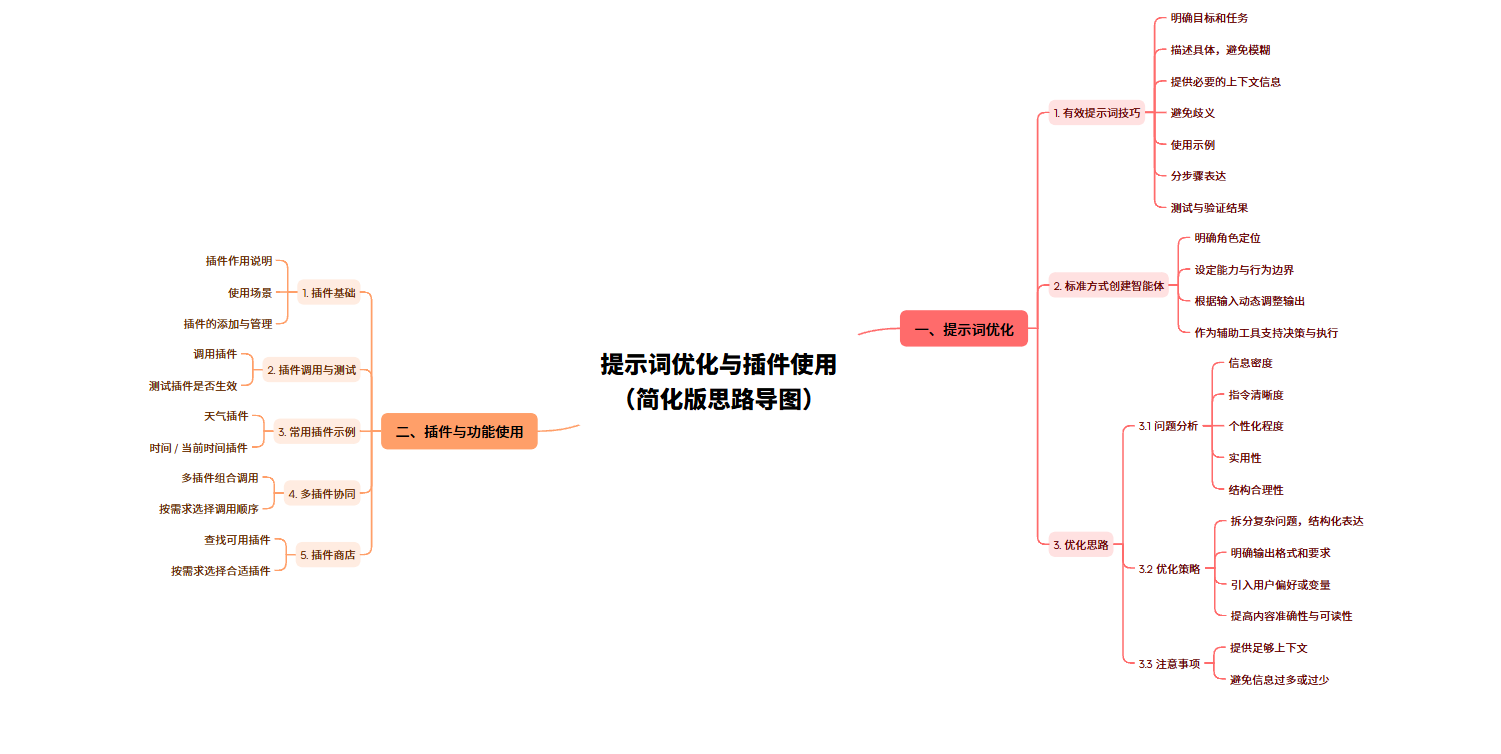

本文结构基于如下思维导图展开:

本文将从 提示词优化 和 插件与功能使用 两大方面,系统梳理一套可落地、可复用的方法论,帮助你从“能用 AI”,进阶到“用好 AI”。

第一部分:提示词优化——打造智能体的“最强大脑”

提示词(Prompt)不仅是与LLM对话的文字,更是智能体的“源代码”。根据思维导图,我们将优化思路分为三个体系:

1.有效提示词的七大黄金法则

很多时候模型表现不佳,并不是模型不够聪明,而是指令不够清晰。编写提示时应遵循以下技巧:

-

明确的目标与任务:用动词开场,直接告诉模型“做什么”。

-

模糊拒绝,描述具体:将“写一篇文章好”改为“写一篇包含三个论点、语气幽默的800字科技评论”。

-

提供必要的背景:背景信息是模型推理的基础。

-

消除歧义:使用专业术语或明确的限制条件,锁死模型的路径理解。

-

Few-Shot(使用示例):给出了两个理想的问答范例,使模型样式和逻辑。

-

步骤分表达(CoT):针对复杂任务,引导模型“一步思考”。

-

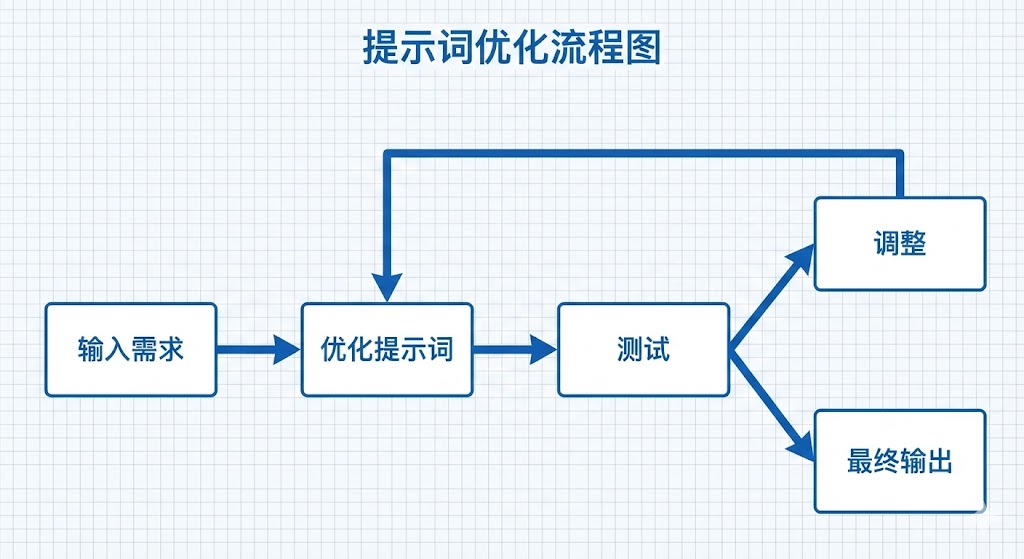

与验证:不要指望一次成功,通过迭代测试修复测试提示。

2. 标准化构建智能体

当我们把迅速上升到Agent层面时,需要建立一套标准化的定义框架:

-

角色定位(Role):你是一位拥有10年经验的Python架构师。

-

能力与边界(Boundaries):明确模型能做什么,更要明确不能做什么(防止幻觉)。

-

动态调整:设计及时要装备指标,根据用户输入动态调整策略输出。

3.进阶优化策略:重构思维

要让智能体的回复具有工程级的水准,我们需要关注以下维度:

-

信息密度与积分:在有限的代币内交付高价值信息。

-

结构合理性:通过Markdown、Json等格式明确输出要求。

-

引入变量:将用户偏好(User Preference)作为变量嵌入提示,实现千人千面的个性化回复。

实战技巧:在提示符末尾添加“请检查上述内容是否遗漏,并确保符合输出格式”,可以显着提高内容的准确性和准确性。

第二部分:插件与功能使用——赋予智能体“执行力”

如果说 Prompt 是思维,那么插件(Plugins)就是智能体连接真实世界的桥梁。

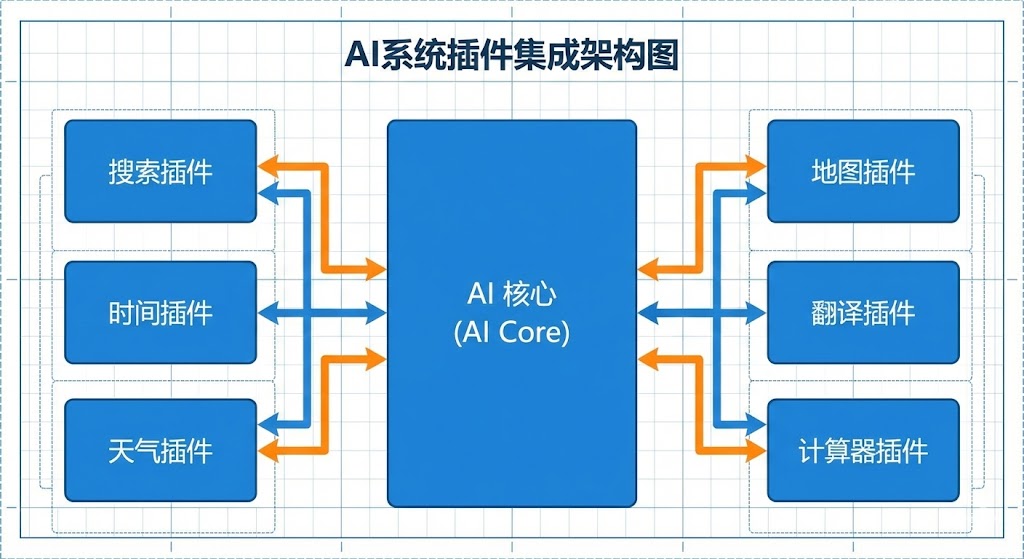

1.插件基础与调用机制

插件的本质是API的封装。在智能体开发平台(如Coze、GPTs)中,配置插件需要注意:

-

作用说明:清晰描述插件的功能,这是大模型决定“何时调用”的关键依据。

-

使用场景:明确告诉模型在什么情况下应该触发该工具。

-

测试生效:配置完成后,必须通过调试模式验证模型能否正确提取参数并调用接口。

下列以COZE平台为例:

2. 常用插件实战

对于初学者,建议从入门基础工具开始:

-

信息查询类:如“天气插件”、“时间/当前时间插件”。此类插件能补充大模型数据滞后的短板。

-

数据处理类:搜索工具、计算器等。

3. 多插件好(Orchestration)

这是智能体开发的高级领域。当用户需求复杂时,需要依次选择调用顺序:

-

调用串行:先调用“搜索插件”获取信息,再调用“分析插件”处理数据。

-

工件调用:同时调用多个数据源进行比对。

-

智能路由:模型根据用户偏好,自主去“插件商店”查找并选择最合适的组合。

总结

提示词优化 + 插件良好 = 强大的 AI 智能体。

-

提示词解决了“理解”与“规划”的问题,通过分解复杂问题和表述表达,保证了产出质量。

-

插件解决了“时效性”与“执行”的问题,让 AI 从聊天机器人进化为任务执行者。

937

937