【李宏毅机器学习笔记】5、Logistic Regression

【李宏毅机器学习笔记】6、简短介绍Deep Learning

【李宏毅机器学习笔记】7、反向传播(Backpropagation)

【李宏毅机器学习笔记】8、Tips for Training DNN

【李宏毅机器学习笔记】9、Convolutional Neural Network(CNN)

【李宏毅机器学习笔记】10、Why deep?(待填坑)

【李宏毅机器学习笔记】11、 Semi-supervised

【李宏毅机器学习笔记】 12、Unsupervised Learning - Linear Methods

【李宏毅机器学习笔记】 13、Unsupervised Learning - Word Embedding(待填坑)

【李宏毅机器学习笔记】 14、Unsupervised Learning - Neighbor Embedding(待填坑)

【李宏毅机器学习笔记】 15、Unsupervised Learning - Auto-encoder(待填坑)

【李宏毅机器学习笔记】 16、Unsupervised Learning - Deep Generative Model(待填坑)

【李宏毅机器学习笔记】 17、迁移学习(Transfer Learning)

【李宏毅机器学习笔记】 18、支持向量机(Support Vector Machine,SVM)

【李宏毅机器学习笔记】 19、Structured Learning - Introduction(待填坑)

【李宏毅机器学习笔记】 20、Structured Learning - Linear Model(待填坑)

【李宏毅机器学习笔记】 21、Structured Learning - Structured SVM(待填坑)

【李宏毅机器学习笔记】 22、Structured Learning - Sequence Labeling(待填坑)

【李宏毅机器学习笔记】 23、循环神经网络(Recurrent Neural Network,RNN)

------------------------------------------------------------------------------------------------------

【李宏毅深度强化学习】视频地址:https://www.bilibili.com/video/av10590361?p=31

课件地址:http://speech.ee.ntu.edu.tw/~tlkagk/courses_ML16.html

-------------------------------------------------------------------------------------------------------

Outline

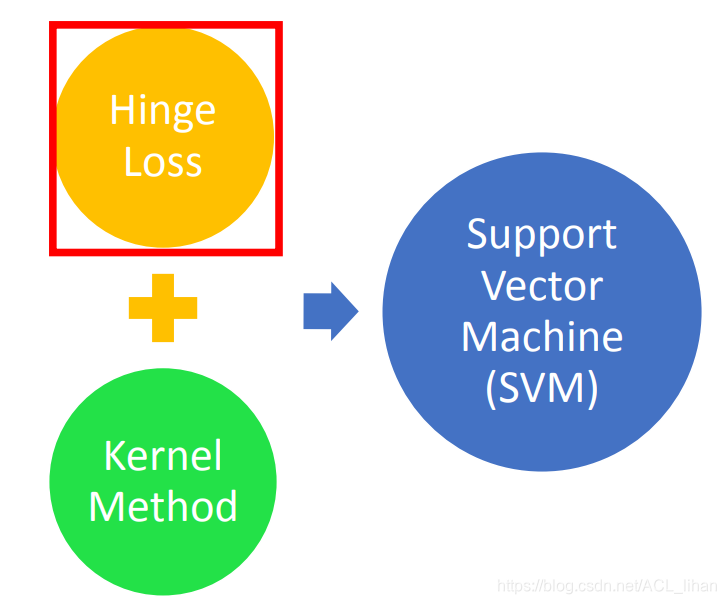

SVM有两个特色,分别是Hinge Loss和Kernel Method。两者加起来就是SVM。

Hinge Loss

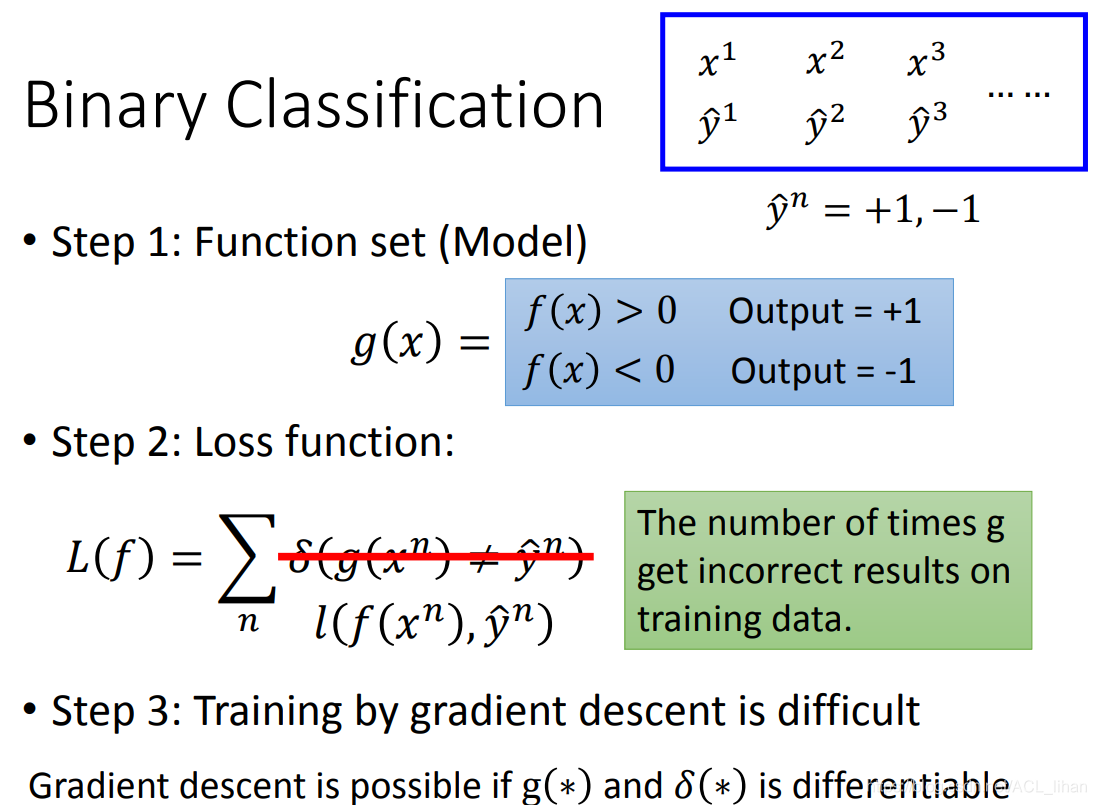

之前说过,机器学习大体分三步。上图以二分类为例。

第二步原本的loss function是:如果预测结果 正确,则等于0。如果预测结果错误,则等于1 。把这些结果累加起来就是loss function 。但是这样的做法,loss function是不可微的。所以需要换用

![]() 来近似刚才的做法。

来近似刚才的做法。

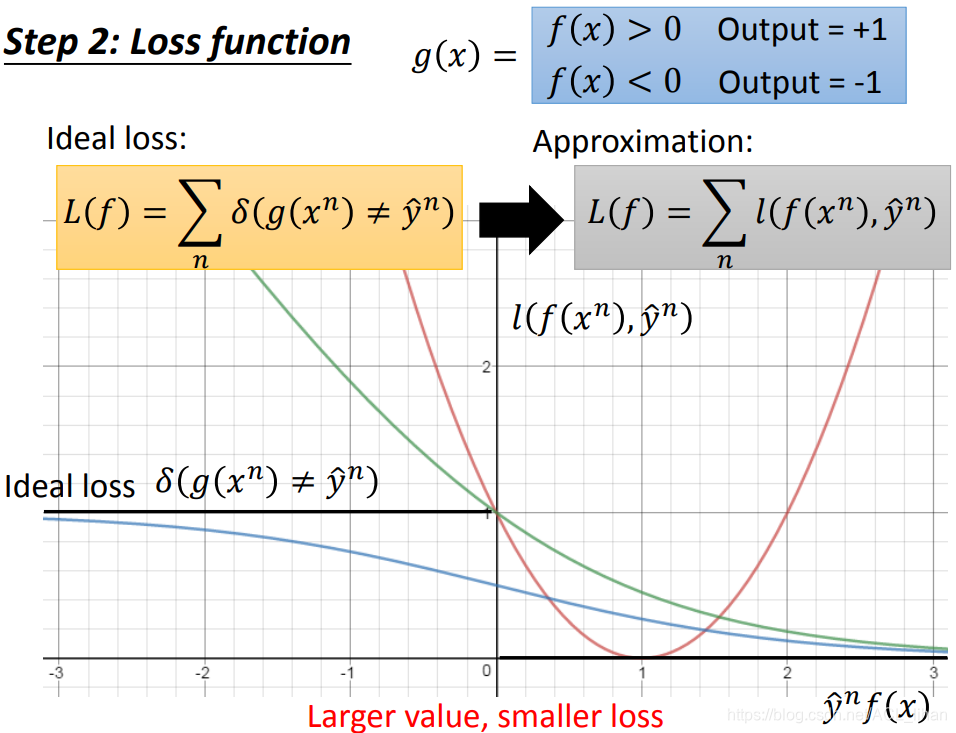

下面是几种![]() 的图像。

的图像。

- 绿线代表Sigmoid + cross entropy

- 蓝线代表Sigmoid + Square loss

- 红线代表Square loss

y\hat有+1和-1两种结果。

这个loss function定义为:预测的结果 f(x) 和真正的结果y\hat 同号的话,则f(x)越趋于无穷的方向的话,loss 越低。

接下来看看采用不同函数来做loss function的表现如何

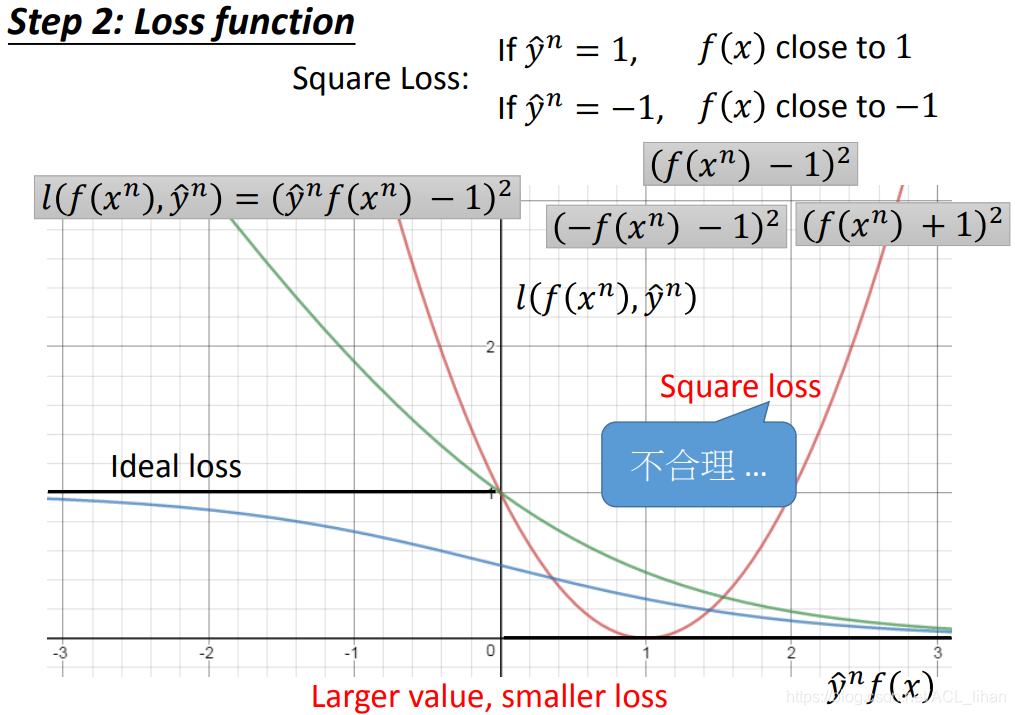

Square loss

这里要说的是Square loss(上图的红线):![]()

如果用Square loss,则

- 当

时,希望预测结果

时,希望预测结果

- 当

SVM详解与Kernel Trick

SVM详解与Kernel Trick

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1233

1233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?