一、背景介绍

1.1 爬取目标

熟悉我的小伙伴都了解,我之前开发过2款软件:

【GUI软件】小红书搜索结果批量采集,支持多个关键词同时抓取!

【GUI软件】小红书详情数据批量采集,含笔记内容、转评赞藏等!

现在介绍的这个软件,相当于以上2个软件的结合版,即根据关键词爬取笔记的详情数据。

开发界面软件的目的:方便不懂编程代码的小白用户使用,无需安装python,无需改代码,双击打开即用!

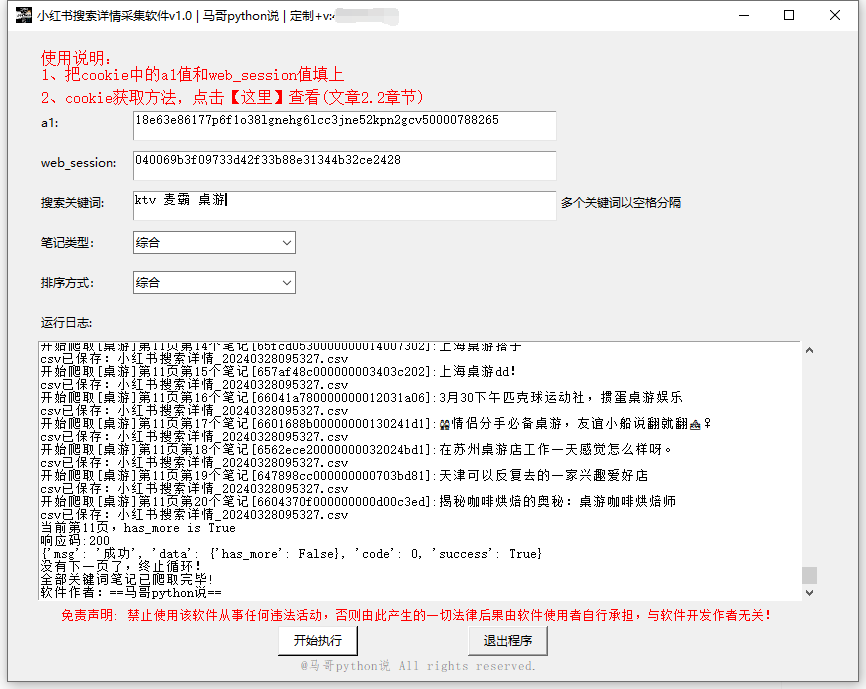

软件界面截图:

爬取结果截图:

1.2 演示视频

软件使用演示:(不懂编程的小白直接看视频,了解软件作用即可,无需看代码)

演示视频:

【软件演示】爬小红薯搜索详情软件

1.3 软件亮点说明

几点说明:

二、代码讲解

2.1 爬虫采集-搜索接口

首先,定义接口地址作为请求地址:

# 请求地址

url = 'https://edith.xiaohongshu.com/api/sns/web/v1/search/notes'

2.2 爬虫采集-详情接口

首先,定义接口地址作为请求地址:

# 请求地址

url = 'https://edith.xiaohongshu.com/api/sns/web/v1/feed'

2.3 两接口逻辑同理

定义一个请求头,用于伪造浏览器:

# 请求头

h1 = {

'Accept': 'application/json, text/plain, */*',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8,en-GB;q=0.7,en-US;q=0.6',

'Content-Type': 'application/json;charset=UTF-8',

'Cookie': '换成自己的cookie值',

'Origin': 'https://www.xiaohongshu.com',

'Referer': 'https://www.xiaohongshu.com/',

'Sec-Ch-Ua': '"Microsoft Edge";v="119", "Chromium";v="119", "Not?A_Brand";v="24"',

'Sec-Ch-Ua-Mobile': '?0',

'Sec-Ch-Ua-Platform':

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?