一、传统TF-IDF算法原理与示例

1. 基本概念

TF-IDF(Term Frequency-Inverse Document Frequency)是一种用于信息检索和文本挖掘的常用加权技术,用于评估一个词语对某篇文章的重要程度 。它由两部分组成:TF(词频)和IDF(逆文档频率)。

TF(词频):表示词语在文档中的出现频率,计算公式为:

TF(t,d) = (词语t在文档d中出现的次数) / (文档d的总词语数)

IDF(逆文档频率):表示词语在整个文档集合中的罕见程度,计算公式为:

IDF(t,D) = log(文档集合D中的总文档数 / (包含词语t的文档数 + 1))

TF-IDF权重:是TF和IDF的乘积,表示词语对文档的重要性:

TF-IDF(t,d,D) = TF(t,d) × IDF(t,D)

2. 示例说明

假设我们有两个文档:

- 文档A:“机器学习是人工智能的核心方法”

- 文档B:“深度学习是实现人工智能的关键技术”

首先,我们需要对这些文档进行分词处理(这里已经完成):

- 文档A的词语:机器学习, 是, 人工智能, 的, 核心, 方法;

- 文档B的词语:深度学习, 是, 实现, 人工智能, 的, 关键, 技术;

接下来计算TF值:

对于文档A中的"人工智能":

- TF(“人工智能”,A) = 1/6 ≈ 0.1667

对于文档B中的"人工智能":

- TF(“人工智能”,B) = 1/7 ≈ 0.1429

然后计算IDF值:假设整个语料库有10个文档,其中包含"人工智能"的文档有2个。

- IDF(“人工智能”) = log(10/(2+1)) = log(10/3) ≈ 1.0986

最后计算TF-IDF权重:

文档A中"人工智能"的TF-IDF权重:

- 0.1667 × 1.0986 ≈ 0.1833

文档B中"人工智能"的TF-IDF权重:

- 0.1429 × 1.0986 ≈ 0.1569

通过这种方式,我们可以为每个词语在文档中的重要性赋予权重。在文档相似度计算中,这些权重会构成文档的向量表示,然后通过余弦相似度等方法计算文档之间的相似程度。

二、Soft TF-IDF算法与传统TF-IDF的区别

1. "Soft"概念的含义

Soft TF-IDF中的"Soft"主要体现在两个方面:

权重计算的平滑处理:对TF和IDF的计算进行平滑处理,避免极端权重值,使权重分布更加均匀和稳定。

相似度判断的软化策略:在计算文本相似度时,采用动态阈值或加权策略,而非简单的二元判断(相似或不相似),使相似度判断更加灵活和准确。

2. 主要区别

|

特性 |

传统TF-IDF |

Soft TF-IDF |

|

TF计算 |

直接使用词频除以文档总词数 |

可能使用对数变换或非线性函数平滑 |

|

IDF计算 |

log(总文档数/(包含该词的文档数+1)) |

使用平滑公式如log((总文档数+1)/(包含该词的文档数+1)) +1 |

|

权重调整 |

无特殊调整 |

可能结合词长度、领域重要性等因素 |

|

相似度判断 |

直接使用余弦相似度 |

可能设定动态阈值或采用加权策略 |

三、Soft TF-IDF算法原理步骤与示例

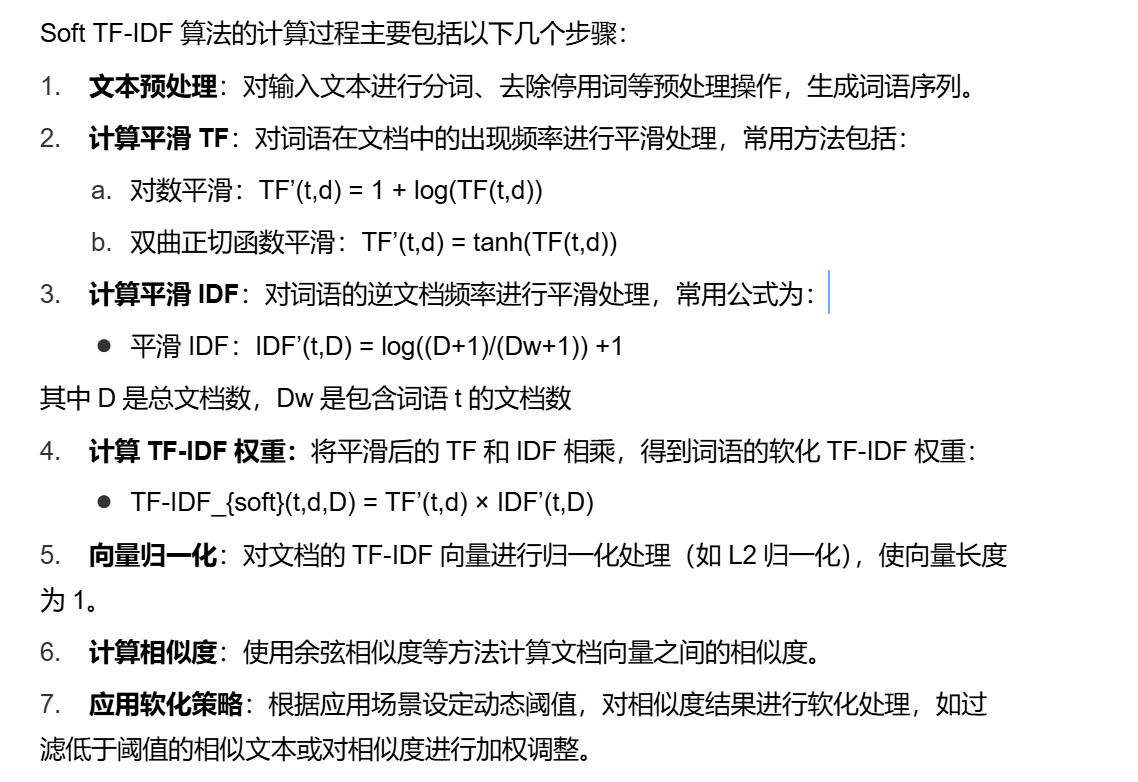

1. 算法原理步骤

我们仍然使用之前的两个文档进行示例:

文档A:“机器学习是人工智能的核心方法”

文档B:“深度学习是实现人工智能的关键技术”

假设语料库共有5个文档,其中包含"人工智能"的文档有2个。

步骤1:计算TF值

文档A中"人工智能"的TF值:

TF(“人工智能”,A) = 1/6 ≈ 0.1667

文档B中"人工智能"的TF值:

TF(“人工智能”,B) = 1/7 ≈ 0.1429

步骤2:计算平滑TF值

使用对数平滑:

TF’(“人工智能”,A) = 1 + log(1) = 1

TF’(“人工智能”,B) = 1 + log(1) = 1

步骤3:计算平滑IDF值

IDF’(“人工智能”) = log((5+1)/(2+1)) +1 = log(6/3) +1 = log(2) +1 ≈ 0.3010 +1 = 1.3010

步骤4:计算TF-IDF权重

文档A中"人工智能"的TF-IDF_{soft}权重:

1 × 1.3010 ≈ 1.3010

文档B中"人工智能"的TF-IDF_{soft}权重:

1 × 1.3010 ≈ 1.3010

步骤5:构建TF-IDF向量

假设我们的词汇表包含:机器学习, 深度学习, 是, 人工智能, 的, 核心, 方法, 实现, 关键, 技术。

文档A的TF-IDF向量:

[0.25, 0, 1.3010, 1.3010, 0.25, 1.3010, 1.3010, 0, 0, 0]

文档B的TF-IDF向量:

[0, 0.25, 1.3010, 1.3010, 0.25, 0, 0, 0.25, 1.3010, 1.3010]

步骤6:计算余弦相似度

余弦相似度 = (向量A · 向量B) / (|向量A| × |向量B|)

计算(向量A · 向量B)点积:

0×0 + 0.25×0.25 + 1.3010×1.3010 + 1.3010×1.3010 + 0.25×0.25 + 1.3010×0 + 1.3010×0 + 0×0.25 + 0×1.3010 + 0×1.3010 = 0 + 0.0625 + 1.6926 + 1.6926 + 0.0625 + 0 + 0 + 0 + 0 + 0 = 3.5102

计算向量长度:

|向量A| = √(0² + 0.25² + 1.3010² + 1.3010² + 0.25² + 1.3010² + 1.3010² + 0² + 0² + 0²) ≈ √(0 + 0.0625 + 1.6926 + 1.6926 + 0.0625 + 1.6926 + 1.6926 + 0 + 0 + 0) ≈ √(7.3954) ≈ 2.7194

|向量B| = √(0.25² + 0² + 1.3010² + 1.3010² + 0.25² + 0² + 0² + 0.25² + 1.3010² + 1.3010²) ≈ √(0.0625 + 0 + 1.6926 + 1.6926 + 0.0625 + 0 + 0 + 0.0625 + 1.6926 + 1.6926) ≈ √(7.3954) ≈ 2.7194

余弦相似度 = 3.5102 / (2.7194 × 2.7194) ≈ 3.5102 / 7.3954 ≈ 0.475

步骤7:应用软化策略

假设我们设定相似度阈值为0.5,那么这两个文档的相似度为0.475,低于阈值,判定为不相似。

但如果我们将阈值设为0.4,则判定为相似。这种动态阈值的设定就是"Soft"策略的一种体现。

四、Soft TF-IDF算法数学公式总结

1. 平滑TF计算公式

对数平滑TF:

TF’(t,d) = 1 + log(TF(t,d))

双曲正切函数平滑TF:

TF’(t,d) = tanh(TF(t,d))

二值化TF(适用于短文本):

TF’(t,d) = 1 如果词语t在文档d中出现,否则为0。

2. 平滑IDF计算公式

标准IDF:

IDF(t,D) = log(D/Dw)

平滑IDF:

IDF’(t,D) = log((D+1)/(Dw+1)) +1

概率IDF:

IDF’(t,D) = log((D - Dw)/Dw)

3. TF-IDF权重计算公式

软化TF-IDF权重:

TF-IDF_{soft}(t,d,D) = TF’(t,d) × IDF’(t,D)

4. 文档相似度计算公式

余弦相似度:

Similarity = (向量A · 向量B) / (|向量A| × |向量B|)

加权余弦相似度(可选):

Similarity = (向量A · 向量B) / (|向量A| × |向量B|) × 权重系数

5. 动态阈值过滤策略

相似度阈值判断:

如果 Similarity > δ,则判定为相似文档,否则为不相似其中δ是一个动态调整的阈值,通常在0.5到0.9之间,根据具体应用场景进行调整。

五、Soft TF-IDF算法的应用场景

1. 文本去重

Soft TF-IDF在文本去重领域有广泛应用,特别是在处理大规模语料库时 。例如在"Soft Deduping"方法中,通过计算文本之间的TF-IDF相似度,设定一个动态阈值(如0.8),高于此阈值的文本被判定为重复内容并被删除。这种方法相比传统的二元判断(完全重复或不重复)更为灵活,能够根据文本相似度的高低进行分级处理。

2. 内容相似度检测

在内容推荐系统、抄袭检测、信息聚合等场景中,Soft TF-IDF能够提供更精确的文本相似度判断。例如在广告数据清洗中,可以通过设定相似度阈值(如0.7)来筛选出同一分类但在商品描述方面却不大相同的广告,为后续的广告文案策划提供参考 。

3. 文本分类与聚类

在文本分类和聚类任务中,Soft TF-IDF通过对权重的平滑处理,能够减少噪声词的影响,提高分类和聚类的准确性 。特别是在处理短文本或领域特异性文本时,这种平滑处理尤为重要。

六、Soft TF-IDF算法的优势与局限性

1. 主要优势

计算效率高:Soft TF-IDF基于向量空间模型,计算速度快,适合处理大规模文本数据。

可解释性强:权重计算过程清晰透明,便于理解哪些词语对文档的重要性更高。

灵活性强:通过动态阈值和权重平滑策略,能够根据不同应用场景调整相似度判断的标准。

抗噪声能力强:对高频噪声词(如某些专业领域内的通用词)的敏感度较低,能够更准确地反映文本的核心内容。

2. 局限性

不考虑语义关系:Soft TF-IDF仍然是一种基于词频的统计方法,无法捕捉词语之间的语义关系和上下文信息。

无法处理一词多义:对于具有多重含义的词语,无法根据上下文确定其具体含义。

维度爆炸问题:当词汇表过大时,TF-IDF向量的维度也会相应增加,导致计算复杂度提高。

阈值设定主观性:相似度阈值的设定具有一定主观性,需要根据具体应用场景进行调整和验证。

七、总结

Soft TF-IDF相似度算法是传统TF-IDF方法的一种优化应用,它通过引入权重平滑和相似度软化策略,使文本相似度计算更加灵活和准确。虽然Soft TF-IDF并非独立算法,而是对传统TF-IDF的改进,但它在文本去重、内容相似度检测和文本分类等场景中表现出色,能够有效解决传统方法在极端情况下的不稳定性问题。

在实际应用中,可以通过调整TF和IDF的平滑方法、向量归一化策略以及相似度阈值,来优化Soft TF-IDF算法的性能,使其更好地适应不同领域的文本分析需求。随着深度学习和预训练语言模型的发展,Soft TF-IDF可能会与其他技术结合,形成更加完善的文本相似度计算方法。

3060

3060

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?