1 聚类算法简介

1.1 认识聚类算法

什么是聚类算法?

-

根据样本之间的相似性,将样本划分到不同的类别中;不同的相似度计算方法,会得到不同的聚类结果,常用的相似度计算方法有欧式距离法。

-

聚类算法的目的是在没有先验知识的情况下,自动发现数据集中的内在结构和模式。

-

无监督学习算法

使用不同的聚类准则,产生的聚类结果不同。

1.1.1 聚类算法在现实中的应用

用户画像,广告推荐,Data Segmentation,搜索引擎的流量推荐,恶意流量识别

基于位置信息的商业推送,新闻聚类,筛选排序

图像分割,降维,识别;离群点检测;信用卡异常消费;发掘相同功能的基因片段

1.1.2 聚类算法的概念

聚类算法:

一种典型的 无监督 学习算法,主要用于将相似的样本自动归到一个类别中。

在聚类算法中根据样本之间的相似性,将样本划分到不同的类别中,对于不同的相似度计算方法,会得到不同的聚类结果,常用的相似度计算方法有欧式距离法。

1.1.3 聚类算法与分类算法最大的区别

- 聚类算法是无监督的学习算法,而分类算法属于监督的学习算法。

- 聚类最常使用,在对数据进行最初处理的时候,没有先验信息,可以使用聚类算法,给样本进行添加标签。

1.1.4 聚类算法分类

-

根据聚类颗粒度进行分类

-

根据实现方法分类

-

K-means:按照质心分类,主要介绍K-means,通用、普遍

-

层次聚类:对数据进行逐层划分,直到达到聚类的类别个数

-

DBSCAN聚类是一种基于密度的聚类算法

-

谱聚类是一种基于图论的聚类算法

-

1.2. 小结

聚类的定义

- 一种典型的无监督学习算法

- 主要用于将相似的样本自动归到一个类别中

- 计算样本和样本之间的相似性,一般使用欧式距离

聚类与分类算法的区别

- 聚类是无监督学习算法,训练数据不需要标签,分类算法属于监督学习算法

2 Kmeans API的使用

2.1 KMeans API介绍

sklearn.cluster.KMeans(n_clusters=8)

- 参数:n_clusters:开始的聚类中心数量,整型,默认值是8,生成聚类数,即产生的质心(centroids)数

- 方法

estimator.fit(x)

estimator.predict(x)

# 训练和预测采用的数据集都是一样的

estimator.fit_predict(x)# 相当于先调用fit(x),然后再调用predict(x)

2.2 Kmeans案例

随机创建不同二维数据集作为训练集,并结合k-means算法将其聚类,你可以尝试分别聚类不同数量的簇,并观察聚类效果:

聚类参数n_cluster传值不同,得到的聚类结果不同

2.2.1流程分析

2.2.2 代码实现

1.创建数据集

import matplotlib.pyplot as plt

from sklearn.datasets.samples_generator import make_blobs

from sklearn.cluster import KMeans

from sklearn.metrics import silhouette_score

# 创建数据集

# X为样本特征,Y为样本簇类别, 共1000个样本,每个样本2个特征,共4个簇,60

# 簇中心在[-1,-1], [0,0],[1,1], [2,2], 簇方差分别为[0.4, 0.2, 0.2, 0.2]

# n_samples - 样本数

# n_feature - 特征个数

# centers = [] - 指定中心点坐标

# cluster_std - 设置标准差

# 返回X - 样本数据 和 y 分类标签

X, y = make_blobs(n_samples=1000, n_features=2, centers=[[-1, -1], [0, 0], [1, 1], [2, 2]],

cluster_std=[0.4, 0.2, 0.2, 0.2],

random_state=9)

# 数据集可视化

# 查看X的两个特征之间的分布

plt.scatter(X[:, 0], X[:, 1], marker='o')

plt.show()

2.使用k-means进行聚类,并使用silhouette_score(轮廓系数)评估

y_pred = KMeans(n_clusters=2, random_state=9).fit_predict(X)

# 分别尝试n_cluses=2\3\4,然后查看聚类效果

plt.scatter(X[:, 0], X[:, 1], c=y_pred)

plt.show()

# 用轮廓系数评估的聚类分数

print(silhouette_score(X, y_pred))

2.3 小结

sklearn.cluster.KMeans(n_clusters=8)

-

参数: n_clusters:开始的聚类中心数量

-

方法: estimator.fit_predict(x)

计算聚类中心并预测每个样本属于哪个类别,相当于先调用fit(x),然后再调用predict(x)

3 Kmeans实现流程

3.1 Kmeans聚类步骤

k-means其实包含两层内容:

- K表示初始中心点个数(计划聚类数)

- means求中心点到其他数据点距离的平均值

具体步骤如下:

-

随机设置K个特征空间内的点作为初始的聚类中心

-

对于其他每个点计算到K个中心的距离,未知的点选择最近的一个聚类中心点作为标记类别

-

接着对着标记的聚类中心之后,重新计算出每个聚类的新中心点(平均值)

-

如果计算得出的新中心点与原中心点一样(质心不再移动),那么结束,否则重新进行第二步过程

通过下图解释实现流程:

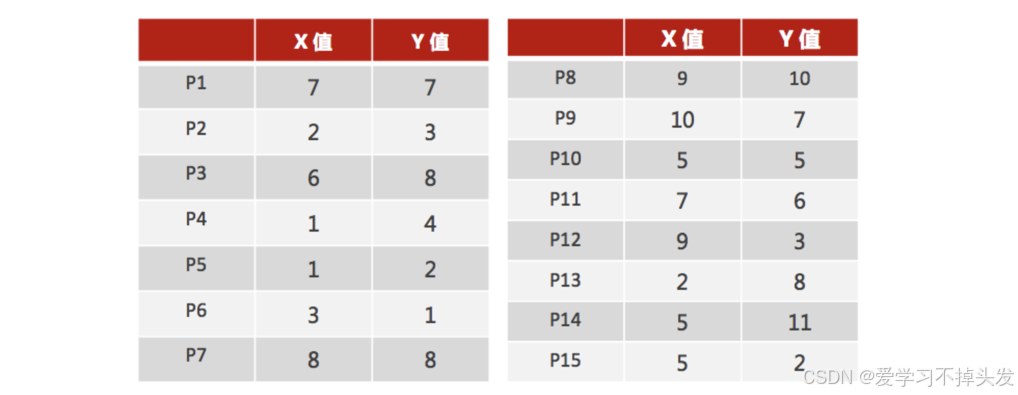

3.2 Kmeans实现流程案例

数据集:

1、随机设置K个特征空间内的点作为初始的聚类中心(本案例中设置p1和p2)

最初随机选择的K个特征,特征的选择会对于模型的训练结果有影响

2、对于其他每个点计算到K个中心的距离,未知的点选择最近的一个聚类中心点作为标记类别

3、接着对着标记的聚类中心之后,重新计算出每个聚类的新中心点(平均值)

- 计算得出的新的中心值与原中心有偏差,以新的中心值为中心,重复步骤2

4、如果计算得出的新中心点与原中心点一样(质心不再移动),那么结束,否则重新进行第二步过程【经过判断,需要重复上述步骤,开始新一轮迭代】

5、当每次迭代结果不变时,认为算法收敛,聚类完成,K-Means一定会停下,不可能陷入一直选质心的过程。

3.3 小结

K-means聚类实现流程

- 事先 确定常数K ,常数K意味着最终的聚类类别数;

- 随机 选定初始点为质心 ,并通过计算每一个样本与质心之间的相似度(这里为欧式距离),将样本点归到最相似的类中,

- 接着,重新计算 每个类的质心(即为类中心),重复这样的过程,直到 质心不再改变,

- 最终就确定了每个样本所属的类别以及每个类的质心。

- 注意:由于每次都要计算所有的样本与每一个质心之间的相似度,故在大规模的数据集上,K-Means算法的收敛速度比较慢。

4 聚类算法模型评估

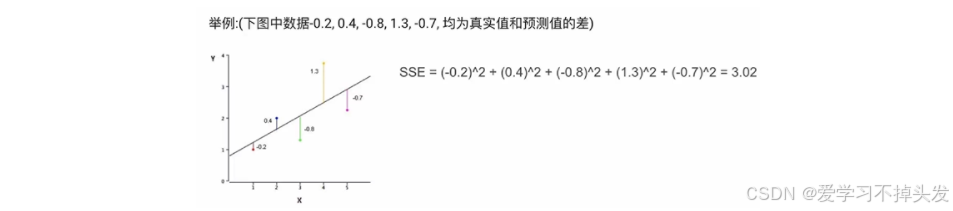

4.1 误差平方和(SSE The sum of squares due to error):

举例:(下图中数据-0.2, 0.4, -0.8, 1.3, -0.7, 均为真实值和预测值的差)

在k-means中的应用:

公式各部分内容:

1.Ci 表示簇

2.k 表示聚类中心的个数

3.p 表示某个簇内的样本

4.m 表示质心点

上图中: k=2

- SSE图最终的结果,对图松散度的衡量.(eg: SSE(左图)<SSE(右图))

- SSE 越小,表示数据点越接近它们的中心,聚类效果越好

- SSE随着聚类迭代,其值会越来越小,直到最后趋于稳定:

- 如果质心的初始值选择不好,SSE只会达到一个不怎么好的局部最优解.

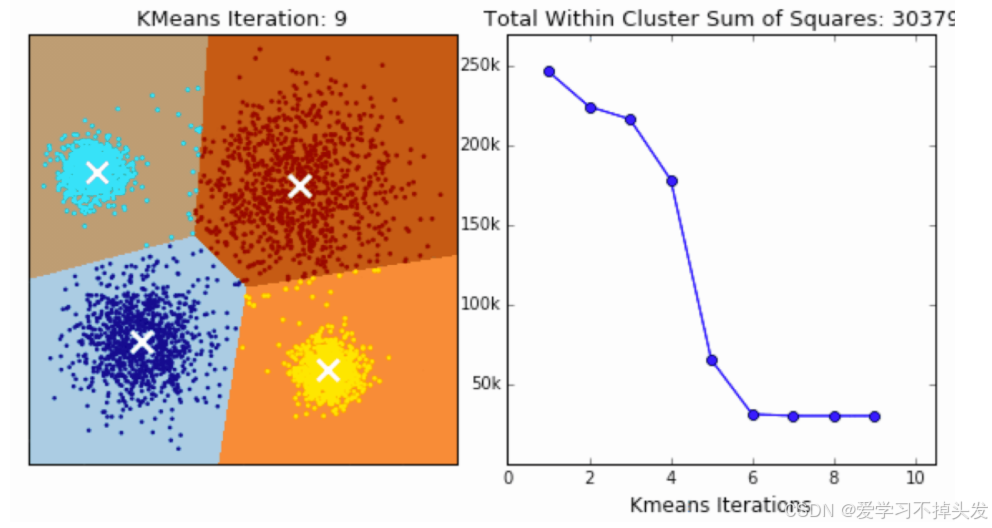

4,2 “肘”方法 (Elbow method) — K值确定

(1)对于n个点的数据集,迭代计算k from 1 to n,每次聚类完成后计算每个点到其所属的簇中心的距离的平方和;

(2)平方和是会逐渐变小的,直到k==n时平方和为0,因为每个点都是它所在的簇中心本身。

(3)在这个平方和变化过程中,会出现一个拐点也即“肘”点,下降率突然变缓时即认为是最佳的k值。

在决定什么时候停止训练时,肘形判据同样有效,数据通常有更多的噪音,在增加分类无法带来更多回报时,我们停止增加类别。

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

from sklearn.metrics import calinski_harabasz_score

def dm01_SSE误差平方和求模型参数():

sse_list = []

*#* *产生数据**random_state**=22**固定好

\* x, y = make_blobs(n_samples=1000, n_features=2, centers=[[-1, -1], [0, 0], [1, 1], [2, 2]],

cluster_std=[0.4, 0.2, 0.2, 0.2], random_state=22)

for clu_num in range(1, 100):

my_kmeans = KMeans(n_clusters=clu_num, max_iter=100, random_state=0)

my_kmeans.fit(x)

sse_list.append(my_kmeans.inertia_ ) *#* *获取**sse**的值

\* plt.figure(figsize=(18, 8), dpi=100)

plt.xticks(range(0, 100, 3), labels=range(0, 100, 3))

plt.grid()

plt.title('sse')

plt.plot(range(1, 100), sse_list, 'or-')

plt.show()

*#* *通过图像可观察到* *n_clusters**=4* *sse**开始下降趋缓**,* *最佳值**4*

4.3 轮廓系数法(Silhouette Coefficient)

结合了聚类的凝聚度(Cohesion)和分离度(Separation),用于评估聚类的效果:

目的:内部距离最小化,外部距离最大化

- 对计算每一个样本 i 到同簇内其他样本的平均距离 ai,该值越小,说明簇内的相似程度越大

- 计算每一个样本 i 到最近簇 j 内的所有样本的平均距离 bij,该值越大,说明该样本越不属于其他簇 j

- 根据下面公式计算该样本的轮廓系数:S = (b -a)/(max(a, b))

- 计算所有样本的平均轮廓系数

- 轮廓系数的范围为:[-1, 1],SC值越大聚类效果越好

计算样本i到同簇其他样本的平均距离ai,ai 越小样本i的簇内相似度越大,说明样本i越应该被聚类到该簇。

计算样本i到最近簇Cj 的所有样本的平均距离bij,称样本i与最近簇Cj 的不相似度,定义为样本i的簇间不相似度:bi =min{bi1, bi2, …, bik},bi越大,说明样本i越不属于其他簇。

簇内样本的距离越近,簇间样本距离越远

4.3.1 SC系数案例

下图是500个样本含有2个feature的数据分布情况,我们对它进行SC系数效果衡量:

n_clusters = 2 The average silhouette_score is : 0.7049787496083262

n_clusters = 3 The average silhouette_score is : 0.5882004012129721

n_clusters = 4 The average silhouette_score is : 0.6505186632729437

n_clusters = 5 The average silhouette_score is : 0.56376469026194

n_clusters = 6 The average silhouette_score is : 0.4504666294372765

n_clusters 分别为 2,3,4,5,6时,SC系数如下,是介于[-1,1]之间的度量指标:

每次聚类后,每个样本都会得到一个轮廓系数,当它为1时,说明这个点与周围簇距离较远,结果非常好,当它为0,说明这个点可能处在两个簇的边界上,当值为负时,暗含该点可能被误分了。

4.3.2 SC API使用

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

from sklearn.metrics import silhouette_score

def dm02_轮廓系数SC():

tmp_list = []

# 产生数据**random_state**=22**固定好

x, y = make_blobs(n_samples=1000, n_features=2, centers=[[-1, -1], [0, 0], [1, 1], [2, 2]],

cluster_std=[0.4, 0.2, 0.2, 0.2], random_state=22)

for clu_num in range(2, 100):

my_kmeans = KMeans(n_clusters=clu_num, max_iter=100, random_state=0)

my_kmeans.fit(x)

ret = my_kmeans.predict(x)

tmp_list.append(silhouette_score(x, ret)) *#* *sc**

plt.figure(figsize=(18, 8), dpi=100)

plt.xticks(range(0, 100, 3), labels=range(0, 100, 3))

plt.grid()

plt.title(‘sse’)

plt.plot(range(2, 100), tmp_list, ‘ob-’)

plt.show()

*#* *通过图像可观察到* *n_clusters**=4* *取到**最大值*

4.4 CH轮廓系数法(Calinski-Harabasz Index)

CH 系数考虑簇内的内聚程度、簇外的离散程度、质心的个数

- 类别内部数据的距离平方和越小越好,类别之间的距离平方和越大越好。聚类的种类数越少越好

- SSW 的含义:相当于SSE,蔟内距离

- C p i C_pi Cpi表示质心

- x i x_i xi表示某个样本

- SSW 值是计算每个样本点到质心的距离,并累加起来

- SSW 表示表示簇内的内聚程度,越小越好

- SSB 的含义:簇间距离

-

C j C_j Cj表示质心, X ‾ \overline {X} X表示质心与质心之间的中心点, n j n_j nj表示样本的个数

-

SSB 表示簇与簇之间的分离程度,SSB 越大越好

-

m 表示样本数量

-

k 表示质心个数,目标希望k越小越好

-

4.4.1 CH系数法 API

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

from sklearn.metrics import calinski_harabasz_score

def dm03_ch系数():

tmp_list = []

*#* *产生数据**random_state**=22**固定好

\* x, y = make_blobs(n_samples=1000, n_features=2, centers=[[-1, -1], [0, 0], [1, 1], [2, 2]],

cluster_std=[0.4, 0.2, 0.2, 0.2], random_state=22)

for clu_num in range(2, 100):

my_kmeans = KMeans(n_clusters=clu_num, max_iter=100, random_state=0)

my_kmeans.fit(x)

ret = my_kmeans.predict(x)

tmp_list.append(calinski_harabasz_score(x, ret)) *#* *sc**

\* plt.figure(figsize=(18, 8), dpi=100)

plt.xticks(range(0, 100, 3), labels=range(0, 100, 3))

plt.grid()

plt.title('ch')

plt.plot(range(2, 100), tmp_list, 'og-')

plt.show()

4.5 小结

- SSE:误差平方和的值越小越好

- 肘部法:下降率突然变缓时即认为是最佳的k值

- SC系数:取值为[-1, 1],其值越大越好

- CH系数:考虑簇内,簇外和质心个数,越大越好

2695

2695

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?