1. BaseInfo

| Title | DIFFERENTIAL TRANSFORMER |

| Adress | https://arxiv.org/pdf/2410.05258 |

| Journal/Time | 202410 |

| Author | 微软研究院和清华大学提出 |

| Code | https://aka.ms/Diff-Transformer |

| Read | 241111 |

2. Creative Q&A

- 减少对无关上下文的关注;

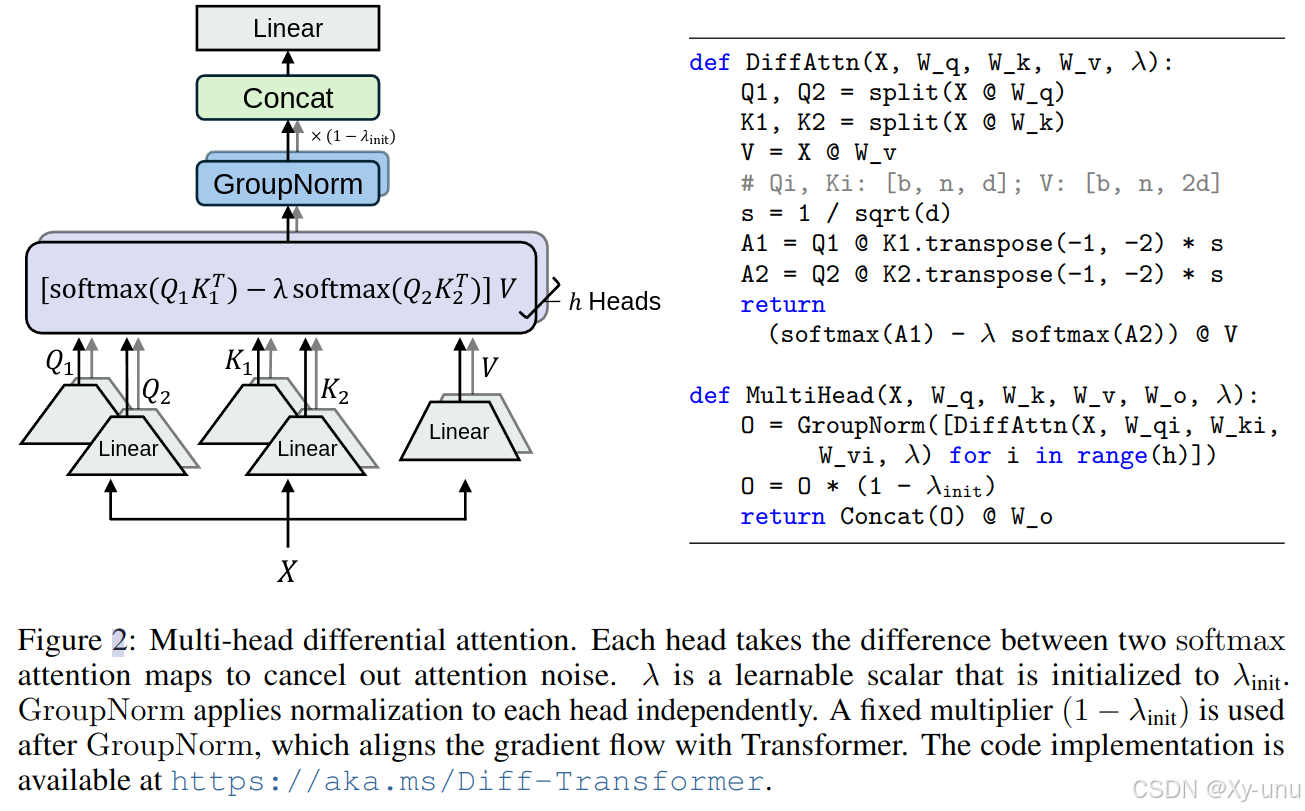

- 通过计算两个Softmax注意力权重的差值来抵消噪音;

3. Concrete

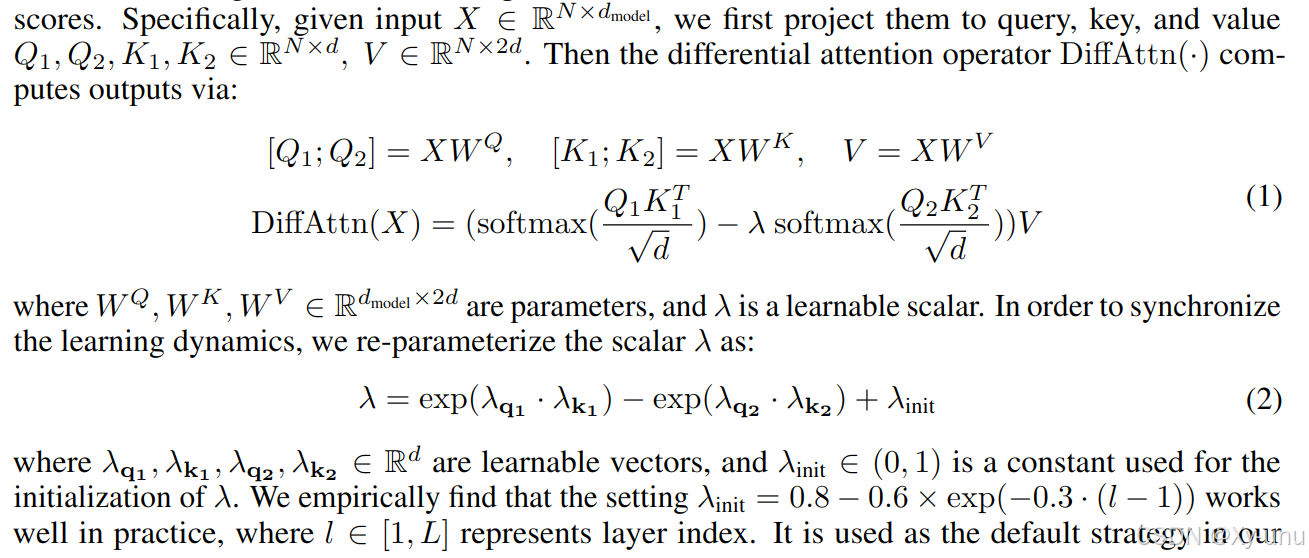

将查询和键向量分为两组,并计算两个独立的 softmax 注意力图。

LLaMA 的结构,把中间的 Attention 变为 Diff-Attention

主要区别在于修改了注意力的softmax过程,并且采用了pre-RMSNorm、SwiGLU等改进。

3.3. Eval

在 LLM 上进行对比的。 StableLM-3B-4E1T。

3.4. Ablation

4. Reference

【85、Differential Transformer 论文原理逐段讲解】 https://www.bilibili.com/video/BV1Jq1PYPEYG/?share_source=copy_web&vd_source=de14afcd5ebe6d387a25fcaeaeafa1c7

5. Additional

主要是在大语言模型上的应用。差分的想法挺有意思的。得看看代码。

744

744

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?