本篇将继续介绍决策的第三种算法:CART算法,它可以说是学习决策树的核心了。高级集成学习很多复杂框架都是基于CART的。下面将详细介绍CART算法的来龙去脉。

CART生成算法

CART剪枝算法

CART算法小结

决策树算法优缺点总结

▍CART生成算法

为什么叫CART算法呢?这还要从它的英文单词说起。CART是 "Classification and Regression Trees" 的缩写,意思是 "分类回归树"。从它的名字上就不难理解了,CART算法是既可以用于分类的,也可以用于回归的。

很多朋友诧异于决策树为什么可以用于回归,明明是if-then结构用于分类的。下面我们来分别介绍CART分类和回归两种情况。

分类树生成算法

CART算法的分类树是与ID3和C4.5有所不同。下面我们针对特征值的类型来分别介绍CART算法是如何进行分类的,以及和C4.5有什么异同。

如果特征值是连续值:CART的处理思想与C4.5是相同的,即将连续特征值离散化。唯一不同的地方是度量的标准不一样,CART采用基尼指数,而C4.5采用信息增益比。下面举个例子说明下:

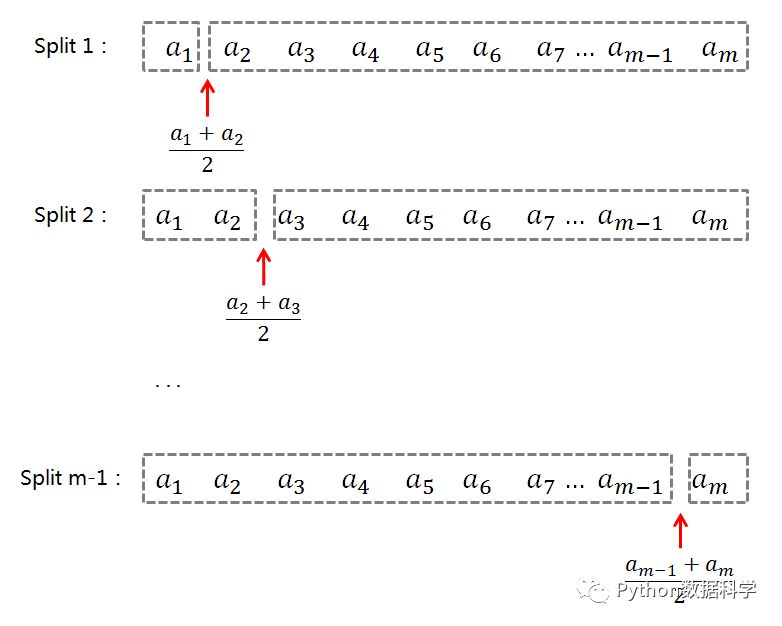

特征a有连续值m个,从小到大排列。m个数值就有m-1个切分点,分别使用每个切分点把连续数值离散划分成两类,将节点数据集按照划分点分为D1和D2子集,然后计算每个划分点下对应的基尼指数,对比所有基尼指数,选择值最小的一个作为最终的特征划分。

基尼指数公式,以及基于特征A划分后的基尼指数

以上就实现了将连续特征值离散化,但是CART与ID3,C4.5处理离散属性不同的是:如果当前节点为连续属性,则该属性(剩余的属性值)后面还可以参与子节点的产生选择过程。

如果特征值是离散值:CART的处理思想与C4.5稍微所有不同。如果离散特征值多于两个,那么C4.5会在节点上根据特征值划分出多叉树。但是CART则不同,无论离散特征值有几个,在节点上都划分成二叉树。CART树是如何进行分类的呢?

还是假设特征a有m个离散值。分类标准是:每一次将其中一个特征分为一类,其它非该特征分为另外一类。依照这个标准遍历所有的分类情况,计算每种分类下的基尼指数,最后选择值最小的一个作为最终的特征划分。

特征值连续和离散有各自的处理方法,不应该混淆使用。比如分类0,1,2只代表标签含义,如果进行加减的运算或者求平均则没有任何意义。因此,CART分类树会根据特征类型选择不同的划分方法&#x

本文深入介绍了CART算法,包括其分类和回归树的生成方法,以及剪枝策略。CART是"分类与回归树"的缩写,通过基尼指数或残差平方和来衡量特征的重要性。对于分类任务,CART可以处理离散和连续特征,而对于回归任务,它使用残差平方和最小化来选择最佳切分。CART算法还涉及了剪枝过程,以提高模型的泛化能力。此外,文章还总结了决策树算法的优缺点。

本文深入介绍了CART算法,包括其分类和回归树的生成方法,以及剪枝策略。CART是"分类与回归树"的缩写,通过基尼指数或残差平方和来衡量特征的重要性。对于分类任务,CART可以处理离散和连续特征,而对于回归任务,它使用残差平方和最小化来选择最佳切分。CART算法还涉及了剪枝过程,以提高模型的泛化能力。此外,文章还总结了决策树算法的优缺点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3753

3753

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?