如需在本地或离线环境下运行本项目,需要首先将项目所需的模型下载至本地,通常开源 LLM 与 Embedding 模型可以从 HuggingFace 下载。

以本项目中默认使用的 LLM 模型 THUDM/ChatGLM2-6B 与 Embedding 模型 moka-ai/m3e-base 为例:

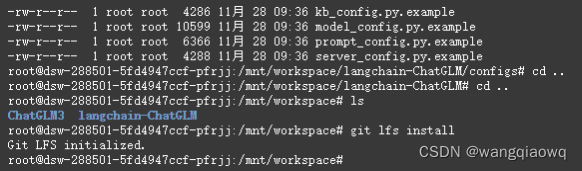

下载模型需要先安装 Git LFS,然后运行

git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git

git clone https://www.modelsco

本文介绍了在本地环境中下载并配置开源LLM和Embedding模型,如THUDM/ChatGLM2-6B和moka-ai/m3e-base,重点提到使用AutoGPTQ进行Int4量化以优化性能。还提供了详细步骤解决GPU版本问题和环境管理,确保PyTorch和CUDA的兼容性。

本文介绍了在本地环境中下载并配置开源LLM和Embedding模型,如THUDM/ChatGLM2-6B和moka-ai/m3e-base,重点提到使用AutoGPTQ进行Int4量化以优化性能。还提供了详细步骤解决GPU版本问题和环境管理,确保PyTorch和CUDA的兼容性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4545

4545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?