温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Python知网文献推荐系统》任务书

一、项目背景

在学术研究领域,面对海量的文献资源,研究人员往往需要花费大量时间进行文献检索和筛选,以找到与自己研究方向相关的优质文献。中国知网作为国内最大的学术文献数据库,拥有丰富的文献资源,但传统的检索方式难以满足用户个性化的需求。因此,开发一个基于Python的知网文献推荐系统具有重要的现实意义,能够帮助用户快速、精准地获取相关文献,提高研究效率。

二、项目目标

- 实现文献数据采集与处理:利用Python爬虫技术从知网获取文献数据,包括文献标题、作者、摘要、关键词等信息,并对数据进行清洗、预处理,构建文献特征向量。

- 构建用户画像:通过分析用户的历史阅读记录、搜索关键词、收藏文献等行为数据,构建用户画像,准确刻画用户的阅读兴趣和研究领域。

- 设计并实现个性化推荐算法:结合协同过滤算法、基于内容的推荐算法等,采用混合推荐策略,根据用户画像和文献特征向量,为用户提供个性化的文献推荐服务。

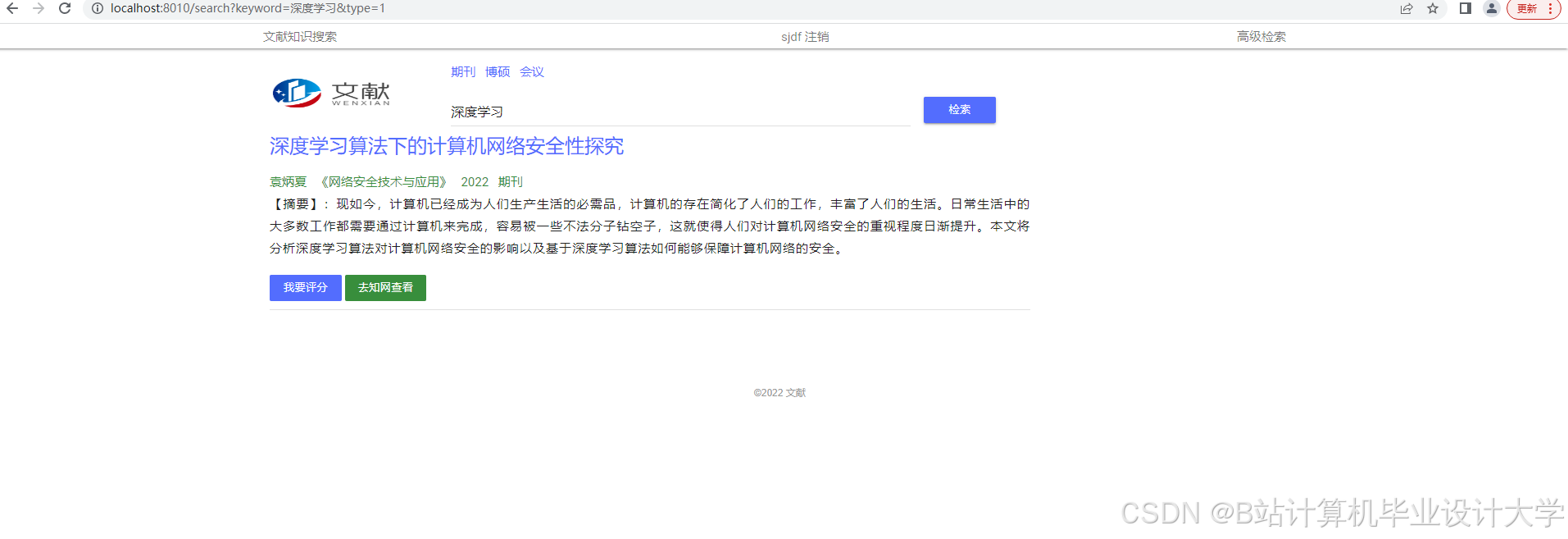

- 开发系统界面:使用Python相关框架搭建Web应用,提供用户注册、登录、文献检索、推荐结果展示等功能,构建友好的用户界面。

- 评估系统性能:通过实验评估推荐系统的准确率、召回率、F1值等指标,根据评估结果对系统进行优化和改进。

三、项目任务及要求

(一)文献数据采集与处理(第1 - 2周)

- 任务内容

- 研究知网的网页结构和数据获取方式,使用Python的

requests和BeautifulSoup库编写爬虫程序,从知网获取文献数据。 - 对采集到的数据进行清洗,去除重复、无效的数据,处理缺失值和异常值。

- 使用

jieba等中文分词工具对文献摘要和关键词进行分词,构建文献特征向量。

- 研究知网的网页结构和数据获取方式,使用Python的

- 交付成果:爬虫程序代码、清洗后的文献数据集、文献特征向量模型。

三、项目任务分解

(一)数据采集与预处理

- 目标:获取知网文献的基础数据,并进行初步整理,为后续推荐算法提供数据支持。

- 具体任务:

- 分析知网的网页结构,确定数据采集的规则和策略。

- 编写Python爬虫程序,实现数据的自动化采集。

- 对采集到的数据进行格式转换、去重、分词等预处理操作。

(二)用户画像构建

- 目标:深入了解用户的阅读习惯和兴趣偏好,为个性化推荐提供依据。

- 具体任务:

- 设计用户行为数据的存储结构,记录用户的阅读历史、搜索记录、收藏行为等。

- 使用机器学习算法或统计分析方法,从用户行为数据中提取特征,构建用户画像。

(三)推荐算法设计与实现

- 目标:开发高效、准确的推荐算法,提高推荐的准确性和个性化程度。

- 具体任务:

- 研究协同过滤算法、基于内容的推荐算法等,分析其优缺点。

- 结合混合推荐策略,设计适合本系统的推荐算法。

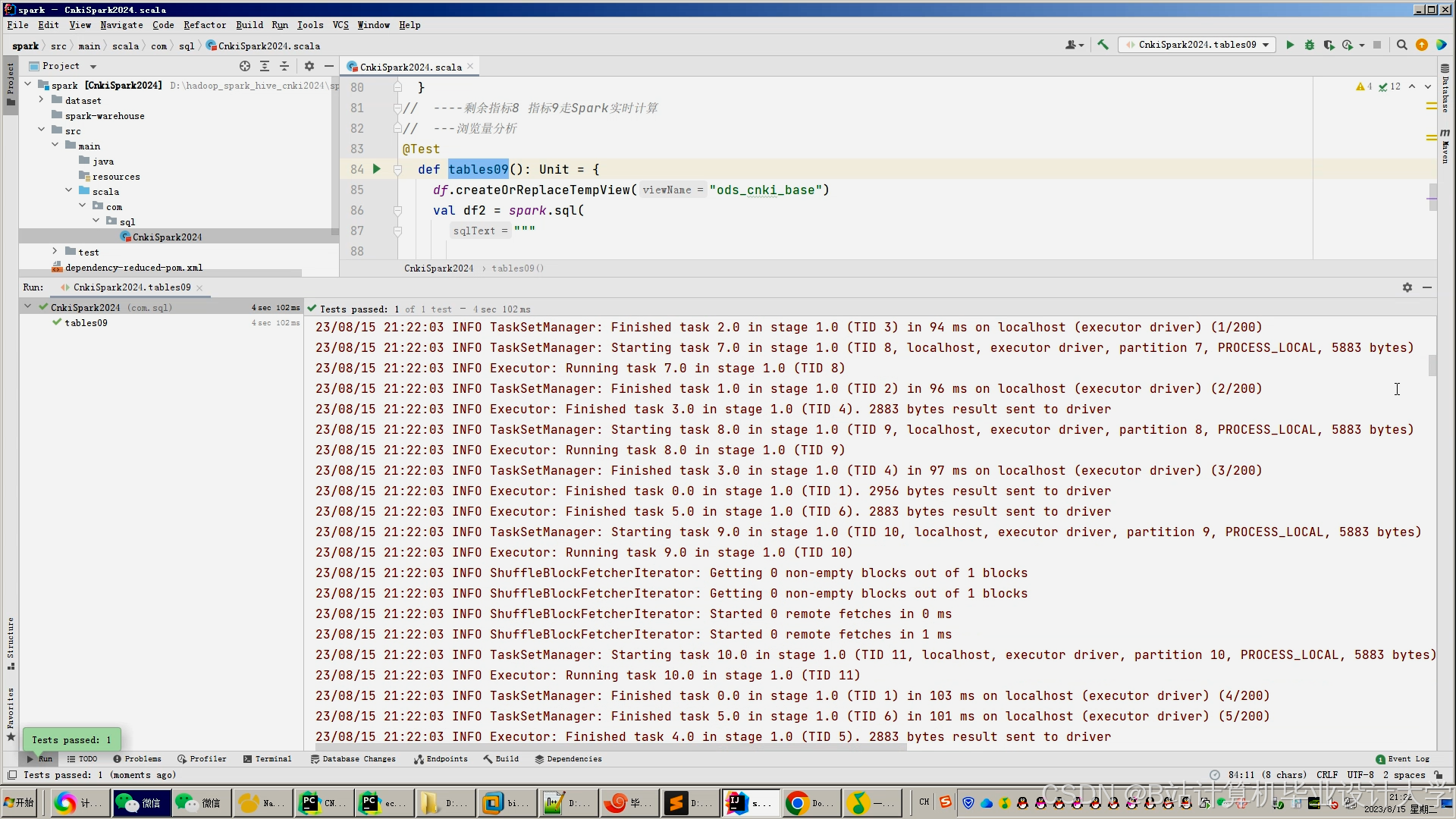

- 使用Python实现推荐算法,并进行参数调优。

(四)系统开发与集成

- 目标:构建一个功能完善、界面友好的Web应用,实现文献推荐系统的各项功能。

- 具体任务:

- 选择合适的Python Web框架(如Flask或Django)搭建后端服务。

- 使用前端技术(如HTML、CSS、JavaScript)构建用户界面。

- 实现用户注册、登录、文献检索、推荐结果展示等功能模块。

- 进行前后端集成,确保系统的稳定性和可用性。

(五)系统测试与优化

- 目标:评估系统的性能,发现并解决存在的问题,提高系统的稳定性和用户体验。

- 具体任务:

- 设计测试用例,对系统进行功能测试和性能测试。

- 收集用户反馈,对系统进行优化和改进。

四、技术要求

- 编程语言:Python

- 数据采集:使用Python爬虫技术,如

requests、BeautifulSoup等库。 - 数据处理:使用

pandas、numpy等库进行数据清洗、特征提取和模型训练。 - Web开发:使用Flask或Django框架,结合前端技术(如Vue.js、React等)构建用户界面。

- 数据库:选择合适的数据库(如MySQL、MongoDB)存储用户数据和文献数据。

五、时间安排

| 阶段 | 时间范围 | 任务内容 |

|---|---|---|

| 准备阶段 | 第1周 | 项目立项、文献调研、技术选型 |

| 数据采集阶段 | 第2 - 3周 | 编写爬虫程序,采集知网文献数据 |

| 数据处理阶段 | 第4 - 5周 | 数据清洗、分词、构建文献特征向量 |

| 算法设计阶段 | 第6 - 7周 | 设计推荐算法,实现协同过滤、内容-based推荐等策略 |

| 系统开发阶段 | 第8 - 9周 | 搭建Web应用,实现前后端功能 |

| 测试与优化阶段 | 第10 - 11周 | 系统测试、性能评估、算法优化 |

| 总结与交付阶段 | 第12周 | 撰写项目报告、提交成果 |

六、预期成果

- 完成一个基于Python的知网文献推荐系统,具备用户注册、登录、文献检索、个性化推荐等功能。

- 发表相关学术论文,展示Python在文献推荐系统中的应用成果。

- 申请相关软件著作权,保护系统的知识产权。

七、项目组成员及分工

| 成员姓名 | 职责 |

|---|---|

| 张三 | 负责数据采集与处理,实现爬虫程序 |

| 李四 | 设计推荐算法,完成算法实现 |

| 王五 | 开发Web应用,构建用户界面 |

| 赵六 | 负责系统测试与优化,撰写项目文档 |

八、项目预期成果

- 系统功能:完整的文献推荐系统,支持用户注册、登录、文献检索、推荐结果展示等功能。

- 技术文档:包含系统设计、算法实现、测试报告等详细文档。

- 学术论文:总结项目研究成果,探讨Python在文献推荐系统中的应用价值。

九、项目风险与应对措施

- 数据获取风险:知网可能对爬虫行为有限制,需遵守相关法律法规,获取合法授权。

- 算法效果风险:推荐算法可能存在误差,需不断优化算法模型,结合用户反馈进行调整。

- 时间管理风险:需合理安排时间,确保各阶段任务按时完成。

十、项目验收标准

- 系统功能完整,能够实现文献推荐的核心功能。

- 推荐算法准确,推荐结果符合用户需求。

- 系统性能稳定,无明显漏洞和故障。

以上任务书可根据实际项目情况进行调整和补充,在实施过程中需严格遵守法律法规,确保数据采集和系统开发合法合规。

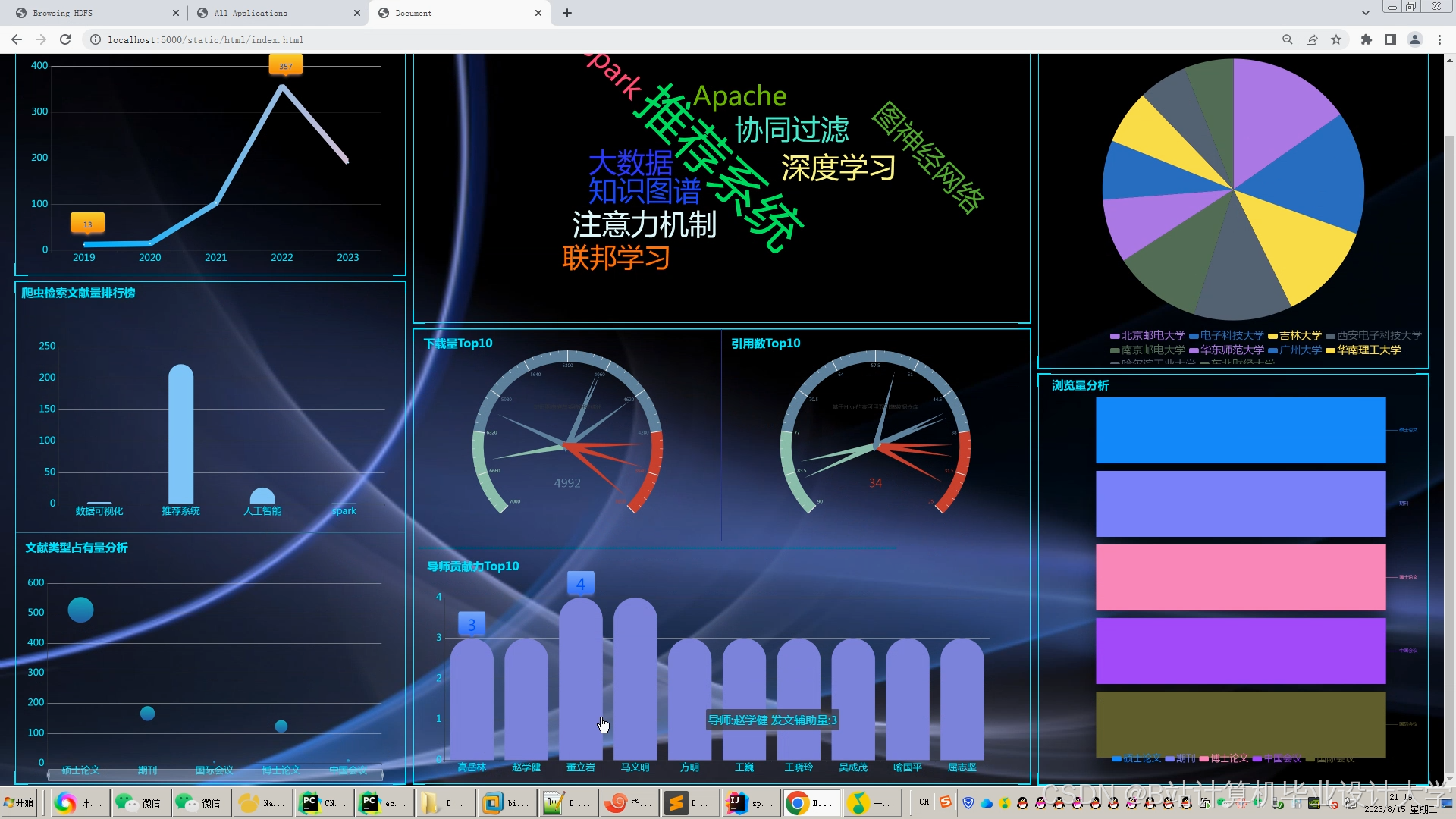

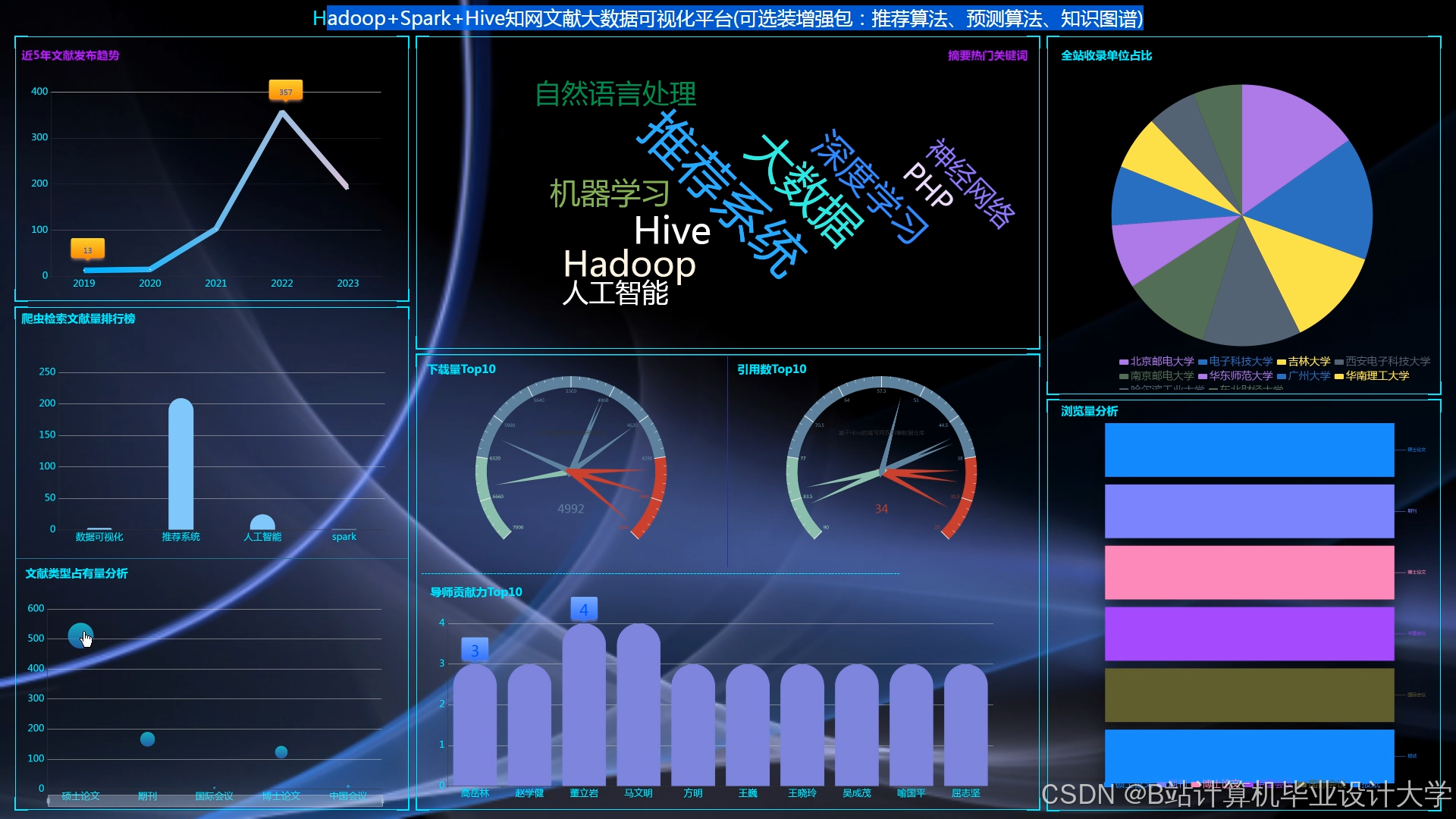

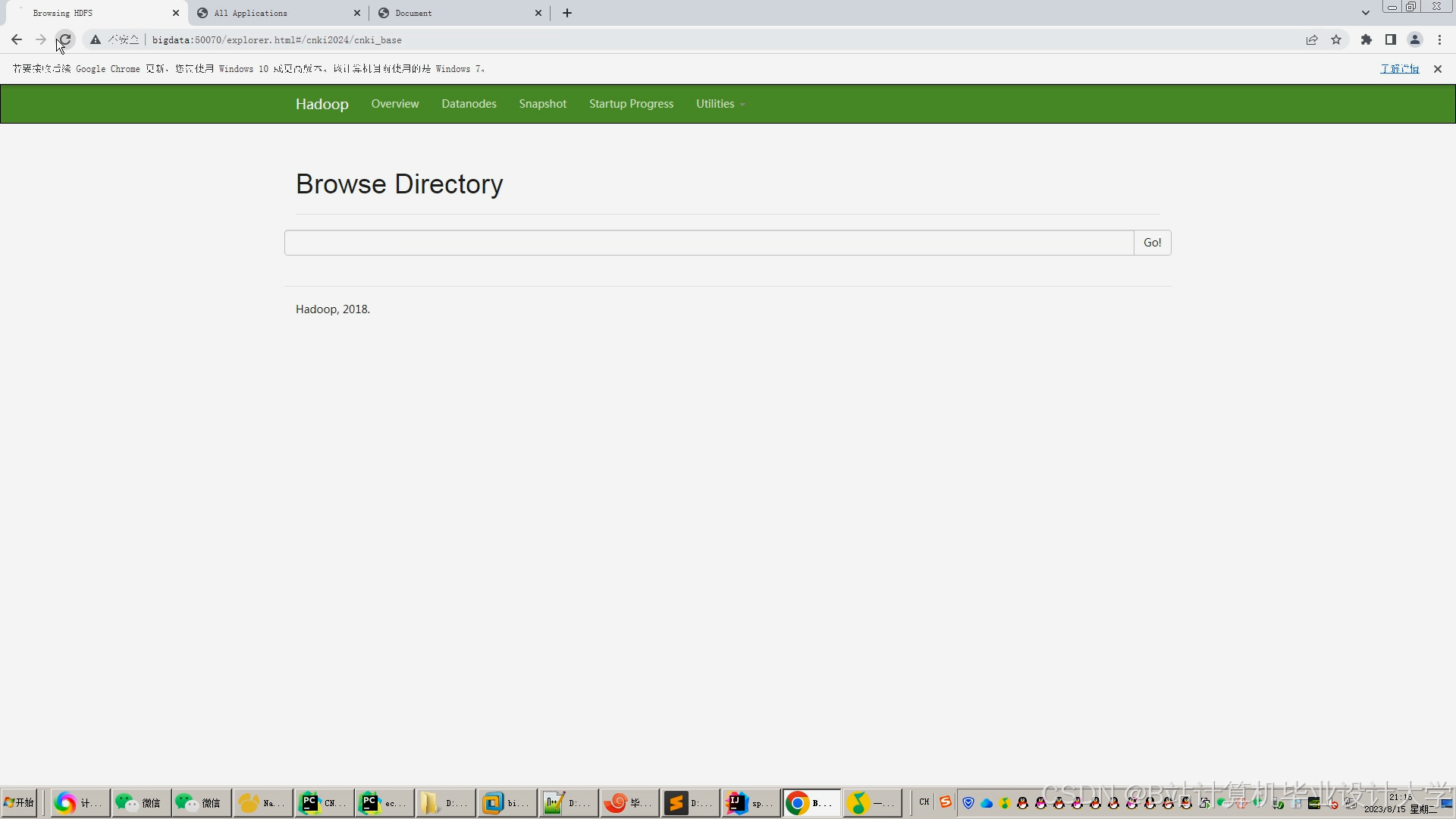

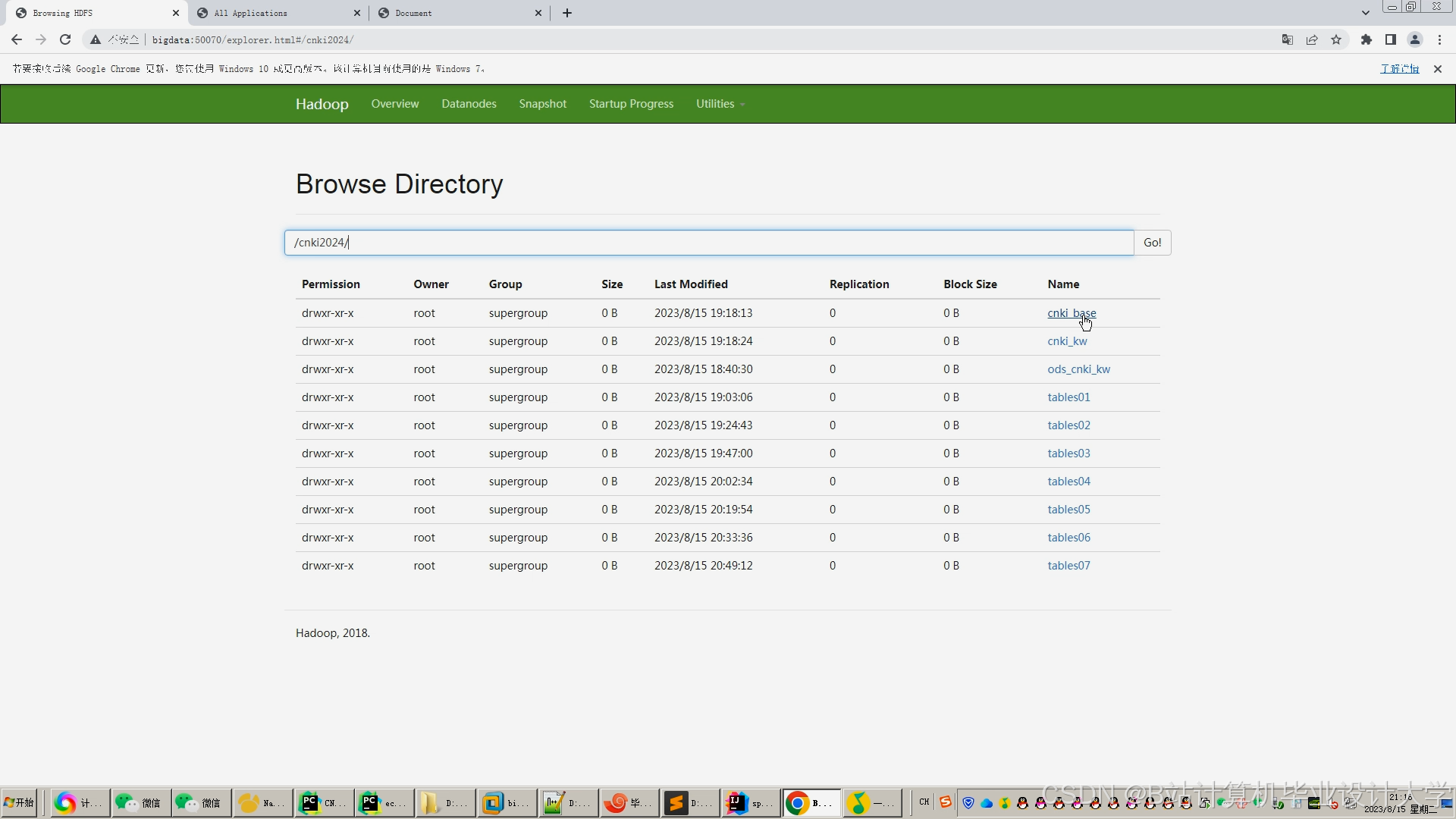

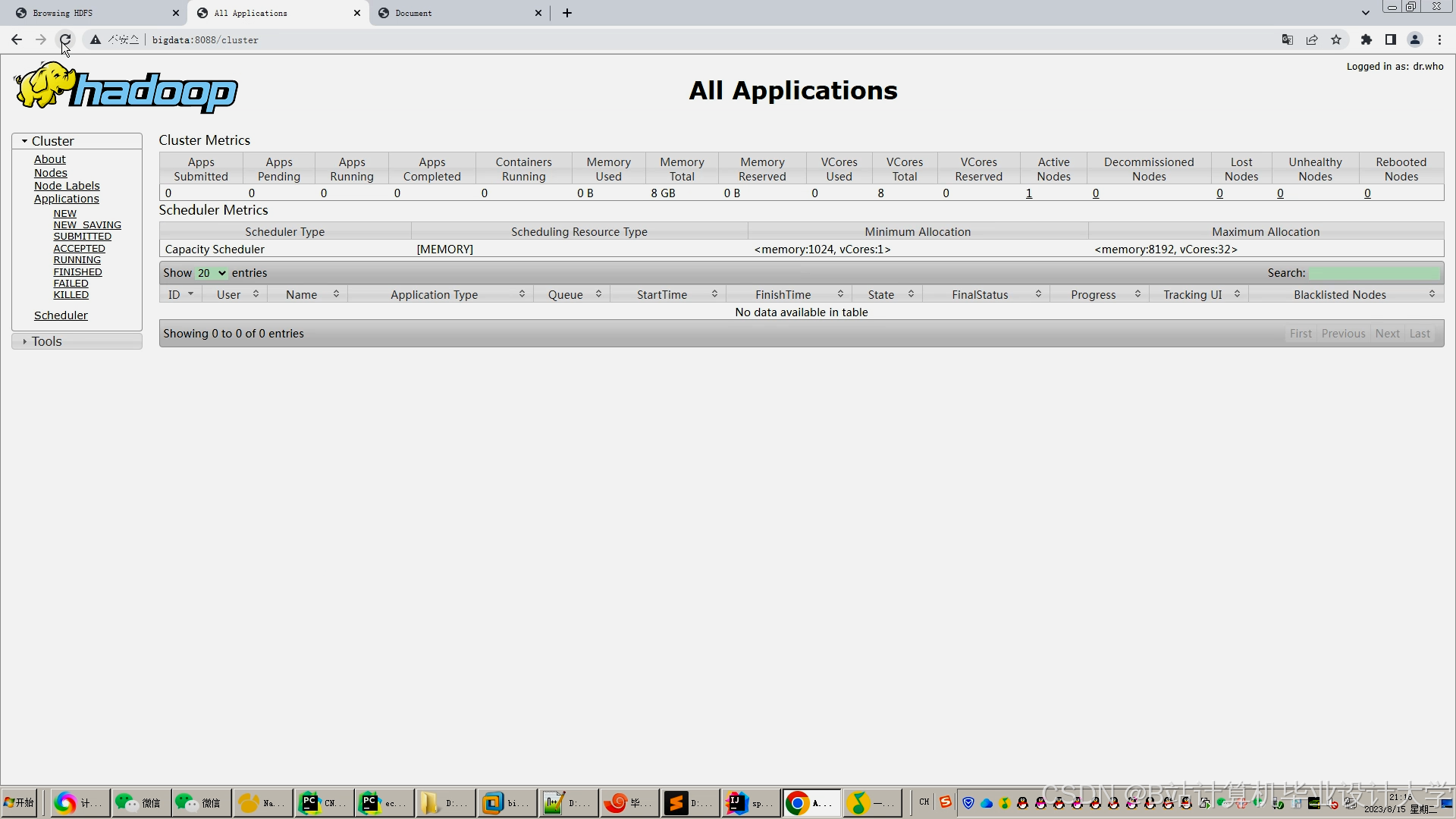

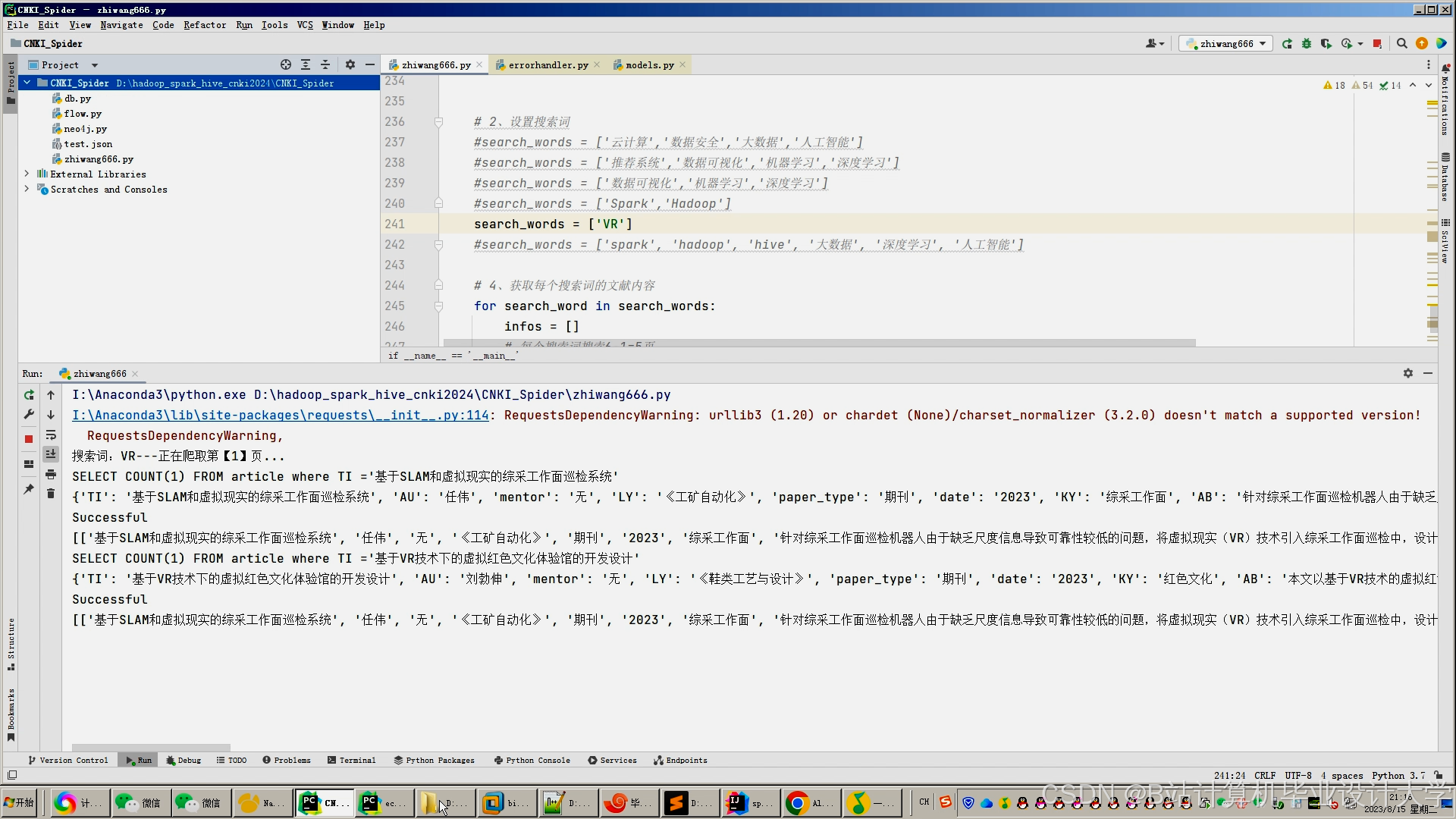

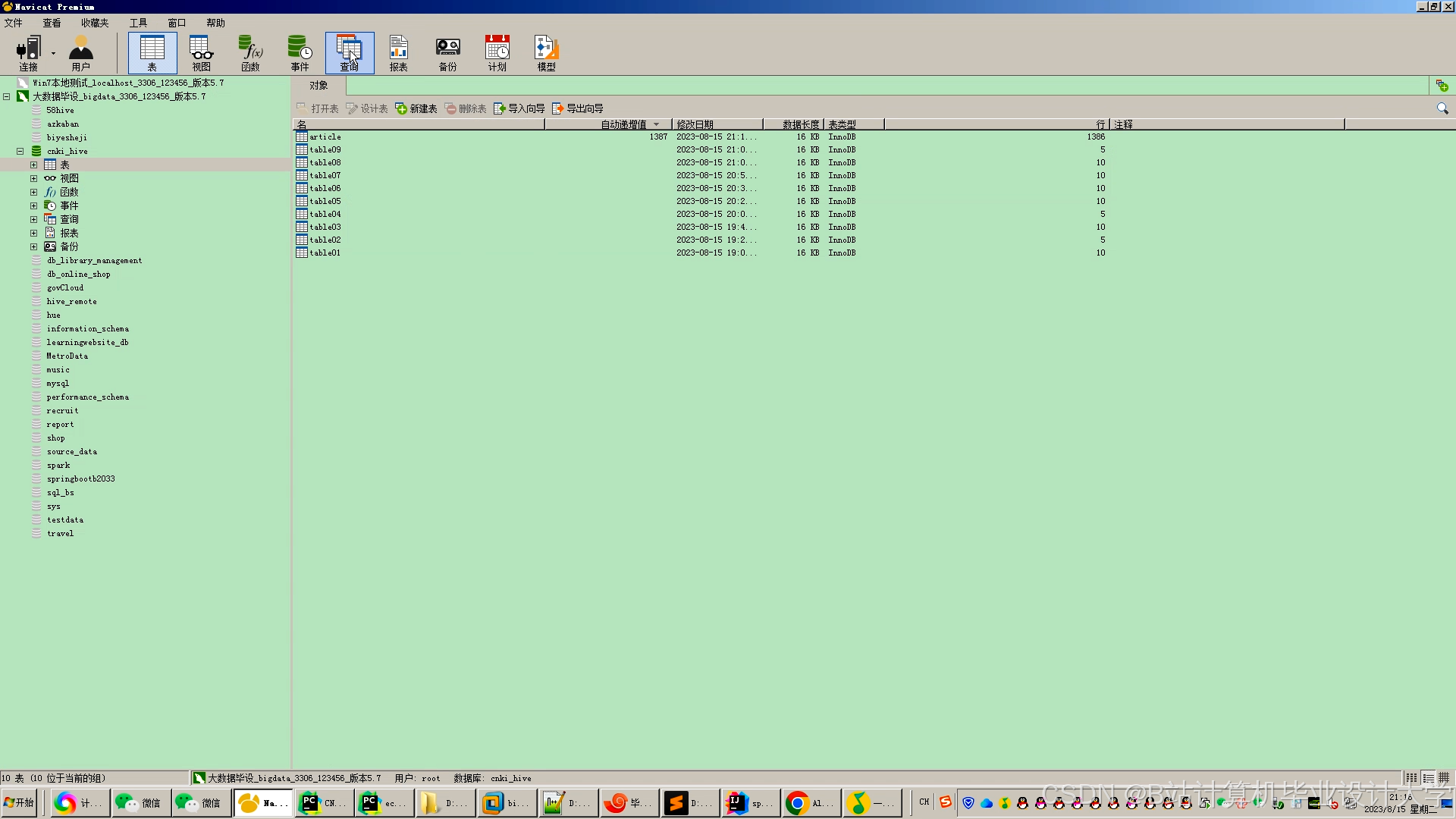

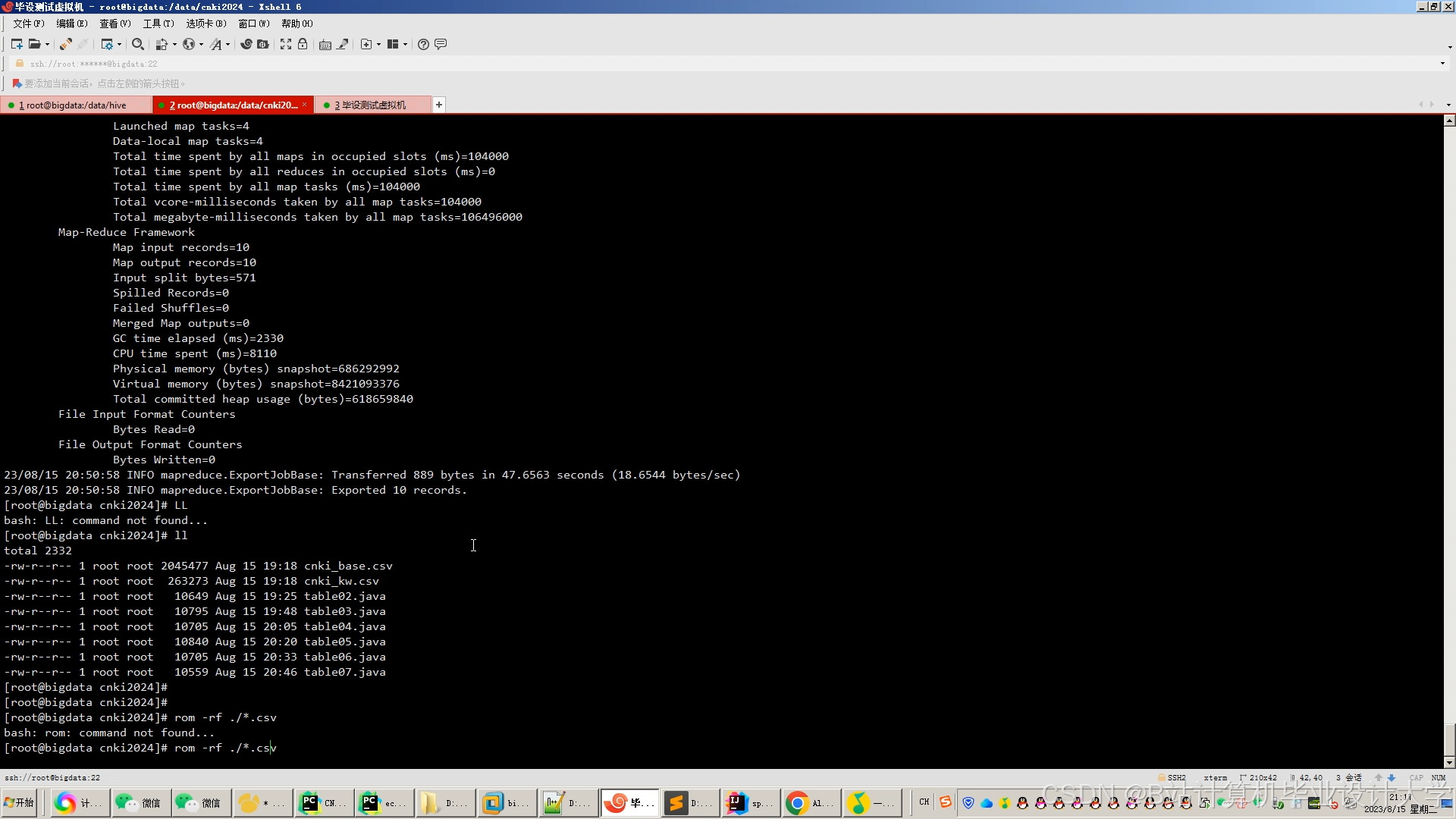

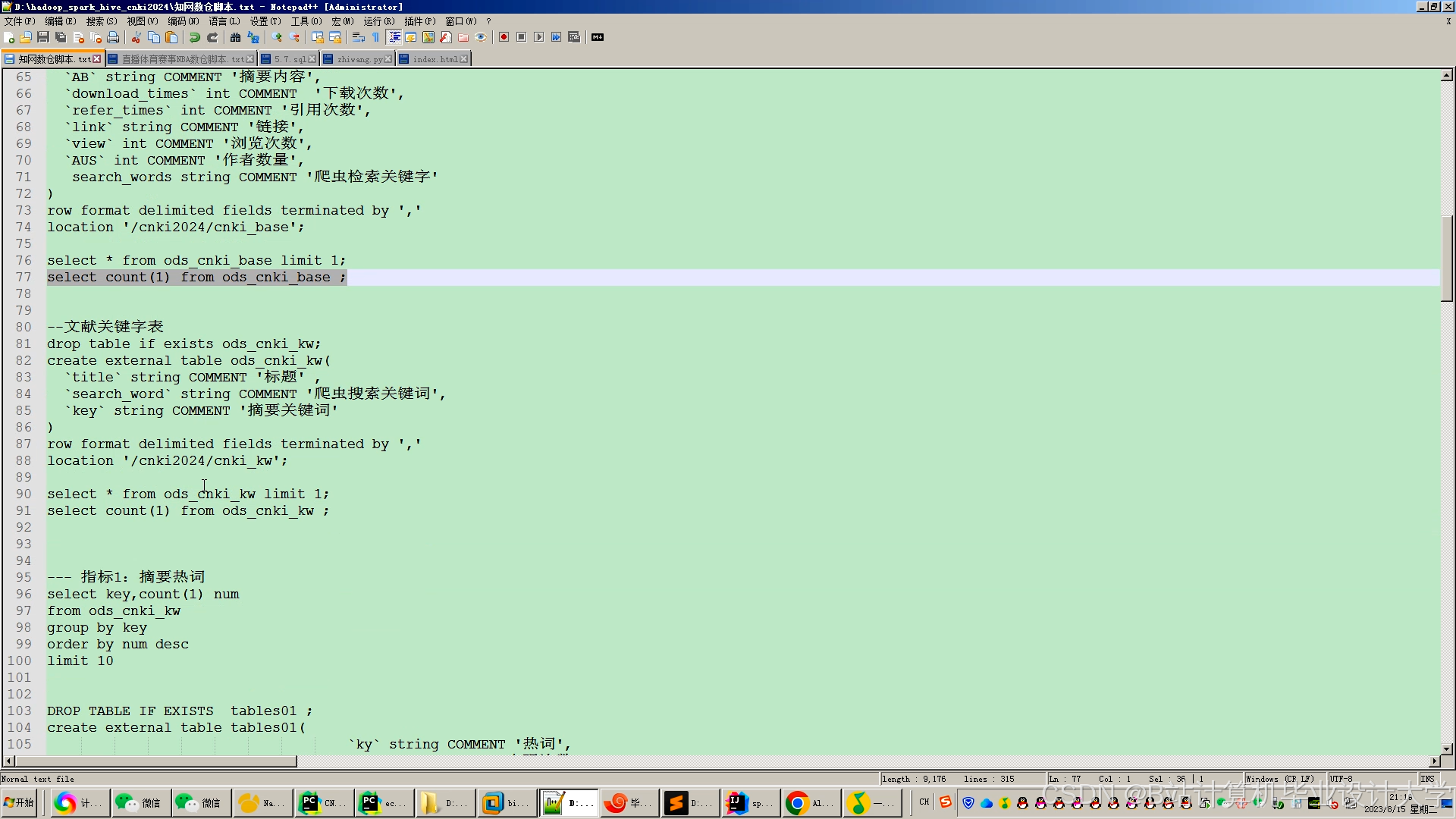

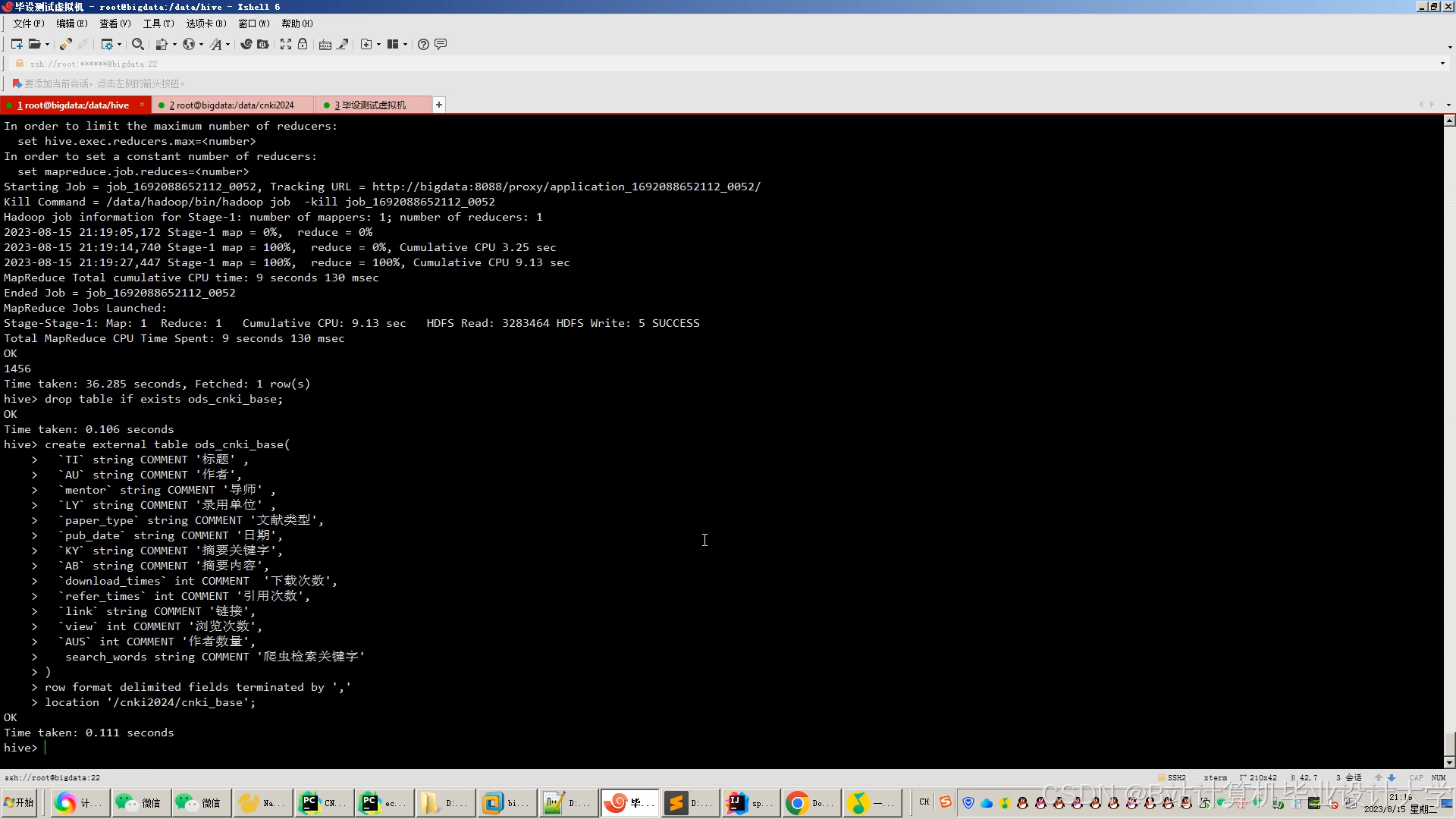

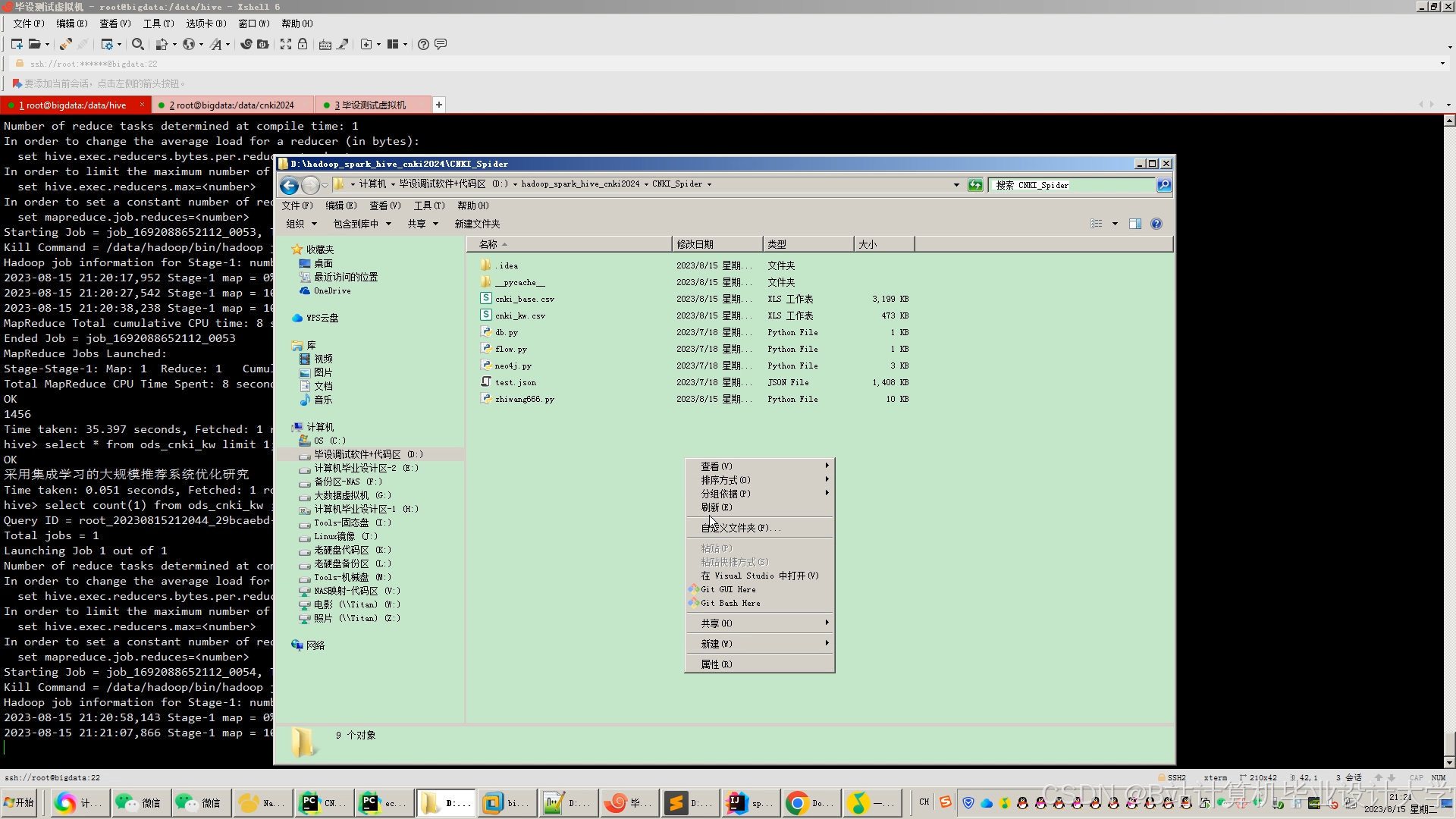

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1281

1281

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?