一. PPL评测

大模型推理:

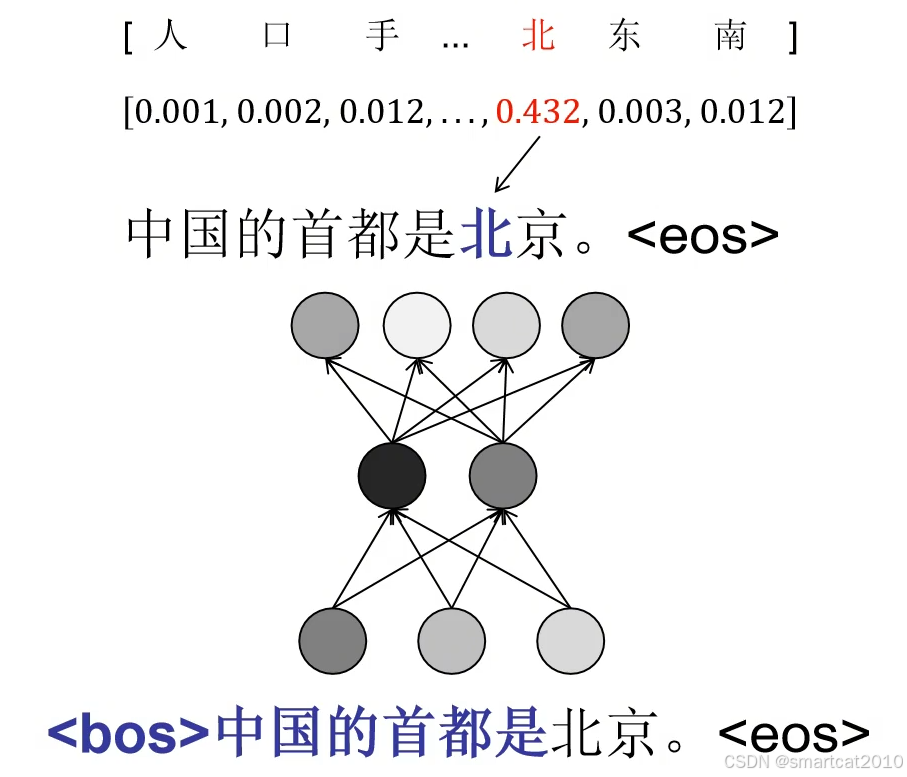

forward时,计算每一个token的生成概率:

整个句子,所有N个token的概率相乘,再开N次方,可视为每个token的“平均概率”,越大越好(“确信度”);

再求倒数,即为困惑度perplexity(PPL),越小越好。

(可以视为,生成这个句子的可能性,相当于从PPL个选项里蒙对的可能性,越小表示越确定)

上例,大模型1和大模型2,“是”之前的token,概率相差不大,“北“、”京“的概率,明显看出2个大模型的能力差异了!模型2看来是不懂这条知识的。

连乘:联合概率。开N次方:为了让“平均”概率不受句子长度的影响。

痛点:计算的时候,连乘的话,数值太小,精度不够了。

解决:使用log,先求对数再求指数:

局限性:

只能反映模型是否“倾向”被测文本。如果被测文本本身质量很烂,而大模型能力很好,则PPL是高的。例如大模型是擅长高质量写作,但被测文本是一段小孩子作文,则PPL很高。

Perplexity(PPL)和大模型评测

于 2024-12-14 17:38:25 首次发布

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3730

3730

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?