安装环境的方式测试的参考:

开始 -

作者:

https://github.com/ifzhang/FairMOT https://github.com/ifzhang/FairMOT

https://github.com/ifzhang/FairMOT

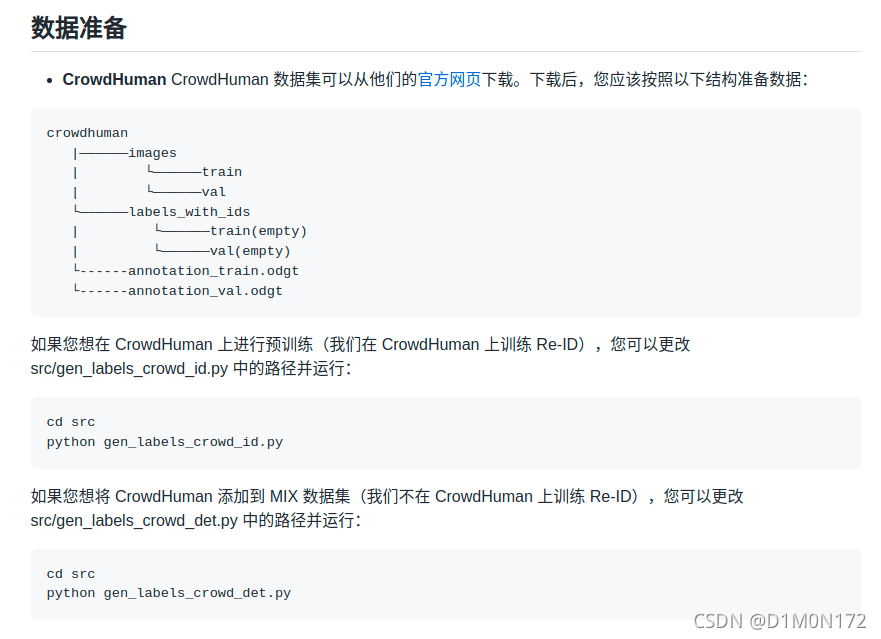

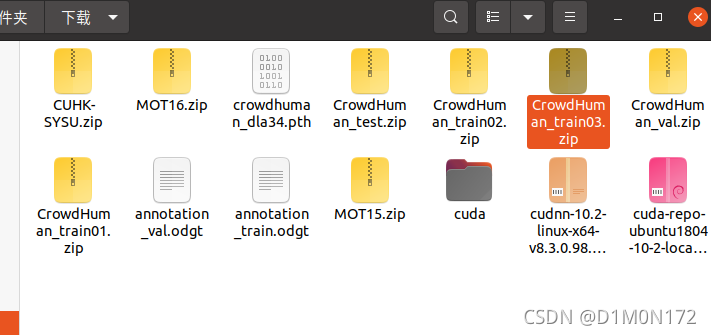

首先下载数据集:

CrowdHuman_train01.zip、CrowdHuman_train02.zip、CrowdHuman_train03.zip、

CrowdHuman_val.zip、CrowdHuman_test.zip

annotation_val.odgt、annotation_train.odgt、crowdhuman_dla34.pth

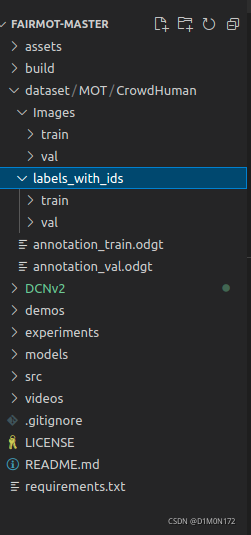

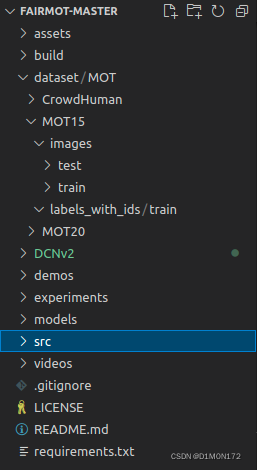

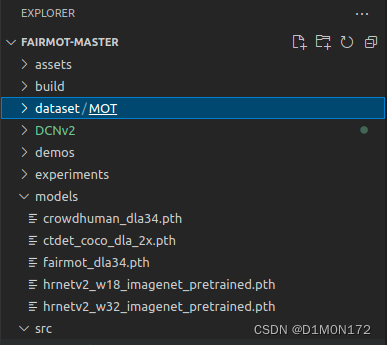

在FairMOT-master根目录下创建\dataset\MOT\CrowdHuman

创建的格式按照作者的方式:

crowdhuman

|——————images

| └——————train

| └——————val

└——————labels_with_ids

| └——————train(empty)

| └——————val(empty)

└------annotation_train.odgt

└------annotation_val.odgt具体如下:

打开\FairMOT-master\src\lib\cfg\data.json

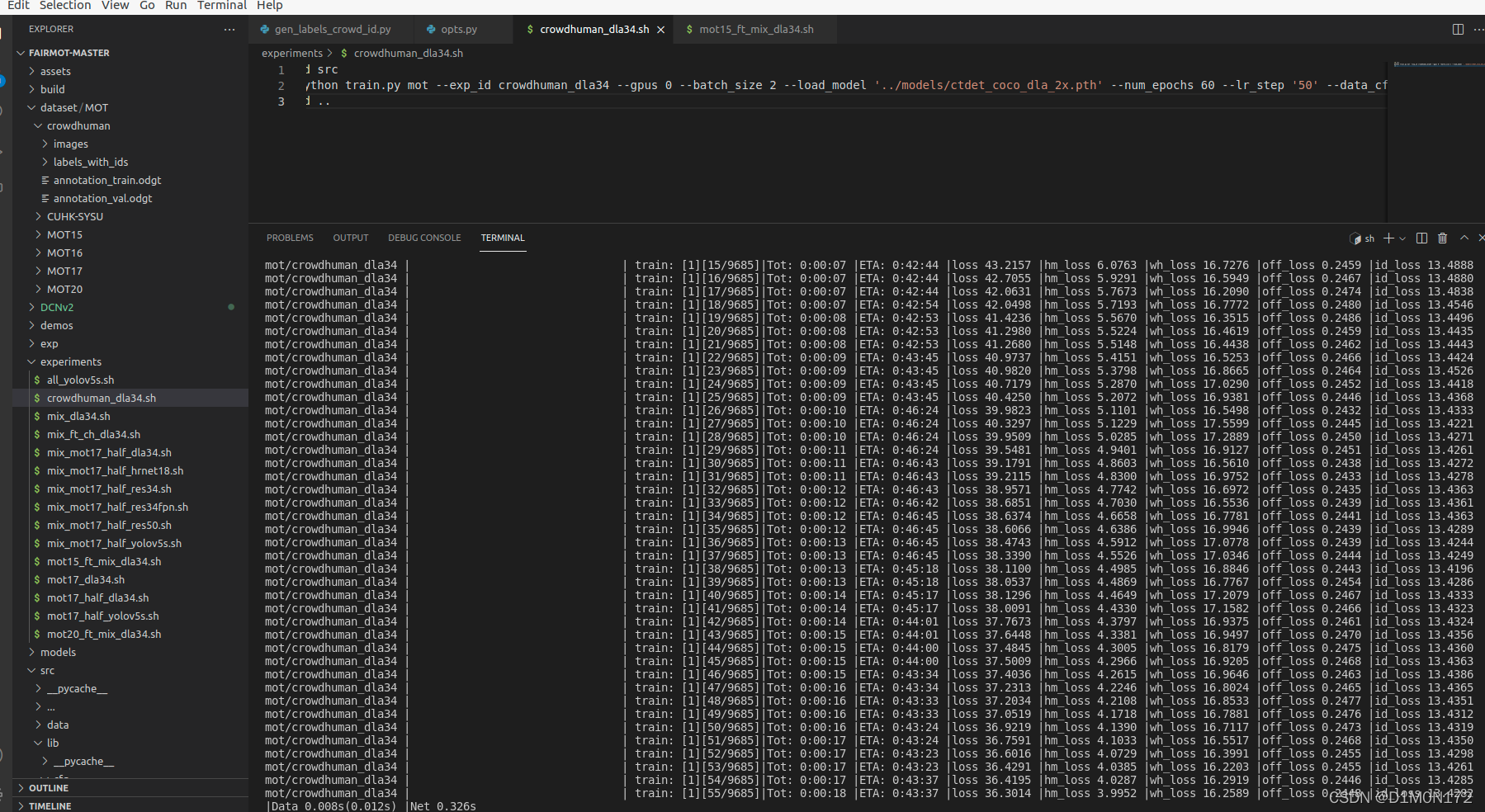

======================2021.11.30.02.18=================

成功训练

先睡觉

======================2021.12.01.11.27=================

更新:

今天先尝试一下2D MOT15训练

1.作者说这么准备数据集:

MOT15

|——————images

| └——————train

| └——————test

└——————labels_with_ids

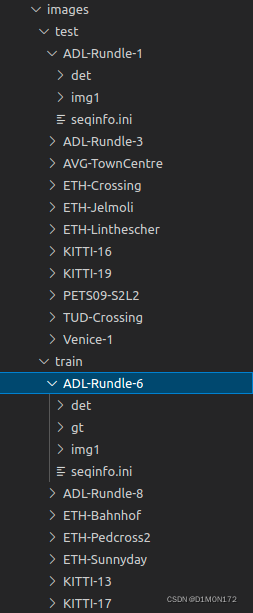

└——————train(empty)(1)将2DMOT2015解压,放入./FairMOT-master/dataset/MOT/MOT15(这里可以是你自己新建的数据集)目录下,解析完成后。MOT15内有train和test两个文件夹,里面存着train和test数据。

(2)在./FairMOT-master/dataset/MOT/MOT15目录下新建一个labels_with_ids文件夹,里面建一个空的train文件夹。

然后下载seqinfo 文件,将 seqinfo 文件夹中的 *.ini 复制到 MOT15 对应的文件夹中。

详细一点是:

ctrl+L 获取文件路径

/home/se8502/FairMOT-master/dataset/MOT/MOT15/images

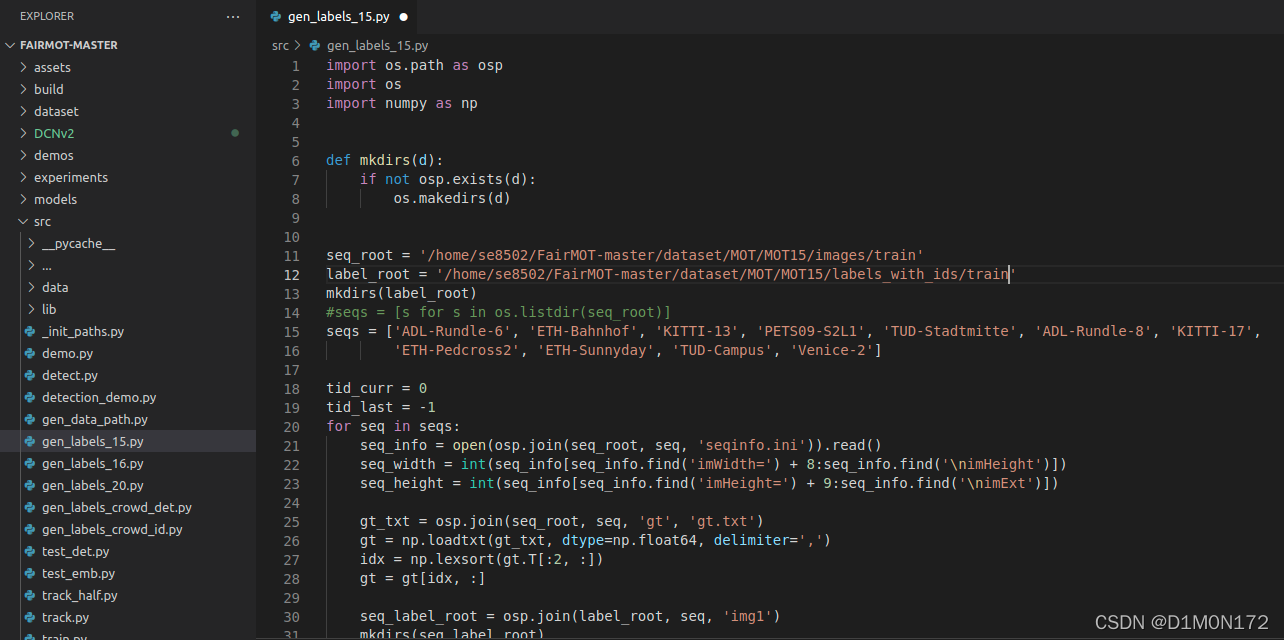

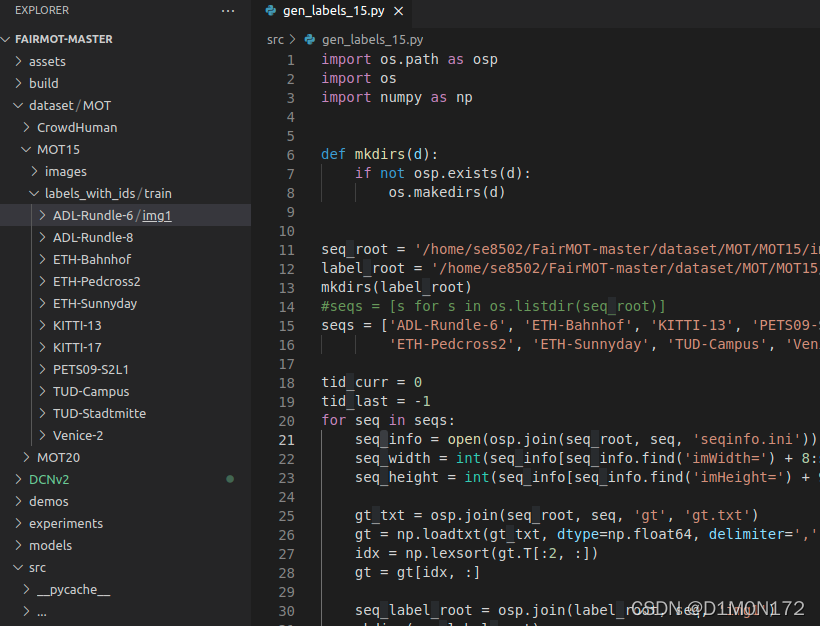

/home/se8502/FairMOT-master/dataset/MOT/MOT15/labels_with_ids/train2. 打开 src/python gen_labels_15.py 修改文件中数据集的路径

分别是:seq_root 和 label_root

打开 Terminal 输入

python gen_labels_15.py

文件夹中就会生成训练集的label

3.训练模型:

按照这样的准备

4. 修改训练数据集地址:

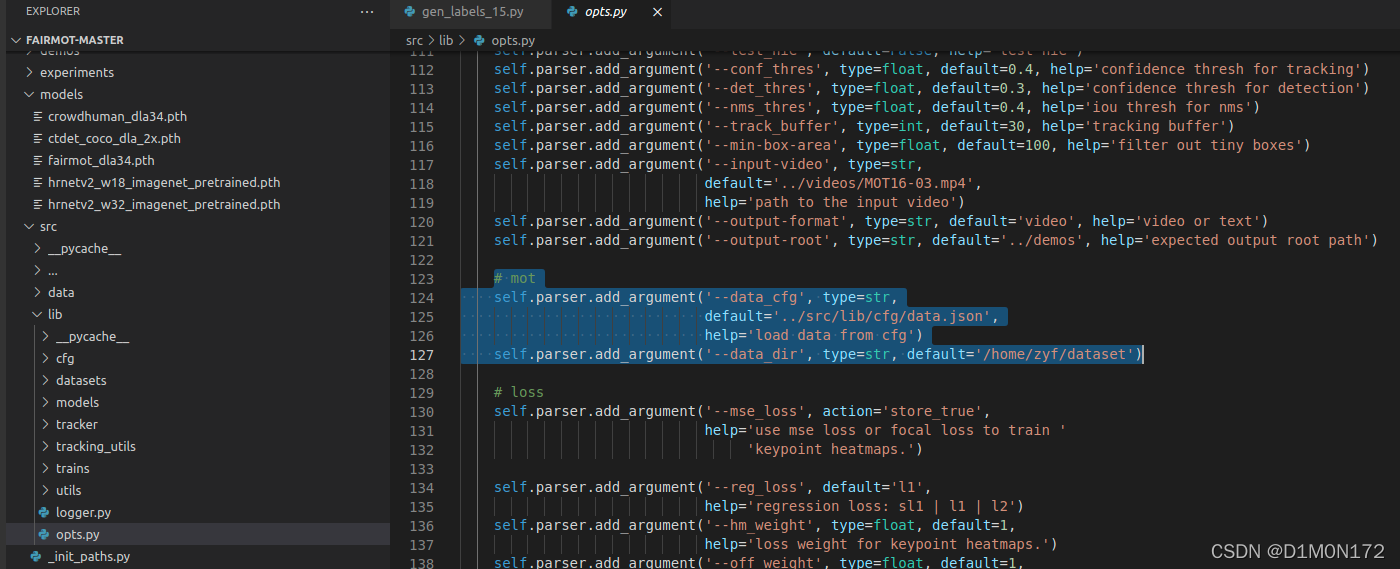

打开文件./src/lib/opts.py

修改为自己的数据集地址:

# mot

self.parser.add_argument('--data_cfg', type=str,

default='../src/lib/cfg/mot15.json',

help='load data from cfg')

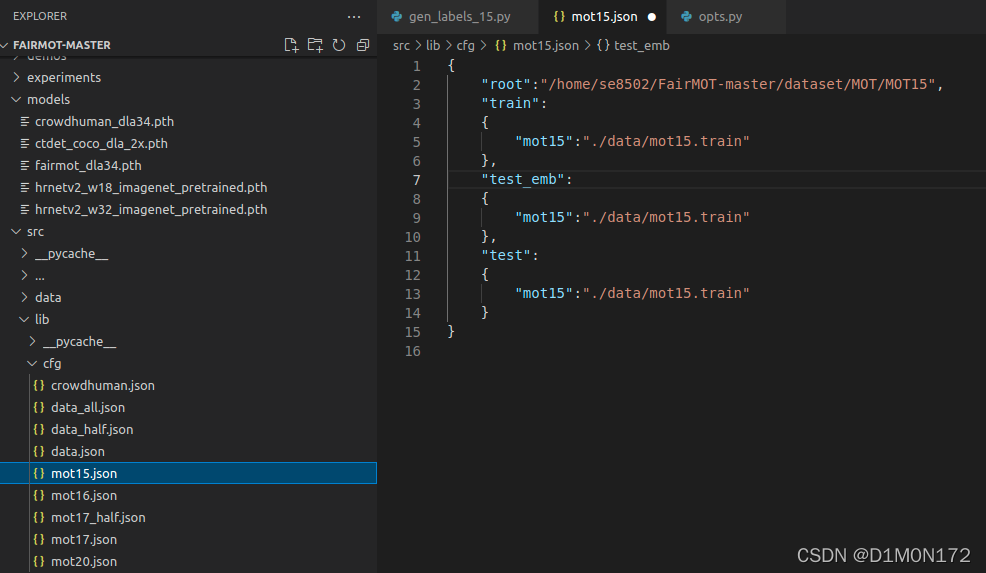

self.parser.add_argument('--data_dir', type=str, default='/home/se8502/FairMOT-master/dataset/MOT/MOT15')打开src/lib/cfg/mot15.json

修改为自己的数据集地址:

{

"root":"/home/se8502/FairMOT-master/dataset/MOT",

"train":

{

"mot15":"./data/mot15.train"

},

"test_emb":

{

"mot15":"./data/mot15.train"

},

"test":

{

"mot15":"./data/mot15.train"

}

}

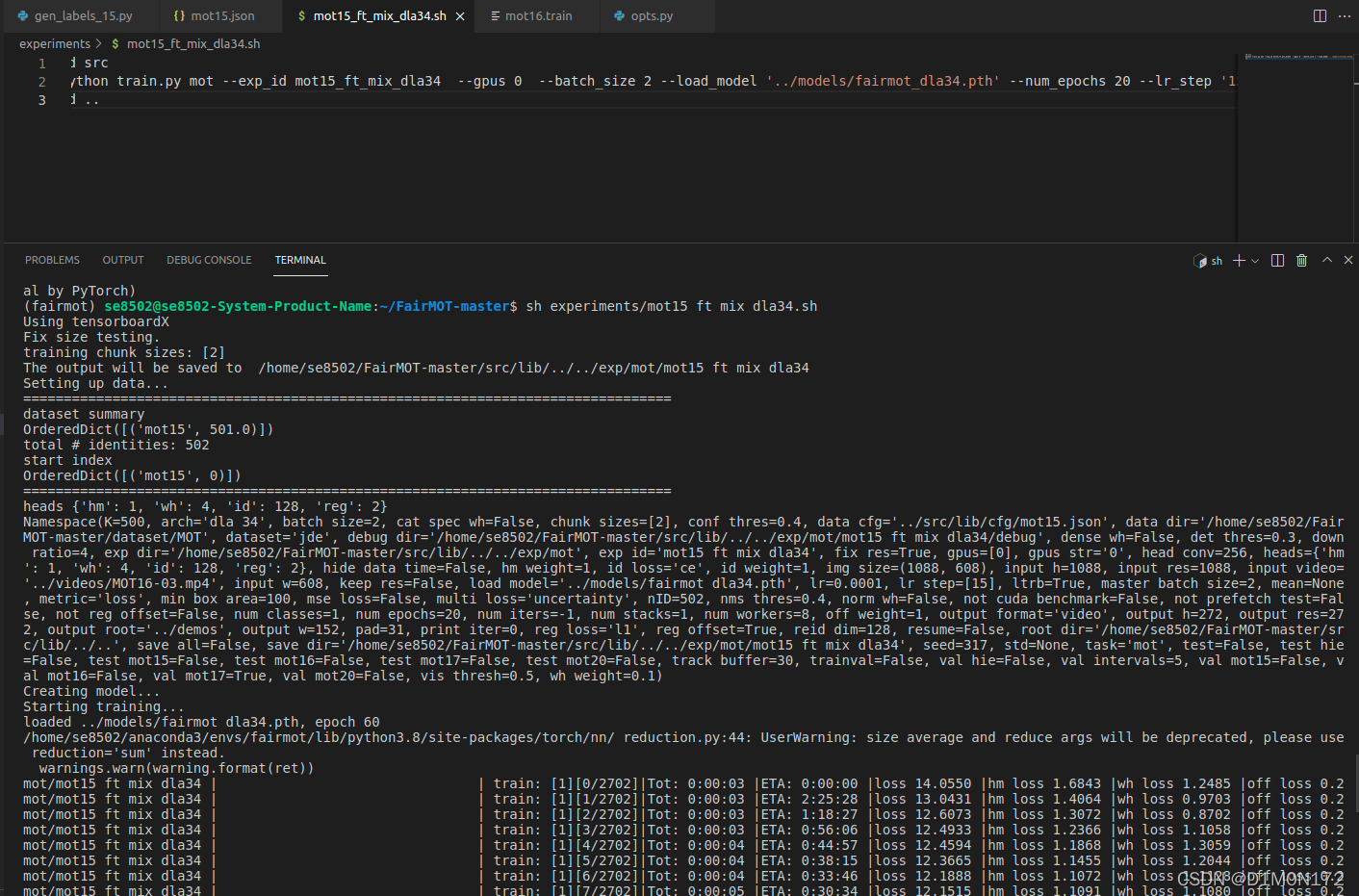

5.训练:

根据自己实际,修改mot15_ft_mix_dla34.sh,训练按照下面的代码:

sh mot15_ft_mix_dla34.sh

========================2021.12.04.03.50================

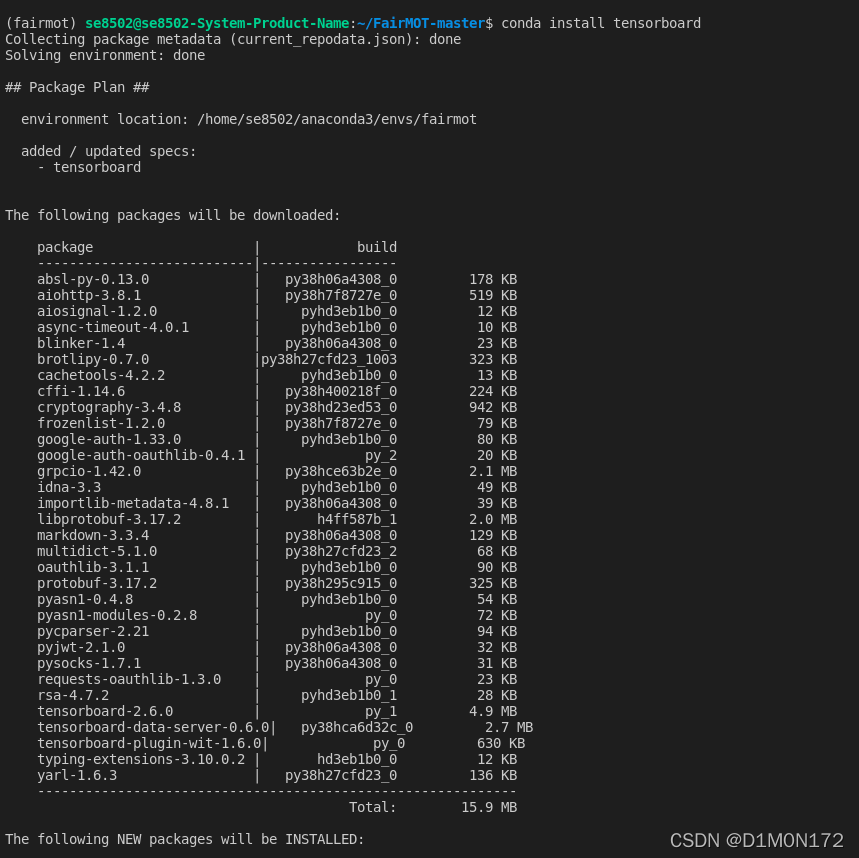

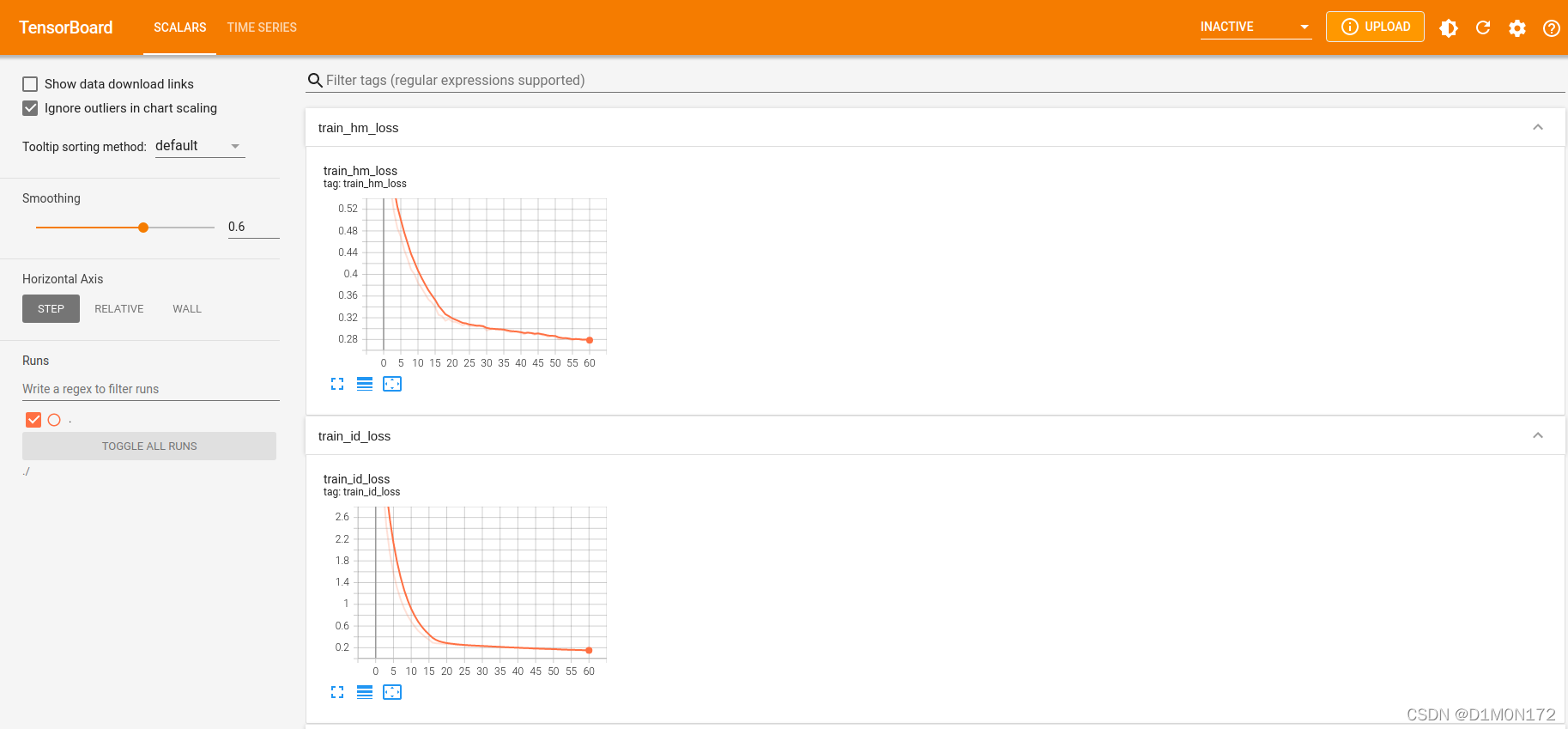

可视化:

安装tensorboard

conda install tensorboard

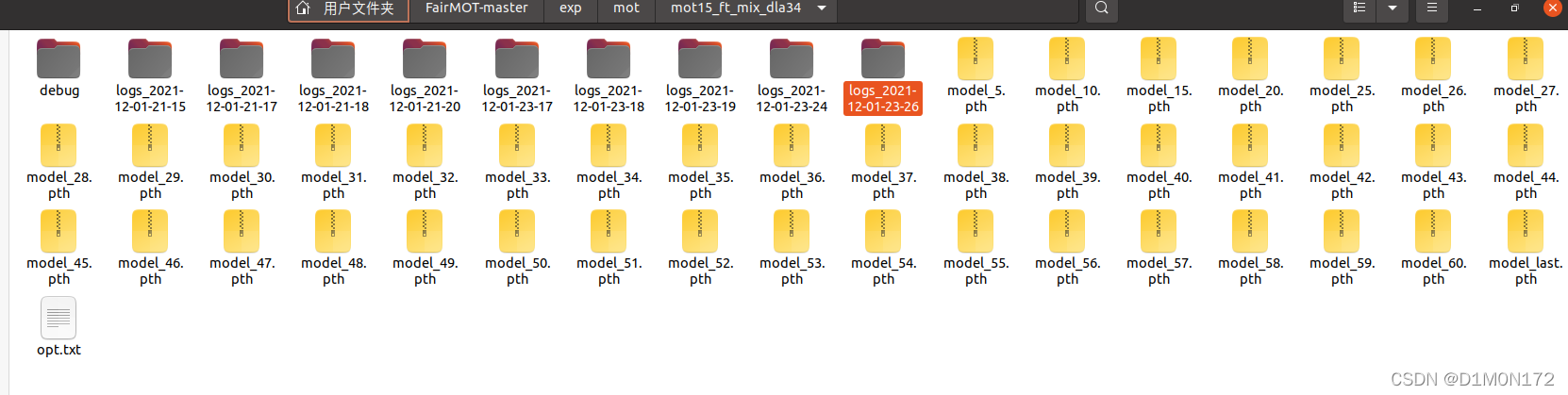

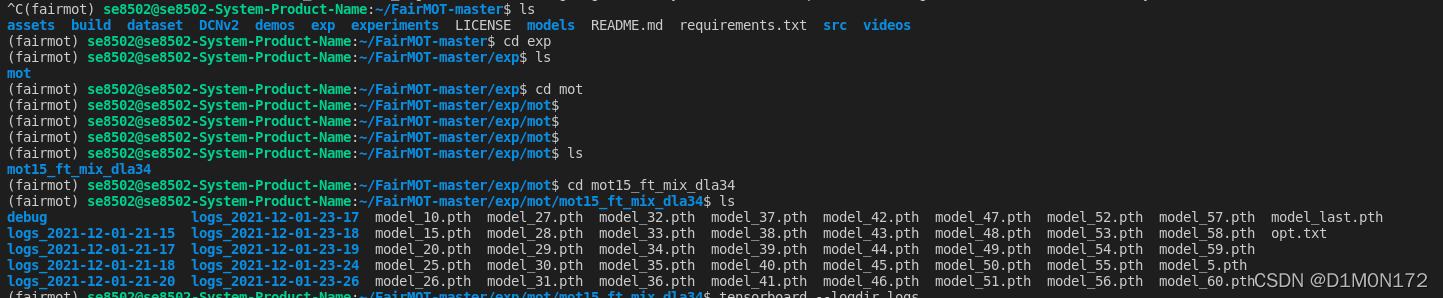

进入文件

/home/se8502/FairMOT-master/exp/mot/看到训练的文件

进入

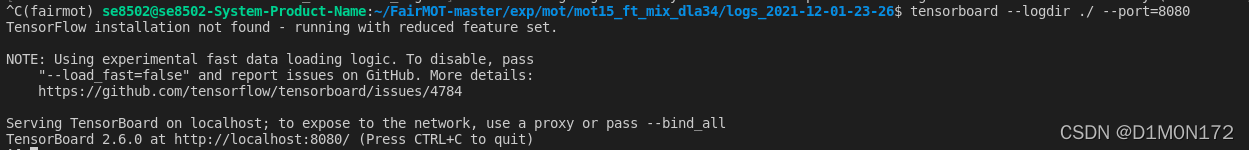

接下来输入:

tensorboard --logdir ./ --port=8080

打开链接:

可以看到可视化的内容

可以看到可视化的内容

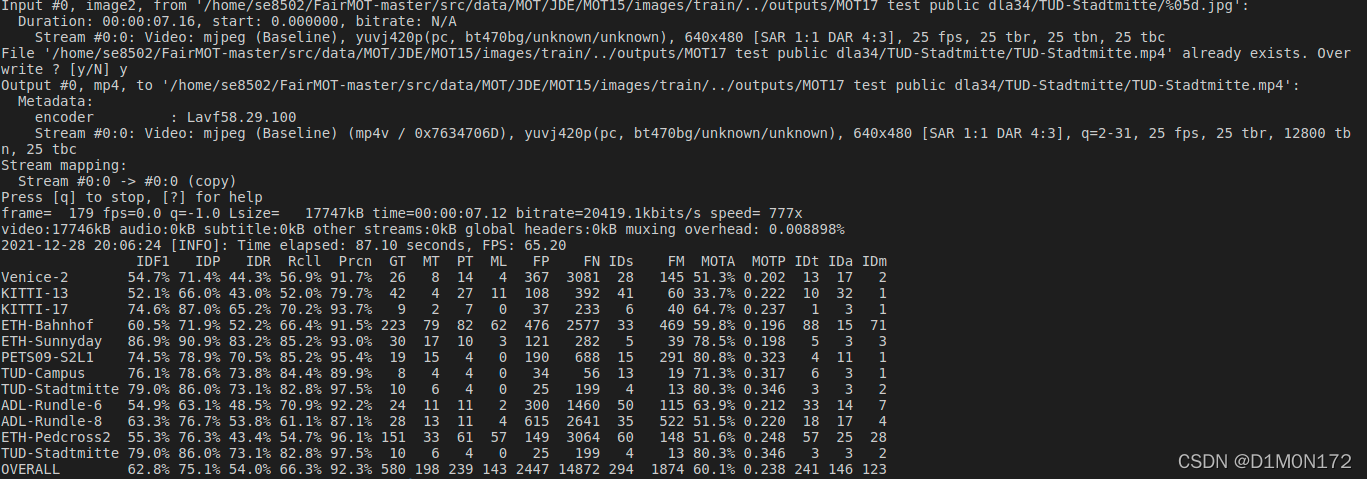

评估网络:

CUDA_VISIBLE_DEVICES=0 python track.py mot --val_mot15 True --load_model ../models/fairmot_dla34MOT17.pth --conf_thres 0.6 --save_all

FairMOT训练及可视化教程

FairMOT训练及可视化教程

本文档详细记录了使用FairMOT进行目标检测与跟踪的步骤,包括环境配置、数据集准备、模型训练、可视化设置以及评估网络的过程。

本文档详细记录了使用FairMOT进行目标检测与跟踪的步骤,包括环境配置、数据集准备、模型训练、可视化设置以及评估网络的过程。

https://blog.youkuaiyun.com/qwazp3526cn/article/details/121527060

https://blog.youkuaiyun.com/qwazp3526cn/article/details/121527060

6052

6052