直观理解和本质

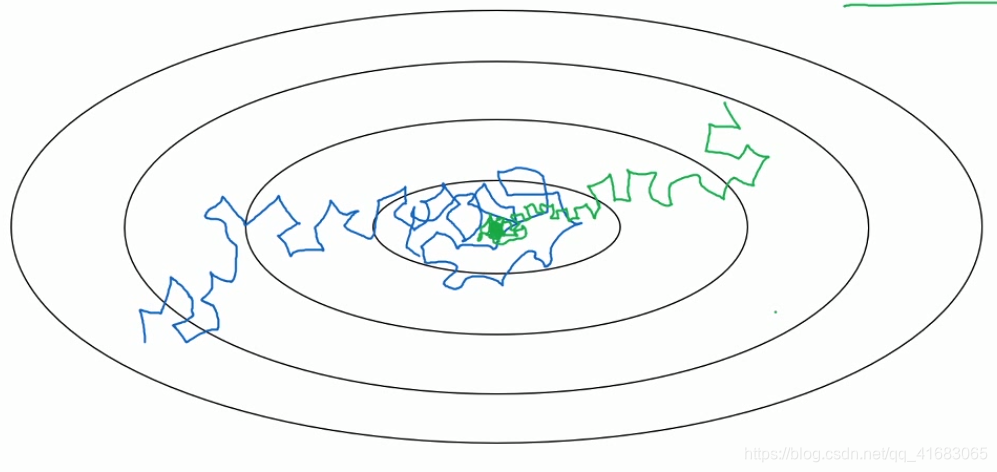

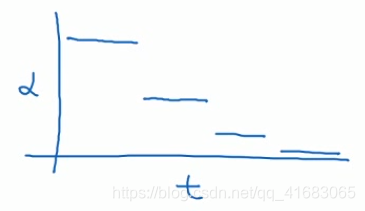

对于没有设置学习率衰减的,寻找到成本函数最小值的路径为蓝色(带有噪音,不收敛,最后在最小值周围浮动)

对于设置了学习率衰减的,寻找到成本函数最小值的路径为绿色(在初期学习率还大,学习速度相对较快。随着α减小,步伐变小变慢,最后曲线会在最小值附近的一小块区域摆动)

学习率α衰减的本质在于:在学习初期可以承受较大的步伐,但当开始收敛的时候,小一些的学习率能让步伐小一些。

实现方法

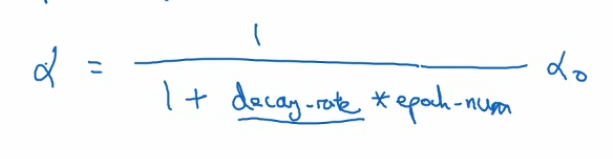

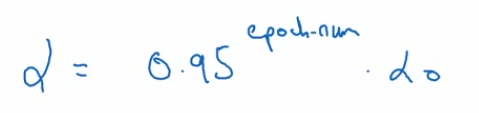

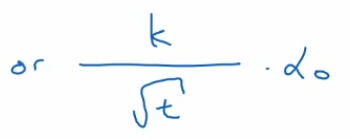

常用的学习率衰减公式:

decay-rate也是一个需要人为设置的超参数。

吴恩达老师:对我而言,学习率衰减并不是我要尝试的要点。设定一个固定的α,然后好好调整,会有很大的影响。学习率衰减确实大有裨益,有时候可以加快训练,但它并不是我会率先尝试的内容。

本文探讨了学习率衰减在机器学习中的应用。通过对比设置与未设置学习率衰减的情况,阐述了其如何帮助算法更高效地收敛到成本函数最小值。介绍了学习率衰减的本质及其实现方法。

本文探讨了学习率衰减在机器学习中的应用。通过对比设置与未设置学习率衰减的情况,阐述了其如何帮助算法更高效地收敛到成本函数最小值。介绍了学习率衰减的本质及其实现方法。

34万+

34万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?