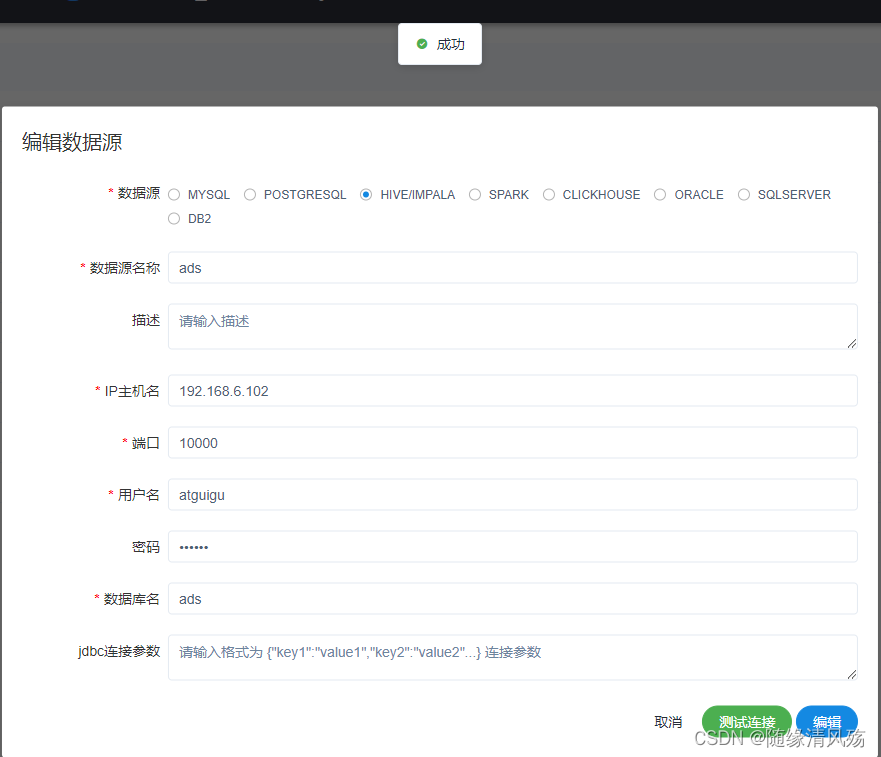

1、hive数据源配置

(1)hive的多用户配置

hive本身不创建用户,用户就是linux的用户,

(2)打开hive的server服务

- 第一步:运行hive下bin/hiveserver2脚本

./hiveserver2

- 第二步:新建xshell窗口

beeline

# 2、连接hive2

!connect jdbc:hive2://192.168.6.102:10000

# 3、输入用户名和密码

Enter username for jdbc:hive2://192.168.6.102:10000: atguigu

Enter password for jdbc:hive2://192.168.6.102:10000: ******

- 第三步:打开hive的WEB端

hadoop102:10002

(3)海豚调度器创建资源

(3)常见问题

- 问题原因

# 1、检查hiveserver是否启动

netstat -anp |grep 10000

- 解决方式

启动hiveserver2

2、Spark数据源配置

(1)启动Spark thritfserver

sbin/start-thriftserver.sh --hiveconf hive.server2.thrift.port=10001 --master yarn --driver-cores 1 --driver-memory 1G --executor-cores 1 --executor-memory 1G -num-executors 2

- 运行结果如下

(2)连接数据源

3、mysql数据源配置

(1)开启mysql服务

sudo systemctl start mysqld

- 运行结果

(2)连接数据源

4、Oracle数据源配置

(1)将Oracle的ojdbc5.jar和ojdbc6.jar拷贝到lib目录

- 注意:本机版版本为oracle11g

(2)连接Oracle数据源

本文详细介绍了Hive和Spark的数据源配置步骤,包括Hive的多用户配置、服务启动、WEB端口访问及常见问题排查;Spark Thrift Server的启动参数设置和连接方法;同时涉及MySQL和Oracle数据库的服务启动与连接配置。

本文详细介绍了Hive和Spark的数据源配置步骤,包括Hive的多用户配置、服务启动、WEB端口访问及常见问题排查;Spark Thrift Server的启动参数设置和连接方法;同时涉及MySQL和Oracle数据库的服务启动与连接配置。

3286

3286

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?