要全面理解神经网络的构成要素及其相互关系,我们需要从建模全流程的角度,讲神经网络视为一个由多个正交维度共同定义的“设计空间”。下面我将完整列举**神经网络的核心组成要素(共8大类)、解释每一类的具体内容、用一张关系图说明它们如何协同工作、澄清常见混淆点**。

一、神经网络的八大核心要素

🔔 注意:你提到的“激励函数”更标准的术语是 激活函数(Activation Function),它属于 第2类“神经元模型” 的一部分。

二、具体细节

-

网络结构(Network Structure)

描述层与层之间的连接方式和拓扑。

示例:

前馈(MLP)

卷积(CNN)

循环(RNN/LSTM)

图结构(GNN)

自注意力(Transformer)

编码器-解码器(Seq2Seq)

决定模型能捕捉什么模式(局部相关性?长程依赖?图结构?) -

神经元模型(Neuron Model)

定义单个单元的输入-输出映射。

核心公式:

a=ϕ(∑wixi+b)

包含:

激活函数(Activation Function):ReLU、Sigmoid、Tanh、Swish 等

特殊单元:LSTM 门控单元、胶囊(Capsule)、脉冲神经元(Spiking Neuron)

决定非线性表达能力 -

学习范式(Learning Paradigm)

定义学习任务的性质。

主要类型:

监督学习(Supervised)

无监督学习(Unsupervised)

自监督学习(Self-Supervised)

强化学习(Reinforcement Learning)

半监督 / 迁移 / 元学习等

决定是否需要标签、奖励或其他监督信号 -

训练机制(Training Mechanism)

指参数如何更新。

包括:

优化算法:SGD、Adam、RMSProp

梯度计算方式:反向传播(BP)、Policy Gradient、Evolution Strategy

训练策略:批量训练、在线学习、课程学习

决定学习效率和收敛性 -

目标函数(Objective Function)

定义优化目标。

类型:

监督学习:交叉熵、MSE、Hinge Loss

无监督:重构误差(AE)、KL散度(VAE)、对比损失(SimCLR)

强化学习:累积奖励(Return)、优势函数(Advantage)

与学习范式强相关,是训练机制的输入 -

正则化与泛化策略(Regularization)

防止过拟合,提升泛化。

方法:

L1/L2 权重衰减

Dropout

数据增强

Early Stopping

Batch Normalization(也有归一化作用)

独立于结构,但影响训练动态 -

初始化与归一化方法

初始化:Xavier、He 初始化 → 影响梯度传播

归一化:BatchNorm、LayerNorm、GroupNorm → 稳定训练

虽不改变模型容量,但极大影响可训练性 -

应用场景与数据特性

最终驱动所有设计选择的根本原因。

例如:

图像 → CNN

文本序列 → RNN/Transformer

图数据 → GNN

小样本 → Meta-Learning

没有“最好”的模型,只有“最适合任务”的组合

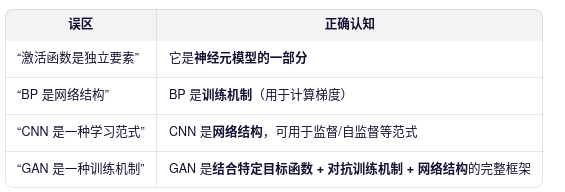

三、常见误区澄清

四、以ResNet为例子,说明8个维度的表现

五、总结

✅ 总结

神经网络不是单一技术,而是一个多维设计空间。你提到的“学习范式、网络结构、训练机制、激活函数”确实是核心,但还需补充:

目标函数(定义优化方向)

正则化策略(控制泛化)

初始化与归一化(保障可训练性)

数据与任务(一切设计的起点)

🌟 真正强大的AI工程师,不是记住模型名字,而是理解这8个维度如何组合以解决实际问题。

637

637

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?