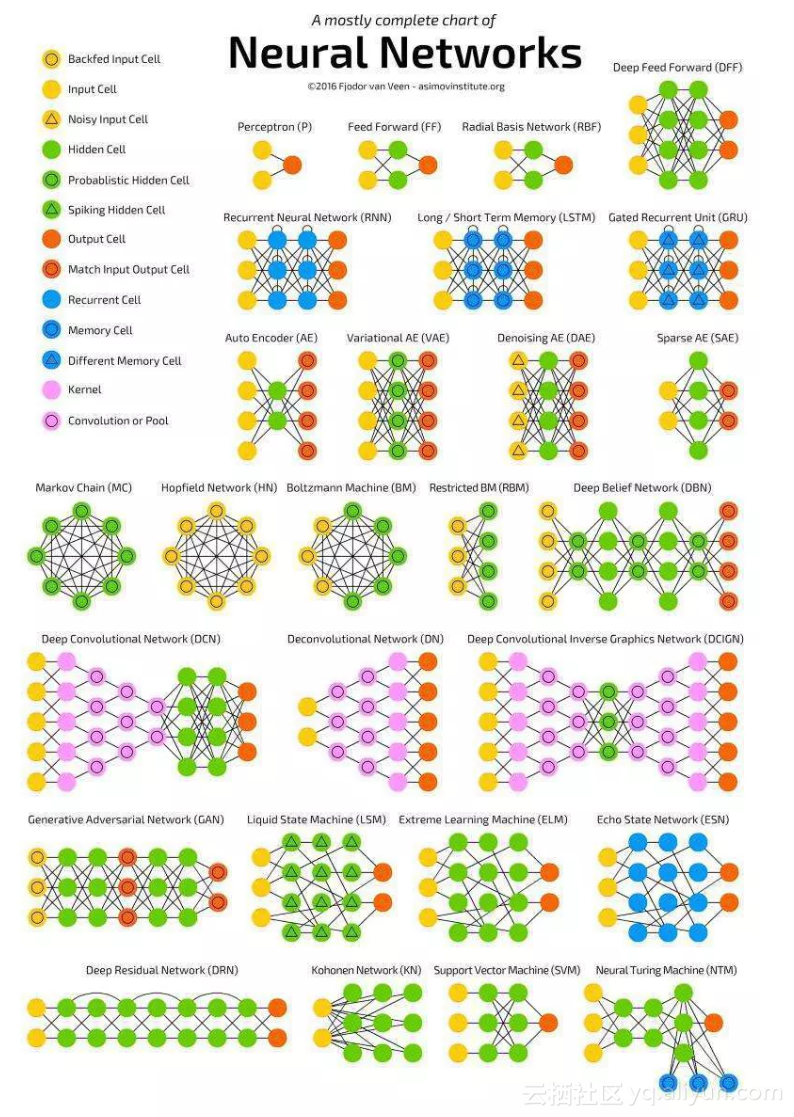

神经网络结构可视化图展示了 27 种不同类型的神经网络模型,并通过统一的图示语言清晰地表达了它们的连接方式、单元类型和信息流动结构。其核心分类逻辑是“拓扑结构 + 单元类型” 的混合体系,这张图不是简单地按“任务”或“时间”分类,而是基于两个关键维度进行系统化组织:

🔹 1. 连接方式(Topology)

前馈 vs 反馈 vs 图结构 vs 混合

是否存在循环、跳跃、记忆等

🔹 2. 神经元/单元类型(Cell Type)

使用了哪些特殊单元?

输入层、隐藏层、输出层

神经元(圆圈)、记忆单元(蓝色)、脉冲神经元(三角)、卷积核(粉色)等

一、图中模型的完整列表与分类(共27种)

⚠️ 注意:第26项 SVM 并不是神经网络,但它被列在图中作为对照,说明作者意图是展示“类似结构的模型”。

二、颜色图例详解(关键理解工具)

图左侧的颜色图例定义了不同节点的含义:

🧩 这些符号让读者能“看图识结构”,非常直观!

三、收录对象分类策略和划分逻辑

📌 这不是严格的学术分类,而是一种“结构+功能”的教学式枚举,其划分依据是:

拓扑结构(前馈、循环、图、卷积)

单元类型(普通神经元、记忆单元、脉冲神经元、卷积核)

是否引入新机制(注意力未出现,因2016年尚未普及)

是否属于主流或代表性模型(如CNN、RNN、GAN、DBN)

这张图之所以能列出27种,是因为它覆盖了以下几类重要方向:

✅ 它是一个面向教育和认知的综合性图谱,目标是帮助初学者建立对神经网络多样性的整体认识。

四、隐藏的"大佬" Transformer

众所周知,该图来源于《A mostly complete chart of Neural Networks》(2016,Fjodor van Veen),是 对2016年前神经网络架构的一次全面盘点,其划分标准是:

✅ 以“连接方式”为核心(前馈、循环、图、卷积)

✅ 以“单元类型”为辅助(记忆、脉冲、卷积、概率)

✅ 以“代表性模型”为目标(涵盖经典、前沿、实验性结构)

✅ 兼顾教学直观性(通过颜色和符号快速识别结构)

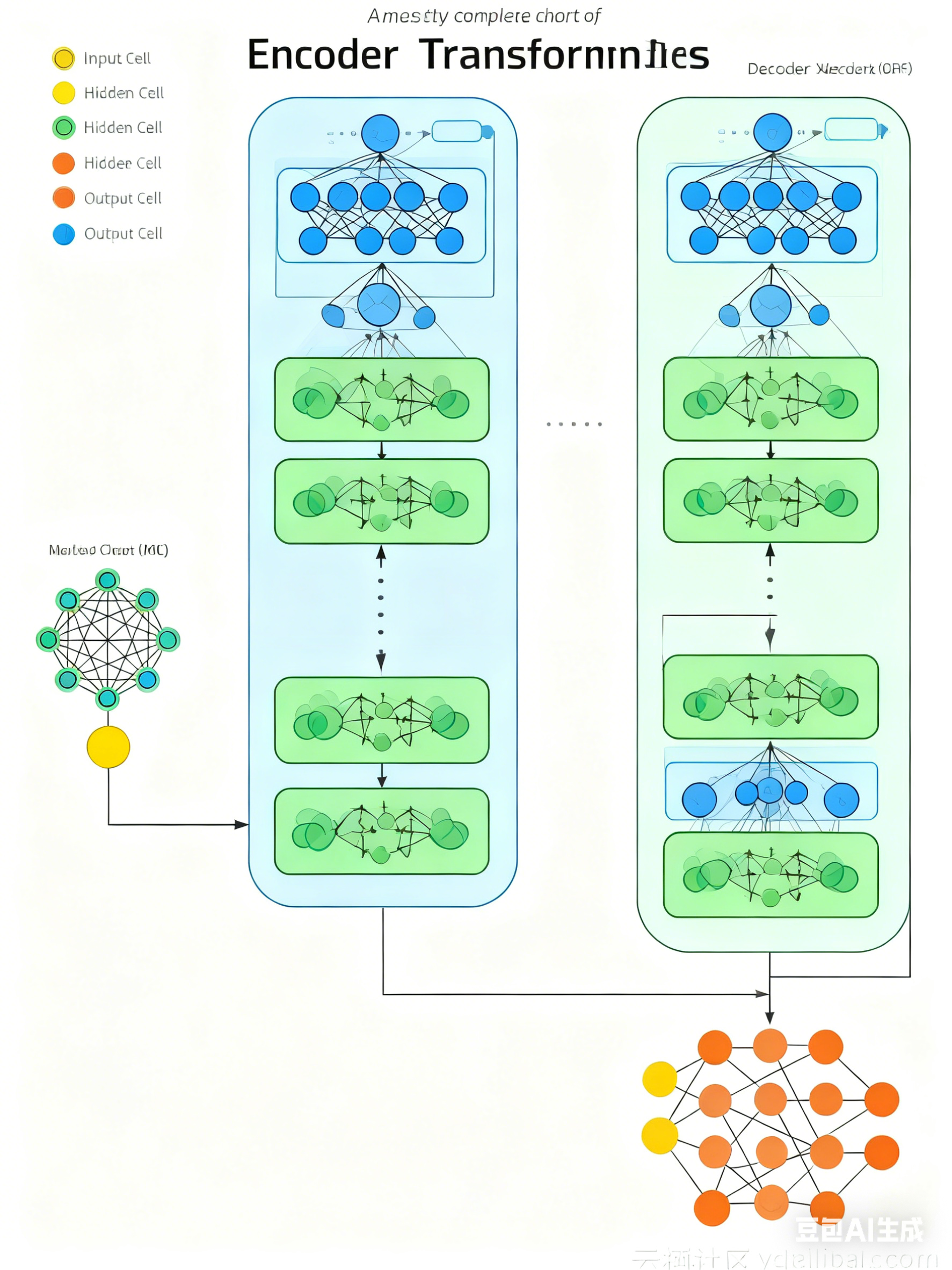

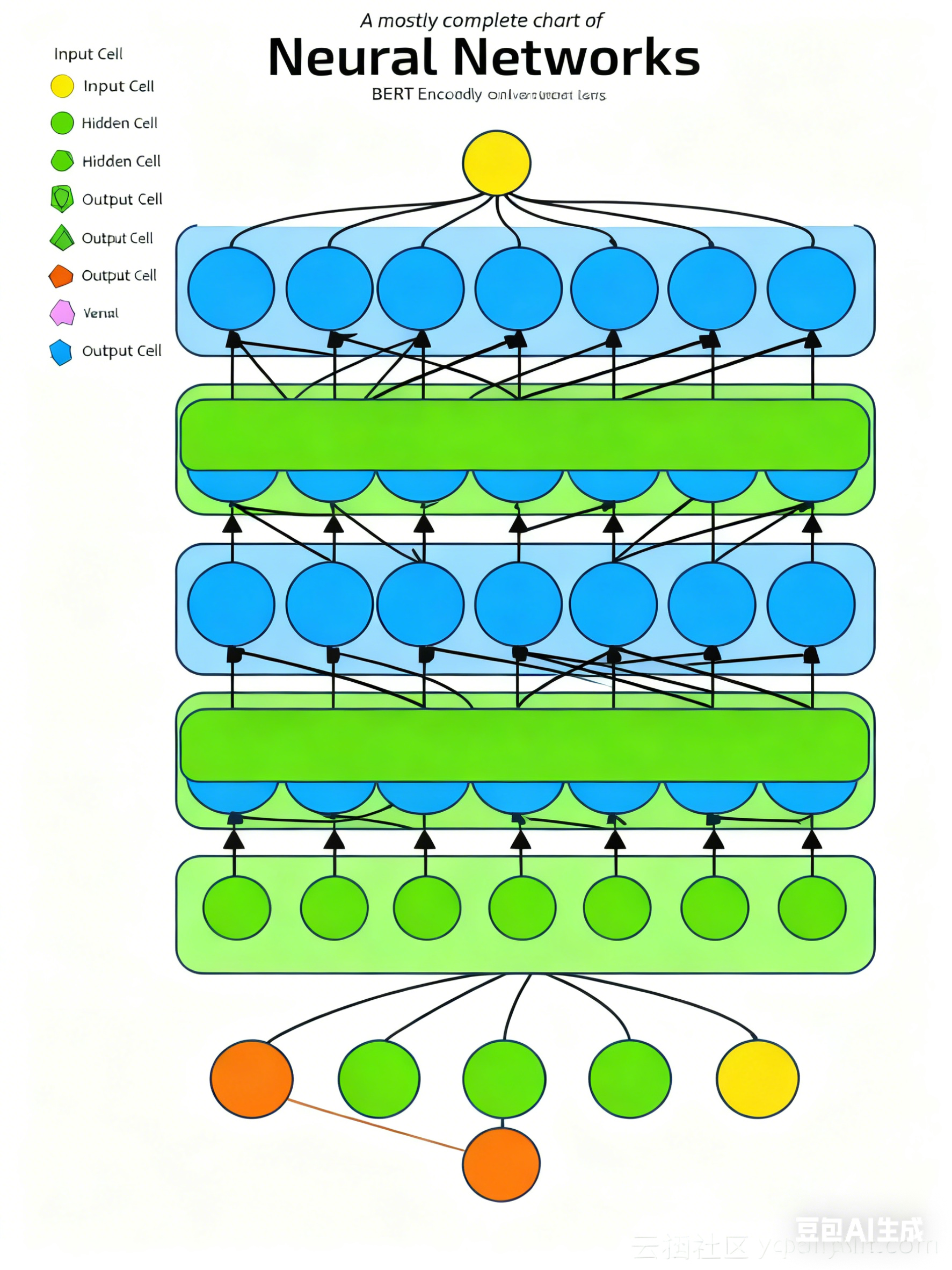

它不是完美的科学分类,而 Transformer 是 2017 年才提出的论文(Attention is All You Need)。所以它不可能包含 Transformer 或 BERT/GPT 等后续大模型。Transformer = 前馈网络 + 自注意力机制,若加入“注意力单元”符号,也可画出其结构。其神经网络的结构拓扑图可表示如下:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?