众所知周深度学习(DL)中,神经网络需要依托数据优化各个神经元的参数,也就是训练。那么优化的是什么参数!!!下面逐步探讨展开:

一、单个神经元的数学模型

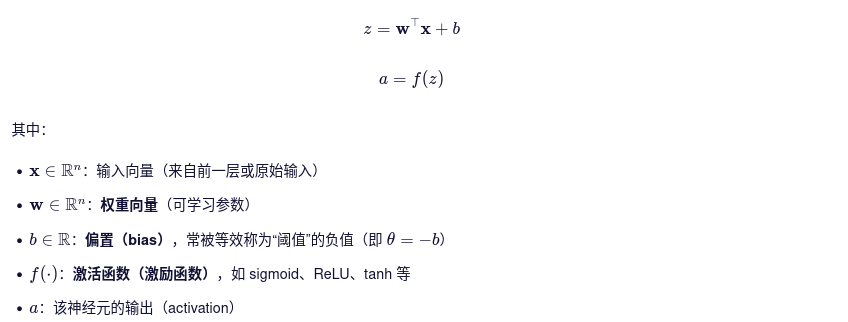

一个典型的神经元(如MLP中的单元)可表示为:

这里的激活函数是固定的函数形式,比如你选择用sigmoid,那整个训练过程中它的函数形式始终是不变的,也不含可调参数(除非特别设计、如PReLU)。

二、哪些参数会被梯度下降优化?

在标准MLP中,可学习(可优化)的参数只有两类:

| 参数类型 | 符号 | 是否可学习 | 说明 |

|---|---|---|---|

| 权重 | w | 是 | 连接输入与当前神经元的强度 |

| 偏置 | b | 是 | 控制激活函数的“偏移”位置 |

激活函数本身不是参数,不被优化(除非使用可学习激活函数,如Swish中的β,但这是高级变体,不在基础BP范畴内)。

因此,针对单个神经元,梯度下降优化的参数就是:

- 所有权重w1,w2,…wn;

- 偏置b

三、为什么偏置b(即“阈值”)需要优化?

虽然激活函数f的形状固定,但它的“触发点”由z=W^T*X+b决定。偏置可以控制输入数值在那个范围内变化可以获得更大的输出数值波动(类似阀门,所以称为阈值),因此在训练中,必须通过梯度下降调整不,使神经元在适合的输入条件下**“激活”**。

四、常见误区

容易混淆的两个概念:

| 概念 | 说明 |

|---|---|

| 激活函数的形式 | 如sigmoid,tanH,ReLU – 认为选定、训练中固定 |

| 激活(输出随输入大幅度变化)发生的“位置” | 由z=W^T*X+b决定 – 由b控制、需学习 |

简而言之,激活函数决定了“怎样通断”(形状),而偏置b决定了“在哪里通断”(偏置位置)。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?