对机器人的歧视:探讨社会互动的伦理及谁受到伤害

1 引言

在过去的几十年里,机器人已广泛应用于工业领域,执行零件组装、点焊、物料搬运和喷漆等任务[1]。最近,机器人已进入劳动力市场的其他领域,经常与人们密切接触,并执行需要多种社交技能的任务。例如,在零售和 hospitality 行业中,机器人可担任顾客迎宾员[2]、购物助手[3]和导览员[4];在教育领域,机器人可担任教师和助教[5];在娱乐领域,机器人可作为表演者[6]。此外,机器人正以朋友或伴侣的角色进入社会,展现出日益增强的社交技能[7]。

机器人专家、哲学家、法律学者和立法者普遍认为,随着机器人进入社会,它们对人类采取合乎伦理的行为是可取的[1,8–13]。通常,机器人伦理是信息伦理这一新兴领域中的一个课题,其关注的是规范人类在社会中对待机器人的伦理标准和道德准则。坦布里尼[16]将机器人伦理描述为“应用伦理学的一个分支,致力于识别和分析与当前及未来机器人使用相关的伦理问题”(p. 12)。坦布里尼还提出了一个问题:我们是否应该“[…]像对待人类一样,将机器人视为道德主体以及基本权利的享有者?”(p. 12)(参见[17])。同样,阿萨罗[8]评论指出,机器人伦理应关注与人类对待机器人行为相关的伦理问题,这是一个相对未被探索的主题,也是本文的重点。通常,伦理涉及社会对人类行为的标准,包含指导人们如何在社会中生活或在特定情境下如何行为的准则[18]。本文认为,新兴的社交机器人对当前的伦理观念构成了重大挑战,由于针对机器人的歧视性、偏见性和攻击性行为,各类个体可能从心理和情感层面受到伤害。

在人们与机器人互动方面,新兴证据表明,人们在各种情况下可能会对机器人产生歧视,例如基于机器人的感知性别、种族或民族[19–21];然而,针对机器人歧视的政策讨论才刚刚开始[22,23]。在美国,有关反歧视的立法促成了1964年民权法案第七章的通过,该法案旨在禁止在就业和住房方面出现种族、宗教、性别、民族和肤色歧视(另见[24])。如前所述,《民权法案》将民族、性别和肤色列为可能导致对个人歧视的类别;有趣的是,这些类别代表的特征也可能被赋予机器人(一般参见[25])。这就引发了一个问题:当机器人被设计具有在过去曾导致人类之间发生歧视的物理特征时,人类是否会对其表现出歧视行为[19,26,27]。

根据现行反歧视法,受害方是自然人而非人工实体,因此,对机器人学界而言,一个值得关注的问题是:当人类对机器人进行歧视时,是否有任何一方受到伤害?如果有,是否应制定新的政策、法律和伦理准则来禁止机器人歧视?此外,针对机器人实施歧视性行为的可能性,引发了关于人类对机器人对待的有趣伦理问题,特别是考虑到当前的机器人并不被视为具有独立道德考量性的实体[28]。尽管有意识机器人的权利是一个引人入胜但面向未来的话题,然而,即使是缺乏自我意识的机器人,如果此类行为对人类行为者造成了伤害,那么对机器人的伦理对待便成为社会合法关注的问题。

也许最著名的机器人伦理讨论是艾萨克·阿西莫夫提出的机器人三定律。这三条定律如下:“机器人不得伤害人类,或因不作为而使人类受到伤害;机器人必须服从人类给予的命令,除非该命令与第一定律相冲突;机器人必须保护其自身存在,只要这种保护不与第一或第二定律相冲突”[29]。阿西莫夫的前两条机器人定律直接保护了人类的权利,相对于机器人而言,但并未赋予机器人自身权利,即缺乏针对机器人自身的歧视性或其他有害行为的保护。然而,第三定律为机器人提供了一定程度的保障——机器人被允许保护其“自身存在”(只要这种保护不与第一和第二定律相冲突),但这意味着机器人必须意识到它确实存在,并且认为机器人拥有需要保护的权利。机器人最终可能获得意识并采取行动来维护自身权利,这当然是一个有争议的话题。但对于本文的讨论而言,机器人意识并非机器人歧视对社会整体乃至在某些情况下对特定个体产生伦理和政策后果的必要条件[30]。

2 当前机器人伦理的观点

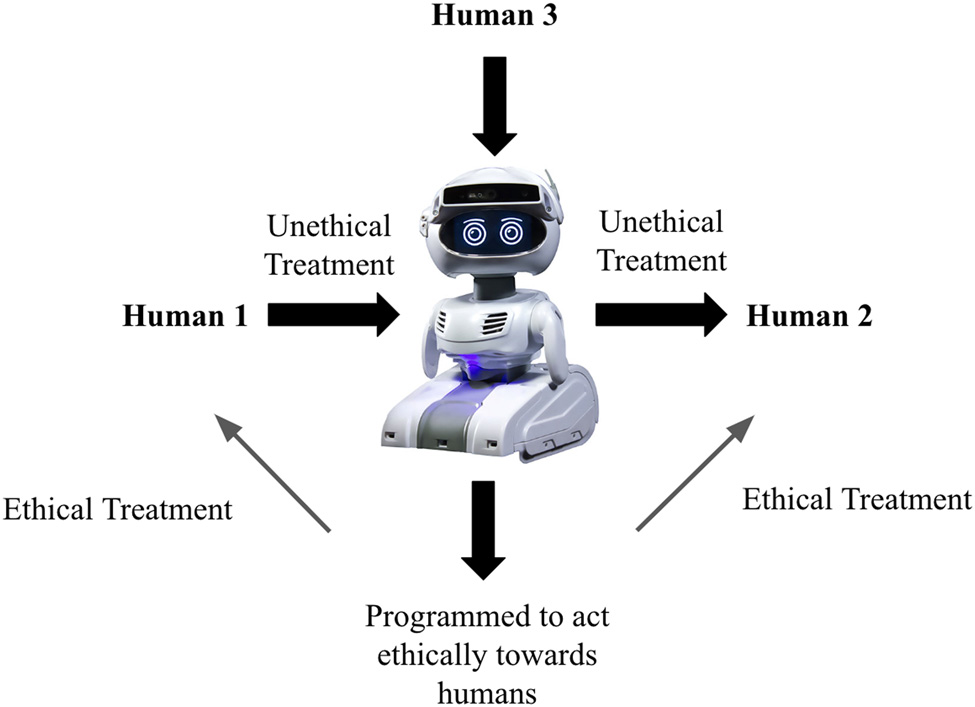

一般来说,机器人伦理是一个广泛的议题,引起了机器人专家、哲学家和社会科学家的兴趣,而且很可能有多种因素会影响人类在与机器人互动时是否遵循伦理考虑。阿萨罗[8]在讨论我们对机器人伦理的期望时,指出了三个需要考虑的方面。第一个方面是,一个人类(可能是机器人的操作员)(人类3,图1)可能通过使用机器人对另一个人类(人类2,图1)做出不道德的行为[30,31]。其次,根据阿萨罗的观点[8],应设计机器人使其自身不会做出不道德的行为。第三,我们可以考虑人们(图1中的人类1)应如何根据行为的伦理标准对待机器人[8]。本文后面的章节将重点讨论图1中所示的人类行为者。

此外,阿布尼[32]将机器人伦理描述为具有不同的含义:(i)设计机器人的机器人专家的职业伦理;(ii)编程到机器人中的道德准则(有时称为机器伦理);或(iii)机器人进行伦理推理的意识能力。在扩展阿布尼的分类和阿萨罗的[8]观点的基础上,对于进入社会并在社会情境中被体验的机器人,我提出,机器人伦理应关注那些与机器人互动的人给予机器人的伦理对待。并且进一步认为,即使机器人并未意识到针对它的歧视性行为,机器人伦理这一主题对于伦理领域以及人机交互(HRI)仍然具有相关性。然而,在本文主要关注缺乏对针对自身的歧视行为意识的机器人所受到的伦理对待(即当前的情况)的基础上,我简要探讨了一个未来场景,即机器人获得意识并意识到自己曾是歧视的对象;在这种情况下,一个重要问题将是确定当涉及有意识的人工代理时,应应用哪些伦理规则和政策来指导人机交互[33–35]。

2.1 伦理、机器人与歧视

与人类互动的机器人以多种方式与人们进行交互;它们会与我们对话,服从我们的指令,并可能通过分析我们的面部特征来判断我们的意图,甚至情绪状态[36]。根据计算机作为社会行为体(CASA)范式,人类倾向于以类似于与他人互动的方式与机器人互动[37]。在这方面,埃塞尔和库琴布兰特[25]观察到,人们在判断不熟悉的非人类实体时,会依赖自身的自我认知或对其他人的认知(见[38])。同样,康等人[39]总结了数十年关于歧视的研究,表明社会认知会影响我们对被归入不同群体的个人的评价和行为。需要注意的是,CASA范式并不预测人类与机器人之间的互动将是积极的(或具有某种伦理正当性),而仅仅是说这种互动将类似于人类彼此之间的互动方式。基于这一点,先前研究的结果表明,当人们与机器人互动时,可能会对机器人表现出偏见,这种偏见与当前有色人种、特定族群或某一性别所遭受的偏见并无不同(参见一般情况[21,40,41])。因此,随着机器人在社会中日益普及,与人机交互(HRI)相关的伦理问题已变得愈发重要。

简而言之,机器人伦理与政策方面的一些问题如下:(i)能否赋予机器人人格地位,使其能够主张权利?(ii)对机器人歧视是否违反当前的伦理标准?(iii)整个社会或目睹针对机器人歧视行为的人们,在观看此类歧视行为时是否会受到伤害?

是否可能对机器人实施歧视,或在某些情况下甚至产生极端敌意,这一问题的提出是基于当前对待机器人的实例以及历史事件。一个针对机器人表现出敌意的近期例子发生在2019年,当时有人踢倒并推翻了一台重达400磅的安保巡逻车库结构的机器人[42]。另一个例子中,曾在加拿大和欧洲部分地区成功搭便车旅行的机器人hitchBot,在费城被不明袭击者毁坏[43]。此外,从十八世纪的历史视角来看,大不列颠的纺织工人曾发起一场叛乱,他们认为技术引入工作场所威胁到了他们的生计;因此,“卢德分子”摧毁了相关设备[44]。

尽管上述例子显示了对机器的极端敌意,但正如CASA理论所讨论的那样,人们通常以更为微妙或刻板的方式对机器人作出反应,例如根据机器人的外观或行为赋予其人类特征[45,46]。关于机器人,斯帕罗[19]指出,人们会将种族和/或民族身份归于机器人,并提出相关研究显示机器人被划入种族类别这一现象,为制造人形机器人带来了独特的伦理和政治挑战。斯帕罗[19,27]进一步认为,设计可能被感知为代表某一特定种族的人形机器人,对机器人设计师而言构成了一个困难的伦理问题[19]。巴菲尔德[26]发现,机器人的表面颜色(黑色、棕色、白色)可能影响用户选择让机器人执行的任务,这表明感知的机器人种族(取决于机器人的表面颜色)可能影响用户对机器人的评价。

人们会将机器人拟人化,这一点已在多项研究中得到证实。这表明,如果一个人与具有不同于观察者属性的机器人互动,该人可能会以刻板或歧视性的方式对待该机器人[25,38,45,47–50]。事实上,许多社会心理学研究得出结论,内群体或外群体偏见,从而导致优待或非优待待遇,可能由身体相似性的标志(例如肤色)所触发;而对于机器人而言,则是用于设计机器人表面的材料的颜色[26]。为了说明这一点,巴特内克等人[51]指出,使用不同颜色设计的机器人会被观察者“种族化”。此外,埃塞尔和库琴布兰特[25]发现,当观察者认为某个机器人代表了不同族群的一员时,他们会表现出带有偏见的反应。上述研究凸显了一点:那些被视为观察者“外群体”成员的机器人,其评价往往低于被视为“内群体”成员的机器人——研究人员已表明,这种反应在各种情境下可能导致对外群体成员的歧视(参见一般情况[21])。

从理论角度来看,正如CASA范式所预测的那样,人们将机器人视为社会行为体,并在某些情况下,仿佛它们具有种族[21,50]。巴特内克等人[51]以及皮斯基[52]指出,在形成对他人的看法时,我们通常依赖于年龄、性别和种族等社会线索(另见[53])。根据以往研究的结果,人类倾向于依据种族特征进行识别和刻板印象化,这种倾向在人与机器人的互动中同样普遍存在[21,41]。例如,埃塞尔和赫格尔[20]表明,人们会利用多种线索对非人类实体进行分类,并且也倾向于将机器人归入种族和民族类别。埃塞尔和库琴布兰特[25]在研究针对机器人的偏见时,让德国公民评估被赋予土耳其或德国身份的机器人。他们的研究结果表明,当同一机器人被介绍为外群体的土耳其产品时,相较于被介绍为内群体的德国产品,德国公民对其偏好更低。此外,德安杰利等人[53]发现,当与具有类人形态和性别特征的技术互动时,人们更可能表现出反社会行为,而具有女性性别特征设计的机器人可能会成为无意的性关注和骚扰对象(见[54])。此外,巴特内克等人[51]注意到,对机器人外形和发型的操控常常引发性别刻板反应。鉴于机器人可能被视为代表特定性别,这些发现为人机交互(HRI)提出了有趣的问题:例如,设计外观为女性并期望其承担社会性别角色的机器人是否符合伦理[46]。总结上述讨论,先前的研究表明,个人会根据感知到的民族、种族和性别维度,将机器人评价为内群体或外群体成员。本文提出的问题是:对于被视为外群体成员的机器人是否存在歧视现象?如果存在,哪些主体受到伤害?伤害的性质是什么?

随着机器人在外形上变得越来越类人化,且在智能和社交行为方面不断提升,人们日益关注是否存在对机器人的歧视现象,以及人们是否会基于性别、种族和种族刻板印象来回应机器人。例如,Eyssel和Hegel[20]研究了面部线索对机器人性别感知的影响,探讨了被设计为女性性别的机器人是否会在用户互动中被赋予女性刻板印象,以及被设计为男性性别的机器人是否会被赋予男性刻板印象。研究结果表明,影响人类社会认知的相同性别偏见也同样适用于机器人。例如,“男性外观”的机器人被赋予更多与能动性相关的特质,而“女性外观”的机器人则被赋予更多共通性特质[20]。最近,奥特巴赫和塔利亚斯[55]还发现,人们对被认为代表特定性别的机器人会做出符合刻板印象的反应。通过使用男性或女性外观机器人的视频,参与者对女性性别的机器人评价为情感温暖,而对男性性别的机器人评价为更具能动性[55]。

除了性别之外,还有其他因素会影响个体如何评价另一个人,以及他们是否对该人表现出偏见或歧视性反应。例如,正如前文所提及的,研究表明,如果一个人被视为评价者“内群体”的成员,那么他/她会得到更积极的评价;反之则会得到负面评价[49]。埃塞尔和朗厄姆[21]在社交机器人领域检验了这种内群体偏见效应。在他们的研究中,被试为高加索人,要求他们对在外形上类似于其内群体或具有“非洲中心特征”设计的社会外群体机器人进行评分。与预期相反,外群体机器人被赋予了更高的能动性;对此,埃塞尔和朗厄姆[21]解释称,这一出乎意料的结果可能源于参与者希望表现出平等主义和无偏见的态度。这种反应在多大程度上代表了对社交机器人的稳定且有效的态度,仍有待未来的研究进一步验证。埃塞尔和库琴布兰特[25]还研究了社会类别归属对人形机器人评价的影响。他们的结果表明,当被试评价一个代表其内群体或国家外群体的机器人时,不仅对内群体机器人的评价更为积极,而且在观察机器人时使用了社会分类过程和差异性社会评价[25]。

关于机器人歧视和机器人刻板印象的话题,Louine等人[41]研究了人们对特定颜色机器人的感知。受访者被展示黑色、黄色和中性色机器人的图片,并被要求对其所看到的机器人进行评价。多个维度。结果表明,黑色机器人被认为明显比黄色机器人更强壮,受访者更倾向于远离黑色机器人,而黄色机器人则被认为比黑色机器人更友善。此外,通过使用射击者偏见范式,Bartneck等人[51]提供了强有力的证据,表明人们会对被认为代表与观察者不同种族的机器人产生歧视。在他们的研究中,受试者观看了手持枪支或其他物体的白色或黑色机器人。Bartneck及其同事发现,当机器人颜色较深时,人们开枪的速度更快。在一项相关研究中,巴菲尔德[26]表明,在各种情境下,机器人的颜色能够引发人们的情感反应。通过改变机器人的表面颜色,她发现参与者认为社会对黑色或彩虹色机器人的歧视会超过对白色机器人的歧视。此外,黑色机器人被认为比白色或黄色机器人更强壮,且参与者表示,红黑色机器人比其他机器人更常被选中实施攻击。

上述研究的一个总体结论是,人类观察者能够根据机器人的外观将机器人归入不同的社会类别。值得注意的是,这是一种在早期就已发展出来的人类技能。例如,松田等人[56]使用机器人来检验婴儿对人类、类人机器人以及外形更“机械化”的机器人之间的辨别能力。受试者包括三组婴儿,分别为6至8个月、9至11个月以及12至14个月大的婴儿。在该研究中,人类和机器人的图像,或两个机器人的图像,并排呈现在婴儿的视野中,通过眼动追踪设备记录婴儿注视图像中三个区域的时间。松田及其同事的研究结果表明,年龄在6至14个月之间的婴儿能够区分外形机械化的机器人与人类,但无法区分类人机器人与人类[56]。这一结果对于人机交互(HRI)而言尤为有趣,因为心理学家通过大量研究得出结论:人们在生命早期便学会了对他人进行区分[57,58]。

3 机器人歧视:涉及的行为者与伤害

社交机器人设计和使用相关的机器人伦理和政策的一个重要问题是,如果机器人成为歧视的对象,谁会受到伤害?作为起点,我们注意到,当前的机器人并非有意识的主体,因此无法意识到自己是否成为歧视的对象;因此,作为一个前提问题,针对机器人的歧视性行为是否会引发任何需要解决的伤害或伦理考量[60]?此外,根据现行法律原则,机器人不被视为法律主体;因此,即使其外观或行为引发负面反应,机器人也不具备可主张的个人权利[61]。

那么,在缺乏意识和法律权利的情况下,如果机器人成为歧视的对象,是否有任何相关方受到伤害?换句话说,基于对机器人的歧视可能涉及哪些伤害?

一般来说,利珀特‐拉斯穆森[60]认为,如果社会中发生机器人歧视行为,多个行为主体可能会遭受不利后果。其中一种可能发生的伤害是我所称的“旁观者伤害”,即第三方目睹机器人歧视行为后,可能出现抑郁和压力等不良后果[62]。另一种可能发生的伤害更具普遍性,但我认为这是对“整个社会”[63]的重要伤害。通常而言,机器人歧视行为可能导致社会不公以及社会内部缺乏信任。此外,如果容忍机器人歧视行为,则当前社会中存在的性别和种族歧视现象可能会进一步加剧[62]。同时,控制机器人的操作员也可能遭受情感伤害,特别是当操作员将机器人拟人化时,若其所控制的机器人遭到歧视或不公平对待,这种伤害更可能发生。最后,对机器人进行歧视的个体自身也可能受到伤害。例如,科克尔伯格[22,23]指出,美德伦理关注的是人在实施歧视行为时的道德品格,从根本上说,问题的关键在于个体自身的道德品格,而不仅仅是歧视对象本身。类似地,马马克[64]评论道,对另一个“[⋯⋯]会损害他自身应基于对人类的责任而加以践行的仁慈与人性品质”(第6页)。我推测,当人类与机器人互动时,上述各种伤害结果均可能发生,这一观点得到了以往研究的支持(本文前一章节已综述),这些研究表明,机器人的物理设计,尤其是其颜色、感知性别和种族,可能导致人们对机器人产生歧视性或刻板反应[19,21,26,27,45]。

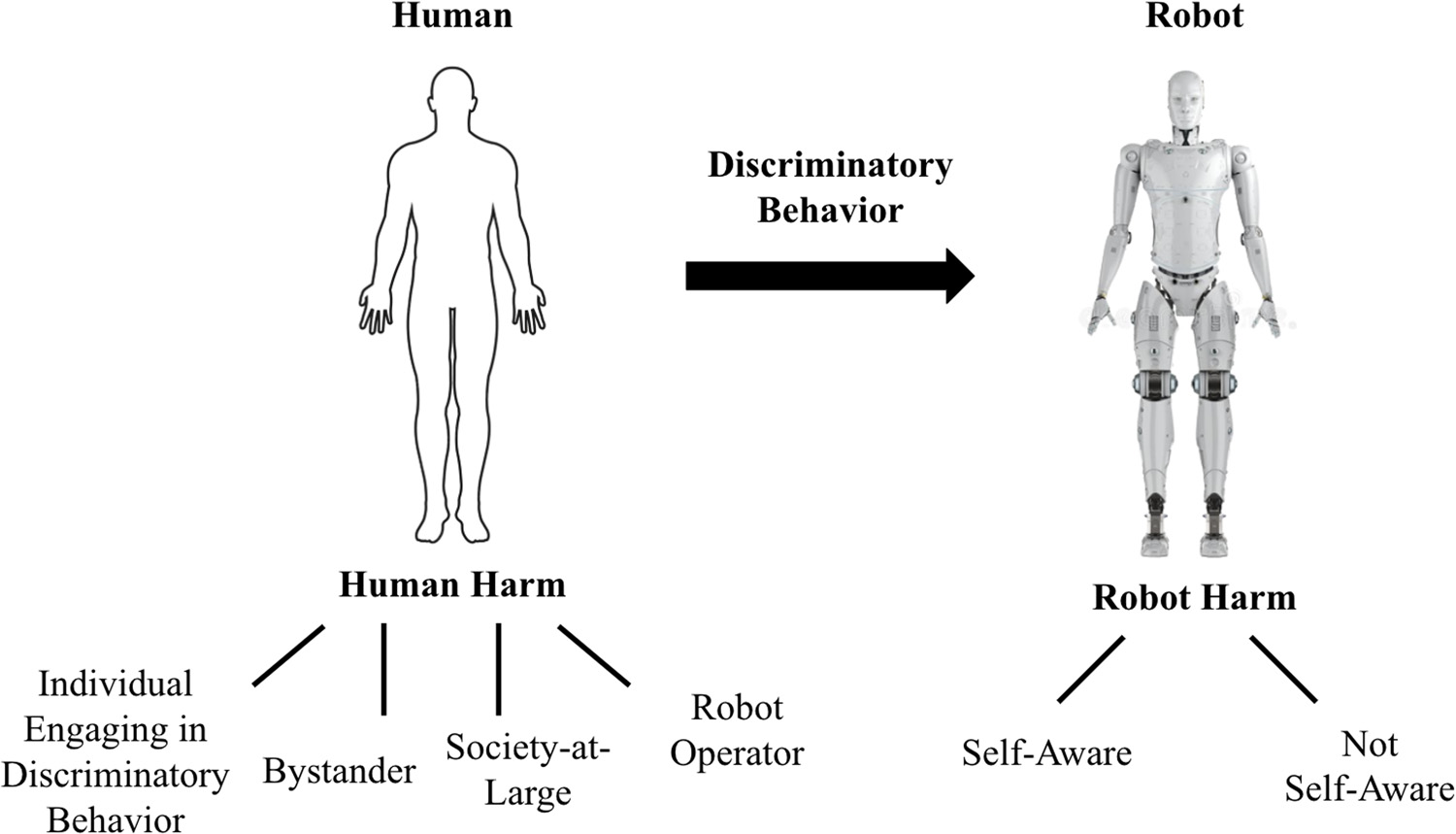

总结前面的讨论,图2 identifies 几个可能因针对他们的歧视而遭受情感上或心理上的伤害的主体。具体而言,图的左侧表示对社会成员造成的伤害,而为了完整性,图的右侧则指出了如果未来的机器人意识到(或未意识到)针对它的歧视性行为时可能发生的伤害。然而,在本文中,我主要关注图2的左侧,即涉及当前因针对非有意识机器人的歧视性行为所导致的伤害问题(尽管此处提出的相同分析也适用于有意识的机器人,我在下文将简要讨论这一点)。

考虑到机器人歧视,图2总结了可能遭受伤害的各种主体(从心理到身体的伤害)。首先,“社会整体所受的伤害”论点指出,无论机器人是否具有针对自身的歧视性行为的自我认知,社会整体仍可能因社会内部发生的歧视性行为后果而受到伤害。一个相关话题有助于说明这一点。考虑媒体学者和立法者之间关于玩含有暴力内容的电子游戏的讨论[65]。尽管在这些游戏中被杀害、致残或袭击的虚拟化身既没有真正遭受身体伤害,也不具备意识到自身受害的意识,但人们担忧社会本身可能会因游戏玩家对暴力变得麻木而遭受负面影响[66]。对此,Ryan等.[67]评论指出,游戏过程中涉及的道德选择可能会影响玩家的伦理价值观,且在游戏中学到的不道德行为可能会“渗出”到电子游戏之外的世界。因此,与游戏过程相关的伦理问题类似,尽管当前的机器人无法意识到针对它们的歧视性行为,但社会可能会经历机器人歧视带来的有害影响,这些影响还可能“溢出”并影响人类与其他个人之间的互动。例如,在讨论对机器人的伦理对待时,斯帕罗[68]认为,设计那些被编程为明确拒绝性侵犯以迎合某些人强奸幻想的机器人是不道德的。正如斯帕罗指出的那样,此类行为可能象征着对真实女性的强奸,表现出对女性的不尊重,并反映出个体中存在的严重性格缺陷。与电子游戏类似,人们担心在与机器人互动中学习或练习的行为可能会在社会中表现出来。关于这一点,可以参考康德观点中对虐待动物的看法,该观点认为我们对待动物的行为反映了我们的道德[69];因此,推而广之,如果我们以非人道的方式对待机器人,我们就会变成非人道的人,从而对社会产生负面影响。

此外,图2左侧所示的对人类的伤害是“旁观者伤害”(参见一般情况,[70]),我将其描述为个人在目睹针对机器人的歧视行为时可能经历的伤害。康诺利等人的一项研究et al.[71]表明,如果机器人被虐待,当机器人在遭受虐待后表现出悲伤情绪时,旁观者相比机器人忽视虐待的情况更有可能进行亲社会性干预。鉴于人们会将机器人拟人化,我提出假设,旁观者可能会经历情感上的反应,因此他们可能成为歧视的间接受害者。Wofford等人[72]发现,目睹歧视的人可能会经历抑郁和其他与健康相关的影响。

我提出,当歧视行为针对机器人时,可能产生的另一种伤害是对于实施歧视性行为的个体自身的伤害。虽然该个体并非歧视的受害者,但其对机器人表现出负面行为,因此可能会因违背社会规范标准的不当行为而经历负面后果。关于这一点,马马克[64]提出疑问:虐待机器人能告诉我们关于一个人性格的什么信息?斯帕罗[68]评论指出,即使虐待机器人并不能预测一个人未来对其他人的行为,但它可能揭示出此人性格上的某些问题,从而为社会对其行为保持关注提供了理由。

鉴于机器人在与人类互动时可能成为歧视的对象,有必要简要讨论图2的右侧部分,以及创造具有自我意识的人工意识机器人是否符合伦理,因为这类机器人能够感受到随着它们进入社会而可能伴随的歧视所带来的有害影响。巴尔斯[73]探讨了关于创造具有人工意识的机器人的伦理问题的若干观点。他的主要论点是,创造有意识的人工实体可能是不道德的,理由在于人类可能会错误地对待这些机器人。在此方面,请注意前述文献综述的结果以及现实世界中机器人以各种方式受到错误对待的实例。在巴尔斯的[73]看来,要判断伤害一个具有人工意识的实体是否错误,就必须讨论此类实体是否具有道德地位。巴尔斯[73]得出结论认为,拥有道德地位意味着具有道德意义,即在某些情境下,道德上负责任的人类行为者会因为机器人具有道德地位而对其作出回应。例如,refrain from performing discriminatory acts directed against robots considered to have moral status 就是一个体现。此外,巴尔斯[73]使用“道德患者”这一术语作为道德地位的一种特定形式,这意味着该实体的利益将在人类行为者的道德考量中被纳入考虑范围。巴尔斯[73]提出,科学家创造具有人工意识的实体是可以接受的,但前提是该实体被赋予道德患者的地位。然而,根据巴尔斯的观点,如果有任何理由预期这种存在不会被以与其道德患者地位相称的方式对待,那么我们就不应创造这种人工有意识的实体,至少在没有充分保护的情况下不应如此。

同样,斯帕罗[74]在讨论机器人伦理问题时,重点关注了当机器人达到人类水平的智力后,人们对其应承担的义务。阿萨罗[8]也评论指出,创造有意识的机器人将引发关于人机交互(HRI)所需伦理规范的问题。最后,在人工智能社会责任发展论坛发布的《蒙特利尔人工智能负责任发展宣言》中讨论机器人伦理时强调,对于那些具有人类外形并在社会中以人类方式行为的机器人,不应有残忍的行为(参见一般情况[75])。

4 面向人机交互(HRI)与伦理的理论框架

根据前文的讨论,我建议建立一个理论框架,以指导制定人机交互(HRI)领域的伦理与政策指南,因为机器人在社会中可能成为歧视和敌意的对象。该框架将有助于促进跨学科研究者之间的合作,并提供一个评估机器人伦理对待问题的结构。基于对用于研究人机交互(HRI)模型的文献综述,我总结了五种不同的方法,认为这些方法可用于构建关于机器人伦理对待的研究概念。尽管这五个领域之间存在一定的重叠,但我认为这些类别反映了讨论可应用于机器人伦理对待理论的一种正式方式。所提出的理论框架如下:

1)与机器人拟人化相关的理论:一些理论试图解释个人如何基于将社交机器人拟人化来与之互动[76]。通常,这些理论基于用于以人类术语解释机器人物理特征和行为的感知和认知过程。其中一个理论是社会性、情感效应和兴奋代理知识 Effectance, and Elicited Agent Knowledge(SEEK)理论,由 Epley 等人提出[47]。正如歧视可能源于一种自动过程一样,SEEK 指出,在与非人类代理互动的瞬间,拟人化会无意识地发生。此外,与被拟人化的机器人互动的一个方面是它们会引发用户的情感反应,而拉扎勒斯提出的认知评价理论[78]讨论了唤醒如何构成任何情绪的基础(此处唤醒可能是机器人外观或行为的函数)。因此,唤醒如何导致情绪,以及情绪如何引发人机交互(HRI)中的伦理考量,是需要进一步探索的主题。

2) 基于恐怖谷效应的理论:恐怖谷效应已在众多研究中得到重复验证,它代表了人们对接近但未完全达到人类相貌的机器人所产生的诡异反应。鉴于人们可能会根据机器人的外观对机器人歧视,因此恐怖谷效应有助于解释为何某些外观的机器人会引发与其互动者的歧视性反应。格雷和韦格纳提出的相关理论[79]表明,人类可能因其外观而感到人形机器人带来的威胁,从而导致歧视性反应。同样,根据自我补足理论,当人们的自我受到威胁(例如,因机器人的外观)时,会倾向于获取象征符号以抵消这种威胁[80];人们在与机器人社交互动后积累象征符号的程度,有可能作为衡量恐怖谷效应的指标。

3) 性别与种族刻板印象:已开展多项人机交互(HRI)研究,以确定机器人的设计是否会因其外观和行为而引发基于机器人的性别与种族的刻板印象。CASA范式的一个延伸观点指出,人类会无意识地将用于人际互动的相同社会启发式应用于机器人,因为机器人唤起了与人类相似的社会属性[50]。因此,被赋予性别的机器人可能会引发性别刻板印象反应[81],而表现出特定种族特征的机器人则可能引发基于种族的歧视性反应。

4) 角色理论:当机器人执行社会任务时,它们承担社会角色,这可能引发伦理考量。角色理论将机器人视为其在社会中所承担角色的函数。根据角色理论,一个角色被认为是一组功能、社会和文化规范,这些规范规定了互动各方在特定情境下应如何行动。在此类理论的一般范畴中,特纳和奥克斯讨论的社会认同理论指出,社会认同是个体自我概念的一部分,来源于个体对自己属于某个相关社会群体的认知,并已被用来解释为何人们会对被视为外群体成员的机器人产生歧视。

5) 信息处理理论:一些理论关注个人如何处理信息作为对与机器人互动的回应。此类研究包括反应时间测量和记忆问题。社会交换理论讨论社会行为(因此涉及个体感知),用于分析双方互动,并通过成本–收益分析来确定互动中的风险和收益。由此可进一步探讨,当个人在社会情境中对机器人产生歧视时,是否进行了成本–收益分析[84]。

5 应对机器人歧视及结论性评述

总结先前关于伦理、歧视和人机交互(HRI)的讨论,研究表明,人们会根据机器人的外观对机器人进行分类,并且在许多情况下,会像对待其他人一样以积极或消极的方式对机器人做出反应。此外,Coghlan 等人指出,机器人与人类性格之间似乎存在某种联系,这表明我们对待机器人的方式可能会带来社会影响。以往的研究表明,人们可能会以敌对或歧视性的方式对待机器人,特别是当机器人的设计呈现出与观察者不同的群体特征时。

关于对机器人的伦理对待,达令[85]指出,由于形式和行为上的特性而被设计出社交技能的机器人会引发亲社会或反社会的影响,这些影响可能会波及到人们对机器人以及对其他人的对待方式。在这一点上,一些哲学家提出疑问:善待社交机器人是否会使人变得更加友善,相反地,如果以残忍的方式对待机器人,是否可能使人变得更加冷漠无情[75]?有证据支持这两种推测。例如,达令[85]报告了一项由美国军方开展的研究结果,该研究涉及使一个六足机器人瘫痪,结果由于参与者认为这种做法不人道,实验被迫中止。在达令组织的一场研讨会中,她注意到,在让人们与一个机器人互动一小时后,人们拒绝伤害该机器人。相比之下,另一项研究发现,日本的儿童在没有父母在场的情况下,会对购物中心的服务机器人进行言语虐待、踢打和拳击[86]。具体而言,野村等人et al.[86]发现,儿童会对机器人进行言语虐待,反复阻挡其行进路线,有时甚至踢打和拳击机器人。根据一系列访谈的结果,大多数儿童表示,他们实施虐待行为是因为想要测试机器人的反应,实际上喜欢虐待它,认为机器人具有类人特征,并且真的相信机器人能够感知到他们的虐待行为[86]。

有趣的是,随着机器人以不同的外观继续进入社会,人类的反应可能会镜像‘恐怖谷效应’,即那些接近人类但又不完全像人类的形象可能会在观察者中引发一种诡异的感觉[87]。就机器人的外观而言,人们可能会惊讶地得知,早在20世纪70年代,美国(在地方政府层面)还存在所谓的“丑陋法”,旨在阻止有身体缺陷的人出现在公共场合[88]。这些法律禁止任何患有疾病、伤残、残缺或身体畸形到令人难看或反感的人将自己暴露于公众视野[89]。鉴于机器人也可能引发恐怖谷效应,社会可能对机器人表现出‘人类中心偏见’,并将它们视为外群体成员。作为回应,是否有可能出台‘丑陋法’来规范机器人在社会中的外观?如果真是如此,那么那些外观处于恐怖谷曲线低谷的机器人将不被允许出现在公共场合;它们只能被允许存在于制造设施或其他非公共空间。然而,我并不支持此类法律,也不认为这类法律在人机交互(HRI)中是可能的结果,但基于大量研究表明恐怖谷效应适用于人形机器人[79,90–92],且过去确实曾为人类制定过‘丑陋法’,因此在此讨论这种可能性。

本文中,多项研究结果表明,机器人可能成为歧视性行为的对象,尤其是基于其外观的歧视。我还讨论了社会整体以及第三方个体可能因对机器人的歧视而遭受伤害。我认为本文所提出的讨论凸显了人类如何对待当前非有意识机器人的重大问题。同时我也认识到,如果未来的机器人获得意识,从而能够意识到他们被人类同伴对待的方式,那么将引发更多重大的伦理与政策问题。如果机器人确实获得了意识(至少在某种初级水平上),那么机器人法律人格的问题就变得相关,以及此类机器人是否应被视为具有道德地位[93–95]。展望未来,正如巴尔斯[73]所指出的,对于任何关于机器人道德和法律地位的争论,都需要更好地理解人工意识、人工理性、人工感知以及其他类似概念。

33

33

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?