将基础模型转化为领域专家的艺术

关键字: [Amazon Web Services re:Invent 2024, 亚马逊云科技, 生成式AI, Amazon Bedrock, Foundation Model, Domain Expert, Continued Pre-Training, Fine-Tuning, Prompt Engineering, Retrieval Augmented Generation, Agents]

导读

标准基础模型对大多数主题都有一般性知识,但缺乏特定领域的专业知识。了解如何对它们进行定制,使其成为您所在领域的专家。在本次会议中,通过互动演示学习如何执行微调、使用检索增强生成技术或使用事务性代理。探索如何评估每种方法的优缺点,以选择最适合您需求的解决方案。

演讲精华

以下是小编为您整理的本次演讲的精华。

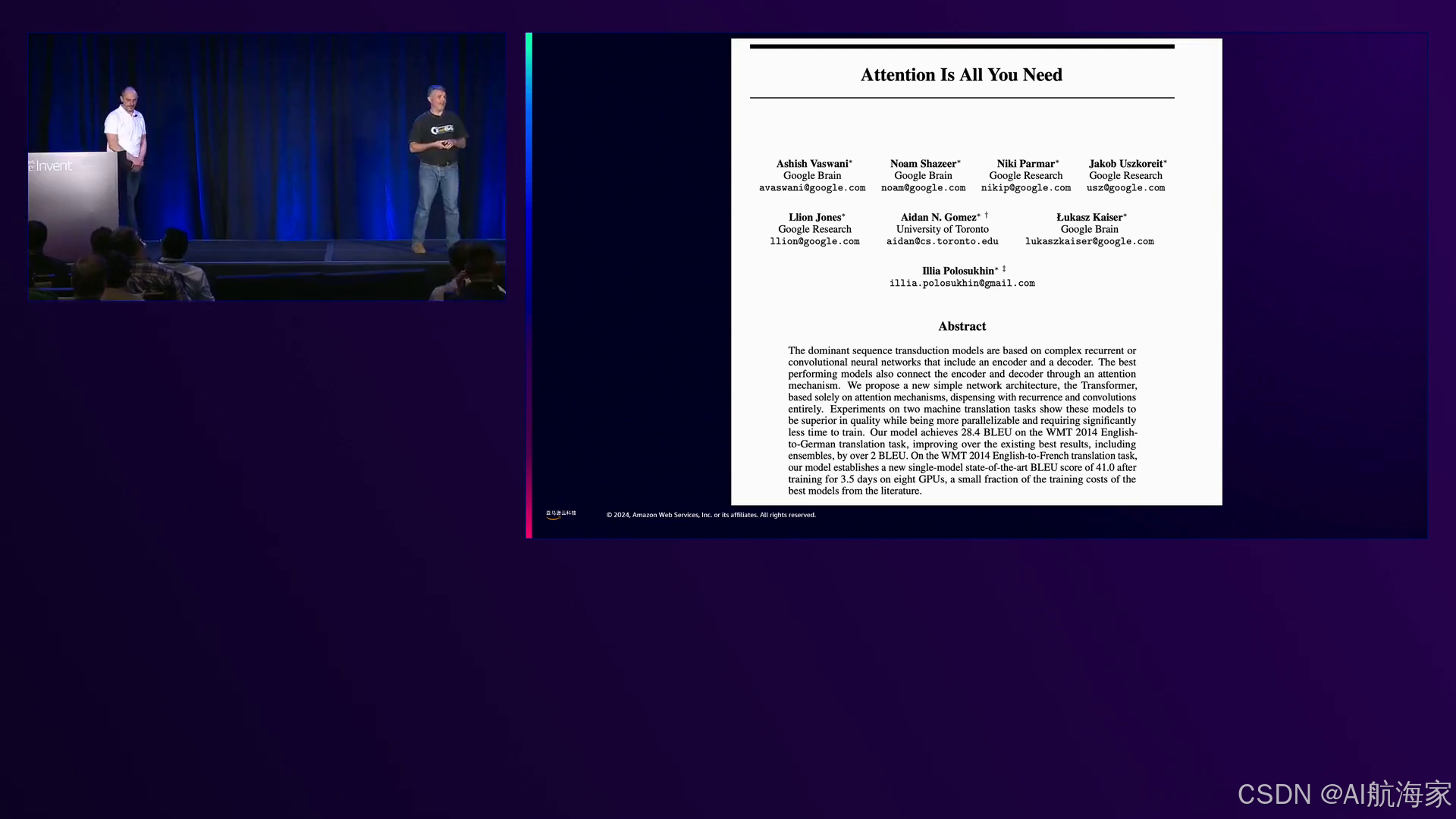

演讲者们首先阐述了大型语言模型的历史起源,特别是追溯到2017年的Transformer技术。他们解释了谷歌研究人员发表的题为“Attention is All You Need”的基础研究论文,该论文引入了Transformer架构和上下文注意力的概念。这种新颖的方法使学习系统能够通过扩大上下文窗口来捕捉文本的含义和重要性,即使单词和短语在文本中不是紧密相连也能理解。

演讲者阐明Transformer模型由两个不同的组件组成:编码器和解码器,它们接受不同的训练并服务于不同的目的。编码器的功能是将字符串或短语转换为数值向量或一组向量。例如,对于短语“Paris is the capital of France”,编码器会将其表示为一个向量。他们将其类比为二维空间中的向量,向量具有距离和长度等属性,但指出在语言模型的上下文中,这些向量在数百或数千维度中运作,对人类来说难以理解,但计算机可以通过矩阵计算轻松处理。

演讲者强调了这些向量的一个非凡特性:具有相同含义或重要性的短语会被表示为在向量空间中彼此接近的向量。为了说明这一概念,他们对比了“Paris is the capital of France”和“The Eiffel Tower was built in 1889”这两个短语,尽管它们没有共同的单词,但由于它们与巴黎有关的共同语义上下文,表示这些短语的向量会位于相近的位置。

转而讨论解码器组件,演讲者阐释了它在预测短语中下一个可能的标记方面的作用。例如,给定短语“Paris is the capital of”,解码器会根据其训练数据和该单词在给定上下文中出现的统计可能性,预测下一个标记为“France”。

演讲者强调了用户对语言模型的三个关键期望,他们将其概括为三个“H”:有帮助、诚实和无害。他们举例说明了模型未能满足这些期望的情况,例如生成无意义或不准确的响应、出现幻觉或试图协助非法或不道德的活动。

演讲者转向了他们论述的核心,阐述了将基础模型转变为领域专家的五种技术,每种技术都针对特定的挑战和需求。

第一种技术是持续预训练,它涉及在大量特定领域的语料库上重新训练整个模型,例如内部文档或许可的外部数据。演讲者强调摄取大量数据的重要性,每个工作可能需要数千美元,以确保模型全面理解该领域。他们演示了在Amazon Bedrock上执行持续预训练作业的过程,包括指定基础模型、输入数据和相关参数,以及指定验证数据的输出位置。

第二种技术是微调,它调整模型的最后几层以适应特定任务,如问答,而无需重新训练整个模型。演讲者强调微调的数据需求相对较低,他们举例使用了来自NVIDIA数据集的仅1.3兆字节的6000个标注问答对。他们演示了在Bedrock上微调模型的过程,展示了如何将模型对“hybridizer”一词的响应从通用定义改为从微调数据集中提取的特定领域解释。

第三种技术是提示工程,它涉及精心设计输入提示,为模型提供相关上下文和指导。演讲者通过演示如何将亚马逊云科技风格指南中的上下文纳入提示,从而显著提高了模型准确响应“open source”的首选书写方式(两个单词或连字符)的能力。他们进一步探讨了这种技术的潜力,建议在提示中包含整个文档或风格指南,使模型能够根据提供的上下文进行总结和生成响应。

第四种技术是检索增强生成(RAG),它结合了编码器模型和向量数据库的能力。演讲者阐释说,编码器模型会为文本块创建向量表示(嵌入),然后将这些向量存储在一个优化了计算向量距离的向量数据库中。通过计算查询向量与存储向量之间的距离,系统可以检索语义相关的文本块,然后将这些文本块提供给解码器模型生成最终答案。演讲者演示了在Bedrock上创建RAG系统的过程,包括摄取欧盟法规文本、指定编码器模型(Amazon Titan Embedding G1 Text)以及利用无服务器OpenSearch向量数据库。他们展示了该系统能够通过检索和总结相关文本块,为监管查询提供精确和有据可查的答复。

第五种也是最后一种技术涉及使用代理,它将语言模型与传统API和工具相结合。演讲者强调,代理本质上是代码模块,它们利用语言模型来确定适合给定查询的工具或API,然后调用该工具,将其输出反馈给模型以生成最终响应。他们提供了一个实际的例子,使用Bedrock的Converse API编写了一个Python代理,该代理成功地根据用户查询亚马逊(AMZN)股票价格从REST API中检索和解释了股价数据。该代理首先使用JSON规范描述了可用工具(在本例中是股票价格API),包括工具功能和输入/输出模式的自然语言描述。当收到“What is the price of the Amazon stock today?”的用户查询时,该代理将其转换为JSON格式,并将其与工具规范一起发送给Bedrock Converse API。API响应表明该代理应该使用股票价格API,并将股票代码“AMZN”作为参数传递。然后,该代理调用REST API获取股价数据,并将其提供回模型,模型生成了最终响应,说明亚马逊当前股价(录制时为126美元)以及当天股价上涨1.89%。

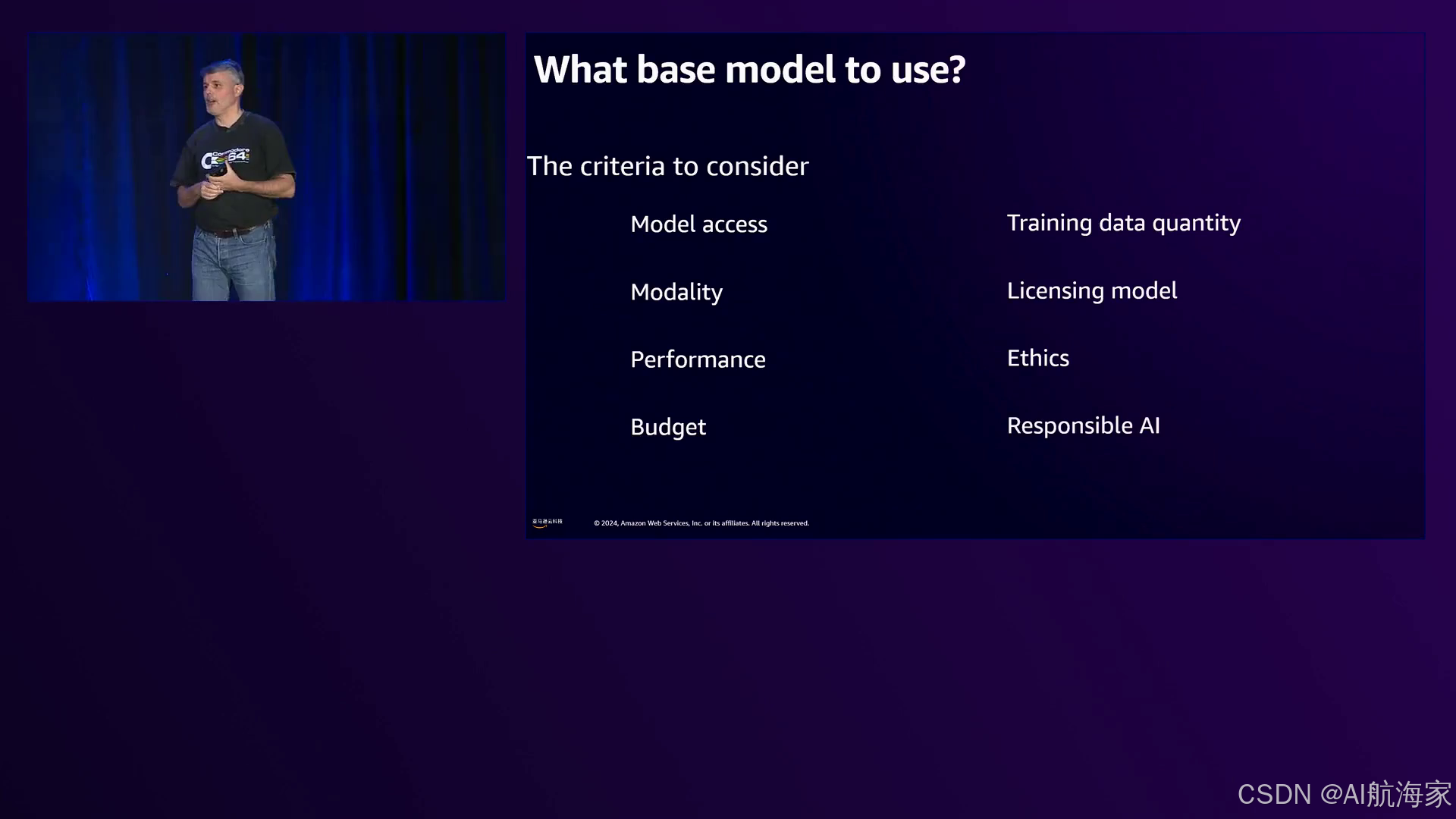

在整个阐述过程中,演讲者意识到在选择基础模型和采用适当技术时必须考虑的各种标准。他们承认部署模式、性能要求、数据可用性、许可、道德考虑和预算限制等因素在决定这些选择时都发挥着关键作用。

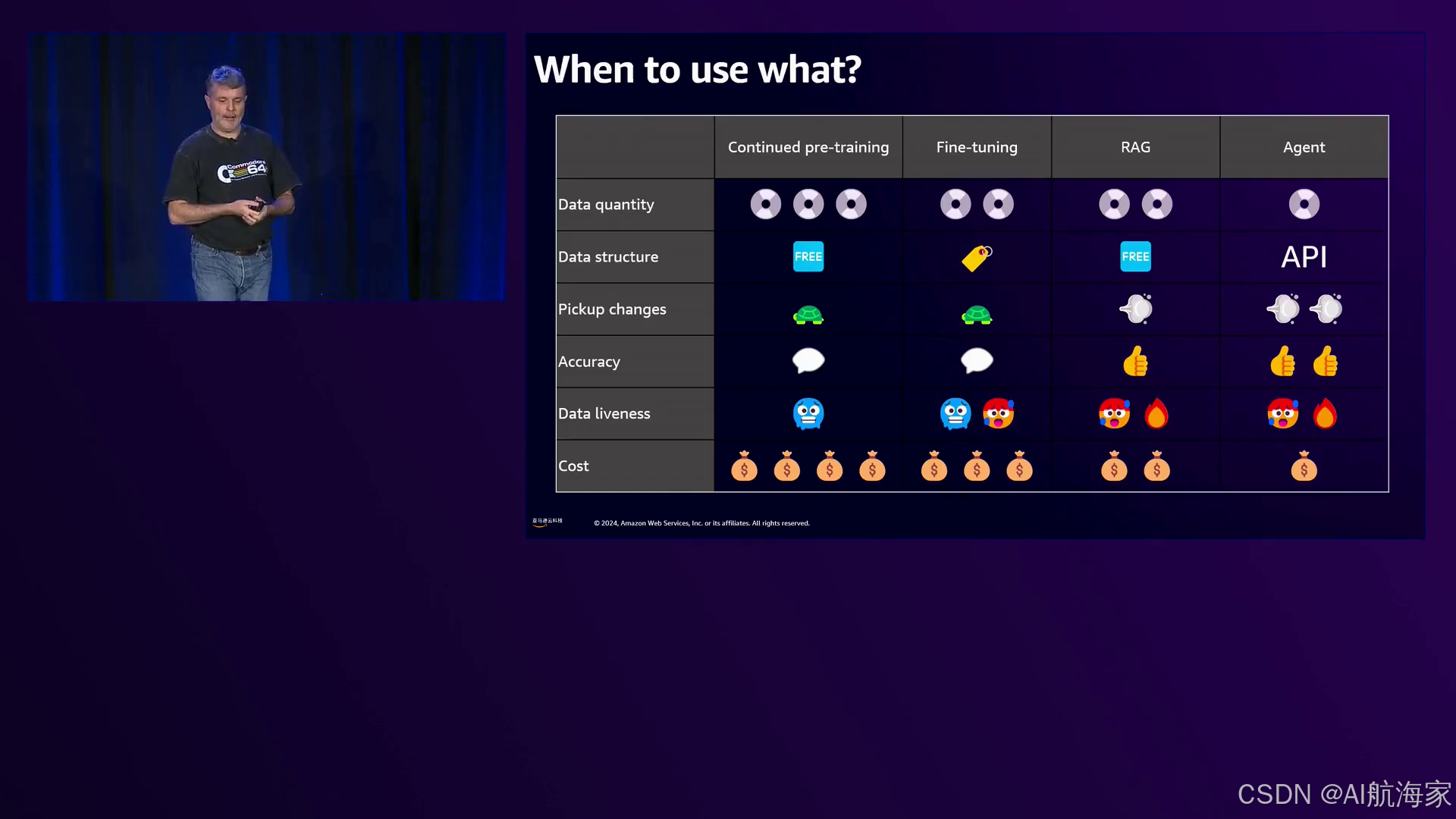

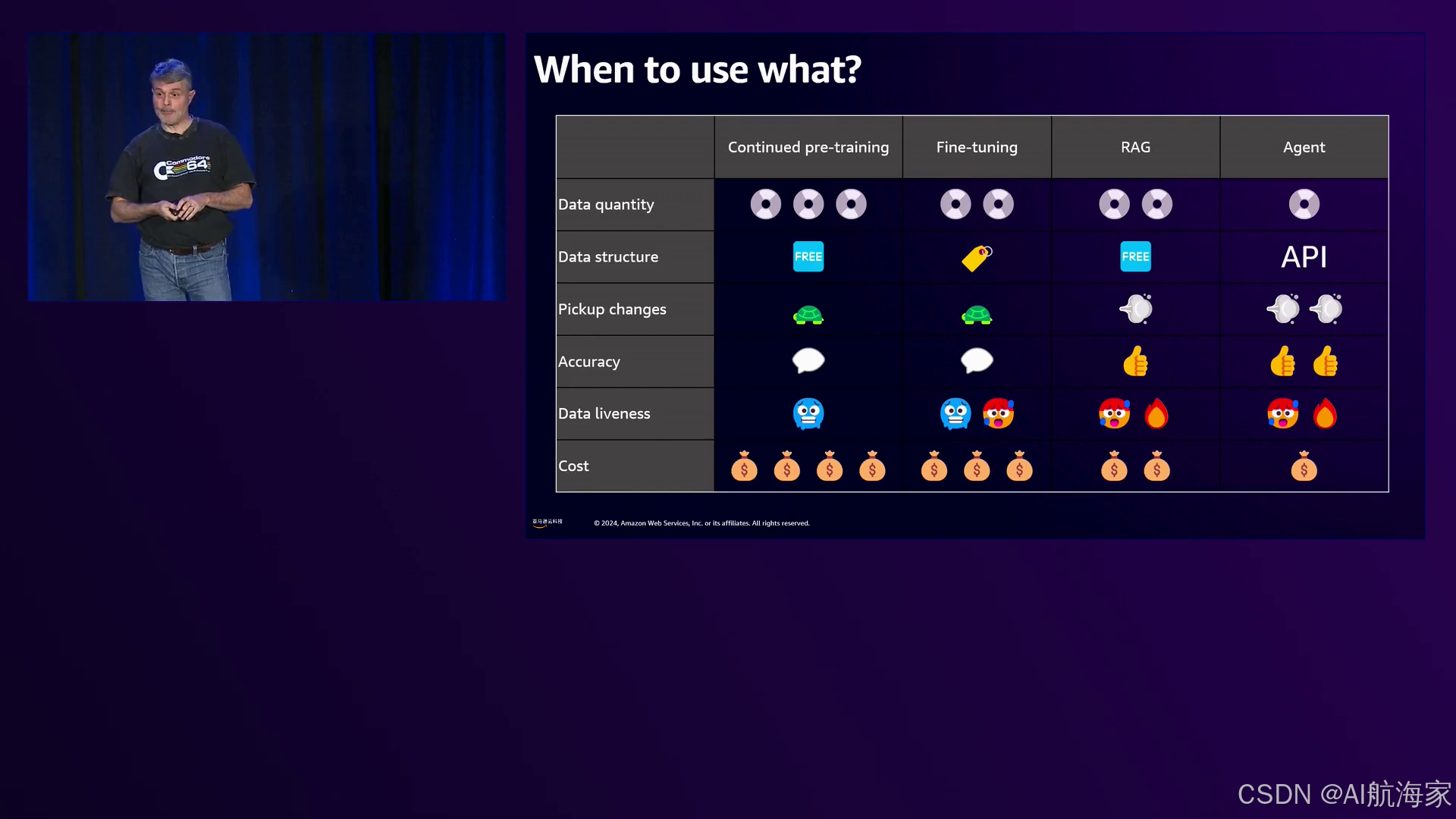

演讲者总结了他们对五种技术在数据量需求、数据结构要求、适应变化数据的能力、响应准确性、数据实时性和成本影响等方面的比较分析。他们强调,虽然这些技术可以单独使用,但实际应用通常需要审慎地结合多种技术来满足每种用例的独特需求。

总之,演讲者全面、深入的论述,丰富的数据点、数字、客户案例和从视频字幕中摘录的实际示例,为与会者提供了一个强大的“工具箱”,用于定制现成的语言模型以满足特定领域的应用需求。他们的阐述涵盖了从持续预训练和微调到提示工程、检索增强和基于代理的架构等整个技术范围,为参与者提供了必要的知识和见解,以驾驭大型语言模型定制和部署的复杂领域。

下面是一些演讲现场的精彩瞬间:

演讲者承认生成式AI聊天的广泛使用及其容易产生幻觉的倾向,然后介绍了减少不准确性并将语言模型转化为针对特定领域的业务专家的策略。

演讲者解释了transformer架构的起源以及大型语言模型中“注意力”的概念,并将其与Beatles的歌曲“All You Need is Love”作了类比。

演讲者解释了AI模型具有防止有害输出的保护措施和防护栏,但可以使用技术来绕过它们,尽管随着模型的改进,这些技术可能会变得越来越无效。

想象培训一个名为Paul的AI助手,通过接触真实对话并学习客户互动的细微差别,使其成为一名熟练的支持代理人。

演讲者回答了关于AI应用程序应使用哪种基础模型的常见问题,强调选择取决于各种因素,如部署环境、模态、准确性要求和预期用例。

亚马逊云科技推出了一系列经济高效的解决方案,用于利用大型语言模型,从持续预训练和微调到检索增强生成(RAG)和代理,满足不同数据类型和成本需求。

演讲者总结了演讲的要点,感谢了溢出房间的观众,并邀请在会后进一步讨论。

总结

在这个演讲中,演讲者们介绍了五种技术,用于将一个通用的大型语言模型转化为特定领域的专家:

- 持续预训练是指使用特定领域的数据重新训练模型,从而使模型适应特定主题。然而,这种技术成本高昂,需要大量数据。

- 微调是调整模型参数,使其偏向于特定的风格、词汇或响应,而不是让模型学习新概念。这种方法所需的数据量比持续预训练少,但会产生一个新的需要部署的模型。

- 提示工程是指通过在查询中包含相关文档等方式,为模型提供足够的上下文,从而生成准确的响应。

- 检索增强生成(RAG)将语言模型与包含文档语义表示的向量数据库相结合。模型可以总结相关文档以回答问题。

- 智能体是利用语言模型选择并调用适当的API或工具来响应查询的程序,并将结果提供给模型生成最终回答。

演讲者强调,这些技术可以相互组合,选择取决于诸如可用数据量、数据结构、变化频率、准确性要求、数据新鲜度和预算等因素。

亚马逊云科技(Amazon Web Services)是全球云计算的开创者和引领者。提供200多类广泛而深入的云服务,服务全球245个国家和地区的数百万客户。做为全球生成式AI前行者,亚马逊云科技正在携手广泛的客户和合作伙伴,缔造可见的商业价值 – 汇集全球40余款大模型,亚马逊云科技为10万家全球企业提供AI及机器学习服务,守护3/4中国企业出海。

646

646

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?