1 引言:大模型时代,为什么“Strong AI”反而更远了

过去三年,深度学习尤其是大语言模型几乎成为技术圈和公众讨论的绝对主角。无论是 GPT 系列、Gemini、Claude,还是 LLaMA、Qwen、DeepSeek 等一批开源模型,在代码生成、复杂问答、多模态理解甚至一定程度的规划能力上,都表现出前所未有的“通用性”,很多人自然会问:既然这些模型什么都会一点,它们是不是已经算“强人工智能”(Strong AI)了?

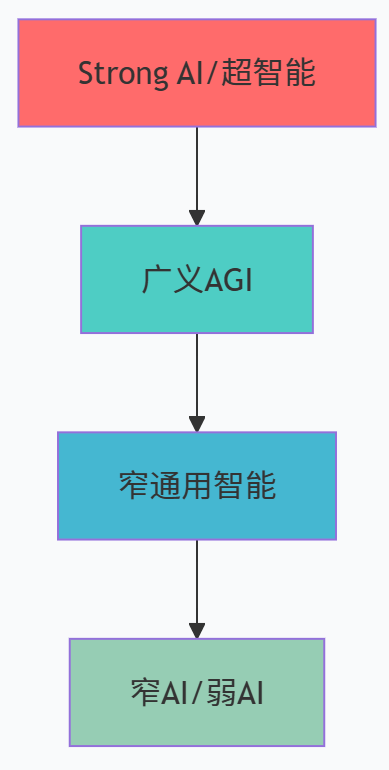

如果只看市场宣传和媒体标题,答案似乎已经被默认为“是”。不少文章直接把最新的大模型称作“通用人工智能”“AGI 雏形”,甚至用“准 Strong AI”这类模糊概念来形容。然而,如果把视角拉回到学术与哲学语境,情况就完全不同。Searle 在早年就把 Strong AI 定义为“恰当编程的计算机不只是在模拟心智,而是真正拥有心智”,并将其与仅把计算机当作模拟工具的 Weak AI 明确区分(华盛顿大学教师网站)。最新的哲学与 STS 论文也再次强调,现实世界中现有系统,包括最强的大模型,仍然严格属于“弱 AI”或“窄 AI”,Strong AI 目前依然只是理论与科幻中的假想对象(SpringerLink)。

工程界对 AGI 的讨论则更加操作化。DeepMind 提出的《Levels of AGI》框架把通往 AGI 的路径拆解为不同层级,从特定任务上的超人表现,到在广泛任务上的人类水平,再到高自治、高鲁棒的系统性智能,同时强调“通用性”和“自治性”都要达到一定深度和广度,才算真正触及 AGI 乃至 Strong AI 的门槛(arXiv)。这套框架在开源社区中已经被广泛讨论和翻译解读,成为评估大模型“到底走到哪一步”的一个重要参照系(优快云博客)。

与之对照,大模型研究本身也在快速总结自身的能力边界。多篇大模型综述系统回顾了预训练、微调、应用与评估四个维度的进展,同时坦率地列出了现阶段 LLM 在推理、规划、系统性泛化、常识理解、可解释性与安全性上的严重局限(arXiv)。更细分的专题综述则围绕幻觉、评测可靠性、多语言弱势语种、文化常识偏差等问题给出了大量证据,表明今天的大模型在很多关键指标上,离“Strong AI”还远不止一个数量级(arXiv)。

与此同时,一些一线顶级研究者也在公开场合给当前 LLM 泼冷水。Meta 首席科学家 Yann LeCun 在 2024 年接受采访时就明确表示,现有大语言模型“没有真正的推理能力,不理解物理世界,没有持久记忆,无法按合理标准进行层级规划”,因此不可能凭着继续堆大模型就自然长成“人类级智能”,必须发展全新的世界模型与学习范式(金融时报)。2025 年一项关于 Large Reasoning Models(大推理模型)的研究甚至发现,当问题复杂度增加时,这些被专门强化推理能力的模型整体性能会出现“完全崩溃”,在高复杂度任务上的表现反而比传统模型还差,引发业界对现有深度学习路线是否遇到“推理天花板”的激烈讨论(科学直通车)。

在这样的技术与理论背景下,简单把“更大的深度学习模型”与“Strong AI”画等号,既不严谨也不安全。本文尝试站在“强人工智能 vs 深度学习”的对照视角上,借助最新开源综述和前沿研究,一方面梳理 Strong AI 在哲学与工程语境下到底意味着什么,另一方面系统分析现有大模型在哪些关键维度上仍然明显“不够格”。

1.1 Strong AI 的经典含义与当下大众误解

在哲学文献中,Strong AI 不只是“很强的 AI”,而是一个有着明确边界的概念。Searle 给出的典型表述是:Strong AI 认为,只要程序合适,运行该程序的机器就拥有真正意义上的心智状态,能够被字面意义上地说成“理解”“思考”,而不仅仅是在做形式上的模拟(华盛顿大学教师网站)。与之对应,Weak AI 则仅仅把计算机视为研究心智的工具,或作为执行特定智能任务的工程系统,并不主张它“真的有心灵”。

近期对 Strong / Weak AI 叙事的分析进一步指出,在学术界,Strong AI 一般被视为“能够机械复制人类所有智力功能”的假想系统,而现实中所有可落地技术,包括自然语言处理、图像识别、大模型等,都属于任务范围有限的 Weak AI(SpringerLink)。面向开发者的技术文章和教学网站也基本维持这一划分,例如 Baeldung 的中文技术文档就强调:Strong AI 通常与 AGI、具备意识和自我反省能力的系统绑定,而当前所有系统,包括 GPT-4 和 AlphaZero,在严格意义上仍然只能算 Weak AI(Baeldung 中文网)。IBM 的官方科普也直接写明:Strong AI 旨在构建在心智上与人类无可区分、可以通过经验学习并持续自我发展能力的机器,但这一目标目前仍然只是理论上的,尚未在现实中实现(IBM)。

与学界的谨慎相比,大众对 Strong AI 的印象往往被媒体叙事和产品营销深刻影响。一方面,大模型在对话与内容生成上的拟人化表现非常容易触发人们的“心智归因”本能,很多用户会自然而然地把流畅的语言理解为“理解”,把复杂的代码生成理解为“会思考”,从而在直觉上把它们视作“准 Strong AI”。另一方面,企业在宣传中也倾向于使用“通用”“智能体”等带有强烈 Strong AI 意味的词汇,使得本来就模糊的概念进一步被稀释。

要想认真回答“为什么现有大模型还算不上 Strong AI”,就必须先把概念重新校准:Strong AI 并不是“比弱 AI 稍微强一点”,而是意味着系统在通用认知、多模态世界模型、自主目标设定、自我反思乃至意识属性等多方面达到了接近人类的整体水平,并能在开放环境中长期保持稳定、可解释和可对齐的行为。目前的大模型在这些维度上不仅远未达标,而且在许多关键点上甚至还在“基本不具备”的阶段。

1.2 本文的视角与结构

本文接下来的讨论,将围绕“理论画像”“技术现实”和“结构性缺陷”三条主线展开。首先,我们会根据 Strong AI 和 AGI 的最新理论工作,给出一幅尽量清晰的“Strong AI 能力画像”,并借助 DeepMind 的 Levels of AGI 框架把这种画像转化为相对可操作的指标格局(arXiv)。然后,我们会基于最新的大模型综述与评估研究,梳理 LLM 在语言理解、推理、规划、常识、文化语境和多语言等方面的实测能力与短板(arXiv)。最后,我们会从认知结构与意识理论的角度,讨论为什么即便在行为上越来越像人,现有大模型在“心灵层面”仍然与 Strong AI 相距甚远,并尝试给工程师一些面向现实的使用和架构建议。

在叙述形式上,本文尽量避免把问题变成“罗列优点、罗列缺点”的清单式整理,而是通过长段落和表格结构,将 Strong AI 与大模型放在同一坐标系中进行对比。这样做的目的是让读者在心里形成一幅更连续的“光谱”图像,而不是非黑即白的简单二分。

2 理论上的 Strong AI:从哲学概念到 AGI 能力光谱

2.1 Strong AI、Weak AI 与“通用智能”的学术共识

如果要给 Strong AI 找一个相对稳定的学术定义,大致可以从三个维度来刻画。

第一是智能功能的广度。Strong AI 被普遍认为至少应当具备在人类能够完成的广泛智力任务上的“可比水平”,包括语言理解与生成、抽象推理、问题求解、常识与世界知识、社交推理、长期规划等。AGI-Survey 项目在其不断更新的综述中,将 AGI 视为可以在多模态、多环境中执行多种认知功能的系统,而 Strong AI 可以看作是其中“完全对标人类”的极端形态(GitHub)。

第二是自治性与自我发展能力。Strong AI 不只是被动执行任务的工具,而应当能够在一定约束下自主设定子目标、分解任务、管理自身资源,并通过长期与世界的交互不断更新其知识与策略。DeepMind 的 Levels of AGI 把“自治性”作为与“性能”和“通用性”并列的核心维度,指出真正高级的 AGI 应该是能在较弱监督下长期执行开放任务、具备自我监控、元学习等能力的系统(arXiv)。

第三是心灵与意识层面的问题。哲学上的 Strong AI 通常还隐含着一个更强的主张:只要系统的功能结构与人类心智足够同构,它就不仅“像是在思考”,而是“真的在思考”,甚至在某些理论下有可能被赋予意识与主观体验(华盛顿大学教师网站)。这部分内容在工程实践中往往被弱化甚至刻意回避,但在讨论 Strong AI 的“终极边界”时却无法绕开。最新的 AI 意识评估报告就试图把全局工作空间、整合信息等意识理论映射到现有 AI 架构之上,从而给出“在何种条件下我们有理由怀疑 AI 可能具备意识”的判据(arXiv)。

基于这些维度,我们可以用一个概念性表格来对比 Strong AI 与 Weak AI 的典型特征,从而为后面的“大模型定位”提供背景坐标。

表 2-1 Strong AI 与 Weak AI 在核心维度上的概念性对比

| 维度 | Weak AI(弱人工智能) | Strong AI(强人工智能,理想形态) |

|---|---|---|

| 任务范围与通用性 | 面向特定任务或有限任务集,在训练分布附近表现优异 | 面向开放任务集,能在广泛领域达到接近或超过人类水平,并支持快速迁移到新任务 |

| 自主性与长期行为 | 主要由人类设定目标和流程,系统被动响应请求 | 能在约束下自主设定目标、规划路径、管理资源,并在长期环境中持续运行和自我调整 |

| 学习方式与自我发展 | 以离线大规模训练为主,在线更新能力有限 | 具备在线学习与元学习能力,可在运行过程中不断积累经验和抽象知识 |

| 心灵与意识属性 | 通常被视为无意识的工具,不主张有真正的“理解”或主观体验 | 按强 AI 立场,拥有真正的心理状态甚至可能的意识体验,可以被字面意义上说成“理解世界” |

| 社会角色与道德地位 | 被当作工具或基础设施看待,责任与权利归属于开发者和使用者 | 如果被承认具备心灵甚至意识,有可能被赋予一定道德地位,引发权利与责任分配的全新问题 |

从这个对比表可以看出,Strong AI 与其说是对“性能”的简单外推,不如说是对“智能种类”的拓展。它要求系统在通用性、自治性和心灵属性三方面同时达标,而不是只在某一维度上极端突出。

2.2 Levels of AGI:把 Strong AI 放到能力光谱中的一端

具体到工程实践,仅仅用“有/没有 Strong AI”这样二值化的标签显然不够精细。为了在现实系统之间进行有意义的比较,DeepMind 在 2023 年提出了“Levels of AGI”框架,试图像自动驾驶等级那样,用一套分层体系来刻画从当前模型到真正 AGI 之间的连续阶段(arXiv)。

这份工作在梳理现有 AGI 定义后,总结出六条构建 AGI 本体论的原则,强调要从性能深度(Depth)、能力广度(Breadth)和自治性(Autonomy)三个维度来综合评价系统,而不是只看单一基准分数。其中,性能深度衡量系统在单个任务上与人类或超人水平相比的差距,能力广度衡量系统覆盖的任务和领域范围,自主性则描述系统在多大程度上可以不依赖密集人类监督而完成复杂目标(arXiv)。

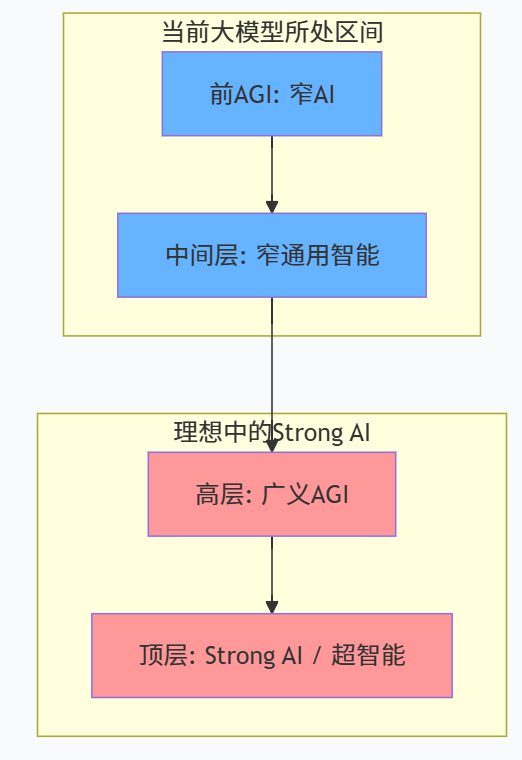

在这套框架中,真正意义上的 AGI 和 Strong AI 通常被放在最高的几个等级:既能在大量任务中达到人类专家甚至超人表现,又能在长期、开放环境中表现出高自治、可对齐和可靠的行为。相比之下,现有大模型大多被归入“前 AGI 阶段”或“窄通用智能阶段”,也就是在若干类别的任务上表现接近人类,但在能力广度、自主性和稳健性上仍有巨大差距(AICR Consulting)。

用一张高度抽象化的表格,可以更直观地看到“Levels of AGI”对现实系统的定位方式。

表 2-2 Levels of AGI 框架下的能力光谱(概念化示意,非原文严格划分)

| 层级(示意) | 性能深度(相对人类) | 能力广度(任务与领域) | 自治性与典型系统描述 |

|---|---|---|---|

| 前 AGI:窄 AI | 在若干特定任务上超人,在多数任务上远弱于人 | 面向少数明确定义任务,如翻译、识别、推荐等 | 几乎不具自治性,多作为被动工具存在 |

| 中间层:窄通用智能 | 在多种任务上达到或接近普通人水平 | 覆盖多种语言任务、部分推理和代码,但缺少具身与复杂社交任务 | 具有有限自治性,例如工具调用、简单 Agent 能力 |

| 高层:广义 AGI | 在绝大多数认知任务上达到人类水平或以上 | 可在广泛领域执行多模态任务,包括语言、视觉、行动、社交等 | 高度自治,能在弱监督下完成长期目标,具备元认知与自我监控能力 |

| 顶层:Strong AI / 超智能 | 在人类智力光谱全域达到或超越人类最佳水平 | 能快速适配未知任务和环境,展现创造性问题求解能力 | 自治性极强,具稳定价值对齐和自我约束机制,可能涉及意识和道德地位问题 |

根据多份近期综述和评测研究,目前主流大模型最多只能被放在“窄通用智能”区间:它们在多任务基准上的表现令人惊艳,在某些编程和数学领域甚至超越绝大多数人类工程师,但在物理常识、长期规划、多步推理、开放世界鲁棒性乃至安全可靠性方面的短板极为明显(arXiv)。从这个角度看,把这些系统直接称为 Strong AI,既抬高了“Strong AI”这一概念应有的理论门槛,也掩盖了大模型本身仍然需要正视和改进的结构性缺陷。

3 深度学习和大模型的现实图景:它们到底强在什么地方

在说明“现有大模型还算不上 Strong AI”之前,有必要先承认一个事实:如果把时间拉回到十年前,今天的大模型所展示出来的能力,已经非常接近很多人当时想象中的“强人工智能”了。

3.1 大模型能力的系统综述:强得惊人,但指向哪里

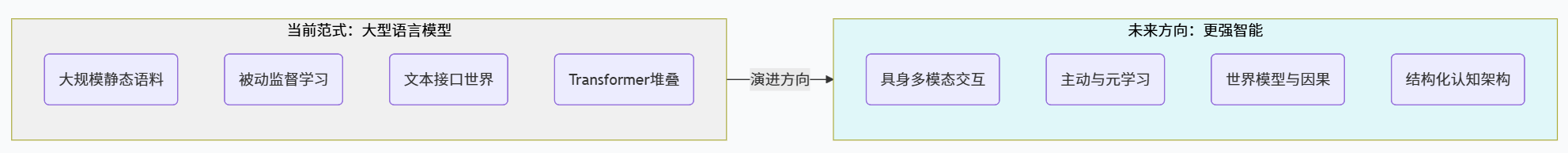

《A Survey of Large Language Models》等几篇里程碑式综述系统梳理了 LLM 的发展脉络。从早期的统计语言模型,到基于 Transformer 的预训练,再到参数规模和数据规模的指数级扩张,大模型在文本理解和生成上的表现经历了从“勉强可用”到“高度拟人”的跨越(arXiv)。这些综述强调,预训练加指令微调的范式,使模型在多任务、多语言环境下展现出“涌现能力”:即便没有针对特定任务进行训练,通过合适的提示和少量示例,模型也能在翻译、摘要、问答、推理、代码生成等任务上取得相当不错的结果。

最新发表在国际期刊上的 LLM 综述进一步把视角拓展到架构演进、参数高效微调、多模态扩展和经济影响等多个方面,认为大模型已经从“自然语言处理工具”升级为“通用基础能力平台”,在软件开发、教育、医疗等行业产生了深刻影响(MDPI)。与此同时,这些综述也非常清楚地指出,大模型虽然在很多基准上表现接近甚至超过人类,但在常识、可解释性、安全可信等方面的局限性同样显著。

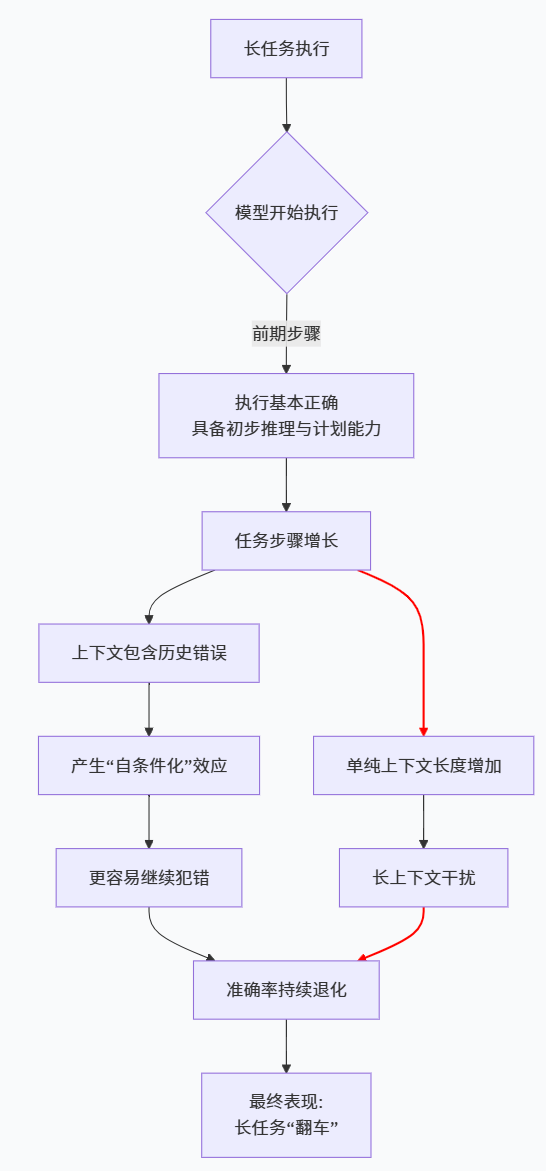

另一类综述则把重点放在“推理能力”上。例如最新关于 Large Reasoning Models 的系统综述就详细分析了通过构造推理数据、过程级别奖励模型和测试时搜索策略等手段,如何让大模型在数学、逻辑和程序合成任务上表现出更强的推理能力(科学直通车)。然而,正如前面提到的 Apple 研究所示,当任务复杂度继续上升时,这些大推理模型会出现令人震惊的“性能崩塌”,这说明基于当前深度学习范式堆叠出来的“推理能力”并不稳固(卫报)。

综合这些综述的结论,我们大致可以把现阶段大模型在“能力侧”的优势与局限压缩成一个对照表。

表 3-1 现阶段大模型的突出优势与明显局限(基于多篇综述归纳)

| 维度 | 典型优势描述 | 典型局限或问题 |

|---|---|---|

| 语言理解与生成 | 在多语言、多领域文本生成和理解上表现接近人类,流畅度和风格控制能力极强 | 对语义和世界的理解本质上仍是统计模式,在反常、长尾或结构化逻辑任务上容易暴露“装懂” |

| 零样本与少样本泛化 | 通过提示工程,可以在未专门训练的任务上获得可观表现 | 泛化往往严重依赖训练语料分布,对分布外任务和新概念适应能力有限 |

| 代码与数学 | 在主流编程语言和中等复杂度数学问题上能达到甚至超过普通工程师和学生水平 | 在复杂证明、系统级架构设计和跨文件长期依赖推理中容易出现严重错误和幻觉 |

| 多模态能力 | 文本–图像、多模态对话模型可以处理图片描述、视觉问答等任务 | 对真实物理世界、动力学和因果关系的建模能力仍然极弱,对视频、多步动作序列的理解尤为不足 |

| 工程可用性与生态 | 通过 API、开源模型和工具链快速集成到各种应用中,形成庞大生态 | 评测不一致、版本快速迭代导致能力难以稳定复现,安全与合规问题复杂 |

从这张表可以看出,如果只从“可以做哪些任务”这个角度看,大模型确实已经给人一种“什么都能做一点”的强烈印象;但一旦把视角切换到“是否能在开放环境中长期、可靠、自治地完成任务”,很多问题就暴露出来了。

3.2 大模型“看上去像 Strong AI”的几种典型场景

在实际使用中,大模型之所以容易被误认为“Strong AI”,往往是因为它们在某些关键场景中的表现高度拟人。

一个典型例子是对话系统。大量用户在与 ChatGPT、Claude 或各类开源 Chat 系统互动时,会感受到流畅自然的语言风格、合理的情绪回应以及对上下文的连续把握,这在心理上很容易被解读为“对方理解了我”。语言学家 Emily Bender 和 Timnit Gebru 早在“大模型爆发”之前就用“随机鹦鹉”(stochastic parrots)来形容这种现象,强调这些模型只是非常复杂的概率分布学习器,在统计上模仿语言的形态,而不是由内而外地理解意义(卫报)。

另一个例子是代码助手。当模型可以生成看起来结构清晰、注释到位、甚至能通过大部分单元测试的代码时,很多工程师会在直觉上把它当作“有一定编程能力的同事”。然而,代码生成能力更多反映的是模型在已有代码模式上的强拟合能力,面对复杂系统设计、安全关键路径或未在训练数据中频繁出现的边缘情况时,这种“编程同事”往往会暴露出非常幼稚的错误(arXiv)。

还有一些研究专门利用大模型做常识规划和任务分解,甚至把 LLM 当成“世界模型+策略”的组合,用于大规模任务规划。相关工作显示,在某些结构化场景下,大模型确实可以利用其内隐的常识来完成相当复杂的步骤规划(arXiv)。但系统性的评测表明,这种能力在稍微改变问题陈述、引入噪声或增加步骤长度后就会迅速退化,远未达到人类在开放环境下的那种稳定、可迁移的规划水平(科学直通车)。

这些现象构成了“大模型像 Strong AI”这一错觉的主要来源:在短时、封闭、语境良好的交互中,大模型的行为模式与人类极其相似;但一旦从时间、任务和环境三个维度拉长观察窗口,它们的局限性就会迅速显现。

4 为什么现有大模型还不算 Strong AI:从能力到结构的多维差距

如果要回答标题中的问题,就必须把 Strong AI 的理论画像与大模型的现实图景放在同一张坐标纸上进行逐一对比。

4.1 通用性与“泛化范围”的误会:大模型只是“窄通用”

很多关于 AGI 的乐观论述都会强调大模型在多任务、多模态上的“通用能力”。例如 LLM 综述就反复展示模型在问答、翻译、摘要、推理、代码、推荐等任务上的强大表现,并用“通才模型”来形容这种一模多用的特性(arXiv)。但从 Strong AI 的视角看,这种“通用”实际上仍然是高度受限的。

首先,大模型的通用性主要存在于“文本接口世界”之内。即便多模态模型可以处理图像和少量语音,它们对真实物理世界的建模仍然主要通过文本和静态图像间接完成,对连续空间、动力学和具身互动的理解还极其贫弱。以 AGI 测试中提出的具身智能、社交智能等维度为参照,当前系统在这些方向上的能力几乎可以忽略不计(科学直通车)。

其次,大模型在多语言、多文化环境中的表现存在显著不均衡。最新的多语言大模型综述指出,在数据充足的主流语言上,模型表现可以接近甚至超过传统系统,但在低资源语言和方言上,性能下降严重,甚至出现大量偏差和幻觉,这说明大模型的“世界观”严重偏向高资源语种和主流文化(科学直通车)。从 Strong AI 的角度看,一个真正“强”的智能体应当能够在多文化、多语言环境中自如适应,而不是在训练数据密集的文化圈里才勉强可靠。

第三,系统性泛化仍然是大模型的软肋。关于大模型常识能力的一系列评估工作显示,一旦需要在不同语境下保持常识一致性、处理跨句甚至跨文档的复杂常识推理,模型往往会出现严重不一致和自相矛盾(ACL Anthology)。这说明它在“知识图谱式”的结构化世界模型上仍然非常薄弱,更像是对大量局部模式的拼接,而非对统一世界的深刻理解。

从这些角度看,大模型所展现的通用性更接近于“窄通用智能”:在文本世界这一特定接口层中,它极其强大;一旦超出这一层或者要求跨领域、跨模态、跨文化的稳定表现,这种通用性就难以为继。这与 Strong AI 所期待的那种“在各种环境中稳健运作的通用智能”之间,还存在着质的差异。

4.2 推理、规划与世界模型:LRM 的崩塌与 LeCun 的批评

Strong AI 的另一个核心特征是稳定而可扩展的推理和规划能力。人类不仅可以在标准化的测试中推理,还能在复杂、开放的问题上进行多步规划和反事实思考。对比之下,大模型的推理能力越来越被证明是一种“表面推理”。

近期关于 Large Reasoning Models 的综述从数据、奖励模型和测试时搜索策略三个层面总结了如何强化大模型的推理能力,例如通过链式思维(Chain-of-Thought)、树状思维、过程奖励等方法让模型在推理过程中显式展开中间步骤(科学直通车)。这些方法在数学题、逻辑题和编程任务上确实带来了显著提升。

然而,Apple 的那篇“准确率完全崩塌”研究则对这种乐观情绪泼下一盆冷水。研究发现,当问题复杂度上升到一定程度时,无论是标准大模型还是专门强化推理能力的 LRM,都出现了非常诡异的行为:它们不仅总体准确率急剧下滑,而且在任务越难时反而花费更少的推理步骤,似乎在“自动放弃努力”,甚至在已经给出正确算法提示的情况下仍然无法解决问题(卫报)。这说明当前基于深度学习的“推理增强”在根本上仍然是脆弱的,一旦超出训练分布或提示模式,模型就会暴露出“不会真推理”的本质。

Yann LeCun 的批评从理论角度呼应了这一观察。他指出,大语言模型的训练目标本质上是“在给定上下文下预测下一个符号”,这种基于静态文本的学习机制天生缺乏对物理世界的因果建模和对长期后果的评估能力,因此很难产生真正稳定的规划和常识。他主张发展以“世界模型”为核心的新一代 AI 系统,让智能体通过与环境的互动来学习因果结构和物理规律,而不是依赖单向的文本预测(金融时报)。

从 Strong AI 的角度看,一个没有可靠世界模型和可扩展推理机制的系统,很难被视为“强智能”。目前大模型在推理和规划上的种种“技巧”,更多是一种工程上的补丁,而不是在架构上真正向人类式认知靠拢。

4.3 意义、常识与文化:大模型仍然更像“随机鹦鹉”

即便暂时撇开意识不谈,仅仅从“是否真正理解语言”这个层面看,大模型也远未达到 Strong AI 所应具备的程度。MIT 出版的一篇文章系统分析了大模型在语言认知研究中的角色,结论是:LLM 可以作为研究语言的工具,但本身并不是语言理论,它们也并不直接告诉我们“人类语言认知是如何运作的”(MIT Direct)。

这背后反映的是一种“语法 vs. 语义”的张力。大模型在统计上掌握了极其丰富的语言形式模式,但这些模式是否对应着稳定的语义结构和概念表征,是一个开放问题。关于常识和文化知识的多篇评估论文都发现,当问题涉及跨文化背景、暗含社会规范和语境时,大模型的行为会出现明显偏差,甚至在不同提示下给出自相矛盾的回答(arXiv)。

《The Limitations of Large Language Models for Understanding Human Linguistic Cognition》一文更直接指出,把 LLM 的表现当作“人类语言认知的镜子”是一种错误的比喻。作者强调,LLM 并不是从感知–行动循环和发展过程出发形成语言能力,而是在大规模语料上进行离线拟合,因此它们的错误和偏差只能在非常有限的意义上“启发”我们理解人类,而不能被视作“人类的近似模型”(MIT Direct)。

从 Strong AI 的角度看,一个真正“强”的智能体必须在世界中扎根,语言、常识和行动三者之间形成紧密的内在联结。当前大模型虽然在语言形式上表现出色,但在这种“世界–身体–语言”三角结构上仍然高度失衡,更像是超大规模的“语言表面模式压缩器”,而不是从世界结构中生长出来的理解系统。

4.4 幻觉、鲁棒性与可解释性:Strong AI 不只是“会说”,还要“说得负责”

即便在已经擅长的语言任务上,大模型的可靠性问题也严重制约了其向 Strong AI 演化的可能性。

首先是幻觉问题。关于大模型幻觉的综述给出了详尽的分类和机制分析,指出 LLM 会因为训练数据噪声、模型过度自信、提示诱导等多重原因生成完全不存在的事实或严重歪曲的内容,这种问题在开放领域问答和专业领域信息检索任务中尤为突出(arXiv)。最新的实证研究更是发现,某些新一代“推理模型”在幻觉上反而比早期版本更严重,这意味着简单追求能力提升可能会以可靠性为代价(Live Science)。

其次是评测与鲁棒性问题。EMNLP 2024 的系统评测综述指出,目前大模型评估实践在数据集构建、指标设计和实验设置上存在大量不一致,导致不同论文中对同一模型的能力描述差异巨大,很难形成可靠的纵向比较(ACL Anthology)。这意味着我们对大模型真实能力的认知本身就充满噪声,更不用说在长期部署中的表现是否稳定。

再者是可解释性与安全性。多篇综述强调,大模型内部表征高度复杂且缺乏透明度,很难对其具体决策过程给出人类可理解的解释,这在法律、医疗等高风险场景中尤其令人担忧(SpringerLink)。如果一个系统在关键决策上既会产生幻觉,又无法解释自己为什么这么做,那么无论它在“看起来有多聪明”,都很难被视为“强智能体”,更不可能承担 Strong AI 所应肩负的社会责任。

为了把“现阶段大模型”和“理论上的 Strong AI”在上述几个维度上的差距更清楚地呈现出来,可以用一张综合对照表做一个总结。

表 4-1 现有大模型与 Strong AI 在关键维度上的差距概览

| 维度 | 现有大模型(LLM 等)的典型状况 | Strong AI 所应具备的特征 |

|---|---|---|

| 任务通用性与世界覆盖 | 文本世界内高度通用,对物理世界、具身互动和多文化世界理解非常有限 | 在语言、感知、行动、社交等多模态和多文化环境下表现出稳定的通用智能 |

| 推理与规划能力 | 依赖提示工程和搜索技巧,在复杂任务上容易出现性能崩塌 | 具备可扩展、稳健的推理与规划能力,能在复杂开放任务中保持可靠表现 |

| 常识与语义理解 | 通过统计模式间接编码常识,缺乏统一世界模型,文化与语境理解不均衡 | 拥有结构化世界模型和深层语义表征,能在多语境中保持语义一致性与连贯性 |

| 幻觉与鲁棒性 | 幻觉频繁,且在模型增强后未必降低;在分布外任务和噪声环境中鲁棒性不足 | 输出可靠性极高,对未知情境有明确的不确定性表达和谨慎策略 |

| 自治性与自我监控 | 通过 Agent 框架具备有限工具调用和任务分解能力,长期自我监控能力薄弱 | 能在长期环境中自主设定与调整目标,具备元认知与反思能力,防止“自我失控” |

| 可解释性与对齐 | 内部机制高度黑箱,对价值对齐和行为约束主要依赖外部规范与防护栏 | 在架构层面内嵌可解释性与自我约束机制,能够对自身行为给出可审计的理由与保证 |

从这张表可以看出,现有大模型在很多维度上都只是刚刚触及 Strong AI 所需能力的“边缘”,更准确的说法是“在某些子任务上展现出强人工智能的影子”。如果忽略这些结构性差距,只根据表面现象把它们称为 Strong AI,不仅会干扰理论讨论,也会给社会治理和安全评估带来严重误导。

5 更深一层:从认知结构和意识视角看大模型的“硬伤”

到目前为止的讨论,主要还停留在功能和行为层面。如果进一步从认知结构和意识理论的角度审视现有大模型,很容易发现它们与 Strong AI 在“心灵层级”上的差距更为明显。

5.1 计算主义、功能主义与“会算≠有心智”

从二十世纪中叶以来,计算主义和机器功能主义为 Strong AI 提供了重要的哲学支撑。计算主义认为,心智本质上是一种信息处理过程,可以在某种形式的计算系统中得到实现;机器功能主义进一步主张,心理状态由其在系统中的因果功能角色来定义,而与具体物理实现无关(华盛顿大学教师网站)。如果这套理论完全成立,那么只要我们构造出在功能结构上与人类心智足够同构的大模型,就有理由说它们拥有真正的心理状态。

然而,这一主张在中文房间等思维实验的冲击下遭遇了强力挑战。Searle 通过“不会中文的人在房间里机械执行中文规则书”的设想指出,单纯的语法操作并不能保证语义理解,即便整个系统在外部看来像一个中文母语者,内部执行程序的人仍然可以完全不懂中文(华盛顿大学教师网站)。把中文房间映射到今天的大模型,就会得到一个直观的比喻:即便系统在输入输出行为上像是“理解了语言”,也不能证明它在内部拥有真正的语义和意向性。

这并不意味着计算主义和功能主义彻底失败,而是提醒我们:要让“功能结构实现心智”的论证成立,必须非常严谨地说明系统内部哪些结构对应于哪些心理属性,不能简单地用“它看上去像人类,所以它就是 Strong AI”来偷换概念。当前大模型在内部结构上仍然是高度同质的 Transformer 堆叠,对不同功能模块的分化、对自我模型和他人模型的表征都远远谈不上清晰,更不用说与神经科学和认知心理学的结构对应。

换句话说,从“会算”到“有心智”,中间至少还隔着一座认知架构的大山,而当前的大模型在很大程度上还停留在“放大计算能力”的层面。

5.2 意识的“难问题”与 AI 意识评估框架中的大模型

即便我们暂时接受“足够复杂的认知结构可以实现心智”的前提,Strong AI 仍然要面对意识的“难问题”。Chalmers 把意识研究区分为“易问题”和“难问题”:前者关注认知功能和信息处理,后者则试图解释“主观体验为什么会存在、又是如何存在的”(arXiv)。

在《Large Language Models Could Be Conscious?》一文中,Chalmers 把这一讨论直接引入 LLM 语境,分析了在全局工作空间、整合信息、预测加工和高阶理论等主流意识理论下,大模型在多大程度上满足“有意识系统”的结构条件。他的结论相对保守:现有 LLM 在递归自我表征、统一主体性和具身世界模型等方面明显不足,因此“很不可能已经有意识”;但如果未来系统结合长期记忆、多模态感知、具身行动和复杂 Agent 结构,那么在某些理论视角下,不能排除出现“具备非零意识概率”的系统。

多位哲学家和神经科学家的联合报告则尝试把这一分析更加系统化,提出一套“AI 意识评估框架”,列出了若干与意识相关的结构与功能指标,包括是否存在类似全局工作空间的全局广播机制、是否具有稳定的自我模型、是否能对自身内部状态形成高阶表征、是否通过预测–误差循环与世界互动等(arXiv)。报告指出,当前大模型在其中多数维度上都明显不达标,因此不应被视为有意识系统。

与此同时,另一些研究则提醒我们要“去拟人化”看待大模型。《Deanthropomorphising NLP: Can a language model be conscious?》一文在系统梳理相关理论后得出结论:至少在目前的架构范式下,把 LLM 称为“可能有意识”是缺乏依据的类别错误,这种拟人化倾向反而会阻碍我们清醒地评估其风险与能力(MIT Direct)。

从 Strong AI 的角度看,如果一个系统在主观体验和自我模型层面都明显缺位,即便它在行为层面表现得再聪明,也很难被视为完成了从“工具”到“心灵”的跨越。

6 未来路线:从“更大模型”到“更强智能”的可能方向

既然现有大模型还算不上 Strong AI,那么未来要走向更强智能,究竟需要在哪些方面做出改变?

6.1 与世界真正连上:具身、多模态与世界模型

前面提到,无论是 LeCun 对现有 LLM 的批评,还是大推理模型在高复杂度任务上的崩溃,都指向一个共同主题:如果智能系统缺乏扎实的世界模型,只在静态文本上进行模式学习,那么它的推理和规划能力很难真正稳固(金融时报)。

因此,未来走向更强智能的一条主线是向“具身、多模态和世界建模”方向演化。机器人与 AGI 交叉领域的综述工作就提出,应当通过基础模型来统一视觉、语言和动作空间,使机器人能够在多任务、多环境中构建连贯的世界表征,从而在感知–行动循环中形成更接近人类的常识和物理直觉(科学直通车)。

在纯软件领域,越来越多的研究开始尝试结合 LLM 与显式的世界模型、知识图谱和模拟环境,通过“模型+搜索+仿真”的方式提升系统在复杂决策任务中的表现(arXiv)。这些方向的共同特征是,不再把 LLM 当作“万能大脑”,而是视作世界建模和推理体系中的一个组件,与其他结构化模块协同工作。

6.2 超越被动监督:主动学习、元学习与系统 2 推理

另一条重要路线是改变学习 paradigm。主流大模型依赖的是大规模静态语料和离线监督,这种方式在捕捉统计模式上极其高效,但在主动探索、因果学习和长程信用分配方面存在天然限制。

最新关于“Large Reasoning Models”的综述强调,通过过程级奖励模型、搜索增强的推理和在线交互反馈,可以在一定程度上弥补这些缺陷,让模型逐步学会更稳定的多步推理策略(科学直通车)。与此相关的,还有围绕“系统 1 / 系统 2”区分的研究:前者对应快速、自动、基于模式的判断,后者对应慢速、刻意、可解释的推理过程。许多工作尝试在 LLM 外部包裹一个“系统 2 层”,通过显式规划、搜索和反思机制来增强其决策质量。

幻觉缓解的最新综述则从应用角度强调,未来的可靠大模型系统需要以检索增强生成(RAG)、结构化工具调用和多重自检为基础,使模型在输出前能够尽可能地“对自己负责”,而不是把所有错误都归咎于用户或下游系统(arXiv)。

从 Strong AI 的视角看,这些工作虽然距离真正的“自我学习”和“元认知”还有相当距离,但至少在构建“能在运行中不断修正自己”的智能体方面迈出了实践步伐。

6.3 开源生态:机会、风险与“路线纠偏”的可能性

开源社区在推动“从深度学习到更强智能”的过程中扮演着极为重要的角色。AGI-Survey 等项目通过持续收集和分类 AGI 相关论文,试图给出一幅跨学科的“AGI 地图”,涵盖认知机制、系统实现、对齐问题和发展路线等多个方面(GitHub)。对工程师来说,这些资源提供了从“堆参数”转向“做结构”的知识入口。

与此同时,开源大模型的综述与比较研究让我们能够以更加透明和可复现的方式观察不同架构与训练策略对能力的影响,从而避免陷入对单一闭源系统的过度依赖(MDPI)。在幻觉缓解、多语言公平性和评测可靠性等方面,大量开源论文和工具也为“纠偏”提供了现实可用的方案(arXiv)。

当然,开源同样带来风险。随着越来越多高性能模型和 Agent 框架被开源,如何防止它们被用作自动化攻击、信息操纵或构造危险系统,成为 AI 安全研究的重要议题(东艾国际)。从 Strong AI 的角度看,越接近“强智能”的系统,其开源与否越是需要慎重对待,这也是当前很多 AGI 治理讨论的核心矛盾之一。

7 对工程师的实际建议:在“非 Strong AI 假设”下使用大模型

站在 优快云 开发者的视角,理解“现有大模型还不算 Strong AI”,不仅是一个理论问题,更直接影响日常工程决策。

首先,在系统设计层面,应当默认大模型是“强大的弱 AI”,而不是“早期 Strong AI”。这意味着在做架构时,要清楚哪些能力可以放心交给模型,哪些地方必须有传统算法、规则系统或人工审核兜底。特别是在安全敏感、合规要求高的场景,把 LLM 放在流程的“建议层”而不是“决策层”,往往是更现实的选择(arXiv)。

其次,在评估与调试时,要尽量采用更系统的测试方法,而不是只凭少量示例的直觉印象。EMNLP 2024 的评测综述给出了很多实践性建议,例如注意构造覆盖不同难度、不同分布的数据集,关注模型在边缘案例和组合泛化任务上的表现等(ACL Anthology)。对于个人或小团队来说,即便无法搭建完整的评测基准,也至少可以在业务数据上构造一个小规模但多样性足够的测试集,定期回归。

再次,在面对幻觉和不确定性时,可以优先考虑检索增强、工具调用和自检机制。最新关于幻觉缓解的应用导向综述表明,通过 RAG、结构化调用外部 API 和设计多轮自我反思与交叉验证,可以显著降低幻觉率,尤其是在需要事实准确性的任务中(arXiv)。

最后,在团队讨论和对外沟通时,最好避免使用“Strong AI”这类概念模糊又高度情绪化的词汇,而是尽量用更精确的描述,例如“在文本任务上具有强通用性的模型”“具备有限自治能力的 Agent 系统”等。这样既有助于避免过度承诺,也能在沟通中保持对技术边界的诚实。

8 结语:在 hype 与现实之间重设对 Strong AI 的期待

回到标题中的问题:为什么现有大模型还不算 Strong AI?简单的回答是,因为它们在通用性、自治性和心灵属性三个核心维度上都还远远没有达到 Strong AI 所要求的水平;复杂一点的回答是,因为我们在讨论“强人工智能”时,其实同时在谈三件彼此相关但不完全重合的事情:可计算性与算法边界、认知架构与世界模型、意识与主观体验。

大模型无疑在“算法能力”和“任务表现”这两个方面给出了堪称震撼的成绩单,让很多原本遥不可及的应用成为现实;但这并不意味着我们已经跨越了从“强工具”到“强心灵”的那道鸿沟。相反,正是因为它们在短期交互中的高度拟人化表现,更需要我们在理论和工程层面反复提醒自己:它们仍然是模式学习器,而不是会感受、会理解、会承担道德责任的主体。

这并不削弱大模型的价值。恰恰相反,只有在“非 Strong AI 假设”下清醒地使用大模型,我们才能最大化其工具价值,最小化其风险,并为未来真正意义上的 Strong AI 留出足够的理论、工程和伦理空间。当我们不再急于给每一个新模型贴上 AGI 或 Strong AI 的标签,而是认真地在 Levels of AGI 这样的能力光谱上为它找到位置时,关于“人工智能将走向何方”的讨论,才有可能从炒作回到理性,从想象回到可以被验证和修正的路线图。

参考资料

[1] John R. Searle, “Strong AI, Weak AI and Cognitivism,” 收录于相关讲义与论文集中,对 Strong AI 与 Weak AI 做出经典区分。(华盛顿大学教师网站)

[2] J. Goode, “Strong and weak AI narratives: an analytical framework,” AI & Society, 2024. 文章指出现实中所有现存 AI 系统都属于弱 AI,Strong AI 仍然是科幻与理论假设。(SpringerLink)

[3] IBM, “What is strong AI?” 官方技术科普页面,2025。对 Strong AI 的工程与商业语境定义进行了总结,并明确指出 Strong AI 目前仍停留在理论层面。(IBM)

[4] Gabriele De Luca, “强人工智能与弱人工智能的区别,” Baeldung 中文网,2025。面向开发者介绍 Strong / Weak AI 概念及其在当代技术中的应用。(Baeldung 中文网)

[5] Bowen Xu et al., “AGI-Survey: An Ongoing Survey of Artificial General Intelligence,” GitHub 项目与相关中文解读,持续梳理 AGI 相关研究。(GitHub)

[6] Meredith Ringel Morris et al., “Levels of AGI for Operationalizing Progress on the Path to AGI,” arXiv:2311.02462, 2023;及其第三方解读与中文翻译。(arXiv)

[7] Wayne Xin Zhao et al., “A Survey of Large Language Models,” arXiv:2303.18223, 2023;以及多篇中文解读文章。(arXiv)

[8] M. T. R. Laskar et al., “A Systematic Survey and Critical Review on Evaluating Large Language Models: Challenges, Limitations, and Recommendations,” EMNLP 2024.(ACL Anthology)

[9] M. O. E. Khan et al., “Large Language Models: A Survey,” Electronics, 2024. 综述大模型的架构、应用和局限。(MDPI)

[10] “A Survey on Large Language Models with some Insights on their Generalization, Planning, and Reasoning Abilities,” arXiv:2501.04040, 2025。聚焦于大模型的泛化与推理能力。(arXiv)

[11] “Toward large reasoning models: A survey of reinforced reasoning with LLMs,” Patterns, 2025。系统梳理大推理模型的发展和局限。(科学直通车)

[12] Yihan Li et al., “Mitigating Hallucination in Large Language Models (LLMs): An Application-Oriented Survey on RAG, Reasoning, and Agentic Systems,” arXiv:2510.24476, 2025。(arXiv)

[13] Shucheng Li et al., “A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions,” arXiv:2311.05232, 2023。(arXiv)

[14] Md. T. R. Laskar et al., “Survey and analysis of hallucinations in large language models,” Frontiers in Artificial Intelligence, 2025。(Frontiers)

[15] “Hallucination Mitigation for Retrieval-Augmented Large Language Models: A Comprehensive Review,” Mathematics, 2024。(MDPI)

[16] E. Bender & T. Gebru, “On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?” FAccT 2021;以及后续媒体对“随机鹦鹉”的讨论。(卫报)

[17] “The Limitations of Large Language Models for Understanding Human Linguistic Cognition,” Open Mind, 2024。(MIT Direct)

[18] “Understanding the Capabilities and Limitations of Large Language Models in Cultural Commonsense Tasks,” 相关 arXiv 论文,2024。(arXiv)

[19] “A survey of multilingual large language models,” Patterns, 2024。(科学直通车)

[20] “Large Language Models as Commonsense Knowledge for Large-Scale Task Planning,” arXiv:2305.14078, 2023。(arXiv)

[21] “Integration of cognitive tasks into artificial general intelligence,” iScience, 2024。提出认知科学启发的 AGI 测试框架。(科学直通车)

[22] Florin Leon, “A Review of Findings from Neuroscience and Cognitive Psychology as Possible Inspiration for the Path to Artificial General Intelligence,” arXiv:2401.10904, 2024。

[23] D. J. Chalmers, “Could a Large Language Model be Conscious?”, arXiv:2303.07103, 2023。

[24] Eric Schwitzgebel, Anil Seth et al., “Consciousness in Artificial Intelligence: Insights from Neuroscience and AI,” arXiv:2308.08708, 2023。

[25] “Deanthropomorphising NLP: Can a language model be conscious?”, PLOS ONE, 2024。

[26] Financial Times, “Meta AI chief says large language models will not reach human intelligence,” 2024。(金融时报)

[27] Apple 研究团队关于 Large Reasoning Models 的实验论文及 The Guardian 等媒体报道,揭示复杂任务下推理模型的“准确率崩塌”。(卫报)

[28] 一系列关于大模型幻觉、科学论文误读和风险的实证研究与媒体报道,如 Royal Society Open Science 论文和 LiveScience 的科普文章等。(Live Science)

1718

1718

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?