1. 引言

时间序列分析是数据科学和机器学习领域的重要研究方向,涉及股票价格预测、天气预报、传感器数据分析等众多实际应用场景。传统的时间序列分析方法主要依赖于统计模型如ARIMA和基于循环神经网络的深度学习方法如LSTM、GRU等。然而,这些方法在处理长序列依赖关系和并行计算方面存在固有限制。

Transformer架构自2017年在"Attention is All You Need"论文中首次提出以来,彻底改变了自然语言处理领域的格局。近年来,研究者们开始探索将Transformer应用于时间序列分析任务,并取得了显著的成果。本文将深入探讨Transformer在时间序列分析中的应用原理、关键技术和实际案例。

2. Transformer架构基础

2.1 核心设计理念

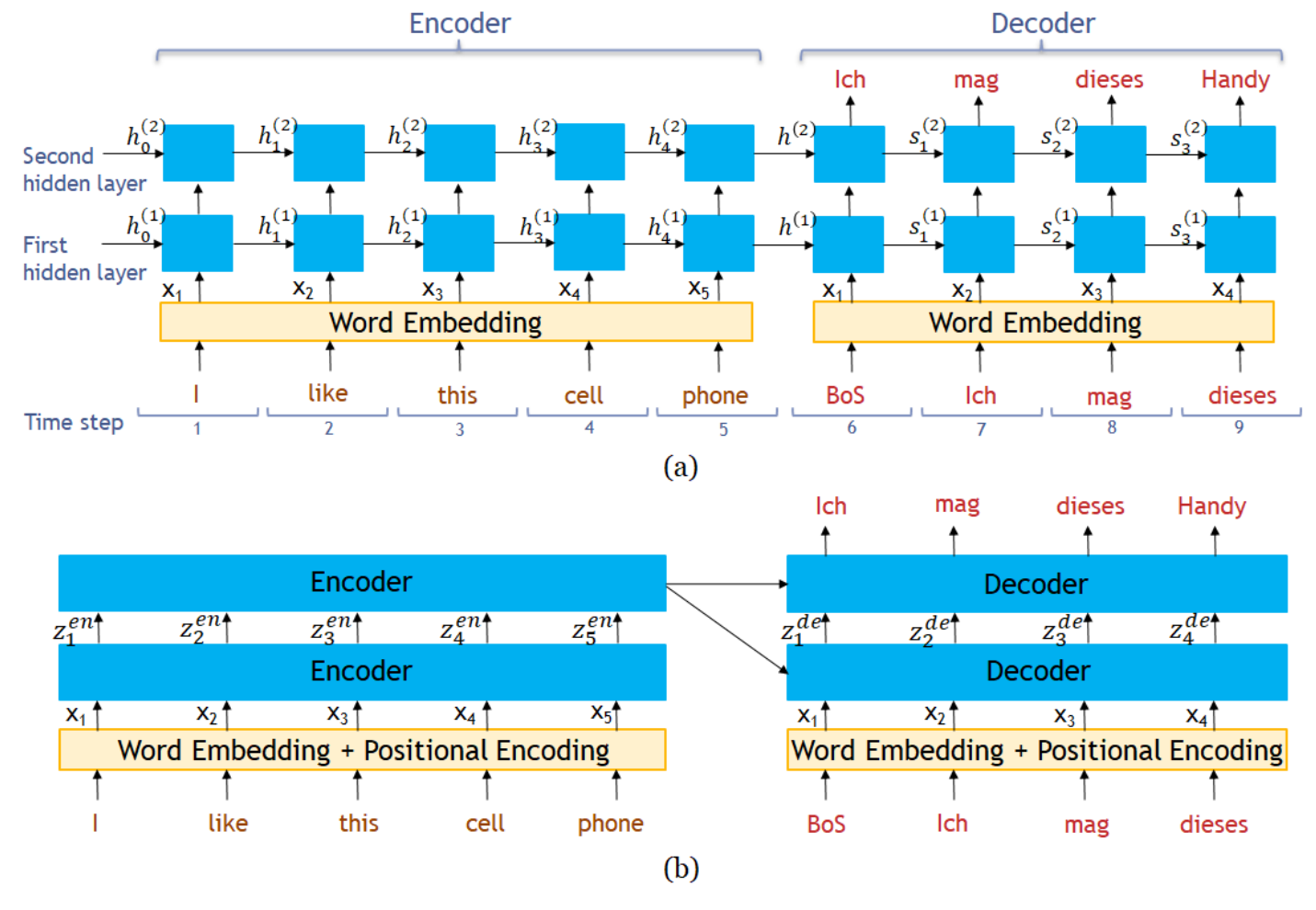

Transformer的核心创新在于完全基于注意力机制构建序列到序列的模型,摒弃了传统的循环结构。这种设计使得模型能够并行处理序列中的所有位置,显著提高了计算效率。对于时间序列分析而言,这意味着可以同时考虑序列中所有时间点之间的相互关系,而不需要按照时间顺序逐步处理。

Transformer的编码器-解码器架构特别适合时间序列预测任务。编码器负责理解历史时间序列的模式和特征,解码器则基于这些特征生成未来的预测值。这种架构的优势在于能够捕获长距离的时间依赖关系,同时避免了RNN系列模型中的梯度消失和爆炸问题。

订阅专栏 解锁全文

订阅专栏 解锁全文

1038

1038

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?