第二部分: 框架与指南

一 引言

自诞生以来,机器人一直被视为自主代理,扮演着关键角色,包括娱乐者、教师、 教练、助手和合作者——这些正是人类自身在社会中所扮演的角色。这些角色要求 机器人通过利用人类在言语和非言语交流中丰富的线索空间,以人们彼此沟通的方 式来与其用户进行交互。同时,机器人还被期望在与用户互动的语境中,倾听并观 察用户,建立必要的内部表征,以实现有效对话。

然而,这一令人振奋的愿景仍远未实现。其结果是,人们对与机器人交互的期 望与实际机器人系统所提供的交互之间存在不匹配。弥合这一差距需要在三个关键 方面取得重大进展。第一,要建立对人类语言的系统性理解,以支持其计算表示; 第二,要使机器人能够处理人类语言:根据交互的动态语境进行表示和规划,并生 成用户能够理解的语言;第三,要开发一种设计方法,将关于人类语言的知识转化 为模型、算法和系统。这三者缺一不可,才能实现以人类对话为模型的有效人机交 互的机器人产品和应用。

过去二十年中,这三个领域都取得了巨大的进展。行为科学、机器人学和设计 领域的研究使我们更接近实现人机对话系统的愿景。其中最引人注目的是一个虽小 但不断增长的研究领域,它处于机器人学、认知科学、语言学和设计的交叉点上。

这些研究探索了人类语言如何作为资源,用于设计能够实现复杂人机对话的机制。

结果是创造了新型的模型、算法和系统。这些创新使机器人能够理解人类的语 言和非语言交流;维持适当的基于会话或任务的交互;并生成有效传达机器人目标、 信念和意图的语言。本章概述了这一研究领域,并展示了其实现丰富而高效的人机 对话的潜力。通过两个例子,我们展示了如何将人类对话中的线索和机制转化为模 型和算法,使机器人具备与用户有效进行对话的工具。

现在已形成了一部分明确的文献,强调了人机对话相关的机遇与挑战。然而, 这些文献分散在多个研究领域中,包括机器人学、多模态界面,

82 第二部分:框架与指南

对话系统、人机交互和人机交互领域。因此,该领域的研究缺乏标准化、已验证和 共享的模型、算法和实现。此外,整个研究工作中的进展和开放性挑战尚未得到综 述、总结和整合。为了弥补这一空白,下一节对相关文献进行了综合综述。该综述 自然引出了我们在第三节中提出的人机对话系统的概念框架。该框架的目标是指导 对现有的人‐机器人对话系统的分析,并为未来系统的设计建立一个框架。该框架还 为第四节中呈现的示例研究提供了语境。本章最后通过讨论由我们对文献的回顾、 框架的整合以及示例研究的发现所启发的机遇与挑战而结束。

二 文献综述

研究探讨了如何将人类对话中的线索和机制整合到远程操作机器人系统和自主机器 人中,使其与用户进行情境化交互(即语言使用受社会、文化和物理环境影响( Goodwin 2000))。贯穿这项工作的共同主线是,努力将人机交互从用户作为低 层次机器人功能的监督者或操作员的角色,转变为用户与机器人之间涉及高层级交 流的“对等交互”。因此,研究努力集中在探索人类对话的哪些方面可能促进此类 交流。最初,这是通过将基于文本或口语对话的元素引入机器人系统的控制机制来 实现的。最近,则通过构建支持面对面的情境化人机对话的复杂对话机制来实现。

从低级控制向高级交互的转变在远程操作机器人系统中表现得最为明显。针对 这些系统的研究将基于文本或电话的对话系统的元素引入了行星探测车(方、索普 和鲍尔 2003)、无人机(UAV)(莱蒙等 2001)、遥控室内移动机器人(特奥巴 尔特等人 2002)以及机器人叉车(特莱克斯等 2012)的控制界面中。此类元素的 引入,将传统的低层次监督控制取代为混合主动权(一种灵活交互范式,其中每个 代理——即人类与机器人——各自贡献其最擅长的部分来完成任务(Allen, Guinn 和 Horvitz 1999年))的“协作控制”(方、索普和鲍尔 2003 及 考普、 马卡连科和达兰特‐怀特 2010)。因此,操作员与机器人作为合作者,通过对话行 为(在对话中充当言语行为的话语,如命令、查询和回应)共同解决导航、感知、 操作和决策中的问题。

4 实现人机对话 83

(方、索普和鲍尔 2003)。协作控制中的沟通通过图形用户界面(GUI)(方、 索普和鲍尔 2003)、口语(特莱克斯等 2012)或两者结合的方式实现(莱蒙等 2001)。这些系统涉及不同程度复杂性的对话管理,从在特定领域中使用有限词汇 和语法(方、索普和鲍尔 2003)到集成具备复杂的多模态对话能力的对话管理器 (莱蒙等 2001)。

与此同时,研究人员探索了开发机器人系统,利用面对面人类对话的某些方面 来模仿情境交互中的人类语言和行为。早期关于实现与机器人有效面对面交互的研 究主要集中在模仿人类对话,以实现多模态、多方对话(松坂、藤江和小林 2001; 斯库比克等 2002)以及情境对话(莫拉茨、费舍尔和滕布林克 2001)。

近期的研究集中于开发实现基于任务的对话或人类与机器人之间的联合行动的 机制(福斯特等人(2006)和霍夫曼和布里齐尔 2007)。根据塞班兹、贝克林和 诺布利希(2006)的观点,联合行动可以被定义为“任何一种社会交互形式,其中 两个或更多个体在空间和时间上协调其行为,以引起环境中的变化”(塞班兹、贝 克林和诺布利希 2006:70)。研究人员还探讨了机器人如何在语言使用中实现语 言和非语言有效性(托里、福塞尔和基斯勒 2013),以及通过自适应对话根据用 户特征或用户状态的实时变化来调整对话行为(萨法尔和穆特鲁,2012)。以下各 小节概述了旨在实现面对面的情境化人机对话中这些关键特征的研究。

多模态、多方对话

人类交流研究强调了言语、手势和目光之间需要精细协调,才能实现复杂思想的符 号交流(斯特里克 1993)。早期的人机对话研究通过探索机器人如何实现多模态对 话,特别是理解涉及语音、手势和注视的人类交流行为,承认了这种协调在对话中 的重要性。Skubic 等人(2004)开发的一个系统整合了语音和手势输入、空间信 息的语义表示以及从环境中感知到的现实世界的空间信息。该系统利用这些数据来 解释并执行命令,例如“去那里[伴随指示性手势]”或“后退这么远[伴随象形手势]”。

施蒂费尔哈根等(2004)开发的类似系统以语音为主要输入交互方式,利用说话者 的手势和头部姿态,在涉及指示、语音识别错误或存在多个可能的语音或手势解释 的情况下消除信息歧义。施蒂费尔哈根等(2007)

由| 斯德哥尔摩大学认证下载日期| 11/ 15/15 1:45 PM提供

84 第二部分:框架与指南

扩展了该系统,以集成一个对话框架,该框架融合来自语音、手势和头部姿态识别 器的信息,以确定所识别的多模态输入是否提供了足够的信息来实现对话目标。

尽管对话研究主要关注二元交互,但真实世界交互通常涉及多个参与者,他们 以不同的参与度参与到交互中(Goffman 1979,Goodwin 1981 和 Levinson 1988)。人机对话领域的研究已开发出识别来自多个用户输入并面向多个用户进行 响应的模型与机制,使机器人能够参与类似的现实世界交互。该研究的一个早期例 子是松坂、藤家和小林(2001年)开发的机器人系统,该系统集成了说话人识别、 语音识别、手势、句法分析、轮流发言和视线控制等机制,从而使机器人能够识别 多个用户的输入并与之进行对话。近期的研究探讨了机器人如何在多方交互中标示 不同级别的注意力(穆特鲁、福尔齐齐和霍奇斯 2006)或不同的参与者角色(穆 特鲁等人 2012 和 穆特鲁等人 2009)。穆特鲁、福尔齐齐和霍奇斯(2006)基于 对人类视线观察所得的分布数据建立了一个机器人视线模型。该模型使机器人能够 将其注意力分配给交互中的所有参与者。穆特鲁等人(2009)应用了一种视线模型, 使机器人能够向具有不同会话角色的用户(例如受话者、旁观者或无意听者)发出 信号。他们在评估该模型的有效性时发现,参与者有97%的时间遵循了机器人所标 示的角色。这些结果为视线线索在人机对话中指示参与者角色的关键作用提供了实 证基础。

B 情境交互

情境化交互这一概念指的是语言使用根植于并受交互语境中的社会、文化和物理特 征所影响(古德温 2000)。在共处一地的情境化交互中实现人机对话的一个关键 挑战,是建立机器人与其用户之间的共享表征,以实现语言与外部世界之间的映射。

这种映射如何内置于(人机)系统之中,通常被称为符号接地问题(哈尔纳德 1990)。

在人机对话语境下,关于此问题的早期研究涉及空间维度的计算模型开发。其 中一些工作致力于基于人类口语的空间指代研究(莫拉茨、费舍尔和滕布林克 2001)。其他研究人员则专注于使机器人能够利用多模态信息进行空间推理和沟通 的方法(斯库比克等人 2004 和 斯库比克等人 2002)。莫拉茨、费舍尔和滕布林 克(2001)开发了一种人类空间指代的计算模型,该模型整合了不同的参考系统 (例如,一种intrinsic参考系统,以允许用户进行空间指

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 85

与机器人相关的参照关系,以及一种相对参考系统,使用户能够根据环境中显著的 物体或一组相似物体来指代目标。斯库比克等人(2002)设计了一种方法,通过机 器人的传感器生成占据栅格地图,并基于内在参考系统自动提供空间关系。利用该 方法,机器人能够回答诸如“你看到多少个物体?”和“柱子在哪里?”之类的问 题,回应如“我检测到四个物体”和“柱子主要在我前方但略微偏右,该物体非常 近”。这项工作的扩展使得机器人能够解释多模态对话行为中的空间指代(包括口 语和手势指代),并根据这些指代执行命令(斯库比克等 2004)。在该系统中, 机器人整合多模态输入以执行命令,例如“走到柱子右边”和“去那边 [并伴随指 示性手势]”。

最近的研究提出了用于解决符号接地问题的方案,使机器人能够解释复杂的空 间指代。一些研究人员通过加强空间推理机制与对话管理之间的集成来应对这一问 题。特奥巴尔特等人(2002)开发了一个系统,用于对占据网格进行先验标记,从 而使语音对话系统能够将推理应用于空间推理,并处理更复杂的空间指代。克鲁伊 夫等人(2007)提出了使用人类辅助建图(HAM)。HAM支持从情境化人机对话 中自动获取和标注空间信息。该方法解决了对机器人内部空间信息表征进行先验标 记的局限性。其他研究人员则采用新颖的语言元素与外部世界之间映射的表示方法。

特莱克斯等人(2011)引入了广义共知图(G3)。该框架利用语音命令的组合性和 层次性结构,自动生成空间指代与外部世界元素(例如位置、物体和事件)之间映 射的概率图模型。该框架在控制机器人叉车上的实现使机器人能够正确理解和执行 诸如“把托盘放到卡车上”之类的命令。

C 联合行动

机器人与人类之间的面对面交互可能还涉及任务的联合执行. 这些联合行动可能在 交互各方的不同参与度下发生;从用户向机器人发出命令并由机器人执行(例如, 命令机器人叉车“将托盘放到卡车上”(Tellex et al. 2011)),到用户与机器人 共同完成复杂的装配任务(例如,联合组装玩具(Foster et al. 2006))。由于联 合行动的需求,已催生了大量关于有效任务型通信的研究,这些研究需要开发多种 模型和系统以实现协调与沟通。

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

86 第二部分:框架与指南

在联合活动中。理论上,这项工作基于克拉克(1996:3)的观点,即语言使用是一 种联合行动,其中基于任务的通信、协调和执行是参与智能体之间更广泛对话的一 部分。西德纳、李和莱什(2003)将机器人的沟通行为定义为机器人与其用户必须 共同完成的联合任务的一部分。他们将这些行为的描述表示为task models(见第三 节.C)。例如,向一组访客进行演示的任务包括一组低级的行为描述——或称任务 模型——这些描述规定了机器人必须执行的适当语音和手势。福斯特等人(2006) 开发了一种基于对话的Collaborative Problem-Solving(CPS)模型的人机对话系 统。在CPS中,智能体根据称为recipes的相似模型执行沟通行为和任务动作,以实 现共同目标——或称为objectives(布莱洛克和艾伦2005)。

关于基于任务的人机对话的其他研究采用了分别用于任务及其相关对话的独立 表示(和模型)。该方法将两者实现为相互通信的独立系统组件。福斯特和马西森 (2008)在一项应用中,让机器人向用户提供组装玩具飞机的指令,并监控用户对 飞机的装配过程。该系统包含两个任务型组件:任务规划器和对话管理器。任务规 划器维护一个完成任务所需步骤的图模型,以及一个对象清单,该清单利用机器人 视觉系统的相关信息来跟踪装配过程中所有物体的状态。这些任务型组件通过信息 状态更新模型与对话管理器进行通信(特劳姆和拉尔松2003)。该模型结合来自任 务型组件的所有可用信息以及用户的语音输入,确定适当的对话输出。另一个任务 与对话表示明确分离的例子是佩尔塔森和弗雷德(2010)开发的基于模式的混合主 动PaMini框架。PaMini框架包括一种用于任务相关行为和信息表示与处理的任务 状态协议,以及一组表示人类对话中常见模式(例如问答对)的对话结构。任务状 态协议这一组件支持混合主动性交互,并基于通过对话子系统获取的信息实现任务 模型的学习。佩尔塔森和弗雷德(2011)将该框架应用于他们称为“好奇机器人” 的机器人学习场景中,在该场景中,机器人学习标记并抓取物体。“好奇机器人” 展示了将任务表示与对话表示分离的可行性。

1 Foster 等人(2009)对实现任务和对话目标的不同方法进行了讨论。

由| 斯德哥尔摩大学提供 真实认证下载日 期 | 11/15/15 1:45 PM

4 实现人机对话 87

D 语言和非语言有效性

大量关于人机对话的研究探索了能够帮助机器人理解和生成适当对话行为的模型。

然而,人机对话中另一个同样重要但研究不足的方面是修辞能力(Hartelius 2011)。修辞能力涉及有效使用从礼貌(布朗和莱文森 1987)到手势(Iverson 和 Goldin‐Meadow 1998年)的言语和非言语线索。这些线索将抽象的对话行为转化 为有效的语音表达,为人机对话创造了丰富的设计空间(穆特鲁 2011)。Torrey、 Fussell 和 Kiesler(2013年)开展了为数不多的对该空间的探索之一。他们研究 了模糊语(例如“有点儿”)和话语标记(例如“基本上”)对人类用户接受机器 人指令的意愿以及对机器人感知的影响。他们发现,使用模糊语或话语标记的机器 人被认为更具体贴性、更受欢迎,且控制感更低。

研究人员发现,副语言线索(如情感表达)会影响人机对话。Breazeal( 2001年)调整了机器人语音,使其与人类语音中的发声情感参数相对应。其中一个 参数是音高范围——基频(f0)变化的范围。她发现,人们能够准确识别这些线索的 时间在25%到84%之间,远高于随机水平(17%)。Scheutz、Schermerhorn和 Kramer(2006)通过添加反映任务紧迫性或用户当前压力水平的情感表达来增强 机器人语音。他们调节语音合成器的参数,以实现更明显的音高变化,从而表达 “恐惧”。对其系统的评估显示,当机器人在其语音中使用情感表达时,人机任务 表现优于未使用情感表达的情况。

关于人机对话中非言语有效性的研究构成了丰富的知识体系,包括注视(西德 纳等人 2004)和手势(黄和穆特鲁 2013a)等不同方面如何提升机器人语音的表 达有效性。早期关于非言语有效性的研究包括西德纳等人(2004)开发的一个机器 人对话系统,用于向参观者进行演示。该系统引导机器人在提供言语解释的同时, 注视感兴趣的对象。西德纳等人(2004)发现,当机器人表现出注视行为时,参观 者与其互动的时间更长,注意力更集中,并且比仅使用语音时更频繁地回望机器人。

穆特鲁、福尔齐齐和霍奇斯(2006)开发了一个面向两名听众讲故事的机器人系统。

该机器人根据从人类讲故事者获得的分布参数来控制其视线对听众的注视与移开。

为了评估机器人视线对故事记忆保留的影响,研究人员操纵了机器人注视听者的程 度,发现增加的注视提高了女性的故事记忆保持,但对男性无显著影响。在类似的 讲故事场景中,黄和穆特鲁(2013a)也采用了基于人类讲故事者参数的注视和手 势。他们发现,机器人使用指示性手势持续提升了所有受试者的故事情节回忆效果。

此外,指示性手势、节拍手势和元

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

88 第二部分:框架与指南

指示性手势影响了女性的故事记忆保留,但只有节拍手势对男性的回忆有效。

E 适应性对话

人类在对话中不仅表现出语言、副语言和非语言线索,还会根据对话伙伴的特定特 征或这些特征的实时变化持续调整自身行为。这种适应性行为的一个常见且可靠的 例子被称为变色龙效应——即对伙伴社会行为的自动模仿或匹配(查特兰德和巴赫 1999年)。其他研究方法探讨了机器人如何调整其与对话相关的行为,特别关注此 类调整是否有利于沟通(例如,托里等人2006年),以及哪些指标和算法可以实现 这种适应(例如,萨法尔和穆特鲁,2012)。

托里等人(2006)根据用户在烹饪方面的专业知识水平调整了机器人的对话行 为。该机器人在与专业厨师互动时仅使用烹饪用具的名称,但为新手厨师提供用具 的名称和描述。他们的结果表明,根据用户专业知识调整对话内容显著减少了新手 提出的问题数量,但并未减少专家提出的问题数量。此外,这也影响了用户对机器 人的评价。在实验条件下,当机器人的语言与其用户的专业知识相匹配时,参与者 认为该机器人更有效、更具权威性且不那么居高临下。一项后续研究探讨了通过眼 神接触和任务进展延迟作为信息需求增加的预测指标,将对话适应于用户信息需求 的实时变化(托里等人 2007)。该研究发现,基于眼神接触向用户提供对指令的 进一步详细说明并未带来任何益处。另一方面,根据任务进展延迟调整信息内容可 减少参与者提出的问题数量。

Szafir 和 Mutlu(2012)开发了一个系统,使讲故事的机器人能够通过脑电 图(EEG;大脑活动的电测量)实时监测听者的注意力水平。作为回应,机器人会 自适应地调整其副语言线索的使用,特别是语音音量和手势的使用。他们评估了三 种条件:无提示(基线)、提示的适应性使用和提示的随机使用。研究发现,与另 外两种条件相比,自适应使用线索的条件显著提高了参与者保留的信息量。

这些研究说明了使用副语言线索以及根据用户的信息需求调整对话(包括信息 内容)方面的好处。Torrey 等人(2007 和 2006)的研究展示了机器人如何根据 用户特征调整其语言;Szafir 和 Mutlu(2012)则证明了用户知识、意识和注意 力的实时变化可作为此类调整的基础

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 89

自适应。协作控制领域的研究还探讨了如何修改对话行为以反映用户特征,例如用 户专业知识(方、索普和鲍尔 2003 和 方、索普和鲍尔 1999)。这项工作强调了自 适应对话在不同形式的人机交互中的优势。

III 人机对话系统框架

在本节中,我们借鉴上述关于人机对话的研究综述,综合提出一个人机对话框架。

我们概述了该框架的关键组成部分和机制,这些机制使机器人能够有效地倾听并与 用户交谈。该框架为第四节中介绍的研究提供了语境。

该框架包含六个关键组件,如下所述,并在图4.1中进行了说明。此框架的目标 是指导对现有系统的分析,并作为未来系统的起始模板。我们并不将其视为所有人 机对话系统开发的公式,因为

5 多模态 生成 语言线索 非语言线索 任务动作 #6 自适应 对话循环 #1 多模态 语言处理 #2 领域 领域处理

任务空间

机器人

User

4 对话模型

3 任务模型

紧密耦合

图4.1:基于第二节所综述的文献,对人机对话系统进行的概念性综合。六个关键组件按照本节中 介绍的顺序编号。灰色线和黑色线分别表示组件之间的通信以及与外部世界的通信。这些组件是对 可能位于机器人内部(例如用于多模态生成的语音和手势能力)或分布在环境中的功能的抽象表示 (例如用于领域处理的 overhead 摄像头系统)。

由| 斯德哥尔摩大学认证下载日期| 11/ 15/15 1:45 PM提供

90 第二部分:框架与指南

特定对话系统的设计将在很大程度上由应用领域的需求所决定。

多模态语言处理

有效的人机对话系统必须能够捕捉并解读来自一个或多个用户的语音、手势和注视 等多模态输入。在需要指示性表达以实现有效沟通的交互中,融合来自不同模态的 信息尤为重要。在多人场景中,多模态信息可能使机器人能够识别说话者以及参与 交互各方的参与者角色,因此这一点也至关重要。为了捕捉和解读多模态信息,该 组件可借助语音识别与处理技术,以及用于识别用户注视方向和手势的算法。此外, 通过捕捉和解读用户的行为与生理信号(例如,利用电信号、脑活动信号来监测用 户注意力(萨法尔和穆特鲁,2012)),还可以实现自适应的人机对话。

B 领域处理

基于任务的人机对话需要实时捕捉和解释物理世界。与任务相关的物体、人、空间 和事件;其他人类或代理协作者的物理动作;以及任务周围条件和环境的变化,在 基于任务的交互中尤为重要。实时捕捉和解释可以借助多种感知和推理子系统(例 如,基于视觉或标记的对物体、人、空间或动作的跟踪),以更新任务模型。领域 信息在涉及物理协作或情境交互的场景中特别有用,因为它使机器人能够保持对世 界的准确理解,从而执行任务步骤。例如,在协作装配场景中,机器人可能需要检 测待装配零件的位置,或评估当前装配状态是否符合任务计划(福斯特等人( 2006))。第四节中描述的机器人系统正是通过此类评估来确定是否协助用户执行 任务。

C 任务模型

基于任务的人机对话的另一个关键组成部分是任务模型——即机器人及其用户所参与任 务的表示形式(另见第二节.C)。任务模型可以是预先编写好的,也可以通过交互获得

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 91

与用户进行交互,或通过使用学习算法(例如强化学习)执行任务。任务模型使机 器人能够监控任务进度、跟踪用户或其他参与任务的智能体所采取的行为、识别任 务目标与任务动作之间的不一致性、根据任务进度调整任务计划,以及学习新任务 或任务计划。有效利用任务模型需要任务模型与对话管理器之间实现紧密耦合。这 种耦合使得机器人能够将用户输入与任务计划进行比对,或生成适当的对话行为以 传达任务步骤和目标。该耦合可以联合考虑任务和对话目标,如Collagen系统( Rich、Sidner和Lesh,2001)和CPS模型(布莱洛克和艾伦2005)的情况,也可 以分别处理,如PaMini框架(Peltason和Wrede,2010)的情况。

D 对话模型

对话模型确保机器人能够解释用户输入,生成适当的对话行为,并执行其他对话功 能(例如,错误处理)。对话模型与任务模型相辅相成,因为它通过与任务模型通 信来评估任务计划或启动任务动作。为了使对话模型能有效管理口语对话和基于任 务的交互需求,它必须支持混合主动性交互。该模型还必须能够在语言处理和生成 中处理多模态,以及涉及多个用户和其他智能体的对话(多方对话)。最后,对于 情境化交互,必须支持消歧、共知建立和修复等过程(见第四节A部分)。佩尔塔 森和弗雷德(2011)对最先进的对话建模方法进行了比较,并讨论了上述部分需求。

E 多模态生成

多模态生成包括语言和非语言策略,这些策略与任务动作一起支持任务模型中定义 的目标。例如,如果教学机器人的任务模型中的目标之一是最大化学生参与度,那 么机器人必须采用有助于提高学生参与度的行为策略和任务动作。Huang和 Mutlu(2012,2013b)开发了一个此类机制的示例,该机制允许机器人从支持设 计者交互目标的选项库中自动选择行为策略。我们认为任务动作也由多模态生成组 件驱动,因为执行这些动作的方式会影响机器人的交际有效性。例如,Dragan、 Lee和Srinivasa(2013)证明,伸手抓取动作可以被配置以增强机器人进行有效沟 通的能力。

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

92 第二部分:框架与指南

向人类观察者传达其意图。当多模态生成机制与任务与对话模型密切协作时,即可 实现这一目标。这些组件共同确定应选择哪些任务动作和对话行为,以及根据任务 目标以最佳方式执行它们的方法。

F 自适应对话

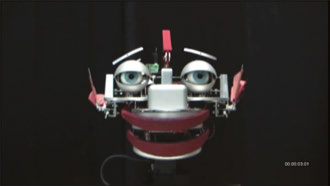

我们所提出的框架的最后一个组成部分是用于自适应对话的低层级感知‐动作循环的 表示。这与考虑任务和对话整体状态的高层级任务计划适应不同。自适应对话循环 建立了多模态处理与生成组件之间的沟通,以实现自适应响应(例如行为模仿、情 感镜像和视线跟随)。自适应对话循环是一种低层级功能,因为它由多个预设的感 知‐动作图式驱动,而不是由高层级的任务或对话计划驱动。里克、保罗和罗宾逊 (2010)开发了一种闭环动作‐感知模型,使机器人能够实时捕捉对话伙伴的头部 运动并加以模仿。将此组件从对话系统的其余部分分离出来,为人机对话系统的设 计提供了若干优势。首先,使用独立模块有助于增强自适应对话的可扩展性,使设 计者能够根据特定应用需求组合所需的自适应能力。其次,这种分离通过降低系统 其余部分的实时处理需求,提高了计算效率。第三,拥有一个独立的自适应对话循 环模块,有助于设计和实现简单的人机对话系统,例如一种通过头部跟踪用户面部 以显得生动且专注但不具备任何口语对话能力的机器人玩具。

综上所述,本节所描述的六个组成部分构成了一个丰富的设计空间,可用于创 建自然且高效的人机对话系统。这些组成部分带来了诸多机遇,同时也伴随着技术 挑战,相关内容将在第五节中进行讨论。

在下一节中,我们将介绍两项研究,以说明如何开发该框架。我们重点关注两 个组成部分:一是任务模型的开发,使机器人能够在装配任务中自主地向用户提供 指令;二是利用专业知识的语言线索的生成模型,以支持有效且有说服力的演讲的 构建。

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 93

IV 实现有效的人机对话

作为指导者、私人教练、教练、信息台服务员、接待员和销售代表的机器人必须能 够有效地与人类用户进行沟通。这需要机器人以一种能够提升用户对所提供信息以 及机器人本身的信心和信任的方式,准确地传达指令、澄清、纠正和确认。

例如,机器人减肥教练可能会提供有关活动和食物的建议,以帮助用户保持健 康并减轻体重。它必须听起来可信,否则将无法激发用户的信心和信任。同样,旅 游信息办公室的机器人服务员必须显得知识渊博且值得信赖。

机器人培训人类进行装配工作时,不仅需要建立信任,还必须教会用户如何完 成任务的每一步。然后,机器人必须监控用户对这些步骤的执行情况,并在必要时 提供澄清、纠正和确认。为了实现这些目标,机器人必须具备以下能力: 1. 语言和领域处理,用于分析用户语音和任务行为(或缺乏行为);2. 任务模型, 用于提供指令、监控任务进度并检测错误;3. 对话模型,用于解释用户输入并生成 对话行为;以及4. 生成模型,用于通过语音和非语言交流传递对话行为。

机器人的成功取决于其理解多模态用户输入的能力,以及在任务语境中理解该输入, 并生成能够推动任务进展的对话行为和任务动作。机器人还必须根据用户和任务状 态的变化调整其行为。

本节介绍的研究涉及设计此类混合主动式机器人系统的两个方面。第一项研究 描述了任务模型(项目(2))的开发与评估。该任务是教导人类学员如何组装一组管 道。该任务模型包含了指导与修复(解决沟通中断)的策略。

第二项研究描述了修辞能力的生成模型(项目(4))的开发与评估。其目标是生 成可信的、值得信赖的和有说服力的机器人语音。每项研究都从考察指导机器人模 型的人类技能开始。

用于指导与修复的任务模型

指令是一种互动过程,指导者与学生通过这种过程进行意义协商(斯肯2003年:2)。

这种协商涉及对话,各方通过对话寻求对某一主题的理解达成一致(皮克林和

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

94 第二部分:框架与指南

加罗德 2004:8)。对齐过程包括由于指导者错误或学生误解而导致的中断。这些中 断可能会阻碍在理解上达成一致的进展(加罗德和皮克林 2007)。对中断的检测 可以有多种形式,尤其是理解检查以及澄清请求和确认请求(斯肯2003年)。根据 中断的类型(即误解或不理解),说话者会采用不同的策略来修复中断(称为修复), 例如重构、扩展说明和协作式精炼(赫斯特等人 1994)。

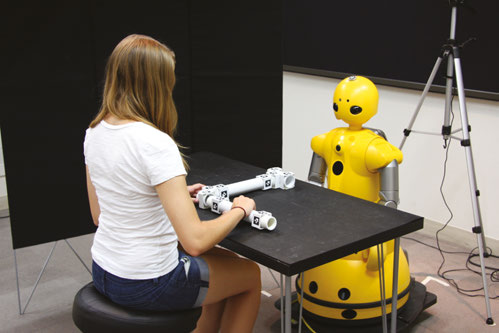

机器人指导者如何实现这种对齐?当中断发生时,它又该如何提供修复?本研 究通过开发一个任务模型来探索这些问题的答案,该模型用于检测和修复机器人的 指令与用户的任务操作之间的中断。该任务是教导受训者如何组装管道结构。选择 此任务是因为它类似于可能分配给机器人的装配任务(例如,修理自行车或组装家 具)。我们首先对执行管道组装任务的人类教师进行分析,并将这些发现作为对话 系统中的任务模型加以实现,其中机器人担任指导者角色。最后,我们在人机对话 环境中对该任务模型进行了评估。

1 研究人类如何检测和修复中断

方法。 管道组装任务——一种将一组管道连接成指定形状的多步骤任务——被用于 研究人类在指导人类受训者执行装配任务时如何检测和修复中断。

参与者。 我们收集了八组两人组人类互动的数据。参与者来自威斯康星大学麦迪逊 分校的校园社区。为了确保性别平衡研究,我们招募了八名男性和八名女性英语母 语者,年龄在18至44岁之间(平均值 = 23.75,标准差 = 8.56)。这些参与者具有 多种多样的职业和专业背景。

Procedure.

参与者面对面坐在一张桌子旁,桌上放置了三种类型的管道(短、中、 长)和两种类型的接头(弯头和三通接头)。在每次成对交互之前,其中一名参与 者(指导者)通过观看视频并练习管道装配来学习如何连接管道。指导者可使用所 需的所有时间来学习该任务。一旦指导者学会正确执行该任务,他们将被要求指导 第二名参与者(受训者)进行管道装配,且不得

长管道。在每次成对交互之前,其中一名参与者(指导者)通过观看视频并练习管道装配来学习如何连接管道。指导者可使用所需的所有时间来学习该任务。一旦指导者学会正确执行该任务,他们将被要求指导第二名参与者(受训者)进行管道装配,且不得借助视频。

每对二元交互均由一台配备广角镜头的摄像头录制,以同时捕捉两名参与者和任务空间。该任务的教学部分(不包括第一名参与者通过视频学习如何构建管道所用的时间)持续时间为3分57秒至6分44秒(分钟,11秒,SD = 2分钟,19秒)。

分析与发现。 我们对沟通中断和修复事件进行了分析和编码。编码内容包括中断的具体情况:参与者之间如何传达中断,以及如何发起和进行修复。为了确保编码数据的可靠性和一致性,两名评分者对中断进行了观察和编码。评分者间信度显示出较高的一致性水平(79%的一致性,Cohen’s κ=.74)。

参与者通过口头(例如,提出疑问)或视觉上(例如,注意到管道未按期望配置)的方式表明意识到中断。他们总是通过口头方式启动修复过程。

我们发现,65%的修复由受训者发起(学员发起的),而35%的修复由指导者发起(教员发起的)。学员发起的修复(也称为“请求”)旨在理解期望;教员发起的修复则旨在澄清或纠正受训者对任务的感知。

学员发起的修复总是通过口头陈述来澄清或确认指导者的期望。当受训者未理解或误解了指令时,就会产生请求。用于修复的口头请求范围从笼统的陈述(例如, “什么?”)到更详细的修复请求(例如,“管道应该放在哪里?”)。我们将这些陈述归入以下类别之一:困惑、确认和澄清。这些类别与以往关于修复的研究一致,这些研究将困惑确定为一种不理解的类型,而澄清则是一种误解的类型(贡西奥尔、沃尔赫尔和布斯 2010,赫斯特等人 1994 和 库洛里和劳里亚 2009)。

教员在两种情况下检测到中断:错误和犹豫。他们还通过学员发起的修复获知中断情况。虽然请求和基于犹豫的中断是由受训者的行动或无动作触发的,但错误检测需要教员对受训者的工作进行检查。错误检测是视觉上进行的,当教员注意到受训者执行了与特定指令目标不一致的操作(例如拿起了错误的零件),或当教员视觉上评估工作空间时,就会发生此类检测。教员通常在受训者完成指令后检查工作区,以确定该指令是否被正确执行。

当教师注意到受训者犹豫时,他们会询问受训者是否需要帮助。教师对犹豫做出反应的平均时间为9.84秒。根据口头和视觉输入,指导者能够确定发生的中断类型,并通过口头方式进行修复。教师选择通过重新表述原始指令来修复中断,通常是在受训者执行错误的指令部分添加信息

由 | Stockholms Universitet 提供 认证下载日期 | 11/15/15 1:45 PM

96 第二部分:框架与指南

或显得犹豫不决。教师仅修复了涉及中断的指令部分。

2 任务模型和系统结构

任务模型. 我们利用在人‐人培训研究期间收集的数据,为机器人‐人类教学对话开发了一个任务模型。在我们的模型中,我们采用模拟理论方法来指导机器人相对于参与者的行为。这是一种常见的建模人类行为的方法,该方法认为人类通过采纳其伙伴的视角来表征他人的心理状态,从而更好地理解伙伴的信念与目标(加莱塞和戈德曼 1998 以及 格雷等人 2005)。模拟理论方法也已被应用于机器人行为和控制架构的设计中,因为它们使机器人能够考虑其人类伙伴的视角(比肖等人 2011 和 尼科莱斯库和马塔里奇 2003)。在教学任务的语境中,指导者拥有一个希望传达给受训者的行为的心智模型。在给出指令后,指导者可以通过将受训者的行为与其预期动作的心智模型进行比较,并注意其中出现的差异,来评估受训者理解或表现上的差距。

根据模拟理论方法,我们为机器人定义了一组与参与者动作或不动作结果相关的指令目标P= p1 ,…,pn ,该目标基于当前指令。根据任务的不同,P 可能在指令的每一步发生变化,因为某些指令目标可能不再适用,而其他目标可能变得相关。

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 97

可能会适用。当参与者执行任务时,机器人指令员将评估工作区的当前状态是否与指令目标集P*相同。如果任何一个单独的任务目标pk与pk*不匹配,则需要进行修复 (见图4.2)。

修复的执行方式取决于哪个任务目标pk被违反(表明出现了错误)。正如我们在人与人之间的互动中所观察到的,指导者仅修复被认为不正确的指令部分。此外,集合P存在一种由指导者对任务的感知所决定的固有顺序。指导者对P的排序受到详述理论的指导,该理论指出,人们会根据自己认为最重要的内容来安排指令顺序,然后在必要时逐步揭示更详细的低级信息(瑞格尔特等人,1980年)。基于这些原则,对给定任务的集合P施加重要性递减的顺序,可以确保每个pk相对于任何pk+n(当n > 0时)具有优先性。如果多个pk被违反,则首先处理k值最低的任务目标。

一个这种顺序的例子是:当受训者拿取了错误的零件并将其安装到错误位置时,指导者首先修复所需零件的类型,然后修复该零件的位置。

我们将受训者提出的修复请求按语义类别进行分组。例如,“我需要哪一块?” 和“我应该拿哪一块?”被识别为同一个问题。然后我们允许模型根据话语的语义类别来确定应使用的适当修复行为。

由于犹豫的建模可能依赖于具体任务,因此可以通过多种度量方式来确定受训者的犹豫。对于管道组装任务,我们选择测量自工作区上次发生变化以来所经过的时间,从而对基于犹豫的中断提供保守估计。我们未使用自上次交互以来经过的时间,因为这可能导致错误地判断受训者处于犹豫状态,而实际上他或她仍在操作中。

我们将工作区连续10秒无变化视为由犹豫引起的中断。这一标准基于我们在人‐人研究中指导者在判断发生中断前等待的时间长度。

尽管我们已经讨论了针对任务目标和工作区相关错误的错误检测模型,但该模型也可扩展用于理解和修复言语错误。例如,如果参与者听错了一个问题,并以与预期答案不一致的方式回应,则需要进行修复。对于原问题的适当答案可形式化为 pk,任何未能满足 pk 的回答均可被视为需要修复的原因。

系统结构。 为了实现我们的任务模型,我们设计了能够处理视觉和语言输入的系统架构。视觉输入用于检查受训者的工作区,而言语输入则用于检测和分类受训者的语音。从

由 | 斯德哥尔摩大学 认证下载日期 | 11/ 15/15 1:45 PM 提供

98 第二部分:框架与指南

这些输入,我们的系统会确定发生的中断类型(如果有),并执行相应的响应。

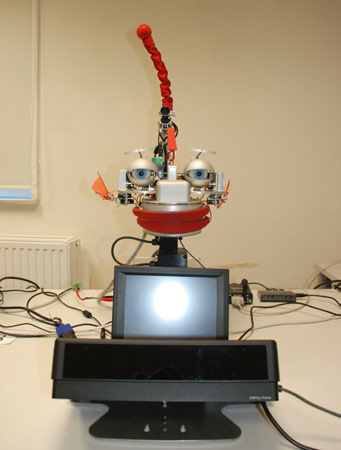

硬件。 我们在瓦卡玛鲁(Wakamaru)人形机器人上实现了我们的模型。视频通过微软Kinect立体相机以每秒12帧的速度捕获,音频通过麦克风阵列输入。摄像头和麦克风悬挂在受训者工作区上方三英尺处。该摄像头设置提供了43英寸乘24英寸的可见工作区范围。第二个立体相机放置在机器人后方,用于跟踪受训者的身体和面部。待组装的管道与人对人指导中使用的管道相同(见图4.3),但每个管道都贴有增强现实(AR)标签,以便工作区摄像头进行检测。我们总共使用了八个独特的 AR标签:两个用于弯头接头,三个用于三通接头,短管、中管和长管各一个标签。每个管道两端各放置四个标签,共八个标签,以便从任意旋转角度都能被检测到。每个标签的方向用于识别零件类型、位置和旋转。管道和接头上的标签位置和方向在每种类型的零件上保持一致,且系统已知每个零件上的标签位置。

架构。 实现我们任务模型的架构包含四个模块:视觉、听觉、对话和控制。视觉与听觉模块分别捕获并处理其对应的输入通道。控制模块利用这些模块的输入来判断是否需要进行修复,并在机器人需要反馈时向对话模块传递工作区的状态。

由| 斯德哥尔摩大学提供 真实下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 99

视觉模块检测受训者工作区的状态,并处理有关受训者位置的信息。每项功能的感知由独立的摄像头管理。该模块处理每一帧并创建一个管道连接的图(C)。构建C包含三个主要步骤:在帧中查找AR标签符号、将这些符号与部件关联,以及根据一组启发式规则确定哪些部件是相连的。

使用修改版本的字形识别与跟踪框架(GRATF)系统2,对每一帧进行AR符号搜索,从而创建一组符号G。集合G中的每个符号由其类型t、位置(x, y)和旋转θ定义。当发现一个符号时,算法会检查是否存在适当类型(例如长管、T型接头)但缺少该符号的零件。如果算法找到一个可能属于此符号的零件(基于邻近性和相似的旋转),则将该符号与此零件关联。若未找到任何零件,则创建一个新的零件,并将该符号与新零件关联。此步骤的结果是生成一组零件P,其中每个零件p由与其相关的符号集合来描述。一个零件p的所有符号构成一个边界框,用于大致估计该零件的边界。利用零件的边界,我们可以确认任意两个零件是否相连,并构建反映工作区的图结构。在受训者操作结束后,正确的图结构G*将与来自工作区的图结构G进行比较。如果这两个图是同构的——即结构完全相同——则表示受训者已成功完成

指令。如果图结构不同构,机器人将确定pk与pk *.之间差异的来源,并将该信息传递给控制模块。

为了扩展系统以支持同时检查多条指令,管道连接集C将逐步建立,从需要检查的第一条指令开始。每条指令都涉及在特定位置和特定角度添加一个新的部件。在工作区中检查第一条指令s1时,会检测到过多的部件,因为从指令到sn所需的所 有部件都放置在桌子上。因此,对于第一条指令,该模块会从C中系统地剔除所有不涉及第一条指令的管道部件。如果一个部件的移除不会导致C中的图变为不连通图,并且不会使该特定部件的数量减少到低于完成当前指令所需的数量,则该部件被定义为多余的。一旦找到一个修改版本的C,能够正确检查s1, ,则将部件逐步返回到C中,以确保其包含完成其他指令所需的所有管道部件。

视觉模块的第二个功能——检测受训者的位置——会在每一帧中进行检查。当受训者位于工作区一英尺范围内时,机器人会调整其头部位置,使其目光注视着桌子,显得正在监控

2 GRATF 是一个开源项目。它的主页是 http://www.aforgenet.com/projects/gratf/

由 | Stockholms Universitet 提供 真实下载日期 | 11/15/15 1:45 PM

100 第二部分:框架与指南

工作区。当受训者距离较远时(例如,后退检查工作或取零件),机器人会抬起头部并注视受训者的面部。如果受训者或机器人正在说话,机器人会注视受训者;如果机器人根据用户的提示检查工作区,机器人会注视工作区中已发生更改的位置。

监听模块

使用以下类别检测和分类来自受训者的语音输入(受训者的对话行为):

– 请求重复:(例如,“你刚才说什么?”“你能重复一下说明吗?”);

– 检查正确性:(例如,“这是正确的零件吗?”“我已经完成管道的安装了。”);

– 检查选项:(例如,“我需要哪根管道?”“它应该放在哪里?”)。

不属于这些类别的话语(例如,对机器人指令的确认)将被系统忽略。

一个定制的对话管理器负责协调对每个类别的回应。每个被识别的话语都有一个相关的语义含义,用以表明该话语的目的。例如,“你刚才说什么?”属于 recognition request。这些语义含义使控制模块能够识别输入话语的类型,并根据受训者工作区的当前状态恰当地回应话语。为了处理涉及工作区的请求,系统首先通过视觉模块检查工作区的状态。例如,当询问“我这样做对吗?”时,机器人需要判断工作区上管道的当前配置是否正确。

关于机器人下一个对话行为的决策由控制模块确定。控制模块使用来自视觉与听觉模块的输入。采用模拟理论方法,通过将这些输入与机器人预期在当前任务步骤指令下发生的行为进行比较来做出决策。我们定义了一个集合P,用于描述受训者可能违背的期望。任务预期的顺序基于我们对人类指导者‐学员互动研究的观察结果。这产生了以下几类期望:

– 及时行动 (p0):受训者及时采取了行动;

– 正确部件 (p1):受训者选择了正确的部件使用;

– 正确放置 (p2):受训者将部件放置在相对于当前工作区的正确位置;

– 正确旋转 (p3):受训者相对于当前工作区正确地旋转了部件。

第一个期望确保受训者在机器人发出最后指令后不超过10秒出现犹豫。违反该期望可能表明存在困惑,可被归类为犹豫性故障。最后三个期望确保

由| 斯德哥尔摩大学提供 真实下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 101

受训者已选择要添加的正确部件,已在正确位置添加了该部件,并且该部件已正确旋转。在评估来自视觉与听觉模块的输入后,控制模块将三类信息传递给对话模块:当前指令、与说话者上一次的话语相关的语义(如有),以及控制模块对工作区的评估结果(如有)。基于这些信息,对话模块选择适当的口头回应以应对检测到的中断。回应取决于受训者正在完成的任务中的哪个指令、工作区的当前布局以及中断的性质。并非所有回应都依赖于全部三项信息。例如,请求重复上一条指令与工作区当前的配置无关,对犹豫的回应则与当前工作区及与受训者的交互无关。然而,请求确认受训者是否已正确完成某条指令,则需要了解已完成的指令以及工作区的当前布局。

3 机器人‐人类指导中任务模型的评估

方法. 为了评估任务模型和系统的可行性与功能,我们研究了机器人‐人类在相同管道组装任务中的协作表现,该任务与之前描述的人‐人研究中使用的任务相同。该任务包含十五个教学步骤。

参与者。 从威斯康星大学麦迪逊分校校园及周边社区招募了八名男性和八名女性英语母语者,年龄在20至34岁之间(平均值 = 23,标准差 = 4.5)。这些受训者具有多种多样的职业和专业背景。他们均作为受训者参与了本研究。

Physical setup. 受训者被给予两个容器:一个用于放置管道,另一个用于放置接头。这些容器中仅包含完成任务所需的零件。该配置模拟了在车间或工作室中不同类型零件可能存放的设置。位于机器人和受训者之间的桌子用作受训者工作空间(见图 4.3)。

程序。 在每次实验开始时,实验人员引导受训者进入实验室,解释任务内容,并向受训者展示任务中将使用的各种管道和接头。实验人员离开房间后,机器人开始交互,说明它将提供关于如何组装管道的逐步说明。然后,机器人通过依次发出两条或更多指令,指导受训者完成管道组装任务。在整个任务过程中,机器人在必要时还提供修复操作。

由| 斯德哥尔摩大学认证下载日期| 11/ 15/15 1:45 PM提供

102 第二部分:框架与指南

听到机器人发出的指令后,受训者取出完成指令所需的零件,并在桌子上组装这些零件。如果受训者请求重复或澄清,机器人会作出回应。当受训者要求机器人检查工作区时,机器人会根据任务模型确认正确的行为或提供修复建议。若无需修复,机器人会祝贺受训者正确完成了指令,并进入下一组指令。任务完成后,机器人再次向受训者表示感谢。随后,受训者填写实验后问卷。受训者完成任务的时间介于3分57秒至8分24秒之间(M = 6分钟59秒,SD = 1分钟19秒)。

分析与发现。 为了确定我们任务模型的有效性,我们识别了受训者中发生的所有中断。我们记录了中断的类型(请求(由受训者发起的修复)、犹豫或错误检测)。对于请求和错误,我们还记录了问题的性质(例如,请求重复指令或受训者使用了错误的管道)。为确保编码数据的可靠性和一致性,中断由两名评分者进行观察和编码。评分者间信度显示了较高的一致性水平(87% 的一致性,Cohen’s κ=.83)。

在16名受训者中,共发生了21次中断。其中10次中断是受训者发出的请求,其余11次中断是通过任务模型的错误检测视觉上发现的。四次涉及受训者使用了错误的部件,两次涉及将部件添加到当前结构的错误位置,五次涉及将部件添加到正确位置但旋转方向错误。这些错误中的大多数(八次)发生在机器人发出指令的第一步。在所有情况下,机器人发出修复指令后,受训者均能够成功完成该步骤,无需进一步修复。

所有来自受训者的请求均为要求机器人重复某个已发布的单个操作步骤。受训者从未要求机器人重复两个或更多步骤(例如:“您能重复所有步骤吗?”)。修复请求在任务的各个步骤中分布均匀,没有哪个特定步骤频繁引发重复请求。

21次中断中有13次发生在交互的前四个步骤中(总共十五个步骤)。21次中断中有18次发生在交互的前半部分。其余三次中断分布在后半部分,包括一次澄清和两次重复指令请求。

4 讨论

我们的评估研究表明,我们开发的任务模型非常有效。对于每位受训者和每次中断发生情况,该任务模型均成功

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 103

完全提供了必要的修复,确保受训者不需要对指令进行进一步的修复。

尽管机器人具备响应澄清请求的能力(例如:“我需要哪个零件?”“关节如何旋转?”),但所有受训者都以重复指令的请求形式提出问题。受训者可能出于多种原因更倾向于请求重复而非针对指令的具体内容进行澄清。他们可能已经遗忘了指令的足够细节,导致难以提出具体问题。或者,如果受训者对一条指令的多个方面都需要澄清,例如既不清楚应使用哪个零件也不清楚应将其放置在何处,他们可能选择仅请求一次重复,而不是提出多个澄清问题。此外,受训者可能更希望在原始指令的语境中获得澄清。最后,尽管已指示受训者自然地与机器人互动,并被告知在需要帮助时可以与机器人交互,但他们可能并未意识到机器人能够处理澄清请求。

大多数中断发生在交互的初期,而在交互的后半部分发生的中断较少。这表明受训者在任务开始阶段需要更多的帮助。随着任务的进行,受训者逐渐适应了关键术语和概念,例如用于识别物体的词汇以及如何执行指导者要求的行为。此外,任务的进展通常会减少受训者可能做出的错误选择,从而降低了中断的可能性。

总之,本节展示了一种任务模型的具体实例化,该模型作为教学系统的一部分,能够自主检测中断并实施修复。通过视觉和语言输入,该任务模型证明了其能够识别中断,并为机器人选择适当的对话行为以修复中断。我们在一个人机对话场景中评估了该模型的可行性和功能,其中受训者在机器人指导下完成管道组装任务,并在需要时获得帮助。结果证实了自主机器人系统使用任务模型的可行性。同时,它还提供了关于人类与机器人之间对话过程如何展开的新见解,例如人们如何向机器人寻求并接收修复。

B 专家型机器人语音生成模型

作为具身社交代理,机器人有可能表现得像一个有效的人类说话者一样,能够说服听众做出某些选择。为了实现这一目标,他们必须让用户相信他们在所讨论的主题内容方面是专家。例如,如果一个机器人博物馆导游没有表现出对博物馆的充分理解,大多数人不太可能被说服去参观其推荐的特定艺术展览。在这种情况下,生成模型对于

由| 斯德哥尔摩大学提供 真实下载日期 | 11/ 15/15 1:45 PM

104 第二部分:框架与指南

信息机器人的言语生成应在话语中恰当地传达专业知识。

专业知识通常被认为是在某一特定领域拥有高水平的知识和经验。然而,专业知识还有另一个维度:修辞能力,即有效且有说服力地沟通的能力(哈特利乌斯 2011)。一个知识渊博的人可能被视为专家,但如果他们无法有效地向听众传达这种专业知识,其专业知识可能无法使他人受益。这样的人更准确地说应被称为知识渊博的,而非专家。要成为专家,既需要知识,也需要修辞努力。专家级人类沟通者会表现出某些语言线索,使听者相信该沟通者是完全合格的专家。许多说话者通过表达善意、引用过去分享专业知识的实例、对信息进行直觉性的条理组织以及使用恰当的隐喻来说服听者相信他们的专业知识(哈特利乌斯 2011)。

如果要让机器人被感知为专家,它们不仅需要具备足够的实践知识,还需要拥有有效表达这些知识所需的修辞能力。为了在机器人语音中实现这种修辞能力,我们创建了一个言语生成模型,该模型借鉴了心理学和语言学文献中关于可增强说话者修辞能力的言语线索的研究。

生成模型接收由对话模型生成的高级对话行为作为输入,并将其转换为机器人将要生成的话语。给定一个对话行为和人机交互的目标,生成模型将生成适当的话语。例如,如果机器人需要与幼儿交谈,合适的生成模型会将其语音表述得更简单。

在本研究的语境中,我们探讨了生成模型如何利用适当的专业知识的语言线索来重构机器人的语音,以提高机器人的可信度和说服力。为了评估这些线索是否有助于机器人实现模型所建议的修辞能力,我们进行了一项实验,实验中机器人向参与者提出建议,关于在虚拟城市游览过程中应参观哪些地标。

与之前所述的任务模型设计一样,我们在专家式言语的生成模型方面的研究也是从人类专家开始的。我们借鉴了心理学和语言学文献中关于人类专家所使用策略的相关研究。

1 专业知识模型

人类。 心理学研究表明,在需要一定程度问题解决的情境中,专家与新手表现出若干容易识别的差异。新手更依赖于表面特征,而专家则更关注基本原理(契等人 1981)。例如,当一个新手查看他们从未去过的城市地图时,他们可能只知道地图上所显示的信息:街道名称、地标名称以及地图上可见的其他任何内容。

由| 斯德哥尔摩大学认证下载日期| 11/ 15/15 1:45 PM提供

4 实现人机对话 105

地图本身。城市的居民(即“专家”)能够利用地图之外的信息,例如未在地图上列出的地标(伊萨克斯和克拉克1987)。

然而,拥有知识与能够分享知识之间存在一个重要区别。传达专业知识的技能,与简单地运用先验知识相比,呈现出一个完全不同的挑战。研究表明,应以一种有用的方式向可能对该主题没有先前经验的人呈现知识,并利用语言线索来支持专业性感知(金钦2003)。这种修辞努力有助于说话者被接受为专家。通过使用修辞手段增强专业性感知,这些说话者不仅仅是提供信息:他们说服听者相信该信息是重要且有用的,并应将其视为真实(哈特利乌斯 2011)。

最终,传达专业知识的目标之一是说服。说话者通过运用修辞能力展示专业知识,试图在情境中建立权威,以证明听者应重视其言论。这种修辞的使用可能导致听者在思想和行为上的服从性(马韦尔和施密特1967)。

机器人。 在人机交互领域的研究还探讨了机器人如何在信息传递角色中更有效地进行沟通。托里等人(2006)表明,机器人向用户提供的信息量取决于用户的专长水平以及信息交换的语境。对于在某一主题上已有经验的人来说,提供过多细节可能显得居高临下;而对于完全不熟悉该主题的人来说,提供不足的细节则可能没有帮助。某些信息虽然有用,但可能仅限于特定群体获取,例如诊所中的健康信息。另一项关于提供帮助的机器人的语言线索研究表明,不仅应避免使用直接命令,因为这通常会使机器人给人留下不良印象,而且使用模糊语(如“我猜”、“我认为”、“也许”等)可以减弱命令的强度,并被许多参与者认为是礼貌的(托里2009)。

研究人员已经探索了将机器人作为具有说服力的实体来使用。例如,在长期减肥计划中,有一个“专家”实体在场已被证明是有益的,因为人们会更自觉地遵守该计划(基德和布雷齐尔2008)。鲁布罗克斯等人(2010)研究了参与者在识别洗衣机最重要设置时遵循机器人建议的意愿。他们得出结论:信息应仔细措辞,以避免对机器人产生不良印象,因为这种印象可能导致人们不再愿意与其互动。

尽管之前的研究已经探讨了信息型机器人以及作为有说服力实体的机器人的对话策略,但在识别可提升对机器人专业性感知的具体言语策略方面,相关研究仍较为匮乏。在本项目中,我们通过构建一个机器人专家话语模型来弥补这一知识空白,该模型包含了基于专家言语分析得出的具体语言线索

由 | Stockholms Universitet 提供 真实下载日期 | 11/15/15 1:45 PM

106 第二部分:框架与指南

人类说话者的修辞学(哈特利乌斯 2011)。下一小节将介绍该模型以及机器人可用于有效传达其专业知识的线索。

2 专家如何交流的生成模型

我们的专家式言语生成模型基于从两个维度定义专业知识整体概念的研究:实践知识,用于体现先验知识和经验;以及修辞能力,主要指言辞技巧(Hartelius 2011)。如图4.4所示,我们建议利用这两个维度将整个专业知识空间划分为四个象限。一个实践知识水平低且修辞能力低的说话者是真实新手。相反,某个对主题内容仅有新手级理解但使用专家式修辞进行交流的人,可能会被错误地感知为专家,这种情况对应于感知专家。感知新手描述的是拥有大量实践知识但缺乏有效传达该知识所需修辞技巧的说话者。最后,真正的专家是指既具备知识又拥有言辞技巧, 在传递信息时能够有效说服他人的个体。

生成模型对于赋予机器人更多实践知识没有帮助;相反,它旨在提升机器人在修辞能力方面的语音表现。心理学和语言学的研究文献指出,存在多种语言线索可增强说话者的修辞能力,从而提高其说服听众的有效性(卡尔森·古斯塔夫森和斯特兰格特2006,玻璃

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 107

等人 1999年,哈特利乌斯 2011,海德2004年,诺埃尔,1999年和斯尼泽克和范斯沃尔,2001年)。我们在生成模型中使用了这五种语言线索。

具有高修辞能力的说话者,无论是感知专家还是真正的专家,都会在其语音中大量使用这些语言线索。而具有低修辞能力的个体,无论是感知新手还是真实新手,则很少或几乎不使用这些线索。作为社会实体的信息型机器人需要有效运用这些线索,才能被感知为专家。这些线索在表4.1中通过示例进行了总结,并在下文进行讨论。

表4.1:专家式言语生成模型中所使用的语言线索汇总。左侧是各线索及其简要描述的列表;右侧是每个线索如何用于重构机器人语音的具体示例。

| 模型线索 | 示例言语生成 |

|---|---|

| 善意 | 希望为 听者。专家:“这家咖啡馆是中午避开烈日的好去处。” 新手:“这家咖啡馆是吃午饭的好地方。” |

| 先前专业知识 | 对过去的参考 帮助经验.专家:“我每年都会向这个博物馆输送大量访客。” 新手:“每年都有很多游客参观这个博物馆。” |

| 条理性 | 更自然的组织 信息的生成。专家:“这座城堡已有1000年历史,是城市中最古老的地标。它 具有哥特式建筑。 Novice:“这座城堡有1000年的历史。它具有哥特式建筑风格。它是” 城市中最古老的地标 |

| 隐喻 | 进行描述 更易于访问。专家:“踏上阳光明媚的海滩,就像将自己包裹在温暖中” 从烘干机里拿出来的毛巾。新手:“阳光明媚的海滩相当热。” |

| 流畅性 | 减少停顿和 语音中的自信。专家:“这座雕像已有200年历史。[300毫秒停顿]它是为 尊敬国王。新手:“这座雕像已有200年历史。[一个1200毫秒停顿]它被建造是为了 尊敬国王。 |

善意。 有效且有说服力的演讲不仅仅是向听者提供信息。研究表明,一个有效的说话者还会向听者传达出考虑这些信息符合其最佳利益(Hyde 2004)。为了达到这种效果,说话者会表现出goodwill,表明说话者希望为听者带来最好的结果( Hartelius 2011)。例如,在描述一座历史博物馆时,说话者不仅可能指出该博物馆是一个热门地标,还可能建议听者如果参观该博物馆,将能够享受乐趣并了解历史。

由| 斯德哥尔摩大学提供 认证下载日期 | 11/ 15/15 1:45 PM

108 第二部分:框架与指南

先前经验。 专家研究发现,专家式言语中的另一个关键语言线索是表达先前经验 (斯尼泽克和范斯沃尔,2001年)。研究表明,有效的说话者会通过与听者建立多次积极的互动经历,或传达自己曾向之前的听者提供过优质信息的经验,以赢得听者的信任。当听者信任说话者时,他们会认为所提供的信息更具价值,并在决策过程中更依赖这些信息。例如,说话者可以提及之前一位参观历史博物馆的听者及其在博物馆的良好体验。

隐喻。 隐喻有助于在说话者与听者之间建立共同点,表明说话者正努力与听者建立联系,并分享自己的经验与专业知识(哈特利乌斯 2011)。例如,说话者可能会将参观历史博物馆的某个特定藏品描述为“步入生活在上个世纪的人们的生活”。对于对该主题经验较少的听者来说,隐喻是特别有效的语言元素,可使概念更易于理解。

条理性。 修辞能力还受到话语条理性的影响(格拉斯等人,1999年;诺埃尔, 1999年)。针对那些在主题领域为专家但在辅导方面为新手的个体的教学策略研究发现,他们常常偏离主题,或回到之前谈话中的某个点以补充先前遗漏的细节(格拉斯等人,1999年)。这些偏离和中断就是条理性差的表现。它们可能损害说话者的可信度,给人留下其对该主题掌握不充分的印象(诺埃尔,1999年)。例如,在描述博物馆时,说话者必须展示出信息的逻辑 progression,并包含足够的细节和良好的连贯性。

流畅性。 最后,语音的时长或流畅性是修辞能力的一个关键副语言线索。研究表明,同时具备实践知识与修辞能力的说话者能够更迅速地调用其知识并进行表达,相较于那些不擅长口语表达或对话题缺乏专业知识的说话者而言更为流利(契、格拉泽和里斯,1981年)。尽管在各级说话者的即兴表达中,一定程度的停顿是正常的,但超出“正常”长度的停顿会被视为表达不清的线索(卡尔森、古斯塔夫森和斯特兰格特,2006年),并会破坏会话的连贯性(卡皮奥内和韦罗尼斯,2002年)。短暂(少于200毫秒)和中等长度(200–1000毫秒)的停顿在即兴表达中较为常见且符合预期,而长时间停顿(超过1000毫秒)频繁出现则可能造成干扰。

由| 斯德哥尔摩大学提供 真实下载日期 | 11/ 15/15 1:45 PM

4 实现人机对话 109

生成模型由这些类型的语言线索组成。它为机器人生成专家式言语,适用于那些需要提供建议和信息并说服人们采取特定行动方案的角色。我们提出了以下假设,关于使用生成模型的机器人在人机交互中可能产生的影响。

假设。 参与者会比接受低修辞能力(使用较少专业知识的语言线索)的机器人提出的建议更频繁地遵循高级修辞能力(使用更多专业知识的语言线索)的机器人所提出的建议。

这一预测基于相关研究的发现,这些研究表明,使用修辞手法来传达专业知识会引发听者的服从性(马韦尔和施密特1967)。先前的研究还表明,专业知识的言语线索有助于建立信任,而接受建议者往往倾向于遵循他们所信任的人提出的建议 (斯尼泽克和范斯沃尔,2001年)。人机交互领域的研究也为这一假设提供了依据。例如,提供建议的机器人使用专家语言会影响用户对其控制性的感知(托里2009)。

3 人机对话中生成模型的评估

方法。 为了检验我们的专家式言语生成模型及预测,我们设计了一个实验,其中两个外观相同的机器人向参与者建议在游览虚拟城市时参观哪些地标。这两个机器人在实践知识量、修辞能力或两者上有所不同。

由| 斯德哥尔摩大学提供 真实下载日期 | 11/ 15/15 1:45 PM

110 第二部分:框架与指南

参与者。 四十八名参与者(24名女性和24名男性)来自威斯康星大学麦迪逊

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?