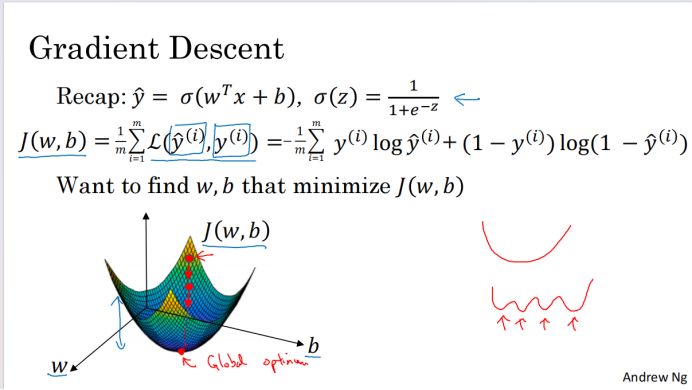

以刚才讲过的logistic回归为例,我们的目标是要找到 使得J(w,b)尽可能小 的w和b

如上图所示,水平的两个轴是w和b【为了方便绘图认为w是一个实数,实际上是更高维的】,J(w,b)是一个曲面。曲面在某个点(w,b)的高度,就是J(w,b)的值

我们要找到w和b使得成本函数J的值为最小值

J是一个凸函数,对于凸函数,在哪里初始化都会到达或接近最低点

而下面这种函数会存在很多局部最优解

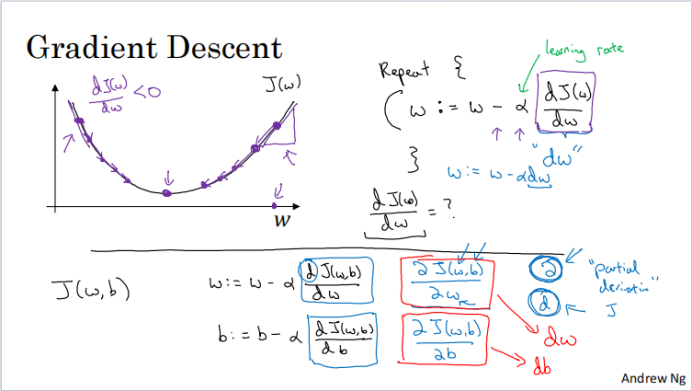

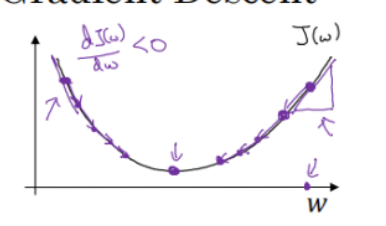

梯度下降法:

从初始点开始,朝着最陡的下坡方向走一步,这是一次迭代;随着迭代,很有希望收敛到或接近局部最优解

上图是忽略b,用J与w的关系曲线来演示梯度下降法,这样图象是二维的,便于理解

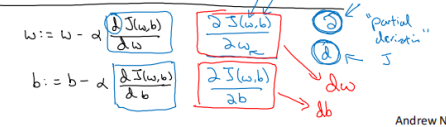

“:=”表示更新,“repeat”就是重复更新w的值

α是学习率,可以控制每一次迭代的步长。

是导数

无论初始点在左边还是右边,最终都会收敛到中间的最低点

同理,对于有两个参数的J(w,b),迭代过程为:

为偏导数符号,因为J(w,b)有两个变量。不过在编写代码时都会写为dw和db

37万+

37万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?