状态机定义

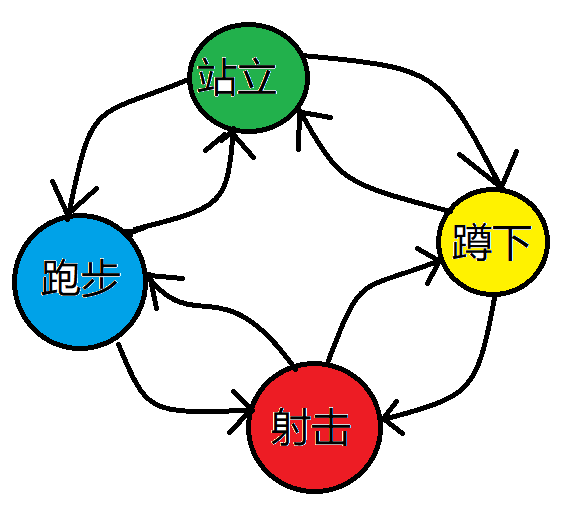

状态机顾名思义跟状态有关系,但到底有什么关系呢。在实际解决的时候,通常把状态想成节点,状态的转换想成有向边的有向图,我们来举个例子。

相信大家都玩过类似枪战的游戏(没玩过的也听说过吧), 他的每一个人物基本都有几个状态:站立,蹲下,跑步和射击。这就可以构成一个简单的状态机图了。

状态机模型

我们拿例题来分析一下。

例题

阿福是一名经验丰富的大盗。趁着月黑风高,阿福打算今晚洗劫一条街上的店铺。

这条街上一共有 N家店铺,每家店中都有一些现金。

阿福事先调查得知,只有当他同时洗劫了两家相邻的店铺时,街上的报警系统才会启动,然后警察就会蜂拥而至。

作为一向谨慎作案的大盗,阿福不愿意冒着被警察追捕的风险行窃。

他想知道,在不惊动警察的情况下,他今晚最多可以得到多少现金?

输入格式

输入的第一行是一个整数 T,表示一共有 T组数据。

接下来的每组数据,第一行是一个整数 N,表示一共有 N家店铺。

第二行是 N个被空格分开的正整数,表示每一家店铺中的现金数量。

每家店铺中的现金数量均不超过1000。

输出格式

对于每组数据,输出一行。

该行包含一个整数,表示阿福在不惊动警察的情况下可以得到的现金数量。

数据范围

1≤T≤50,

1≤N≤

输入样例:

2

3

1 8 2

4

10 7 6 14输出样例:

8

24样例解释

对于第一组样例,阿福选择第2家店铺行窃,获得的现金数量为8。

对于第二组样例,阿福选择第1和4家店铺行窃,获得的现金数量为10+14=24。

这道题的大意就是,有t组数据,每个有n个超市,告诉你每一家的价钱,不能盗窃相邻的超市。

计算大盗能获得的最大利益。

解题思路

这道题有两种解法,第一种是普通的线性dp,第二种是状态机dp。

第一种

用f[i]表示前i家商店阿福可以获得的最大价值。

对于第i次选择,只能选偷或者不偷,偷就是f[i - 2] + w[i], 不偷就是f[i - 1]。

状态转移方程就是:

f[i] = max(f[i - 2] + w[i], f[i - 1]);完整ac代码如下:

#include <bits/stdc++.h>

using namespace std;

const int N = 1e5 + 10, INF = 1e9;

int t, n;

int w[N], f[N];

int main() {

scanf("%d", &t);

while(t--) {

scanf("%d", &n);

for(int i = 1; i <= n; i++) scanf("%d", &w[i]);

memset(f, -INF, sizeof f);

f[0] = 0;

for(int i = 1; i <= n; i++) f[i] = max(f[i - 2] + w[i], f[i - 1]);

printf("%d\n", f[n]);

}

return 0;

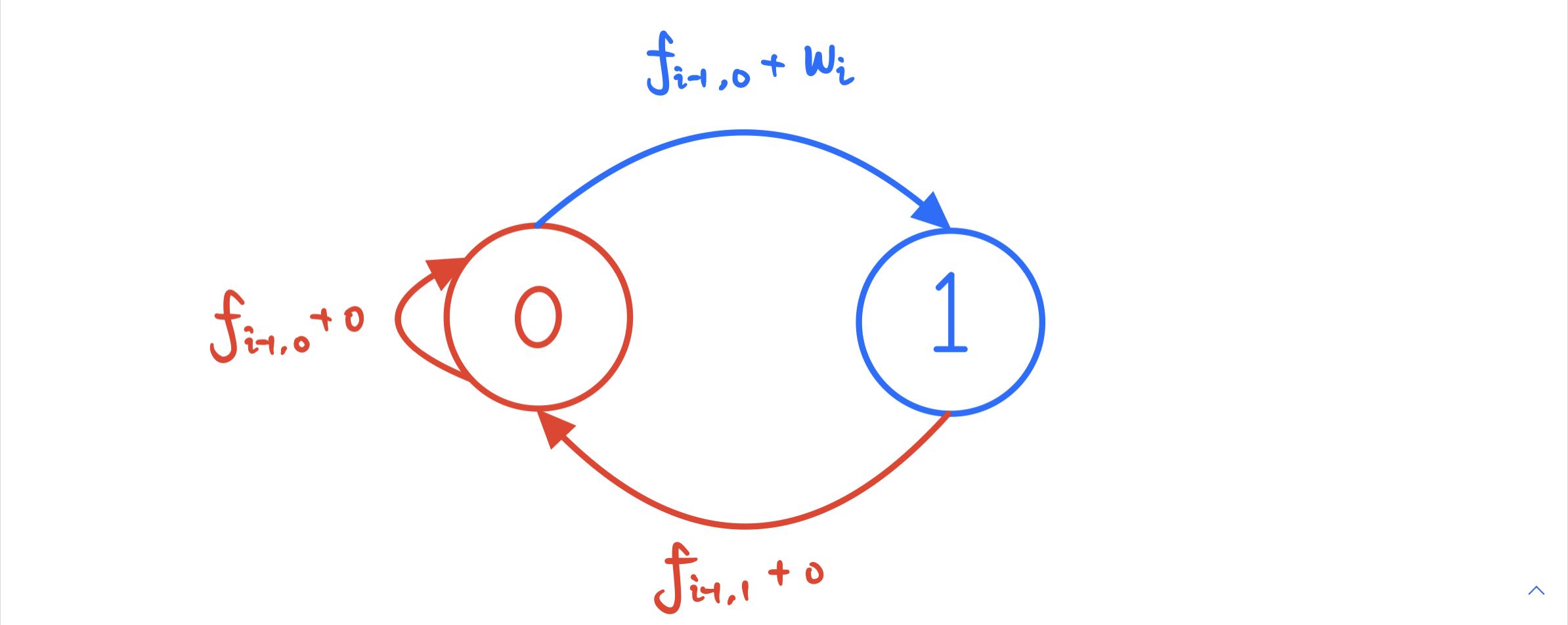

}第二种就是今天讲到的状态机了,对于第i个超市,可以选择偷或者不偷,我们用1表示偷,0表示不偷(都是当前的超市)。

状态转移方程就是:

f[i][0] = max(f[i - 1][0], f[i - 1][1]);

f[i][1] = f[i - 1][0] + w[i];ac代码如下:

#include <bits/stdc++.h>

using namespace std;

#define read(a) scanf("%d", &a);

const int N = 1e5 + 10, INF = 1e9;

int t, n;

int w[N], f[N][2];

int main() {

read(t);

while(t--) {

read(n);

for(int i = 1; i <= n; i++) read(w[i]);

f[0][0] = 0, f[0][1] = -INF;

for(int i = 1; i <= n; i++) {

f[i][0] = max(f[i - 1][0], f[i - 1][1]);

f[i][1] = f[i - 1][0] + w[i];

}

printf("%d\n", max(f[n][1], f[n][0]));

}

return 0;

}

文章介绍了如何使用状态机模型解决一道动态规划问题,即大盗阿福在不触发报警的情况下洗劫店铺以获取最大现金。给出了两种解题方法,一种是普通的线性动态规划,另一种是状态机动态规划,并提供了相应的AC代码示例。

文章介绍了如何使用状态机模型解决一道动态规划问题,即大盗阿福在不触发报警的情况下洗劫店铺以获取最大现金。给出了两种解题方法,一种是普通的线性动态规划,另一种是状态机动态规划,并提供了相应的AC代码示例。

923

923

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?