一.背景

LangChain Agent 作为大语言模型(LLM)驱动的智能代理,能够自主规划任务、调用工具、执行逻辑推理并生成结果,是实现 AI 自动化处理复杂任务的核心载体。但在实际落地过程中,人工介入(Human-in-the-Loop) 并非可有可无的附加环节,而是 LangChain Agent 从 “实验室演示” 走向 “产业规模化应用” 的必要支撑。其诞生与普及,根植于 LLM 技术的固有局限、产业场景的复杂需求,以及人机协同智能的范式演进。以下从技术背景、产业需求背景和工具生态背景三个维度,梳理 LangChain Agent 人工介入的核心逻辑。

1.技术背景:LangChain Agent 的能力边界与固有缺陷

LangChain Agent 的核心逻辑是 “LLM 作为大脑 + 工具调用作为手脚”,依托 Prompt 工程和工具链(如搜索引擎、数据库、API)完成任务。但当前 LLM 技术的局限性,决定了 Agent 无法完全脱离人工介入:

1. LLM 的 “认知缺陷” 导致 Agent 决策失误

LLM 本质是基于统计规律的 token 序列生成模型,缺乏真正的逻辑推理能力和世界模型,这使得 LangChain Agent 在执行任务时容易出现以下问题:

- 幻觉与事实错误:Agent 在调用工具或生成结论时,可能编造不存在的工具结果、错误的事实数据(如引用不存在的文献、计算错误的数值),尤其在处理专业领域任务时,幻觉问题会导致结果完全失效。

- 逻辑链断裂:对于多步骤任务(如 “分析某公司财报→对比行业数据→生成投资建议”),Agent 可能在任务规划阶段遗漏关键步骤,或在执行过程中偏离初始目标,导致任务失败。

- 工具调用失当:Agent 无法精准判断 “何时需要调用工具”“调用哪款工具”“如何解析工具返回结果”—— 例如,明明需要调用数据库查询最新销售数据,却错误调用了静态文档检索工具;或工具返回异常结果时,无法识别并调整策略。

这些 “认知缺陷” 是当前 LLM 技术的固有瓶颈,仅靠模型迭代或 Prompt 优化难以彻底解决,必须依赖人工介入进行纠错和引导。

2. Agent 工具链的局限性放大执行风险

LangChain Agent 的能力延伸高度依赖工具链,但工具链本身存在诸多限制:

- 工具覆盖范围有限:并非所有业务场景都有现成的工具可供调用(如企业内部的私有系统、定制化的数据分析工具),Agent 面对未覆盖的工具时会陷入 “无计可施” 的状态。

- 工具调用的权限与安全问题:Agent 调用涉及企业核心数据的工具(如客户数据库、财务系统 API)时,若缺乏人工监管,可能出现越权访问、数据泄露或误操作(如误删数据库记录)。

- 工具返回结果的歧义性:工具返回的原始数据(如 JSON 格式的接口数据、非结构化的网页内容)可能存在歧义,Agent 无法准确解析时,会生成错误的结论。

此时,人工介入成为弥补工具链短板、控制执行风险的关键手段。

3. 无监督的 Agent 行为缺乏可控性

LangChain Agent 具备一定的自主决策能力,但这种 “自主性” 在缺乏约束时会带来不可控性:

- 任务执行的不可预测性:Agent 可能选择非最优的路径执行任务(如为了获取一个简单数据,反复调用多个工具),导致效率低下;甚至在极端情况下,执行与任务目标相悖的操作。

- 无法处理突发异常:当遇到网络故障、工具服务中断、输入数据格式错误等突发情况时,Agent 缺乏自主排障能力,会直接终止任务或陷入死循环。

人工介入能够为 Agent 提供 “异常处理机制” 和 “行为约束框架”,确保任务执行的可控性。

2.产业需求背景:落地场景对 Agent 可靠性与合规性的硬性要求

LangChain Agent 的产业落地场景(如金融分析、企业办公、客户服务、工业运维),对 AI 系统的可靠性、合规性、专业性提出了远高于实验室场景的要求,这直接驱动了人工介入机制的需求:

1. 企业级任务对结果可靠性的极致追求

企业使用 LangChain Agent 处理的任务往往涉及核心业务(如 “生成季度销售报告”“制定客户跟进策略”“分析供应链风险”),这些任务的结果直接影响决策制定。若仅依赖 Agent 自主执行,一旦出现错误,可能导致企业决策失误、经济损失。因此,企业的核心需求是:

- 关键节点的人工审核:在 Agent 生成最终结果前,由人工审核其任务执行过程和结论的准确性;

- 任务中断时的人工接管:当 Agent 无法解决问题时,人工能够介入并继续完成任务;

- 结果的人工修正:对 Agent 生成的初步结果进行人工优化,提升专业性和准确性。

例如,金融行业使用 Agent 分析上市公司财报时,必须由金融分析师审核 Agent 生成的分析报告,修正其中的财务数据错误或逻辑漏洞,才能提交给投资决策团队。

2. 合规监管对人工介入的强制性要求

在金融、医疗、法律、政务等受监管的行业,AI 系统的输出必须满足合规要求(如数据隐私保护、内容真实性、决策可追溯):

- 金融行业:AI 生成的投资建议、风险评估报告必须有人类分析师的签字确认,符合金融监管机构的要求;

- 医疗行业:AI 辅助诊断的结果必须由医生审核,才能作为临床决策的依据,避免医疗事故;

- 法律行业:AI 生成的合同、法律意见书必须由律师审核,确保符合法律法规和行业规范;

- 数据隐私领域:Agent 处理用户敏感数据(如身份证号、银行卡信息)时,人工介入能够监督其数据使用行为,防止违规泄露。

这些合规要求使得人工介入不再是 “可选项”,而是 LangChain Agent 进入受监管行业的 “准入条件”。

3. 垂直领域的专业知识壁垒需要人工突破

LangChain Agent 虽然能够通过工具调用获取领域数据,但缺乏垂直领域的隐性知识和实践经验:

- 工业运维场景:Agent 能够调用传感器数据识别设备异常,但无法像资深工程师一样,根据异常数据结合现场经验判断故障根源(如设备振动异常可能是轴承磨损,也可能是安装偏差,需人工结合实际情况分析);

- 客户服务场景:Agent 能够处理标准化的客户咨询,但面对情绪激动的客户、复杂的投诉场景时,缺乏人工客服的共情能力和问题协商技巧;

- 科研场景:Agent 能够检索文献、整理实验数据,但无法像科研人员一样,基于数据提出创新性的研究假设。

人工介入能够将领域专家的隐性知识和实践经验注入 Agent 的执行流程,突破专业知识壁垒,让 Agent 真正适配垂直领域的需求。

4. 成本与效率的平衡需求

企业在落地 LangChain Agent 时,需要平衡 “AI 自动化带来的效率提升” 和 “AI 错误带来的成本损失”:

- 若完全依赖人工处理任务,效率低下,无法应对大规模的业务需求;

- 若完全依赖 Agent 自动化处理,错误率较高,可能导致成本损失。

人工介入机制能够实现 “AI 处理简单任务 + 人工处理复杂任务 + 人工审核关键任务” 的混合模式,在保证效率的同时,将错误率控制在可接受范围内。例如,企业使用 Agent 处理日常的客户咨询,对于简单问题(如 “产品价格是多少”),Agent 直接回答;对于复杂问题(如 “定制化产品的解决方案”),自动转人工处理;对于涉及退款、投诉的问题,Agent 生成初步处理建议后,由人工审核并执行。

3.工具生态背景:LangChain 生态对人机协同的支撑与演进

LangChain 作为一站式的 LLM 应用开发框架,其生态的发展为 Agent 人工介入提供了技术支撑,同时也推动了人工介入机制的不断优化:

1. LangChain Agent 架构的可扩展性为人工介入提供了入口

LangChain Agent 的核心组件(如 AgentExecutor、Tool、CallbackHandler、Memory)采用模块化设计,具备良好的可扩展性:

- 回调机制(Callback):LangChain 的

BaseCallbackHandler允许开发者在 Agent 执行的关键节点(如任务开始、工具调用前、结果生成后)插入自定义逻辑,这成为人工介入的核心入口 —— 例如,在 Agent 生成结果后,触发回调函数将结果发送给人工审核系统,待审核通过后再输出。 - 中断与续跑机制:LangChain Agent 支持在任务执行过程中中断(如遇到指定条件时停止执行),并将任务状态保存到

Memory中,人工处理后可恢复执行,实现 “人工介入 - 任务续跑” 的闭环。 - 工具的人工交互扩展:开发者可以基于 LangChain 的

Tool接口,开发 “人工介入工具”—— 当 Agent 调用该工具时,自动将任务转发给人工审核者,获取人工反馈后再继续执行。

这种模块化的架构,让人工介入机制能够无缝集成到 LangChain Agent 的执行流程中,无需重构核心逻辑。

2. LangChain 生态的社区实践推动人工介入机制的标准化

随着 LangChain 社区的发展,越来越多的开发者和企业将人工介入机制应用到 Agent 场景中,形成了一系列标准化的实践方案:

- 触发条件的标准化:社区总结了人工介入的常见触发条件(如 Agent 置信度低于阈值、涉及敏感内容、任务复杂度超过阈值、工具调用失败),并提供了可复用的判断逻辑。

- 人工交互流程的标准化:形成了 “Agent 触发人工介入→提交任务到审核队列→人工处理并反馈结果→Agent 续跑任务” 的标准化流程,且与主流的消息队列、工单系统实现了集成。

- 评估与优化的标准化:社区开发了针对人工介入效果的评估指标(如人工介入率、审核通过率、任务完成率),帮助企业优化人工介入的策略(如调整触发阈值、优化 Agent 工具链)。

这些标准化的实践,降低了企业实现 LangChain Agent 人工介入的技术门槛,推动了该机制的普及。

3. 多模态与多智能体生态的发展提升人工介入的效率

LangChain 生态正朝着多模态(文本、图像、语音、视频)和多智能体(多个 Agent 协同工作)方向发展,这也为人工介入带来了效率提升:

- 多模态人工介入:人工审核者可以通过可视化界面,同时查看 Agent 生成的文本结果、调用的图像数据、语音记录等,更全面地审核任务执行情况;

- 多智能体的分层介入:企业可以部署 “初级 Agent 处理简单任务 + 高级 Agent 处理复杂任务 + 人工处理疑难任务” 的分层架构,人工仅需介入极少数的疑难任务,大幅提升效率。

例如,在工业运维场景中,初级 Agent 处理传感器数据的常规分析,高级 Agent 处理复杂的故障诊断,当高级 Agent 无法解决时,再将故障数据和初步分析结果发送给工程师,工程师通过多模态界面查看数据后,给出处理建议。

4.总结:人工介入是 LangChain Agent 落地的核心桥梁

LangChain Agent 人工介入机制的出现,并非对 AI 自动化的否定,而是对人机协同智能的深度实践。其背景涵盖了三个核心层面:

- 技术层面:LLM 的认知缺陷、Agent 工具链的局限,决定了 Agent 无法完全自主完成复杂任务,人工介入是弥补技术短板的必要手段;

- 产业层面:企业对任务可靠性、合规性、专业性的需求,以及成本与效率的平衡,驱动了人工介入机制的落地;

- 工具层面:LangChain 的模块化架构和社区生态,为人工介入提供了技术支撑和标准化方案。

从本质上看,人工介入是连接 LangChain Agent 技术能力与产业落地需求的核心桥梁 —— 它让 Agent 从 “具备理论能力的智能模型” 转变为 “能够解决实际业务问题的实用系统”,也让人类从 “重复劳动的执行者” 转变为 “AI 系统的监管者、纠错者和赋能者”。这种人机协同的范式,既是当前 AI 技术阶段的最优解,也是未来通用人工智能(AGI)发展的重要方向。

二.具体实现

1.引入依赖

from langchain.agents import create_agent

import sys

import io

import os

from langchain.tools import tool

from langchain.agents.middleware import HumanInTheLoopMiddleware

from langgraph.checkpoint.memory import InMemorySaver

from langgraph.types import Command

2.配置大模型参数

# 设置UTF-8编码,解决中文乱码问题

if sys.stdout.encoding != 'utf-8':

sys.stdout.reconfigure(encoding='utf-8')

if sys.stderr.encoding != 'utf-8':

sys.stderr.reconfigure(encoding='utf-8')

os.environ['PYTHONIOENCODING'] = 'utf-8'

os.environ["OPENAI_API_BASE"] = "xxx"

os.environ["OPENAI_API_KEY"] = "xxx"

3.定义工具函数

@tool

def get_weather(location: str) -> str:

"""Get weather information for a location."""

return f"Weather in {location}: Sunny, 72°F"

4.定义agent,配置人工介入开关

agent = create_agent(

model="gpt-4.1-2025-04-14",

tools=[get_weather],

middleware=[HumanInTheLoopMiddleware(

interrupt_on={

# Require approval for sensitive operations

"get_weather": True

})

],

# Persist the state across interrupts

checkpointer=InMemorySaver()

)

5.发起agent请求

config = {"configurable": {"thread_id": "121"}}

# Run the agent

result = agent.invoke(

{"messages": [{"role": "user", "content": "上海天气如何?"}]},

config=config

)

print(result)

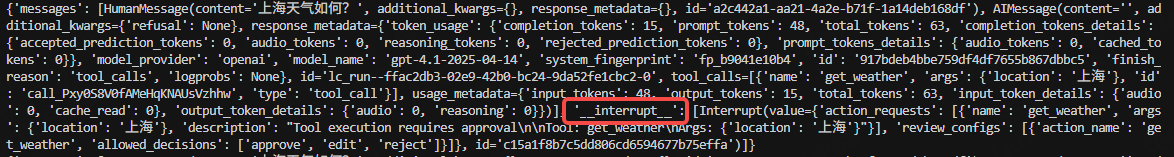

结果显示中断,需要人工介入:

6.人工介入,并修改工具参数

result2 = agent.invoke(

Command(resume={"decisions": [{"type": "edit", "edited_action": {

# Tool name to call. Will usually be the same as the original action.

"name": "get_weather",

# Arguments to pass to the tool.

"args": {"location": "广州"},}

}]}),

config=config # Same thread ID to resume the paused conversation

)

print(result2)

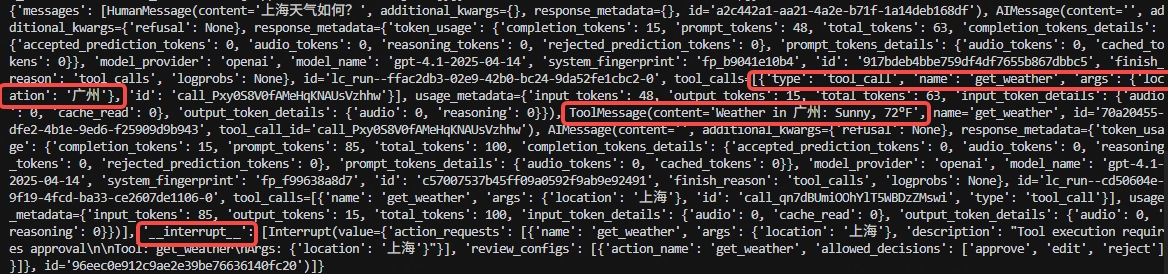

结果显示工具按照修改后参数执行了,但agent认为结果不符合,继续请求工具,并再次产生中断

7.人工介入,直接同意

result3 = agent.invoke(

Command(resume={"decisions": [{"type": "approve"}]}),

config=config

)

print(result3)

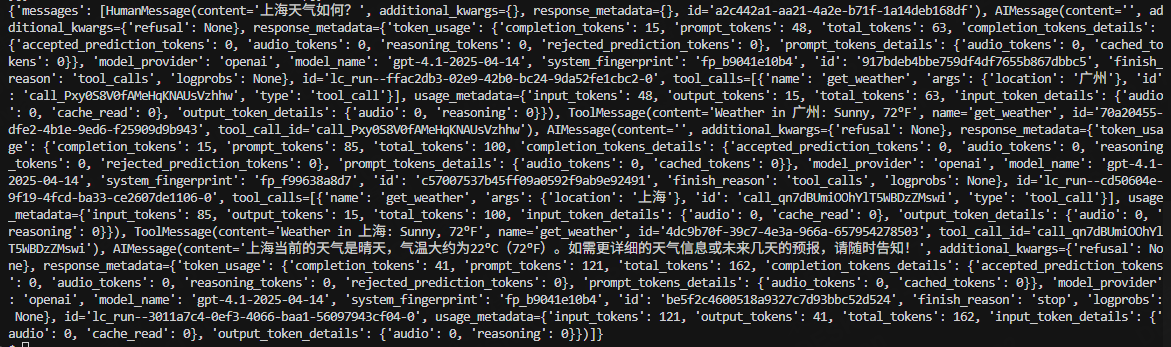

结果通过了

298

298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?