引言

2017年,Google提出了 Transformer 架构,其自注意力机制使模型能够高效捕捉长距离依赖关系,为后续大模型的发展奠定了基础。从Google的 BERT 预训练模型再到 OpenAI 的GPT系列,大模型的参数规模不断扩大,性能也不断提升。到2022年底,ChatGPT的横空出世更是掀起了生成式AI的技术浪潮。随着大模型应用的不断深入发展,也暴露出了诸多问题,如静态训练数据滞后与私有数据无法利用、模型的幻觉、无法执行多步骤复杂任务等。LangChain的出现有效解决了大模型在实际应用中的诸多问题,为大模型的发展提供了新的可能。

一. 什么是LangChain

LangChain是一个开放的、可组合的框架,它为每个模型、工具和数据库提供了标准接口,帮助开发者将大语言模型与外部资源连接起来,可以快速构建能随生态系统发展而自适应的大语言模型应用程序。

二. 为什么选择LangChain做为大模型应用框架

选择LangChain做为大模型应用框架主要有以下几个方面:认可度、易用性、可扩展性、可观测性。

- 认可度

截止到2025年10月,在GitHub上LangChain已获得了117k⭐,是目前star数最多的AI应用开发框架,并且LangChain拥有活跃的开发者社区和丰富的文档资源,能够快速帮助开发者解决问题和获取帮助。

- 易用性

LangChain屏蔽了不同大语言模型调用接口、输入和输出格式之间的差异,开发者无需深入了解底层模型细节,创建模型后,就可以直接使用。 - 可扩展性

LangChain允许开发者通过自定义工具和组件来扩展框架的功能,以适应特定的应用需求。 - 可观测性

与其它 AI 应用框架相比,LangChain官方推出了LangSmith AI 应用监控与分析平台,可以监控大模型应用各组件的交互细节并支持告警功能帮助开发者快速定位异常节点,还可以对Prompt响应延迟、token消耗等关键指标进行量化分析,提供交互式回溯功能,可以查看任意节点的输入输出和中间状态。

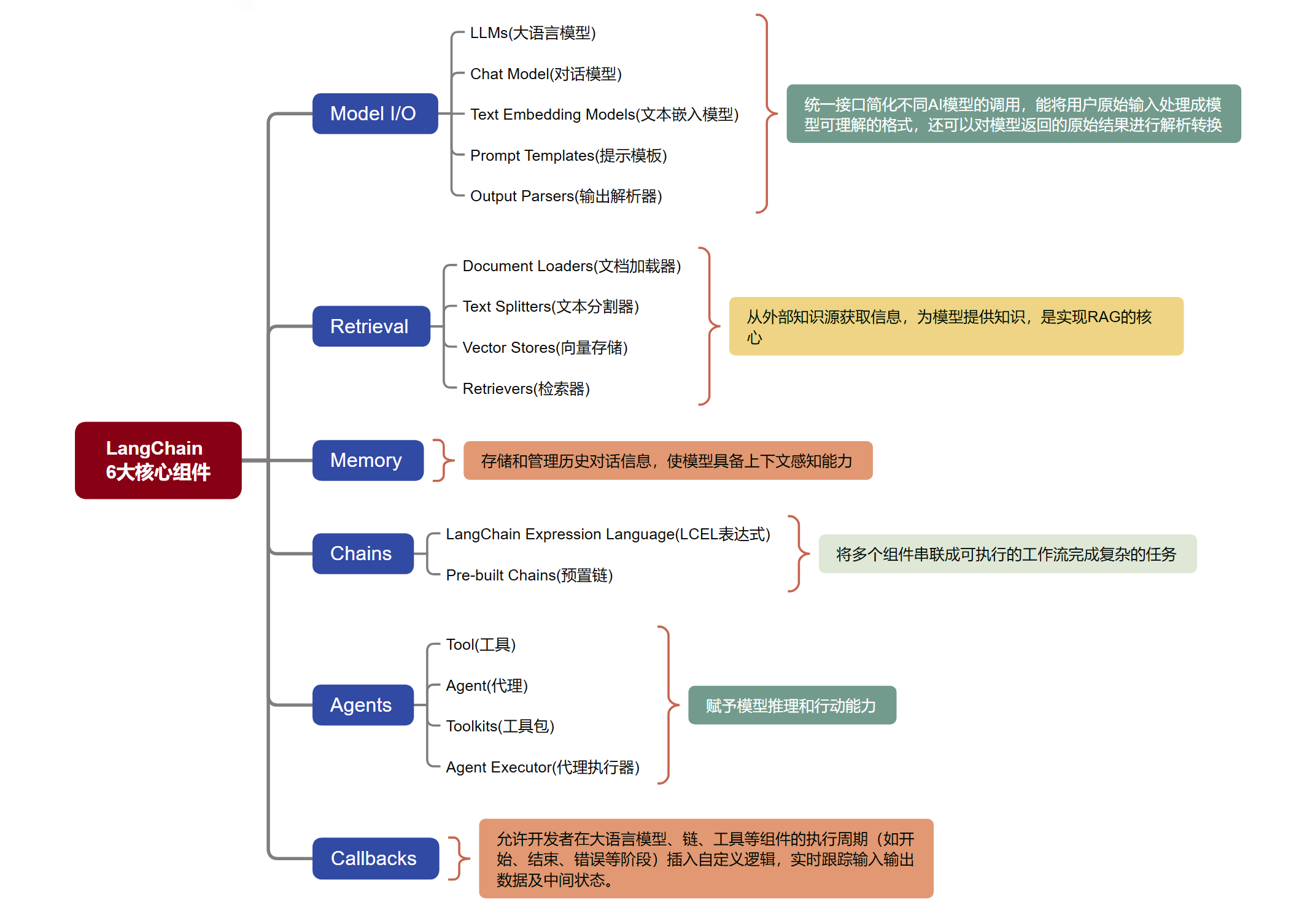

三. LangChain有哪些核心组件

LangChain主要提供了6大核心组件帮助开发者更好地使用大语言模型。包括Model I/O、Retrieval、Memory、Chains、Agents、Callbacks。这些组件相互配合,形成了灵活且模块化的框架以及成熟的应用链,为用户提供了一个快速搭建和部署大语言模型智能应用平台。

3.1 Model I/O

这是与大语言模型交互的核心,负责处理输入和输出,提供统一的接口规范,屏蔽不同大语言模型的差异。

- LLMs(大语言模型)

提供统一的接口,调用纯文本补全模型,输入是字符串,输出也是字符串。 - Chat Model(聊天模型)

提供统一的接口,调用基于消息的聊天模型,输入是一个由SystemMessage, HumanMessage, AIMessage等组成的列表,输出是一个 AIMessage。 - Text Embedding Models(文本嵌入模型)

提供统一的接口,对接不同文本嵌入模型,将文本数据转化为向量表示。 - Prompt Templates(提示模板)

动态生成提示词,简化与大语言模型的交互过程,通过清晰易懂的提示文本,帮助大模型更准确地把握用户意图。 - Output Parsers(输出解析器)

将大语言模型输出的文本转换为结构化数据。

3.2 Retrieval

用于从外部知识源(如文档、数据库)中获取与问题相关的信息,是实现 RAG 的核心。

- Document Loaders(文档加载器)

将不同数据源转换为 LangChain Document 对象的核心模块,支持 CSV、PDF、HTML、JSON 等多种格式。 - Text Splitters(文本分割器)

将长文档切分成更小的块(Chunks),以适应模型的上下文窗口限制。 - Vector Stores(向量存储)

将文本、图像等非结构化数据转换为向量并存储,并提供相似性搜索功能。 - Retrievers(检索器)

从不同的数据源(如文档库、数据库、向量库等)中,快速、精准地筛选出与用户查询高度相关的信息片段(如文本段落、图片特征、音频片段等),为后续任务(如问答、生成、推荐)提供高质量地上下文支撑。

3.3 Memory

存储和管理历史对话信息,使模型具备上下文感知能力。

3.4 Chains

将多个组件(或多个模型调用)组合成一个序列,以完成复杂的任务。

- LCEL(LangChain Expression Language)

LangChain v0.3版本推荐的全新、声明式的链构建方式。使用 | 操作符来连接组件,使代码非常简洁和易读。 - Pre-built Chains(预置链)

封装了常见功能的现成链组件,只需传入必要参数即可快速实现问答、摘要、翻译等任务,让开发者无需从零构建复杂的大语言模型应用程序。

3.5 Agents

让大模型根据工具和用户输入来决定执行什么动作(Action),是实现自主任务执行的核心。

- Agent(智能体)

通常由一个大模型和一个提示词驱动,来决定下一步是使用工具还是直接返回答案。 - Tool(工具)

代理可以调用的函数,可以是搜索引擎、计算器、数据库查询、代码执行器或者任何自定义的API。 - Toolkits(工具包)

一组相关的工具集合,用于完成一个特定领域的任务(如操作 SQL 数据库、与文件系统交互)。 - Agent Executor(代理执行器)

驱动智能体(Agent)动态执行多步骤任务(如工具调用、循环决策)的自动化引擎,确保复杂流程稳定运行。

3.6 Callbacks

允许开发者在大语言模型、链、工具等组件的执行周期(如开始、结束、错误等阶段)插入自定义逻辑,实时跟踪输入输出数据及中间状态。

四. LangChain有哪些使用场景

4.1 智能问答与知识库

- 关键技术:RAG

- 原理:对多种格式的数据(PDF、Word、Markdown、数据库等)进行处理,使用嵌入模型将数据向量化并保存到向量数据库。将用户的查询内容也进行向量化并与向量数据库中存储的数据进行比对,找出最匹配的数据。将用户查询的内容和匹配的数据嵌入到提示词模板中输入给大模型,生成所需的输出。

- 具体应用:企业内部知识库、产品手册问答、法律/医疗文档分析。

4.2 智能代理与自动化

- 关键技术:Agents、Tools

- 原理:通过调用各种工具来执行复杂的、多步骤的任务。

- 具体应用:自动化报告生成、个人助理、代码助手等。

4.3 对话式应用

- 关键技术:Memory,Conversation Chains

- 原理:结合Memory组件存储和管理历史对话信息,理解上下文,实现连贯的交流。

- 具体应用:聊天机器人。

五. 总结

LangChain通过提供完整的工具链和最佳实践,极大地简化了LLM的应用开发流程。它的模块化设计和丰富的功能特性,使得开发者能够快速构建出功能强大的 AI 应用。随着技术的不断发展,LangChain必将在 AI 应用开发领域发挥越来越重要的作用,其未来可能的发展方向包括更强大的 Agent 系统、更完善的工具生态、更灵活的框架扩展性以及更多的企业级特性。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?