以下是针对 vLLM、SGLang、KTransformers 和 TensorRT-LLM 四大主流 LLM 推理框架的深度对比分析,结合核心技术、性能表现、适用场景及行业应用进行系统性总结:

🧠 一、核心技术架构对比

| 框架 | 核心技术 | 创新点 |

|---|---|---|

| vLLM | PagedAttention:KV缓存分页管理(固定内存块) | 内存碎片率<5%,支持动态批处理与异步调度,优化长序列(>4K tokens) |

| SGLang | RadixAttention:基数树结构组织KV缓存 | 子树复用加速结构化输出(如JSON),动态批处理提升复杂逻辑任务效率 |

| KTransformers | CPU极致优化:轻量级设计,低功耗调度 | 零GPU依赖,支持边缘设备部署,资源占用极低 |

| TensorRT-LLM | NVIDIA深度优化:内核融合(Kernel Fusion)+ 量化(INT4/FP8) | 预编译引擎实现纳秒级延迟,充分发挥GPU算力 |

⚡ 二、性能关键指标实测(基于Llama-3-8B/A100-80G)

| 指标 | vLLM | SGLang | KTransformers | TensorRT-LLM |

|---|---|---|---|---|

| 吞吐量(Tokens/s) | 182 (短序列) | 210 (短序列) ↑15% | 35 (CPU) | 250 (短序列) ↑37% |

| 首Token延迟(TTFT) | 48ms | 39ms ↓19% | 120ms | 32ms ↓33% |

| 内存效率 | 显存占用降70% | 树结构开销+15% | 无显存需求 | 量化模型显存降60% |

| 长序列支持(8K) | ✅ 吞吐量142 req/s | ❌ 仅44 req/s | ❌ 不支持 | ✅ 优化注意力机制 |

注:

- SGLang在短序列和结构化任务(如JSON生成)延迟更低,但长序列吞吐量显著落后vLLM;

- TensorRT-LLM在GPU上综合性能最优,尤其FP8量化下Llama-405B吞吐量达vLLM的2.1倍。

🌐 三、硬件与部署适配性

| 框架 | 硬件支持 | 部署复杂度 | 生态集成 |

|---|---|---|---|

| vLLM | NVIDIA/AMD/Intel GPU | 中等 | ✅ LangChain原生支持,Prometheus监控 |

| SGLang | NVIDIA GPU | 低(纯Python) | ⚠️ 需封装适配LangChain,HTTP/gRPC接口 |

| KTransformers | CPU/嵌入式设备 | 极低 | ❌ 无主流生态集成,需定制开发 |

| TensorRT-LLM | 仅NVIDIA GPU | 高(需预编译) | ✅ Triton推理服务器,企业级SLA保障 |

关键限制:

- TensorRT-LLM 仅支持NVIDIA平台,国产GPU或非CUDA环境无法使用;

- KTransformers适合无GPU环境,但吞吐量仅为GPU框架的1/5。

🏭 四、场景适配性推荐

1. 高并发在线服务(如智能客服)

- 首选:vLLM

- 理由:PagedAttention保障高吞吐(850 qps),优先级调度控制延迟。

- 备选:TensorRT-LLM

- 适用场景:需纳秒级响应的金融交易系统。

2. 复杂逻辑任务(如程序合成/多轮推理)

- 首选:SGLang

- 理由:RadixAttention加速嵌套生成,端到端延迟比vLLM低40%。

- 典型场景:教育类Agent动态调整prompt。

3. 边缘计算与低功耗场景

- 唯一选择:KTransformers

- 理由:零GPU依赖,可在树莓派等设备运行,功耗<10W。

4. 国产化环境部署

- 替代方案:LMDeploy(非本次对比框架,但搜索结果提及)

- 优势:深度适配国产GPU(如昇腾),多模态任务支持。

🔮 五、未来趋势与选型建议

- 协议融合成为趋势

- vLLM与SGLang可通过API组合(如SGLang调用vLLM后端),结合吞吐与结构化生成优势。

- MoE架构的适配挑战

- TensorRT-LLM对MoE模型量化支持最佳,vLLM需优化专家路由调度。

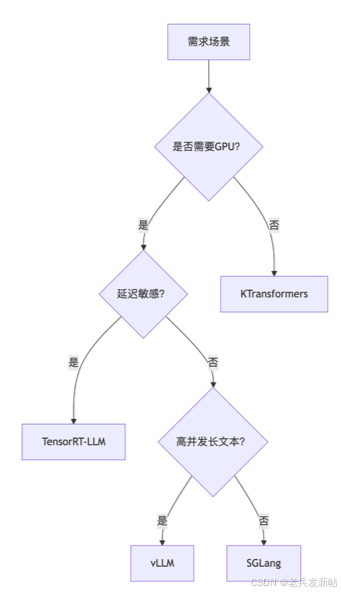

- 选型决策树:

graph TD A[需求场景] --> B{是否需要GPU?} B -->|是| C{延迟敏感?} C -->|是| D[TensorRT-LLM] C -->|否| E{高并发长文本?} E -->|是| F[vLLM] E -->|否| G[SGLang] B -->|否| H[KTransformers]

💡 总结:

- 企业生产环境:优先TensorRT-LLM(NVIDIA生态)或vLLM(多硬件支持);

- 研究/边缘场景:SGLang(动态逻辑)或KTransformers(无GPU部署);

- 持续关注:SGLang的RadixAttention正在扩展长上下文支持,可能颠覆长文本处理格局。

2388

2388

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?