随着我对 Agent 的学习不断深入,新的概念、工具和技术层出不穷。哪些是构建 Agent 必须掌握的,哪些只需了解?这成了我亟需厘清的问题。

我经常把 Agent 比作人,那自然也可以把 Agent 的构建类比为人类从出生到胜任工作的全过程。我发现用这样的类比去思考,就很容易理解这些眼花缭乱的技术和概念,到底是在解决什么问题,以及我需要聚焦在哪个区域。

01

🍼启蒙阶段:理解语言

![]()

学语言 → 语言理解

就像人从呱呱落地到呀呀学语,大模型也是从开始学习人类语言开始的,这个阶段通过预训练,让模型学会‘读、写、说’,能看懂文本、能续写合理内容、具备基础推理雏形。

这一阶段主要是基于机器学习与概率语言建模理论,采用 Transformer/self-attention 结构,通过无标注语料的自监督训练,让模型从海量文本中自我学习语言规律,实现语言能力的涌现。

可以通俗地理解为:大模型在玩一场“概率版的接龙游戏”——每看到一个词,就用算法判断下一个词最可能是什么,然后不断重复、持续优化。

由于这一阶段需要海量的数据、计算资源和算法工程能力,通常由大型模型厂商(如 OpenAI、DeepSeek等)完成。

主导方:大模型厂商(OpenAI、DeepSeek 等)

输入:超大规模语料(多语种文本/代码/网页/书籍/论坛等)

输出:通用基座模型

关键词:预训练(Pre-training)、Transformer/self-attention、Tokenizer、Embedding、旋转位置编码(RoPE)、稀疏专家(MoE)、Scaling Laws……

02

📚通识教育阶段 :学会常识

![]()

学常识 → 听得懂话

就像人进入小学到高中,开始系统地学习语文、数学、历史与科学,大模型在这个阶段也进入了“通识教育”。

它不再只是会说话,而是学习如何遵循指令、理解任务、掌握常识,逐步具备理解问题与回答问题的能力。

这一阶段主要基于监督学习与指令微调(Instruction Tuning)理论,采用有标注或合成数据进行训练,使模型学会“听懂人话”,能够按照指令完成通用任务。常见方法包括 SFT(Supervised Fine-Tuning)、RFT(Reinforced Fine-Tuning),以及针对特定任务的多轮指令微调。

可以通俗地理解为:这是模型的“通识学校教育阶段”,老师(标注数据)开始教它怎么答题、怎么按要求写作文,让它从“会说”变成“会用”。

主导方:大模型厂商

输入:大量高质量的指令问答数据(可人工标注或模型合成)

输出:具备通用理解与任务执行能力的指令遵循模型

关键词:指令微调(SFT/RFT)、数据合成(Self-Instruct)、Alignment tuning、偏好数据(Preference data)、多任务学习、few-shot/zero-shot 学习……

03

🎓专业教育阶段:学会判断

![]()

学判断 → 对齐推理

就像人从大学到博士阶段,开始接受专业训练、学会做研究、理解规则与伦理,大模型在这一阶段也进入了“专业教育”。

它不再只是照本宣科地回答,而是学习如何理解人类意图、掌握价值判断、在复杂任务中作出平衡决策。

这一阶段主要基于强化学习(RL:Reinforcement Learning)与人类偏好建模理论,采用 RLHF(Reinforcement Learning from Human Feedback)或 RLAIF(AI Feedback)等方法,通过人类或模型的反馈让模型学会“什么是好答案”。

关键过程包括:构建奖励模型(Reward Model)、用算法(如 PPO、DPO、GRPO、DAPO、VAPO等)优化模型参数,实现“从会答题到答得好”的能力跃迁,这是让 AI 从模仿人类走向自主学习的重要一步。

可以通俗地理解为:这是大模型的“研究生阶段”,它开始接受导师指导(人类反馈),学会自主反思与总结自己的回答是不是符合规范、有没有冒犯、有无逻辑漏洞;在一次次的反馈与反思中,持续改进中,逐渐自己归纳形成“理解”,“性格”和“判断力”。

主导方:大模型厂商

输入:指令遵循模型 + 人类或 AI 反馈数据(优劣答案对比)

输出:对齐人类价值观、具备推理与自我约束能力的对齐模型(Alignment Model)

关键词:RLHF、RLAIF、Constitutional AI、奖励模型(Reward Model)、偏好优化(PPO / DPO / GRPO)、安全对齐、价值约束、偏差校正、Reward hacking、推理优化……

04

💼胜任培养阶段:学会工作

![]()

学实务 → 场景落地

就像一个人从学校步入社会,开始实习、入职、接受岗位培训,大模型在这一阶段也要经历“胜任培养”。

它不再只是会答题、懂常识,而是要在特定企业、特定场景中完成真实工作——能跑通流程、解决问题、与人或系统协作。

这一阶段主要基于上下文学习理论,通过提示词工程(Prompt Engineering)、上下文工程(Context Engineering)、检索增强生成(RAG,GraphRAG)、知识图谱、工作流编排(Workflow Orchestration)等方法,把模型能力嵌入业务环境。

同时,引入LoRA(轻量微调)对高频任务做定向强化;通过MCP(Model Context Protocol)、A2A(Agent to Agent)等机制,让多个 Agent 能够与工具、系统和彼此协作,形成可观测、可追踪、可评估的智能工作流。

可以通俗地理解为:这是模型“上班”的阶段,它有了工牌(身份与权限),能用工具(系统接口),还能和同事协作(多 Agent 协同);它开始替代或辅助人类在某个岗位上完成具体任务。

训练方:应用团队 / 企业 AI 部门 / SaaS 产品方

输入:企业数据 + 经验总结 + 业务流程 + 工具接口 + 上下文模板

输出:能在特定场景中执行任务的 Agent 系统

关键词:上下文工程、提示词模板、知识增强(RAG / GraphRAG / 知识图谱)、Tool use / API 调用、Memory / State Management、Workflow(LangGraph 等)、MCP、A2A、LoRA、评估与回放(Evaluation & Replay)、可观测性、Agent 模式(ReAct / Planning)、强化式工作流(RL for Orchestration)……

05

🚀持续学习阶段:学会成长

![]()

学改进 → 自我成长

就像一个人在工作中越做越熟,学会总结经验、听取反馈、不断改进,大模型与 Agent 也需要经历“持续学习”的阶段。

它不再只是能完成任务,而是能在反馈中优化、在经验中成长,实现从“能胜任”到“越做越好”的持续进化。

这一阶段主要基于反馈学习与持续优化(Continuous Learning)理论,结合自动评估(Auto-Eval)、经验记忆(Memory / Experience Base)、小步微调(LoRA / Adapter)等方法,形成一个可持续迭代的智能飞轮。

核心逻辑是:通过不断收集真实任务中的反馈数据(用户评分、成功率、返工率、异常日志),让 Agent 自动或半自动地分析错误、优化提示、修正知识、更新模板,必要时进行轻量再训练,从而让系统性能随时间持续提升。

可以通俗地理解为:这是 Agent 的“职场成长阶段”,它开始“复盘工作”,会记录经验(日志)、改进方法(模板)、请教导师(人类反馈),最终形成自己的“工作手册”,越干越熟、越干越快。

主导方:应用团队 / 企业 AI 部门 / SaaS 产品方

输入:运行日志、用户反馈、评估数据、错误案例、补充知识

输出:可持续优化的 Agent 系统

关键词:反馈学习(Feedback Learning)、Auto-Eval、Learning Loop、经验与反馈库(Memory / Experience Base / Error Log)、自反思机制(Self-Reflection)、小步 LoRA / Adapter、强化反馈循环(RL for Evaluation)、Training-Free GRPO、Auto Curriculum / Self-Improvement…

尾声

从“懂语言”到“懂世界”

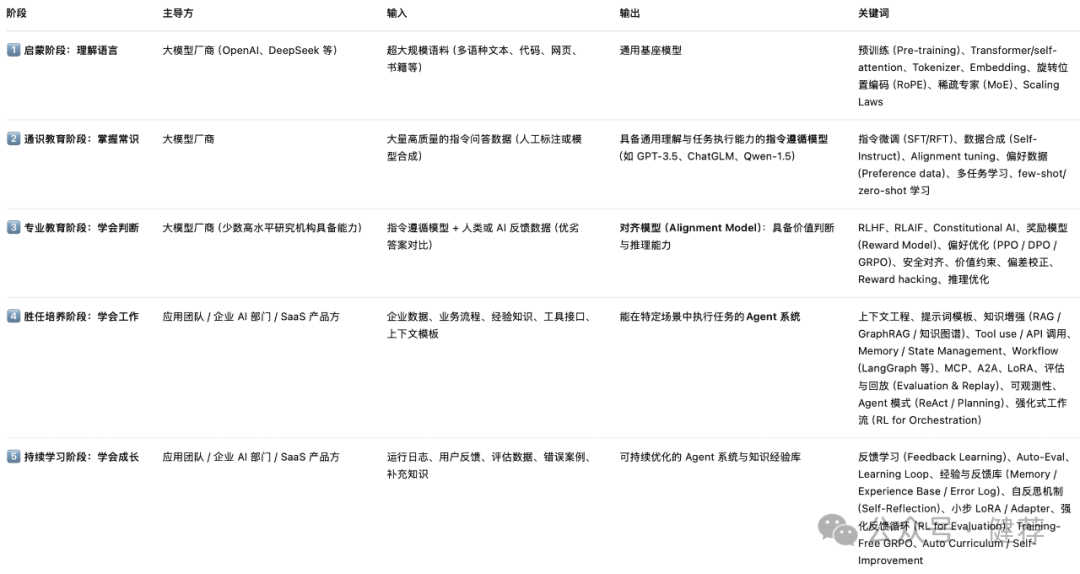

如果我们汇总一下这五个阶段:

就会发现:

![]()

Agent 的成长之路,也就是智能体从“语言模型”进化为“智能体”的过程。

-

在启蒙阶段,它学会了理解语言,掌握了表达的能力;

-

在通识阶段,它积累了知识,学会了遵循人类的指令;

-

在专业教育阶段,它学会了判断与价值取舍;

-

在胜任培养阶段,它学会了在真实世界中工作;

-

在持续学习阶段,它开始具备自我成长与自我优化的能力。

从“能说”到“能干”,再到“能改进”,这就是智能体进化的方向。

从理解语言到理解世界,相信越来越多的 AI 智能体此时正在经历这样的成长之路,来到我们的身边。

理解了这个过程,也为我们在学习中理解一个新的技术和概念,提供了一个映射的思路,帮助我们判断应该聚焦和关注的领域,避免迷失在技术和概念的海洋里。

610

610

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?