向Qwen团队致敬,他们开放了Qwen3-Coder的全部权重模型。这对于开源社区和开发者而言意义非凡。其超长上下文虽然诱人,但实际使用场景可能并不常见。

阿里巴巴旗下的Qwen团队刚刚发布了迄今为止最先进的代码模型Qwen3-Coder。这款模型提供了多种规模版本,其中最大的版本参数高达4800亿,树立了开源代码模型的新标准,尤其在编程生成、浏览器交互以及工具调用等领域表现突出,足以与Claude 4 Sonnet一较高下。

近期开发者社区内对Claude 4 Sonnet模型的抱怨逐渐增多,主要源自于Claude的频繁限流和性能下降,这让不少开发者开始转而寻找新的解决方案。如今Qwen3-Coder携卓越的基准测试成绩以及开源开放的特性,成为了新的关注焦点。

一个重要问题随之而来:在真实的编程场景中,Qwen3-Coder是否足够优秀,足以挑战Claude在实际工作流程中的领先地位呢?

什么是Qwen3-Coder?

Qwen3-Coder是阿里云Qwen团队基于Qwen3系列开发的代码专用模型。

该模型完全开源,专为超长上下文场景的智能化编程设计,借助YaRN技术,其上下文窗口支持长达100万token,实际运行时启用了350亿个活跃参数。

Qwen3-Coder延续了基础版Qwen3模型的优势,除了擅长代码生成外,在数学推理和通用语言理解等任务中也有突出表现。

该模型支持358种编程语言,包括但不限于Python、JavaScript、TypeScript、C++、Java、Go、Rust、PHP、SQL、HTML、CSS和Shell等主流语言。

据Qwen团队工程师林君阳介绍,尽管现在还不敢说Qwen3-Coder完全能与Claude Sonnet 4媲美,但作为智能化编程助手,它的表现已经非常突出,比此前发布的Qwen2.5-Coder强大许多,采用了MoE架构,能力得到质的飞跃。

如需了解更多技术细节,可参考官方白皮书。

根据基准测试结果显示,Qwen3-Coder-480B-A35B-Instruct已经成为迄今为止性能最强的开源智能代码模型。

下面,我们将深入了解它的具体表现。

Qwen3-Coder模型特点

Qwen3-Coder-480B-A35B-Instruct的主要参数如下:

- 类型:因果语言模型(CLM)

- 训练阶段:预训练和后训练(强化学习)

- 总参数量:4800亿(启用参数350亿)

- 模型层数:62层

- 注意力头数(GQA):Q头96个,KV头8个

- 专家网络(Experts)数:160个(激活8个)

- 原生上下文长度:262,144 tokens

默认支持对话模式,无需手动禁用思考标签(think标签),随时可以用于聊天式交互。

预训练阶段

Qwen3-Coder使用7.5万亿token进行预训练,其中70%的数据来自代码相关领域。在强化编程能力的同时,保留了基础的数学与通用推理能力。此外,该模型默认支持256K tokens超长上下文,通过YaRN技术还可扩展到1M tokens。

团队还通过Qwen2.5-Coder清理和重写了部分低质量训练样本,大幅降低了模型“幻觉”(hallucination)的发生概率。

后训练阶段

后训练阶段重点采用了强化学习技术(Code RL),并针对真实世界的编程任务进行优化训练,以提高代码可执行性。

同时引入了长程强化学习(Long-Horizon RL),在SWE-Bench等需要长期规划的任务中表现更加优秀。

团队利用阿里云平台并行运行了20,000个训练环境,这极大地提升了模型在实际场景中的表现。

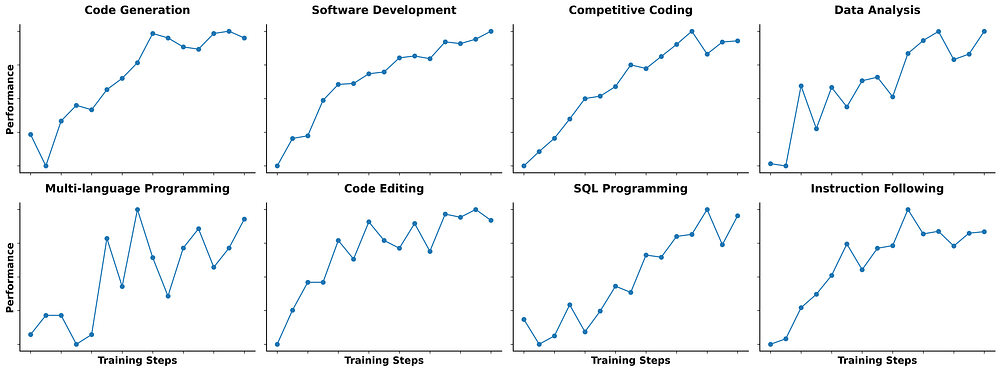

Scaling Code RL

Qwen3-Coder基准测试表现

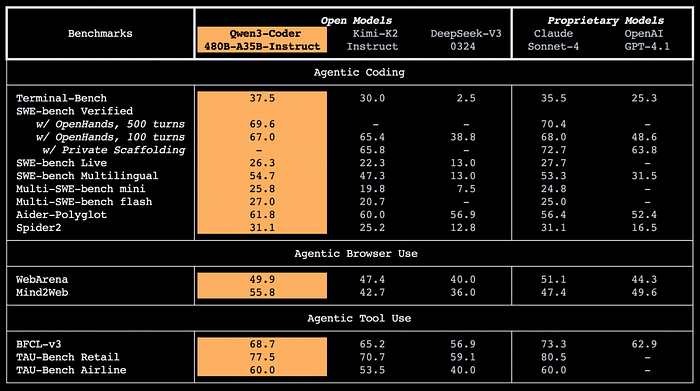

根据官方发布的测试数据显示,Qwen3-Coder 480B-A35B-Instruct在开源智能编程模型中遥遥领先。

Qwen3-Coder Benchmarks. Image from Qwen

具体测试中,Qwen3-Coder在编程任务、浏览器交互及工具使用方面的表现远超其他开源模型,Terminal-Bench评分37.5、Mind2Web评分55.8、TAU-Bench Retail评分达到77.5。

尽管如此,它仍未超越Claude Sonnet-4,后者在复杂任务处理、准确度与细致控制方面更具优势,如在SWE-bench、BFCL等工具测试中仍占领先位置。

总体来看,Qwen3-Coder已处于开源模型领先地位,与Claude差距逐步缩小,但目前还无法完全超越顶级闭源模型。

如何访问Qwen3-Coder?

Qwen团队同时开源了一个命令行编程工具:Qwen Code。

Qwen Code基于Gemini Code进行了定制化改造,新增了专属提示词(prompt)和函数调用协议,更充分发挥Qwen3-Coder的智能编程能力。

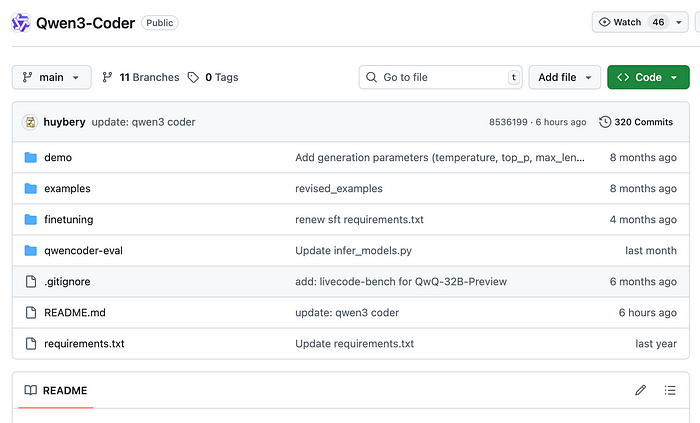

项目现已在GitHub平台开源,目前贡献者26位,Star数量超5600个。

Qwen3-Coder GitHub page. Image by Jim Clyde Monge

克隆项目到本地方法:

复制

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -g

- 1.

- 2.

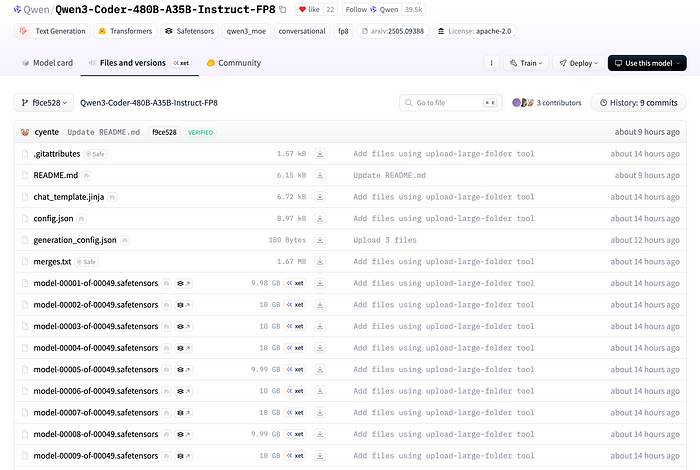

注意:安装时会下载大量约9-10GB大小的Safetensor模型文件,请确保磁盘空间充足。

Qwen3-Coder safetensor files. Image by Jim Clyde Monge

设置环境变量(使用OpenAI SDK调用):

复制

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

- 1.

- 2.

- 3.

然后即可使用命令qwen进行编程。

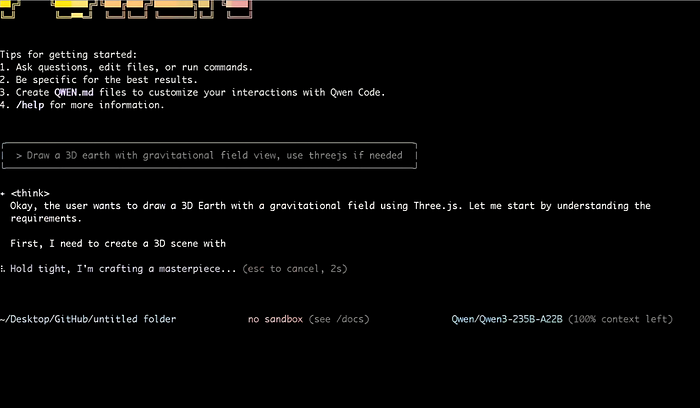

Qwen3-Coder CLI. Image by Jim Clyde Monge

也可以通过HuggingFace或Qwen官方应用在线使用Qwen3-Coder,无需安装。

示例1:与Qwen3-Coder-480B-A35B-Instruct对话

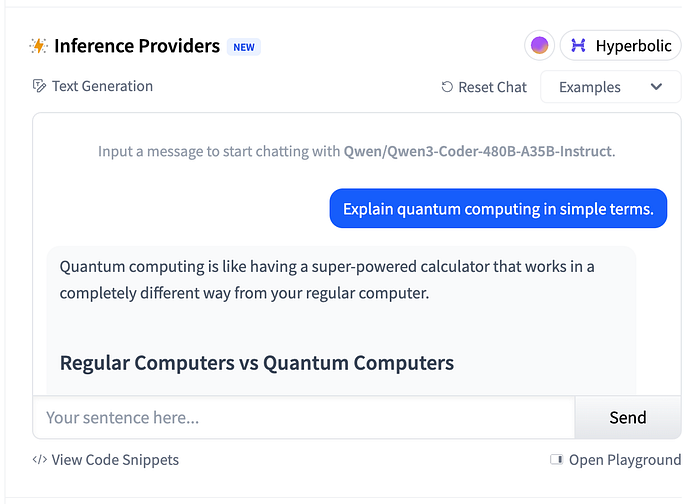

若想测试Qwen3-Coder的聊天能力,可进入官方HuggingFace空间。在页面右侧有聊天窗口,你可以直接向模型提问。

如下例所示:

Qwen3-Coder HuggingFace. Image by Jim Clyde Monge

用户提问:请用简单语言解释一下什么是量子计算。

模型回答:

量子计算就像一台性能超级强悍的计算器,但它的工作方式和普通电脑完全不同。

普通计算机 vs 量子计算机:

- 普通计算机使用的是“比特”(bits),要么为0要么为1,就像电灯开关一样,要么开,要么关。

- 量子计算机使用的是“量子比特”(qubits),它们能同时处于0和1的叠加状态,就像一个旋转的硬币,在落下前同时拥有正面和反面。

量子的神奇特性:

- 叠加:量子比特能同时处于多种状态,因此量子计算机能一次性探索大量可能性。

- 纠缠:量子比特之间有奇特的联系,改变其中一个状态,无论距离多远,另一个都会立刻感知。

- 干涉:量子计算机能够强化正确答案并抵消错误答案,这种现象就像调准电台信号一样,快速准确找到想要的信息。

独特优势:

普通电脑逐步解决问题,而量子计算机能同时探索上千种方案,更高效地解决复杂问题,就像成千上万台电脑同时工作。

现实应用领域:

- 药物研发:模拟分子间的相互作用。

- 密码学:破解现有的加密技术。

- 优化问题:寻找最短路径或最优排程方案。

- 人工智能:更高效地处理海量数据。

当前挑战:

量子计算机十分脆弱,需要极低温环境(接近绝对零度),极易出错,造价昂贵且制造困难。

可以将量子计算视为专用于极为复杂问题的特殊工具,而非日常使用电脑的替代品。

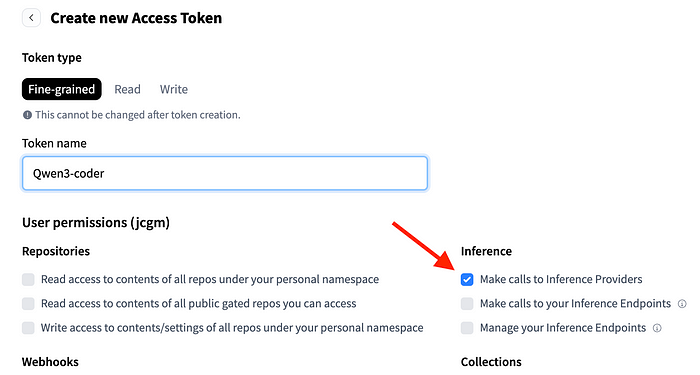

若想通过Playground界面与模型交互,需在HuggingFace官网生成一个免费的推理API访问令牌(Inference API Token),否则模型无法正常回应。

HuggingFace creating API token. Image by Jim Clyde Monge

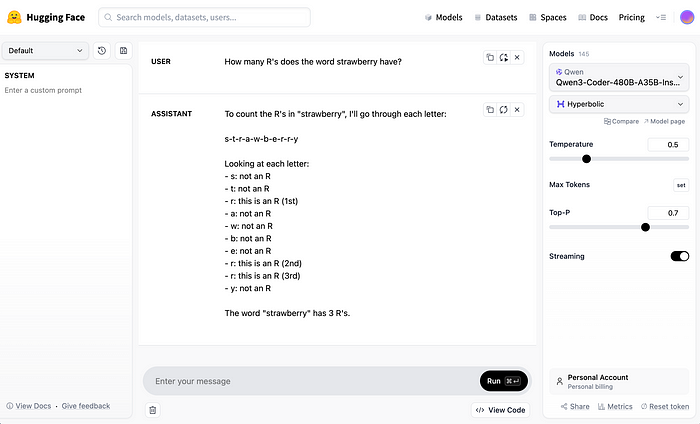

获得令牌后,即可打开Playground界面,并进行更精细的参数调整,如temperature、top-p和token数等。

HuggingFace Qwen3-Coder dashboard. Image by Jim Clyde Monge

用户提问:单词strawberry里面有几个字母R?

模型回答:

单词“strawberry”逐字检查如下:

复制

s-t-r-a-w-b-e-r-r-y

- 1.

- s:不是R

- t:不是R

- r:这是第一个R

- a:不是R

- w:不是R

- b:不是R

- e:不是R

- r:这是第二个R

- r:这是第三个R

- y:不是R

因此,单词“strawberry”共有3个字母R。

示例2:使用Qwen3-Coder快速创建Web应用

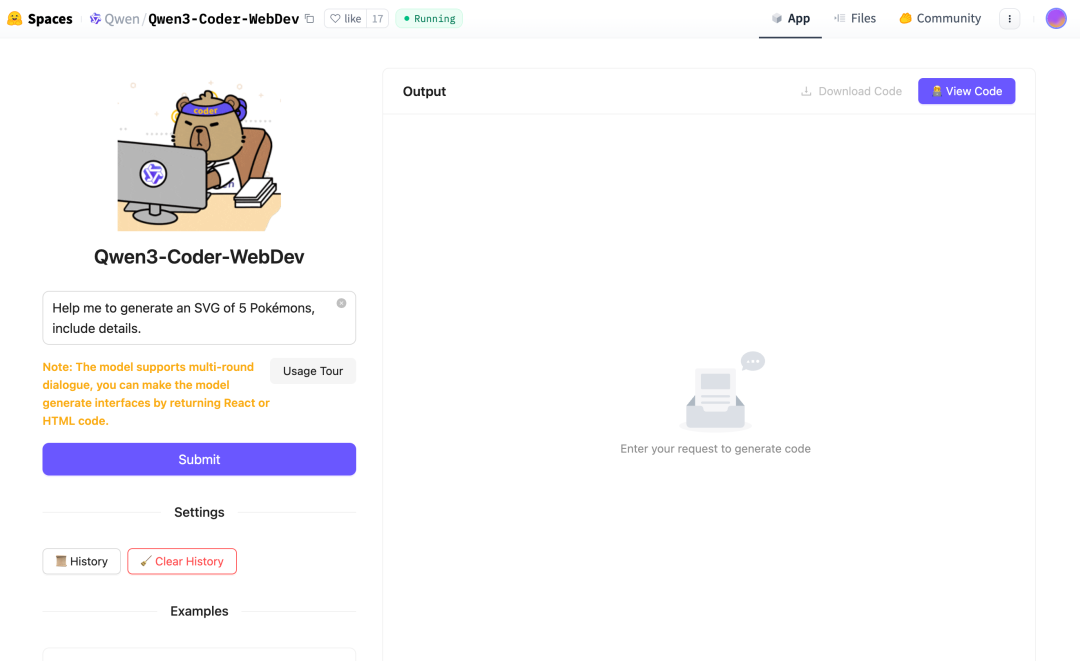

Qwen3-Coder擅长从零开始生成前端Web应用。你可以前往官方HuggingFace空间,直接在Prompt框中描述你想生成的网页或应用。

例如,以下是一个生成包含5只宝可梦(Pokémon)SVG图像的提示示例:

用户输入Prompt: 「帮我生成一个包含5只宝可梦SVG图像的网页,要有详细特征。」

模型很快开始在界面右侧生成完整的HTML/React代码,整个过程大约只需30秒。

图片

以下即为代码运行后的实际效果:

HuggingFace Qwen3-Coder example. Image by Jim Clyde Monge

生成的SVG图案非常细致,每只宝可梦在鼠标悬停时还拥有流畅的动画效果。

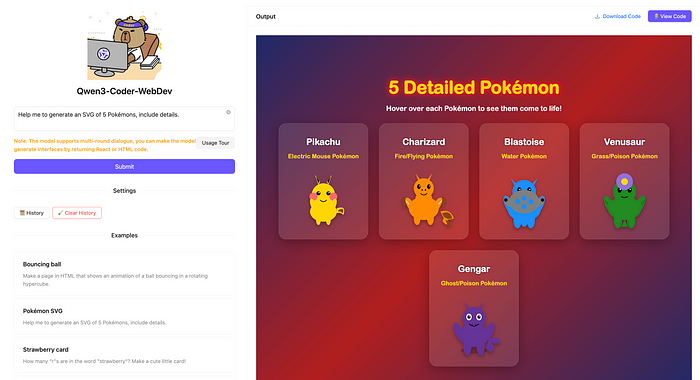

此外,也可在Qwen官方的Chat应用中进行类似操作。登录chat.qwen.ai,选择Qwen3-Coder模型及需要的工具(如创建Web应用、深入研究或图像生成等):

Qwen web app with Qwen3-Coder example. Image by Jim Clyde Monge

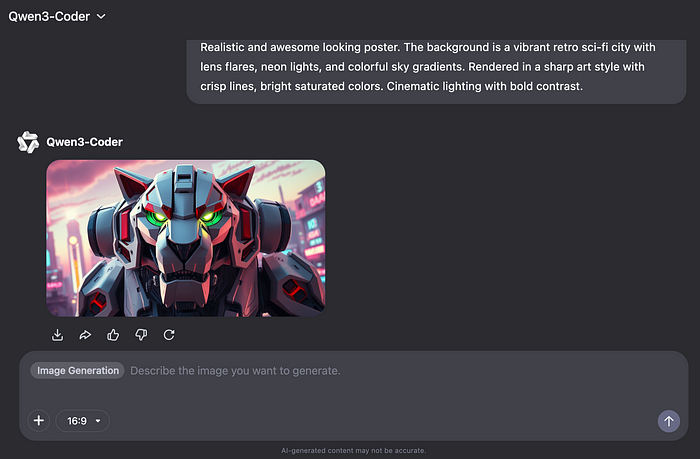

作为测试,再试一下图像生成效果,使用如下Prompt:

Prompt示例: 一个复古未来主义风格的机械狮子特写,灵感来自经典高达动画风格。狮子头部由棱角分明的白色装甲板组成,配以鲜明的红蓝色细节,眼睛为发光的绿色护目镜风格,下方暴露出机械结构。背景是一座霓虹灯装饰的复古科幻城市,有镜头光晕,色彩鲜艳,线条清晰锐利,整体效果震撼,电影级别的光影处理,色彩对比鲜明。

生成的图像效果如下:

Qwen web app with Qwen3-Coder example. Image by Jim Clyde Monge

不过整体质量不尽如人意,相比谷歌Imagen 4、Midjourney等专业图像生成模型还有明显差距。

作为对比,同样的Prompt在Flux Labs AI使用谷歌的Imagen 4生成的效果明显更优质,更准确地体现了原有描述。

Flux Labs image generation example. Image by Jim Clyde Monge

通过对比可见,Qwen3-Coder虽然在代码生成方面表现突出,但图像生成能力仍然较弱。

Qwen3-Coder API费用

Qwen3-coder-plus为官方API商业版,根据输入token数量阶梯定价:

- 上下文窗口:1,048,576 tokens

- 免费额度:激活后180天内100万tokens免费使用

具体费用(每百万tokens):

- 0~32K tokens:输入,输出5

- 32K~128K tokens:输入,输出9

- 128K~256K tokens:输入,输出15

- 256K~1M tokens:输入,输出60

(图片占位)

结语

向Qwen团队致敬,他们开放了Qwen3-Coder的全部权重模型。这对于开源社区和开发者而言意义非凡。其超长上下文虽然诱人,但实际使用场景可能并不常见。

建议开发者尝试一下免费平台,亲自验证Qwen3-Coder在实际编程工作中的表现是否能达到甚至超出预期。

期待Qwen3-Coder未来能与Claude 4 Sonnet更紧密竞争,共同推动智能编程领域发展。

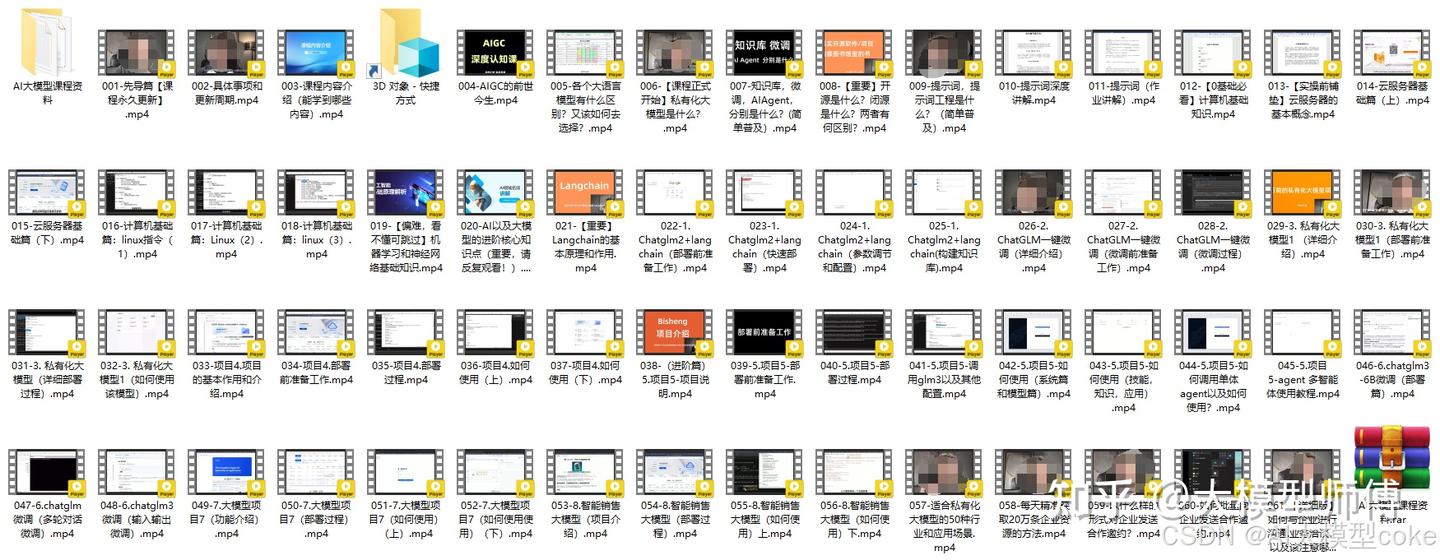

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

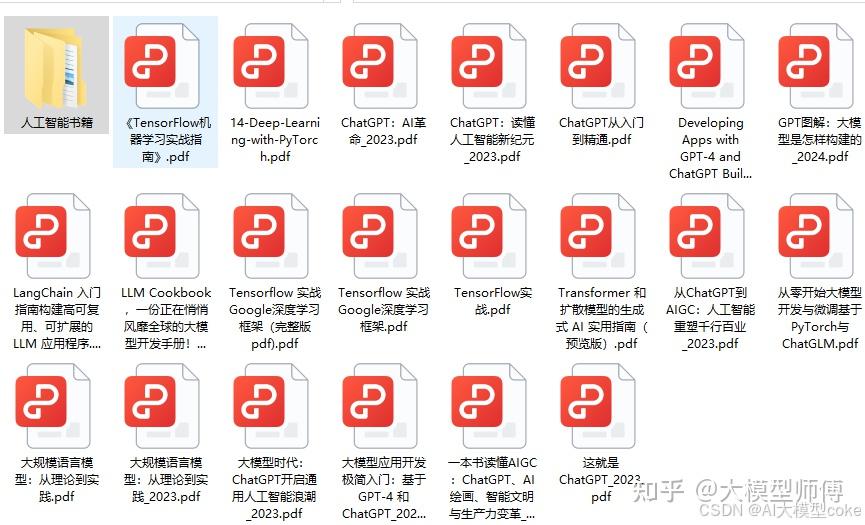

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

4075

4075

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?