有位大佬说过:质量是做出来的,不是测出来的,效能和质量问题往往出双入对。这篇文章,我们将一起讨论如何利用定性与定量的工具,精准定位那些最有可能引发线上风暴的“问题模块”。

引言:从“效能之痛”到“质量之殇”

在上一篇《架构问题的系统性识别方法(一):“坏味道”的架构识别法 —— 从研发效能低下入手》,我们当时的视角,主要聚焦于研发效能,即复杂度是如何拖慢我们前进的步伐的。今天,我们要将视线转向一个比研发效能更严峻、更关乎企业生命线的话题——线上质量与系统稳定性。

想象一下,一个核心流程在线上突然中断、一笔关键的交易数据发生错乱、甚至因为一个隐藏的逻辑漏洞导致公司产生实际的资金损失(资损),这些问题带来的,可能就是灾难性的后果,让每一位技术人惊出一身冷汗的“梦魇”。长此以往,对于企业而言,企业品牌也会受到极大的损伤。

那么,是什么导致了这些可怕的线上问题?是代码质量不高?是测试不到位?这些都只是表象。追根溯源,我们会发现,在一个复杂系统中,大多数线上质量问题的“万恶之源”,都指向同一个幽灵——失控的复杂度。一个过度复杂的系统,就像一片杂草丛生的沼泽地,不仅会让身处其中的开发者步履维艰(影响效能),更可怕的是,沼泽之下隐藏着无数的深坑与流沙(质量风险),随时可能来一次宕机或者资损,让业务、产品、开发都措手不及。

因此,我们将学习一套系统性的方法,将“复杂度”这个模糊的概念,转化为可度量、可管理的“风险指数”。我们将一起讨论如何利用定性与定量的工具,精准定位那些最有可能引发线上风暴的“问题模块”。最终,我们将以一个「堆砌」多年的订单系统为例,全程演示如何分析其风险,并制定出一套“分而治之”的精准治理策略,从而真正实现通过控制复杂度,来守护线上系统的质量与稳定。

一、 重新认知复杂度:从“认知负荷”到“风险之源”

在之前的文章中,我们倾向于将复杂度理解为“认知负荷”,即一段代码、一个模块有多难被人类的大脑所理解。这个视角是正确的,但还不够全面。一个成熟的架构师,必须从两个维度来审视复杂度:

1. 静态复杂度:结构之熵

这是我们通过阅读代码、查看架构图就能感知到的复杂度。它“静静地”躺在我们的代码仓库里,主要体现在结构上。

-

代码层面:巨大的类(上帝类)、超长的方法、极高的圈复杂度、深不可测的继承树、晦涩难懂的算法逻辑等。

-

架构层面:模块间混乱的、网状的依赖关系(循环依赖);服务边界模糊,职责不清;缺乏统一的规范和设计模式。

静态复杂度的主要危害:直接侵蚀研发效能,间接影响质量。它让代码变得难以理解、难以修改、难以测试,是导致“开发一个简单需求耗时很久”、“改一处、崩多处”的直接原因。

2. 动态复杂度:行为之乱

这是系统在运行时表现出的复杂度。它不可见、不可触,却更具破坏力。它体现在系统的行为上,排查问题难度大,有时候甚至完全排查不出来。

-

状态空间爆炸:一个对象或一个流程,有多少种可能的状态?状态之间的转换路径是否清晰、可控?例如,一个订单对象,可能同时拥有“待支付”、“已取消”、“已发货”、“部分退款”等几十种状态,其状态机如果设计混乱,极易产生数据不一致。

-

流程路径繁杂:一段业务逻辑,有多少个

if-else分支?有多少种异常情况?这些分支和异常是否都得到了妥善处理?例如,一个下单流程,可能要同时处理普通商品、预售商品、虚拟商品,每种商品又对应不同的优惠、库存、履约逻辑,这些逻辑交织在一起,形成了一张复杂难懂的决策网络。 -

异步与并发交互:在分布式系统中,多个服务、多个线程之间的交互,充满了不确定性。时序的错乱、消息的丢失或重复、事务的失效等,都会导致难以复现的“幽灵”Bug。

动态复杂度的主要危害:直接威胁线上质量。它正是导致流程中断、数据不一致、资损等严重生产事故的“幕后黑手”。

我们可以用一个“冰山”模型来比喻:静态复杂度是浮在水面上的冰山一角,我们容易看到它对研发效能的影响;而动态复杂度,则是隐藏在水面之下的巨大山体,它看不见、摸不着,却能轻易地给我们的生产航船带来致命一击。架构师的核心任务,就是不仅要看到水面上的冰山,更要探测出水下的巨大风险。

二、 定性分析:绘制系统的“风险地图”

在动用复杂的量化工具之前,我们首先需要一种直观的方式,来“看见”系统中的风险。定性分析,就是帮助我们绘制这幅“风险地图”的过程。

1. 系统依赖关系图:从“连接图”到“爆炸半径图”

我们在之前的文章中已经介绍过依赖关系图。现在,我们要换一个视角来解读它。这张图不再仅仅是模块间的“连接关系图”,而是一张“故障爆炸半径图”,在阿里做大促PM的时候,这是每次促前最重要的工作。

-

识别“枢纽节点”(Hub):图中那些拥有大量“入度”(被很多模块依赖)和“出度”(依赖很多模块)的节点,就是系统的“枢纽”。它们通常是“上帝类”或“上帝服务”。

-

评估“爆炸半径”:一个“枢纽节点”一旦发生故障,其影响范围(爆炸半径)会有多大?它会导致多少上游服务瘫痪?会影响多少下游服务的正常工作?

-

风险解读:一个节点的连接线越多,它在“风险地图”上的颜色就应该越红。它不仅维护成本高(静态复杂度),更是系统中的高危单点故障源(动态风险)。

2. 业务流程全景图:暴露隐藏的“流程断点”

由于,代码和架构图往往会隐藏业务的真实流程,我们需要和产品、业务方一起,将核心的业务流程,毫无遗漏地画出来,并且把异常情况考虑完整。

-

工具:使用BPMN(业务流程建模与标注)或简单的泳道图。

-

要素:不仅要画出正常流程,更要重点标注出所有的分支逻辑、异常路径、补偿事务、人工干预点。

-

风险解读:

-

一张视觉上像“蜘蛛网”一样混乱的流程图,直接暴露了极高的动态复杂度。

-

那些缺乏明确错误处理和补偿机制的异常路径,就是最容易发生流程中断和数据不一致的地方。例如,支付成功了,但扣减库存的下游服务调用失败了,此时如果没有可靠的补偿机制,就会产生数据不一致问题。

-

3. 跨限界上下文交互图:识别脆弱的“通信生命线”

在微服务架构中,服务间的通信是另一个主要的风险来源。我们需要绘制一张图,清晰地标识出不同限界上下文(服务)之间的调用关系。

-

标注通信方式:同步RPC调用?异步消息?

-

标注核心依赖:哪些调用是核心业务流程的“关键路径”?哪些是强依赖,哪些是弱依赖?

-

风险解读:

-

大量同步、长链路的RPC调用,是系统脆弱性的主要来源。链路中任何一个服务出现性能抖动或故障,都会导致整个调用链的“雪崩”。

-

跨越多个上下文的分布式事务,是动态复杂度的“重灾区”,也是数据不一致的高发地。

-

通过这三张图,我们就能从宏观上,定性地识别出系统中哪些区域是“事故高发区”,为我们接下来的定量分析指明方向。

三、 定量分析:为风险“称重”,让数据说话

定性分析给了我们方向,而定量分析则给了我们不容置疑的证据,并帮助我们进行精确的优先级排序。

1. 传统代码度量(静态复杂度)

-

圈复杂度:衡量代码分支的复杂度。一个方法如果圈复杂度超过20,通常就难以被完整测试和理解,隐藏Bug的风险很高。

-

认知复杂度:比圈复杂度更进一步,衡量代码的“理解难度”。它对

try-catch、嵌套、递归等更耗费脑力的结构进行“惩罚”。 -

代码行数(LOC):简单粗暴但有效。一个超过1000行的类,几乎可以肯定它违反了单一职责原则,是一个潜在的“上帝类”。

2. 结合运行时数据的风险度量(动态风险)

仅仅分析静态代码是不够的,我们需要结合系统运行时的“历史表现”,来评估风险。

-

变更频率(Change Frequency):通过分析Git的提交历史,我们可以知道哪些文件或模块是修改最频繁的。

-

缺陷密度(Defect Density):通过关联Jira等缺陷管理系统,我们可以统计出每个模块平均“千行代码的缺陷数”。

-

变更失败率(Change Failure Rate):在部署流水线中,哪些模块的变更最容易导致发布失败或紧急回滚?

现在,我们可以提出一个核心的、量化的风险评估模型:高风险模块 = 高静态复杂度 + 高变更频率 + 高缺陷密度。

一个模块,如果它本身就写得“天书”一样(高静态复杂度),同时又因为业务需要而频繁被不同的人修改(高变更频率),并且历史上就证明了它是个“Bug窝”(高缺陷密度),那么这个模块,就是我们系统中的“定时炸弹”。它不仅会持续吞噬我们的研发效能,更有极高的概率在未来的某次变更中,引发严重的线上事故。

四、 案例实战:解剖一个“千疮百孔”的订单系统

现在,让我们运用今天学到的方法论,来“解剖”一个典型的、迭代了多年的遗留订单系统。

“病患”背景:这是公司的核心OrderService。

-

效能痛点:任何与订单相关的需求,哪怕只是增加一个字段,都需要几周的开发和回归测试。

-

质量“梦魇”:近半年来,它已经引发了3次严重的线上故障,包括“优惠计算错误”导致的资损,“掉单”(订单支付成功但系统未记录)导致的数据不一致,以及“订单状态流转卡死”导致的流程中断。

第一步:定性诊断——绘制“风险全景图”

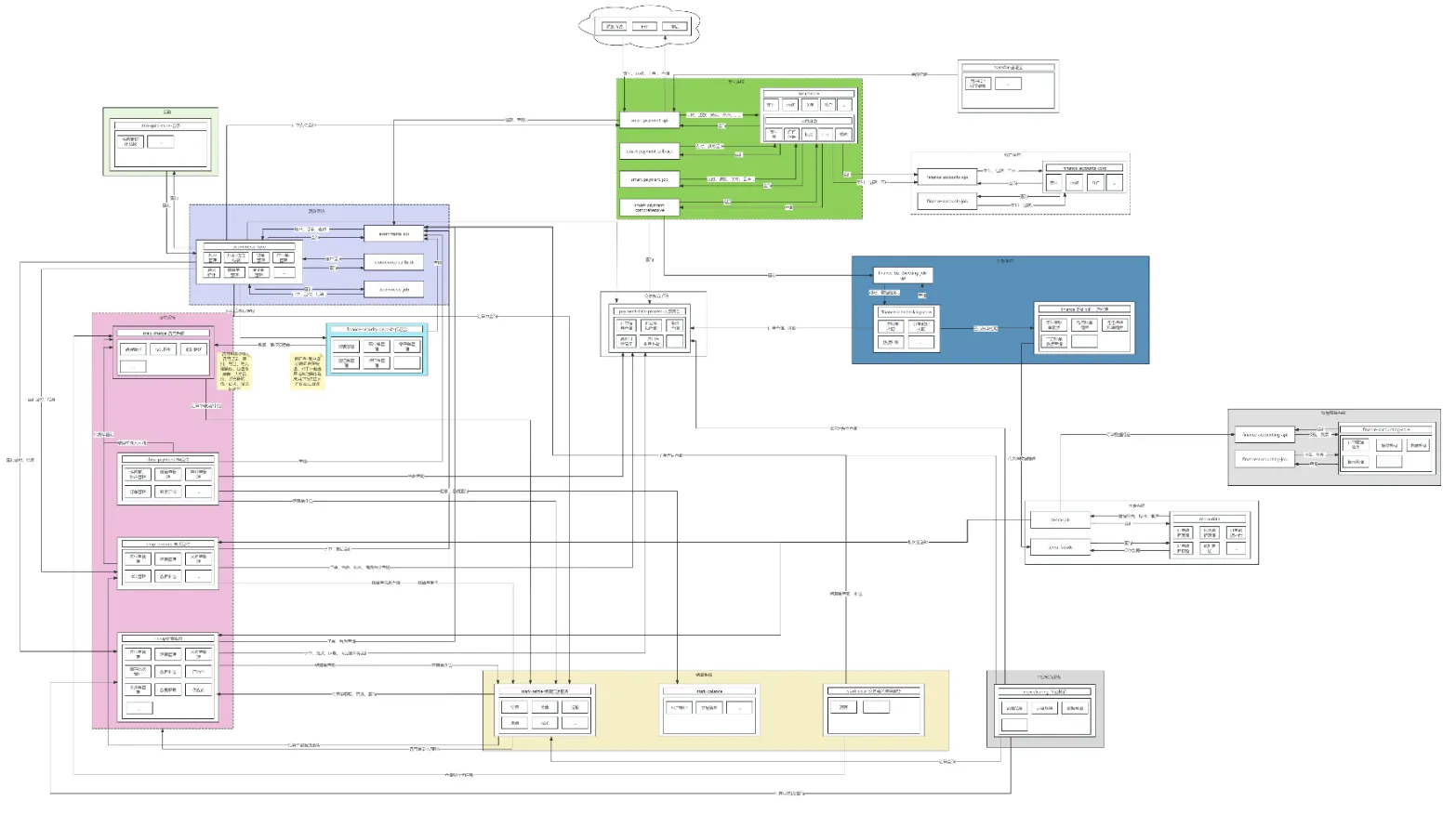

1. 依赖关系图:我们画出了OrderService的依赖图,发现它是一个典型的“上帝服务”。它同步调用了用户、商品、库存、营销、支付、风控、履约等几乎所有核心服务,同时也被大量的下游数据同步任务所依赖。结论:它的“爆炸半径”覆盖了整个公司的核心业务。

2. 业务流程图:我们梳理了其核心的placeOrder()方法对应的业务流程。结果令人震惊:这是一张包含了超过50个逻辑分支的“流程迷宫”,用以处理不同渠道(PC、App、小程序)、不同用户等级、不同商品类型(实物、虚拟、预售)、以及十几种促销活动的排列组合。其中,大量的异常路径没有闭环处理。结论:动态复杂度极高,流程中断风险巨大。

第二步:定量诊断——用数据锁定“病灶”

1. 静态代码分析:我们用SonarQube扫描了代码。OrderService这个类足有5000行,其核心方法placeOrder()的圈复杂度高达128!

2. 运行时风险分析:

-

变更频率:通过分析Git历史,

OrderService.java是过去一年中,整个代码库里被修改次数最多的文件,平均每周都有2次以上的提交。 -

缺陷密度:通过关联Jira,我们发现过去一个季度,有40%的线上Bug,其根源都指向

OrderService。

诊断结论:OrderService是一个集高静态复杂度与高动态风险于一身的、名副其实的“系统级定时炸弹”,是时候要对其进行架构级别的治理了!

第三步:制定“分而治之”的治理策略

我们的目标不是推倒重来(投入大、风险高),而是通过一系列精准的重构,逐步“拆除”炸弹,留下稳定、高效的系统。

1. 识别并剥离核心关注点:我们分析placeOrder()的5000行代码,发现它混杂了至少四个核心职责:

-

订单校验(如库存检查、风控检查、优惠券有效性检查)

-

价格计算(应用各种优惠、计算运费、税费)

-

订单创建(核心的数据持久化操作)

-

下游通知(通知履约、发送短信、增加积分等)

2. 实施策略:从“上帝类”到“微内核+插件”

-

第一阶段:内部重构,职责分离。我们先在

OrderService内部,将上述四大职责,重构成四个独立的内部模块(OrderValidator,PriceCalculator,OrderCreator,OrderNotifier)。此时,placeOrder()方法本身,变成了一个轻量级的、负责编排这四个模块的“协调者”。这一步,极大地降低了静态复杂度,需求来了直接改特定的模块即可,而不再担心改一处影响多处。 -

第二阶段:异步化,斩断同步依赖。我们将

OrderNotifier模块,从同步调用,改造为发布领域事件的异步模式。订单创建成功后,只发布一个OrderCreatedEvent,由下游的履约、积分等系统去订阅和处理。这一步,极大地降低了动态复杂度,消除了长链路同步调用带来的流程中断风险。 -

第三阶段:服务化,拆分限界上下文。随着业务发展,我们发现“价格计算”逻辑本身就极其复杂且多变,与订单复用很多基础模块,而又被订单模块依赖。因此,我们启动一个新项目,将

PriceCalculator模块,正式拆分为一个独立的PriceCenter微服务。OrderService通过RPC调用这个新服务来获取价格。这一步,实现了架构层面的风险隔离,避免问题相互影响。

经过这一系列“手术”,那个曾经庞大、脆弱、危险的“上帝服务”,被成功地拆解、重塑为一个职责清晰、风险可控的现代化订单引擎。

结语:架构师,是系统风险的“首席控制官”

今天,我们为“复杂度”赋予了全新的、更深刻的内涵。我们认识到,它不仅仅是研发效能的“减速带”,更是系统质量的“隐形杀手”。一个对复杂度失控的系统,无论功能多么强大,都像一艘行驶在雷区里的巨轮,随时有倾覆的危险。

作为架构师,我们必须从“功能实现者”的角色,转变为系统风险的“首席控制官”。我们需要熟练地运用定性与定量的分析工具,像经验丰富的医生一样,定期为我们的系统进行“体检”,绘制出精准的“风险地图”,识别出那些最有可能“癌变”的模块。

更重要的是,我们要有推动变革的勇气和智慧。识别问题只是第一步,更艰巨的任务,在于制定出切实可行的、循序渐进的治理方案,并通过持续的重构,逐步拆解风险,为我们的系统构建起一道坚实的“质量防火墙”。这,正是架构师的核心价值所在——不仅要构建功能,更要守护质量。

---------------------

写在最后:关于「架构思维」,我根据过往经验,整理了20篇的文章,公众号已经全部发出,可以关注「架构山海」去看,公众号为主吧。这里也会尽量同步更新。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?