1. 实战概述

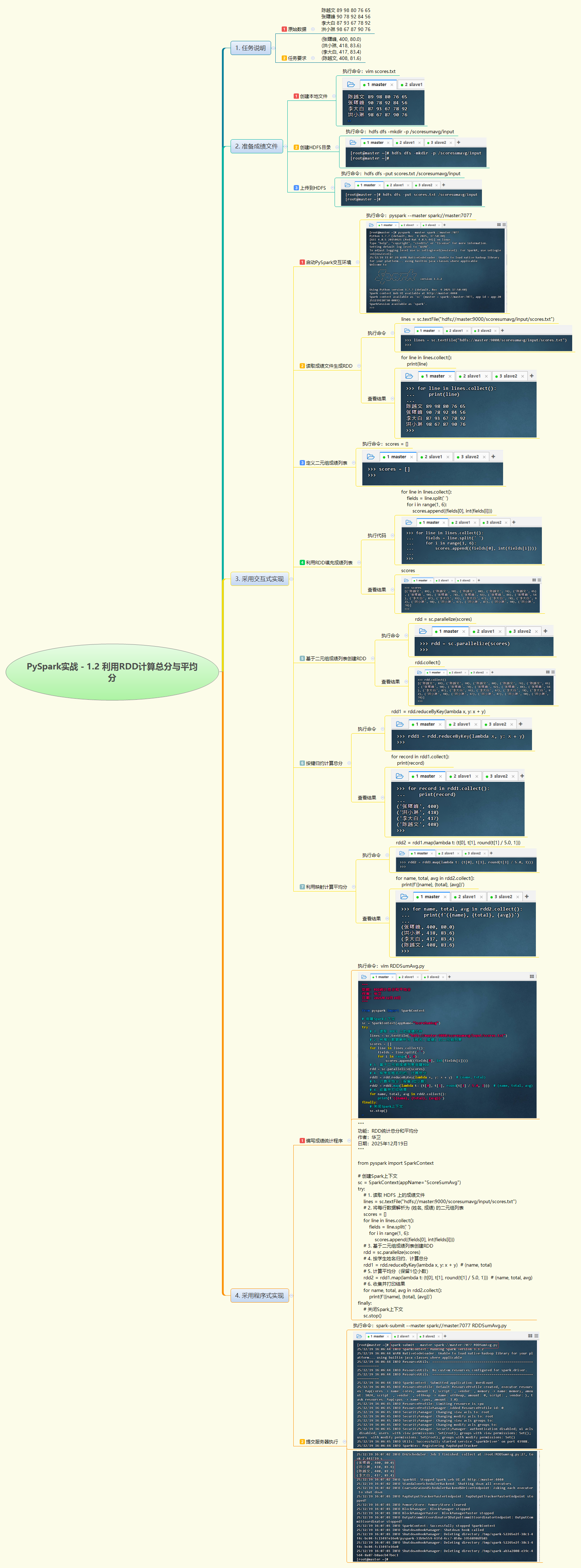

- 本次实战基于 PySpark RDD 实现学生成绩的总分与平均分统计。通过读取 HDFS 上的成绩文件,将每门成绩拆分为(姓名, 分数)二元组,利用

reduceByKey聚合总分,并通过map计算平均分,最终输出每位学生的姓名、总分和保留一位小数的平均分,完整展示了 RDD 的典型数据处理流程。

2. 实战步骤

3. 实战总结

- 本次实战通过交互式与程序式两种方式,深入掌握了 PySpark RDD 的核心操作:从 HDFS 读取文本、解析字段、构建键值对、使用

reduceByKey进行聚合、再通过map衍生新指标。虽然示例中使用了collect()将数据拉回 Driver 构建列表,适用于小规模数据,但在生产环境中应优先采用flatMap等分布式转换避免单点瓶颈。程序成功提交至 Spark Standalone 集群并输出正确结果,验证了 RDD 编程模型在结构化数据统计中的有效性。该任务为后续更复杂的学生成绩分析(如科目排名、及格率等)奠定了坚实基础。

842

842

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?