前言

ERNIE-4.5在GitCode社区发布了,发布地址是:http://gitCode社区ERNIE4.5模型列表

是一个专门的栏目,有整个的ERNIE4.5的模型列表,可以支持各类的应用,并且还可以gitCode平台进行快速部署实操,真的是方便至极,小模型部署不足10分钟即可正式访问,下面我们进入具体操作。

目录

一、易用性——超快速部署ERNIE-4.5-0.3B-Paddle

二、ERNIE-4.5-21B-A3B-Base-Paddle

测试模型说明

整体对三个模型进行了测试,这里是整体的架设过程的基础数据,可供参考。

| 模型型号 | 显卡型号 | 部署时间 | token效率 |

| ERNIE-4.5-0.3B-Paddle | A800 | 实测6分半 | 10次访问均291.4/秒 |

| ERNIE-4.5-21B-A3B-Base-Paddle | A800 | 实测17分钟 | 10次访问均36.72/秒 |

| ERNIE-4.5-VL-28B-A3B-PT | A100 | 实测21分钟 | 未测评 |

所测基础模型参数:

| ERNIE-4.5-0.3B | ERNIE-4.5-21B-A3B-Base | ERNIE-4.5-VL-28B-A3B | |||

|---|---|---|---|---|---|

| 关键字 | 值 | 关键字 | 值 | 关键字 | 值 |

| 模态 | 文本 | 模态 | 文本 | 模态 | 文本 & 视觉 |

| 训练阶段 | 后训练 | 训练阶段 | 预训练 | 训练阶段 | 后训练 |

| 参数量 | 0.36B | 参数量(总 / 激活) | 21B / 3B | 参数(总 / 激活) | 28B / 3B |

| 层数 | 18 | 层数 | 28 | 层数 | 28 |

| 头数 (Q/KV) | 16/2 | 头数(Q/KV) | 20/4 | 头数(Q/KV) | 20/4 |

| 上下文长度 | 131072 | 文本专家(总 / 激活) | 64 / 6 | 文本专家(总 / 激活) | 64 / 6 |

| 视觉专家(总 / 激活) | 64 / 6 | 视觉专家(总 / 激活) | 64 / 6 | ||

| 共享专家 | 2 | 共享专家 | 2 | ||

| 上下文长度 | 131072 | 上下文长度 | 131072 | ||

完整测试视频

文心4.5开源模型易用性评测:0.3至28B模型

一、易用性——超快速部署ERNIE-4.5-0.3B-Paddle

ERNIE-4.5-0.3B 是一个文本密集型后训练模型。

模型地址:GitCode - 全球开发者的开源社区,开源代码托管平台

A100快,但是A800也够用。

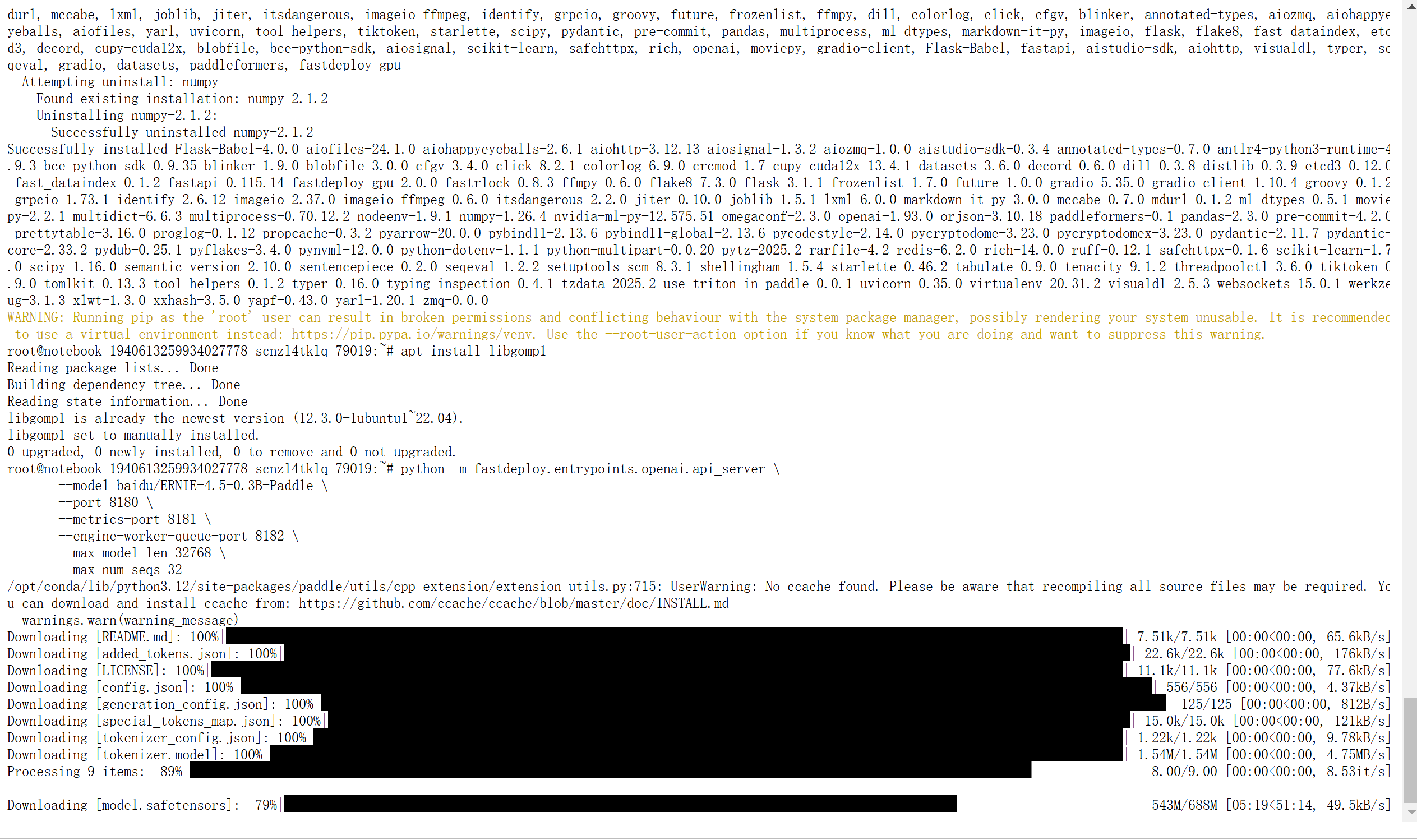

获取的Python命令,如果运行不了就是环境的问题,需要预先安装写环境的依赖,依赖在下方我留下了:

python -m fastdeploy.entrypoints.openai.api_server \

--model baidu/ERNIE-4.5-0.3B-Paddle \

--port 8180 \

--metrics-port 8181 \

--engine-worker-queue-port 8182 \

--max-model-len 32768 \

--max-num-seqs 32依赖下载提示,这个需要依据具体的服务器型号来看啊,在这里有说明:https://github.com/PaddlePaddle/FastDeploy

python -m pip install paddlepaddle-gpu==3.1.0 -i https://www.paddlepaddle.org.cn/packages/stable/cu126/

python -m pip install fastdeploy-gpu -i https://www.paddlepaddle.org.cn/packages/stable/fastdeploy-gpu-80_90/ --extra-index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

apt install libgomp1

需要下载一会,这里就等会吧,可以看到网速还算挺快,网速慢就没法愉快的玩耍了哦。

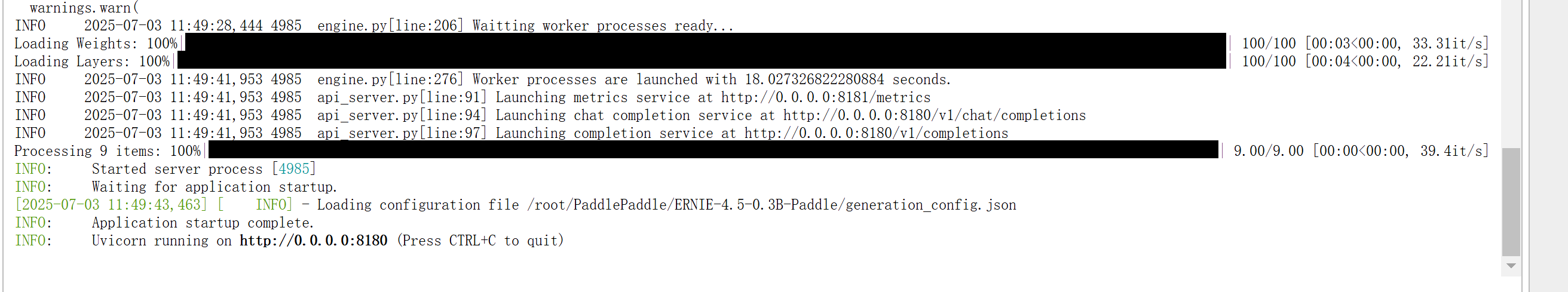

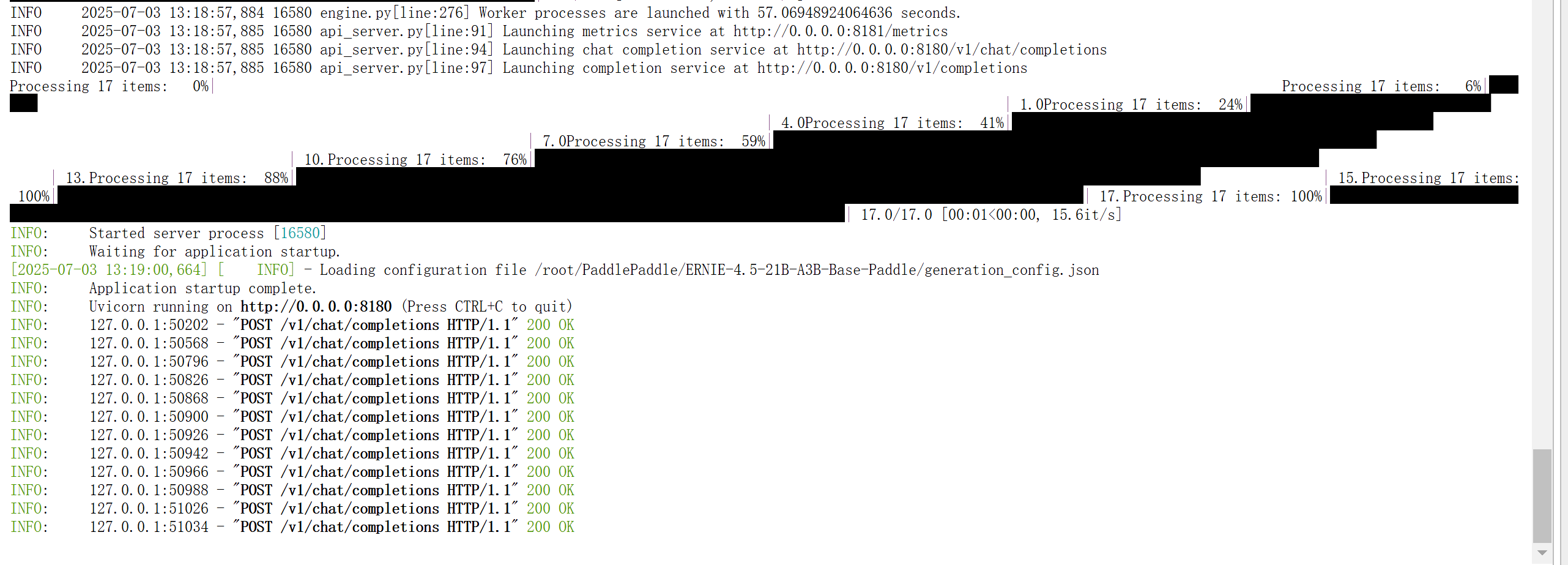

ERNIE-4.5-0.3B-Paddle服务启动

这里我们只需要等待完毕既可以看到对应的服务启动。

可以在最后面看到running的状态,并且有访问路径。

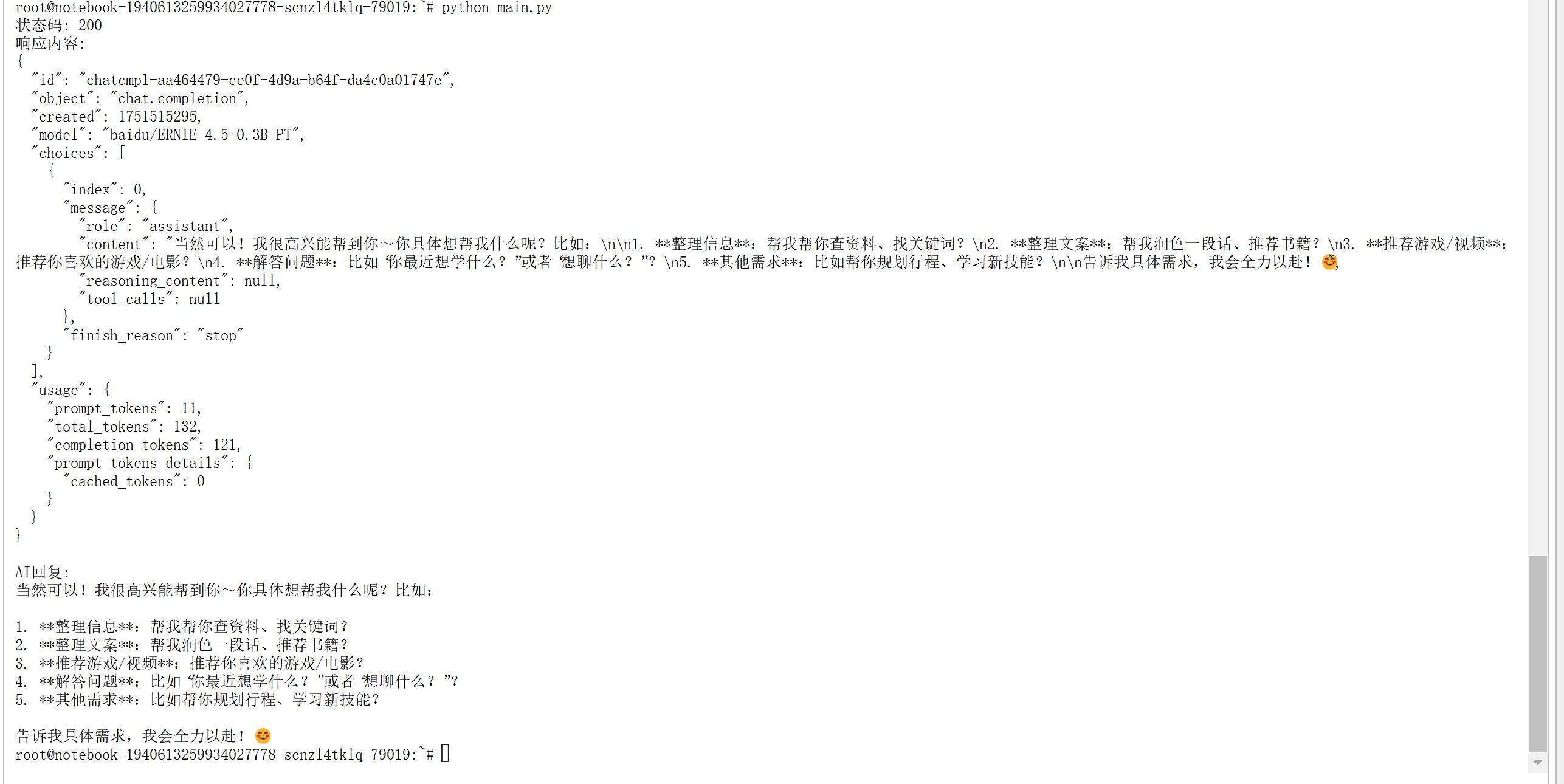

基础访问测试

构建请求代码:

import requests

import json

def main():

# 设置API端点

url = "http://127.0.0.1:8180/v1/chat/completions"

# 设置请求头

headers = {

"Content-Type": "application/json"

}

# 构建请求体

data = {

"model": "baidu/ERNIE-4.5-0.3B-PT",

"messages": [

{

"role": "user",

"content": "你能帮我做什么"

}

]

}

try:

# 发送请求

response = requests.post(url, headers=headers, data=json.dumps(data))

# 检查响应状态

response.raise_for_status()

# 解析响应

result = response.json()

# 打印响应结果

print("状态码:", response.status_code)

print("响应内容:")

print(json.dumps(result, indent=2, ensure_ascii=False))

# 提取并打印AI的回复内容

if "choices" in result and len(result["choices"]) > 0:

ai_message = result["choices"][0]["message"]["content"]

print("\nAI回复:")

print(ai_message)

except requests.exceptions.RequestException as e:

print(f"请求错误: {e}")

except json.JSONDecodeError:

print(f"JSON解析错误,响应内容: {response.text}")

except Exception as e:

print(f"发生错误: {e}")

if __name__ == "__main__":

main()访问效果:

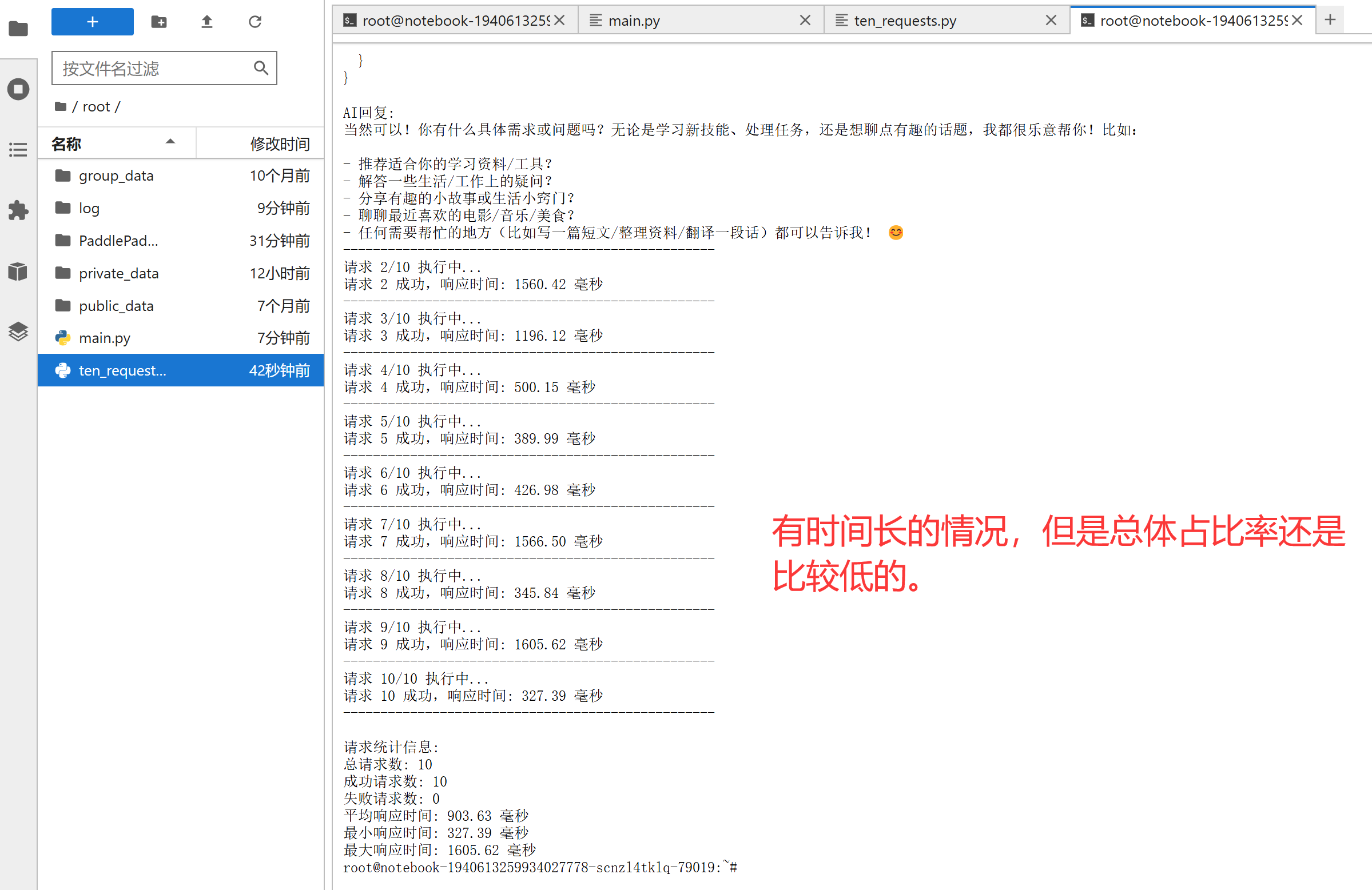

连续请求测试

这里做一个连续请求测试看看效果,连续访问10次。

代码段:

import requests

import json

import time

from statistics import mean

def send_request():

"""发送单次请求并返回响应时间和结果"""

# 设置API端点

url = "http://127.0.0.1:8180/v1/chat/completions"

# 设置请求头

headers = {

"Content-Type": "application/json"

}

# 构建请求体

data = {

"model": "baidu/ERNIE-4.5-0.3B-PT",

"messages": [

{

"role": "user",

"content": "你能帮我做什么"

}

]

}

try:

# 记录开始时间

start_time = time.time()

# 发送请求

response = requests.post(url, headers=headers, data=json.dumps(data))

# 检查响应状态

response.raise_for_status()

# 解析响应

result = response.json()

# 计算响应时间(毫秒)

response_time = (time.time() - start_time) * 1000

return {

"success": True,

"response_time": response_time,

"status_code": response.status_code,

"result": result

}

except requests.exceptions.RequestException as e:

print(f"请求错误: {e}")

return {"success": False, "error": str(e)}

except json.JSONDecodeError as e:

print(f"JSON解析错误: {e}")

return {"success": False, "error": f"JSON解析错误: {str(e)}"}

except Exception as e:

print(f"发生错误: {e}")

return {"success": False, "error": str(e)}

def main():

# 请求次数

request_count = 10

# 存储响应时间

response_times = []

# 存储成功请求数

success_count = 0

print(f"开始执行 {request_count} 次请求...\n")

# 执行多次请求

for i in range(request_count):

print(f"请求 {i+1}/{request_count} 执行中...")

# 发送请求

result = send_request()

if result["success"]:

success_count += 1

response_times.append(result["response_time"])

print(f"请求 {i+1} 成功,响应时间: {result['response_time']:.2f} 毫秒")

# 只打印第一次请求的详细结果

if i == 0:

print("状态码:", result["status_code"])

print("响应内容:")

print(json.dumps(result["result"], indent=2, ensure_ascii=False))

# 提取并打印AI的回复内容

if "choices" in result["result"] and len(result["result"]["choices"]) > 0:

ai_message = result["result"]["choices"][0]["message"]["content"]

print("\nAI回复:")

print(ai_message)

else:

print(f"请求 {i+1} 失败: {result.get('error', '未知错误')}")

print("-" * 50)

# 如果不是最后一次请求,添加短暂延迟以避免请求过于频繁

if i < request_count - 1:

time.sleep(0.5)

# 计算统计信息

if response_times:

avg_response_time = mean(response_times)

min_response_time = min(response_times)

max_response_time = max(response_times)

print("\n请求统计信息:")

print(f"总请求数: {request_count}")

print(f"成功请求数: {success_count}")

print(f"失败请求数: {request_count - success_count}")

print(f"平均响应时间: {avg_response_time:.2f} 毫秒")

print(f"最小响应时间: {min_response_time:.2f} 毫秒")

print(f"最大响应时间: {max_response_time:.2f} 毫秒")

else:

print("\n所有请求均失败,无法计算响应时间统计信息。")

if __name__ == "__main__":

main()效果:

AI回复:

当然可以!你有什么具体需求或问题吗?无论是学习新技能、处理任务,还是想聊点有趣的话题,我都很乐意帮你!比如:- 推荐适合你的学习资料/工具?

- 解答一些生活/工作上的疑问?

- 分享有趣的小故事或生活小窍门?

- 聊聊最近喜欢的电影/音乐/美食?

- 任何需要帮忙的地方(比如写一篇短文/整理资料/翻译一段话)都可以告诉我! 😊

--------------------------------------------------

请求 2/10 执行中...

请求 2 成功,响应时间: 1560.42 毫秒

--------------------------------------------------

请求 3/10 执行中...

请求 3 成功,响应时间: 1196.12 毫秒

--------------------------------------------------

请求 4/10 执行中...

请求 4 成功,响应时间: 500.15 毫秒

--------------------------------------------------

请求 5/10 执行中...

请求 5 成功,响应时间: 389.99 毫秒

--------------------------------------------------

请求 6/10 执行中...

请求 6 成功,响应时间: 426.98 毫秒

--------------------------------------------------

请求 7/10 执行中...

请求 7 成功,响应时间: 1566.50 毫秒

--------------------------------------------------

请求 8/10 执行中...

请求 8 成功,响应时间: 345.84 毫秒

--------------------------------------------------

请求 9/10 执行中...

请求 9 成功,响应时间: 1605.62 毫秒

--------------------------------------------------

请求 10/10 执行中...

请求 10 成功,响应时间: 327.39 毫秒

--------------------------------------------------请求统计信息:

总请求数: 10

成功请求数: 10

失败请求数: 0

平均响应时间: 903.63 毫秒

最小响应时间: 327.39 毫秒

最大响应时间: 1605.62 毫秒

大规模token提问

我们刚才做的是基础测试,这回我来一个大的,共计需要上传的token数量为1277个,这已经是很大的量了,我们依据这些数据计算当前的天气情况。

运势计算

请根据当前的具体黄道信息计算,当前的天气情况。

天干地支:乙巳壬午癸酉午时

属相:蛇

阴历时间:二〇二五年六月初九

具体时辰:12

六壬月:大安

六壬天:空亡

六壬日:速喜

月相:九夜月

物候:半夏生

节气:夏至

三元九运:下元九运

日禄:子命互禄辛命进禄

六爻:友引

七曜:木

彭祖天干:癸不词讼理弱敌强

彭祖地支:酉不会客醉坐颠狂

八字:乙巳壬午癸酉戊午

纳音:覆灯火-杨柳木-剑锋金-天上火

日宜:祭祀

沐浴

理发

整手足甲

修饰垣墙

平治道涂

馀事勿取

日忌:开市

入宅

出行

修造

词讼

时宜:订婚

嫁娶

开市

安葬

修造

时忌:祈福

求嗣

乘船

吉神:民日

天巫

福德

天仓

不将

续世

除神

鸣吠

凶神:劫煞

天贼

五虚

五离

每日相冲生肖:兔

每日相冲方位:东

星宿:獬

星宿吉凶:吉

星宿歌曲:斗星造作主招财

文武官员位鼎台

田宅家财千万进

坟堂修筑贵富来

开门放水招牛马

旺蚕男女主和谐

遇此吉宿来照护

时支福庆永无灾.

阳贵神方位:东南

阴贵神方位:正东

喜神方位:东南

福神方位:东北

财神方位:正南

月胎神:占床仓

今日胎神:房床门外西南

太岁方向:东南

十二值星:平日

北斗九星-年份-九数:三

北斗九星-年份-七色:碧

北斗九星-年份-五行属性:木

方位:正东

北斗九星:天玑

北斗九星名称:禄存

北斗九星-吉凶:凶

北斗九星-奇门:天冲

北斗九星-八门:伤门

北斗九星-八门吉凶:小吉

北斗九星-八门-奇门阴阳:阳

北斗九星-太乙名称:轩辕

北斗九星-太乙类型:安神

北斗九星-太乙九神歌诀:出入会轩辕

凡事必缠牵

相生全不美

相克更忧煎

远行多不利

博彩尽输钱

九天玄女法

句句不虚言.

北斗九星详解:三碧木震(正东)天玑玄空[禄存凶]奇门[天冲小吉伤门阳]太乙[轩辕安神]

整体请求代码

import requests

import json

import time

from statistics import mean

def send_request():

"""发送单次请求并返回响应时间和结果"""

# 设置API端点

url = "http://127.0.0.1:8180/v1/chat/completions"

# 设置请求头

headers = {

"Content-Type": "application/json"

}

# 构建请求体

data = {

"model": "baidu/ERNIE-4.5-0.3B-PT",

"messages": [

{

"role": "user",

"content": """

请根据当前的具体黄道信息计算,当前的天气情况。

天干地支:乙巳壬午癸酉午时

属相:蛇

阴历时间:二〇二五年六月初九

具体时辰:12

六壬月:大安

六壬天:空亡

六壬日:速喜

月相:九夜月

物候:半夏生

节气:夏至

三元九运:下元九运

日禄:子命互禄辛命进禄

六爻:友引

七曜:木

彭祖天干:癸不词讼理弱敌强

彭祖地支:酉不会客醉坐颠狂

八字:乙巳壬午癸酉戊午

纳音:覆灯火-杨柳木-剑锋金-天上火

日宜:祭祀

沐浴

理发

整手足甲

修饰垣墙

平治道涂

馀事勿取

日忌:开市

入宅

出行

修造

词讼

时宜:订婚

嫁娶

开市

安葬

修造

时忌:祈福

求嗣

乘船

吉神:民日

天巫

福德

天仓

不将

续世

除神

鸣吠

凶神:劫煞

天贼

五虚

五离

每日相冲生肖:兔

每日相冲方位:东

星宿:獬

星宿吉凶:吉

星宿歌曲:斗星造作主招财

文武官员位鼎台

田宅家财千万进

坟堂修筑贵富来

开门放水招牛马

旺蚕男女主和谐

遇此吉宿来照护

时支福庆永无灾.

阳贵神方位:东南

阴贵神方位:正东

喜神方位:东南

福神方位:东北

财神方位:正南

月胎神:占床仓

今日胎神:房床门外西南

太岁方向:东南

十二值星:平日

北斗九星-年份-九数:三

北斗九星-年份-七色:碧

北斗九星-年份-五行属性:木

方位:正东

北斗九星:天玑

北斗九星名称:禄存

北斗九星-吉凶:凶

北斗九星-奇门:天冲

北斗九星-八门:伤门

北斗九星-八门吉凶:小吉

北斗九星-八门-奇门阴阳:阳

北斗九星-太乙名称:轩辕

北斗九星-太乙类型:安神

北斗九星-太乙九神歌诀:出入会轩辕

凡事必缠牵

相生全不美

相克更忧煎

远行多不利

博彩尽输钱

九天玄女法

句句不虚言.

北斗九星详解:三碧木震(正东)天玑玄空[禄存凶]奇门[天冲小吉伤门阳]太乙[轩辕安神]

"""

}

]

}

try:

# 记录开始时间

start_time = time.time()

# 发送请求

response = requests.post(url, headers=headers, data=json.dumps(data))

# 检查响应状态

response.raise_for_status()

# 解析响应

result = response.json()

# 计算响应时间(秒)

response_time = time.time() - start_time

# 获取token数量

completion_tokens = result.get('usage', {}).get('completion_tokens', 0)

prompt_tokens = result.get('usage', {}).get('prompt_tokens', 0)

total_tokens = result.get('usage', {}).get('total_tokens', 0)

# 计算每秒token数量

tokens_per_second = total_tokens / response_time if response_time > 0 else 0

return {

"success": True,

"response_time": response_time,

"status_code": response.status_code,

"result": result,

"completion_tokens": completion_tokens,

"prompt_tokens": prompt_tokens,

"total_tokens": total_tokens,

"tokens_per_second": tokens_per_second

}

except requests.exceptions.RequestException as e:

print(f"请求错误: {e}")

return {"success": False, "error": str(e)}

except json.JSONDecodeError as e:

print(f"JSON解析错误: {e}")

return {"success": False, "error": f"JSON解析错误: {str(e)}"}

except Exception as e:

print(f"发生错误: {e}")

return {"success": False, "error": str(e)}

def main():

# 请求次数

request_count = 1

# 存储统计数据

response_times = []

tokens_per_second_list = []

completion_tokens_list = []

prompt_tokens_list = []

total_tokens_list = []

# 存储成功请求数

success_count = 0

print(f"开始执行 {request_count} 次请求...\n")

# 执行多次请求

for i in range(request_count):

print(f"请求 {i+1}/{request_count} 执行中...")

# 发送请求

result = send_request()

if result["success"]:

success_count += 1

response_times.append(result["response_time"])

tokens_per_second_list.append(result["tokens_per_second"])

completion_tokens_list.append(result["completion_tokens"])

prompt_tokens_list.append(result["prompt_tokens"])

total_tokens_list.append(result["total_tokens"])

print(f"请求 {i+1} 成功:")

print(f"响应时间: {result['response_time']:.3f} 秒")

print(f"完成tokens: {result['completion_tokens']}")

print(f"提示tokens: {result['prompt_tokens']}")

print(f"总tokens: {result['total_tokens']}")

print(f"每秒tokens: {result['tokens_per_second']:.2f}")

# 只打印第一次请求的详细结果

if i == 0:

print("\n第一次请求详细信息:")

print("状态码:", result["status_code"])

print("响应内容:")

print(json.dumps(result["result"], indent=2, ensure_ascii=False))

# 提取并打印AI的回复内容

if "choices" in result["result"] and len(result["result"]["choices"]) > 0:

ai_message = result["result"]["choices"][0]["message"]["content"]

print("\nAI回复:")

print(ai_message)

else:

print(f"请求 {i+1} 失败: {result.get('error', '未知错误')}")

print("-" * 50)

# 如果不是最后一次请求,添加短暂延迟以避免请求过于频繁

if i < request_count - 1:

time.sleep(0.5)

# 计算统计信息

if response_times:

avg_response_time = mean(response_times)

min_response_time = min(response_times)

max_response_time = max(response_times)

avg_tokens_per_second = mean(tokens_per_second_list)

avg_completion_tokens = mean(completion_tokens_list)

avg_prompt_tokens = mean(prompt_tokens_list)

avg_total_tokens = mean(total_tokens_list)

print("\n请求统计信息:")

print(f"总请求数: {request_count}")

print(f"成功请求数: {success_count}")

print(f"失败请求数: {request_count - success_count}")

print("\n时间统计:")

print(f"平均响应时间: {avg_response_time:.3f} 秒")

print(f"最小响应时间: {min_response_time:.3f} 秒")

print(f"最大响应时间: {max_response_time:.3f} 秒")

print("\nToken统计:")

print(f"平均完成tokens: {avg_completion_tokens:.1f}")

print(f"平均提示tokens: {avg_prompt_tokens:.1f}")

print(f"平均总tokens: {avg_total_tokens:.1f}")

print(f"平均每秒tokens: {avg_tokens_per_second:.2f}")

else:

print("\n所有请求均失败,无法计算统计信息。")

if __name__ == "__main__":

main()请求效果:

AI回复:

### 当前天气情况

当前时辰为卯时(14:00),此时为黄道吉时,未出现不利天气因素,适宜出行、休息等。### 今日吉宿

今日对应生肖为蛇,与所持吉宿(兔)相冲,即日时冲煞,煞气冲撞不利。### 吉神方位

- **喜神**:东南

- **福神**:东北

- **财神**:正南

- **阳贵神**:东南### 月胎神

方位为房床门外西南,未遇不利之事。### 时支福庆

今日无吉庆之事,福禄寿全无灾。### 十二值星

- **平日**:无

- **三**:木

- **七色**:碧

- **五行属性**:木

- **方位**:正东### 北斗九星

- **正东**:天玑

- **天冲**:伤门

- **小吉**:阳

- **太乙**:轩辕### 吉凶分类

- **凶**:天冲、小吉

- **奇门**:天冲、伤门

- **八门**:无

- **阴阳**:阳### 具体事项

- **沐浴**:可进行

- **理发**:可进行

- **整手足甲**:可进行

- **修饰垣墙**:可进行

- **平治道涂**:可进行

- **馀事勿取**:可进行

- **日忌**:无

- **日宜**:订婚、嫁娶、开市、安葬、修造

- **时忌**:祈福、求嗣、乘船

--------------------------------------------------请求统计信息:

总请求数: 1

成功请求数: 1

失败请求数: 0时间统计:

平均响应时间: 4.063 秒

最小响应时间: 4.063 秒

最大响应时间: 4.063 秒Token统计:

平均完成tokens: 399.0

平均提示tokens: 785.0

平均总tokens: 1184.0

平均每秒tokens: 291.40

回答的结果对的,刚下过雨,雨过天晴,现在是吉时,且响应的时间也还是可以的,毕竟整个上传的token量还是比较大的。

二、ERNIE-4.5-21B-A3B-Base-Paddle

升级一下,现在使用21B的模型,启动方式与0.3b是一样的。

我这里做了几次访问,上下拉动了一下,有些窜行,但能看到具体的版本:

21B文本测试过程

代码部分,这里需要对模型的名称进行修改,再进行分析。

# 构建请求体

data = {

"model": "baidu/ERNIE-4.5-21B-A3B-Base-Paddle",

"messages": [

{

"role": "user",

"content": """

你作为一位人工智能能帮我发财吗?有什么渠道,请简洁的帮我说一下,吸引我的兴趣。

"""

}

]

}AI回复:

作为一位人工智能,我虽然无法直接帮你发财,但我可以为你提供一些可能有助于你实现财务目标的建议和渠道。以下是一些简洁的要点:1. **投资理财**:

- **股票市场**:通过研究公司基本面、行业趋势,选择有潜力的股票进行投资。

- **基金投资**:选择合适的基金产品,如指数基金、混合基金等,分散风险。

- **债券投资**:投资国债、企业债等固定收益类产品,获取稳定收益。2. **创业创新**:

- 寻找市场空白,开发新产品或服务,满足消费者需求。

- 利用人工智能技术,开发智能产品或服务,提高效率,降低成本。3. **技能提升**:

- 持续学习新知识,提升个人技能,增加职场竞争力。

- 参加专业培训课程,获得相关证书,提高薪资待遇。4. **副业赚钱**:

- 利用业余时间,开展副业,如自媒体创作、电商销售、在线教育等。

- 寻找兼职机会,如翻译、设计、编程等,增加收入来源。5. **房地产投资**:

- 购买房产,通过租金收入或房产增值获得收益。

- 关注房地产市场动态,选择合适的投资时机。6. **保险规划**:

- 购买合适的保险产品,如人寿保险、健康保险等,为未来提供保障。

- 了解保险产品的特点和优势,选择适合自己的保险方案。请注意,以上建议仅供参考,具体投资决策需根据个人情况谨慎考虑。同时,投资有风险,入市需谨慎。在追求财务目标的过程中,务必保持理性,避免盲目跟风或冲动投资。

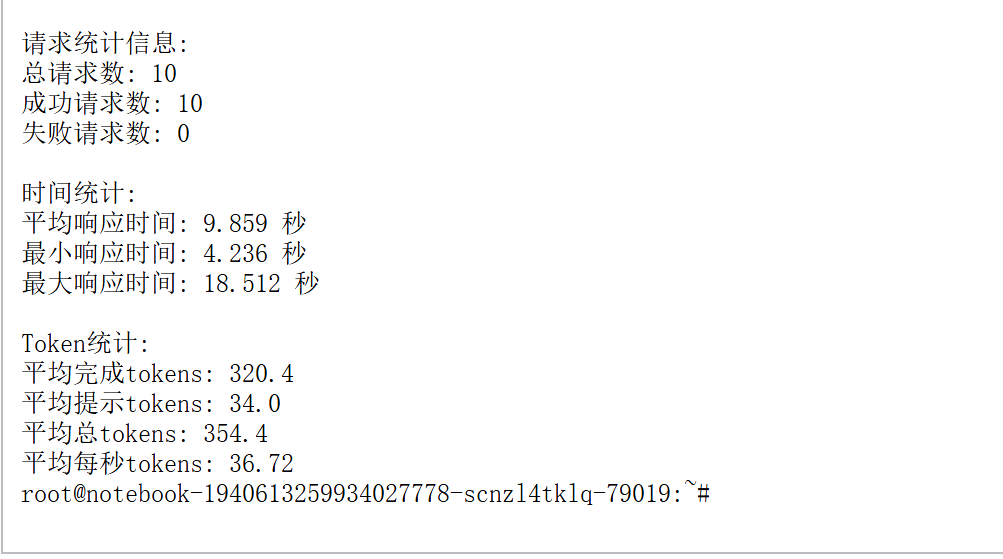

10次访问进行测试:

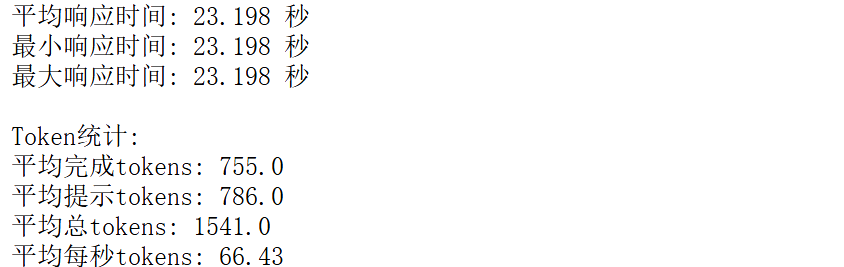

大规模token提问

这次我们进行八方位吉凶的提问:

根据下方的黄道日期,计算当前八方位的吉凶。

天干地支:乙巳壬午癸酉午时

属相:蛇

阴历时间:二〇二五年六月初九

具体时辰:12

六壬月:大安

六壬天:空亡

六壬日:速喜

月相:九夜月

物候:半夏生

节气:夏至

三元九运:下元九运

日禄:子命互禄辛命进禄

六爻:友引

七曜:木

彭祖天干:癸不词讼理弱敌强

彭祖地支:酉不会客醉坐颠狂

八字:乙巳壬午癸酉戊午

纳音:覆灯火-杨柳木-剑锋金-天上火

日宜:祭祀

沐浴

理发

整手足甲

修饰垣墙

平治道涂

馀事勿取

日忌:开市

入宅

出行

修造

词讼

时宜:订婚

嫁娶

开市

安葬

修造

时忌:祈福

求嗣

乘船

吉神:民日

天巫

福德

天仓

不将

续世

除神

鸣吠

凶神:劫煞

天贼

五虚

五离

每日相冲生肖:兔

每日相冲方位:东

星宿:獬

星宿吉凶:吉

星宿歌曲:斗星造作主招财

文武官员位鼎台

田宅家财千万进

坟堂修筑贵富来

开门放水招牛马

旺蚕男女主和谐

遇此吉宿来照护

时支福庆永无灾.

阳贵神方位:东南

阴贵神方位:正东

喜神方位:东南

福神方位:东北

财神方位:正南

月胎神:占床仓

今日胎神:房床门外西南

太岁方向:东南

十二值星:平日

北斗九星-年份-九数:三

北斗九星-年份-七色:碧

北斗九星-年份-五行属性:木

方位:正东

北斗九星:天玑

北斗九星名称:禄存

北斗九星-吉凶:凶

北斗九星-奇门:天冲

北斗九星-八门:伤门

北斗九星-八门吉凶:小吉

北斗九星-八门-奇门阴阳:阳

北斗九星-太乙名称:轩辕

北斗九星-太乙类型:安神

北斗九星-太乙九神歌诀:出入会轩辕

凡事必缠牵

相生全不美

相克更忧煎

远行多不利

博彩尽输钱

九天玄女法

句句不虚言.

北斗九星详解:三碧木震(正东)天玑玄空[禄存凶]奇门[天冲小吉伤门阳]太乙[轩辕安神]请求效果:

根据提供的黄道日期和相关信息,我们可以分析当前八方位的吉凶情况。以下是详细的解析:

### **一、八方位吉凶总览**

| 方位 | 吉凶 | 吉凶详解 |

|------|------|----------|

| **正东** | 凶 | 北斗九星天玑(禄存,凶) |

| **正南** | 小吉 | 八门伤门(阳) |

| **正西** | 吉 | 星宿獬(吉) |

| **正北** | 吉 | 星宿吉凶:吉 |

| **东南** | 吉 | 太乙轩辕(安神) |

| **西南** | 吉 | 星宿吉凶:吉 |

| **西北** | 吉 | 星宿吉凶:吉 |

| **东北** | 吉 | 福神方位东北 |### **二、各方位详细解析**

#### **1. 正东(凶)**

- **北斗九星**:天玑(禄存,凶)

- **奇门**:天冲(小吉)

- **八门**:伤门(阳)

- **太乙**:轩辕(安神)

- **星宿**:獬(吉)

- **吉凶结论**:整体为凶,但星宿吉。#### **2. 正南(小吉)**

- **八门**:伤门(阳)

- **奇门**:天冲(小吉)

- **星宿**:獬(吉)

- **吉凶结论**:小吉,整体偏向吉。#### **3. 正西(吉)**

- **星宿**:獬(吉)

- **吉凶结论**:吉。#### **4. 正北(吉)**

- **星宿**:獬(吉)

- **吉凶结论**:吉。#### **5. 东南(吉)**

- **太乙**:轩辕(安神)

- **星宿**:獬(吉)

- **吉凶结论**:吉。#### **6. 西南(吉)**

- **星宿**:獬(吉)

- **吉凶结论**:吉。#### **7. 西北(吉)**

- **星宿**:獬(吉)

- **吉凶结论**:吉。#### **8. 东北(吉)**

- **福神方位**:东北

- **吉凶结论**:吉。### **三、其他关键信息**

- **星宿**:獬(吉),象征公正与威严,吉星高照。

- **太乙轩辕**:安神,表示安详宁静。

- **北斗九星**:天玑(禄存,凶),需谨慎。

- **八门伤门**:小吉,但需注意不利。### **四、总结**

- **整体吉凶**:以正东为凶,其余方位以吉为主,其中正南、正西、正北、东南、西南、西北、东北均为吉,正东为凶。

- **注意事项**:正东方位需谨慎行事,其余方位可进行重要活动。

回复的比较详细,响应时间23秒,虽然时间稍微长一些,但是整体效果还是非常可以的。

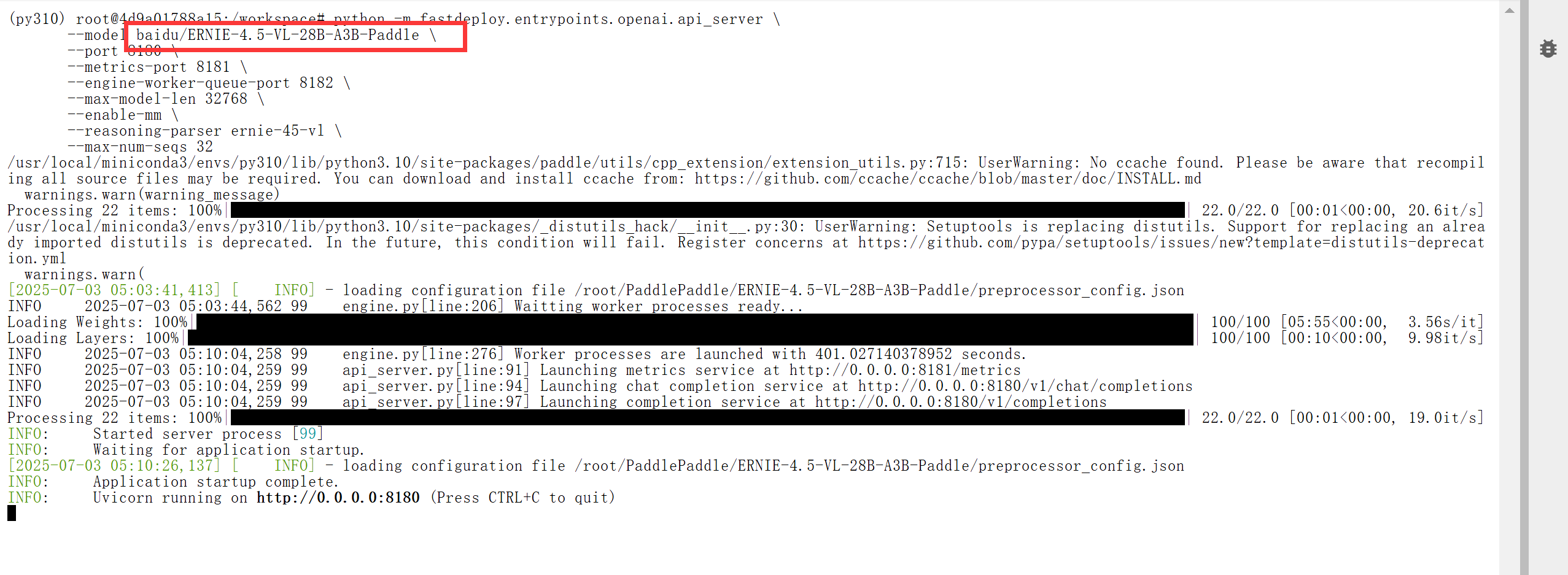

三、ERNIE-4.5-VL-28B-A3B-PT

这回测试个大的:ERNIE-4.5-VL-28B-A3B-PT的支持图像,使用的服务器也要升级一下,这个用A100来跑,这回再来看看效果。

GitCode开源模型地址:GitCode - 全球开发者的开源社区,开源代码托管平台

实际测试

测试代码:

import requests

import json

def main():

# 设置API端点

url = "http://127.0.0.1:8180/v1/chat/completions"

# 设置请求头

headers = {

"Content-Type": "application/json"

}

# 构建请求体

data = {

"model": "baidu/ERNIE-4.5-VL-28B-A3B-PT",

"messages": [

{

"role": "user",

"content": [

{"type": "text", "text": "细致分析,当前的这张图片中门是开着的还是关着的,返回[开] [关]。"},

{"type": "image_url", "image_url": {"url": "door (1).jpg"}},

]

}

]

}

try:

# 发送请求

response = requests.post(url, headers=headers, data=json.dumps(data))

# 检查响应状态

response.raise_for_status()

# 解析响应

result = response.json()

# 打印响应结果

print("状态码:", response.status_code)

print("响应内容:")

print(json.dumps(result, indent=2, ensure_ascii=False))

# 提取并打印AI的回复内容

if "choices" in result and len(result["choices"]) > 0:

ai_message = result["choices"][0]["message"]["content"]

print("\nAI回复:")

print(ai_message)

except requests.exceptions.RequestException as e:

print(f"请求错误: {e}")

except json.JSONDecodeError:

print(f"JSON解析错误,响应内容: {response.text}")

except Exception as e:

print(f"发生错误: {e}")

if __name__ == "__main__":

main()测试图片:

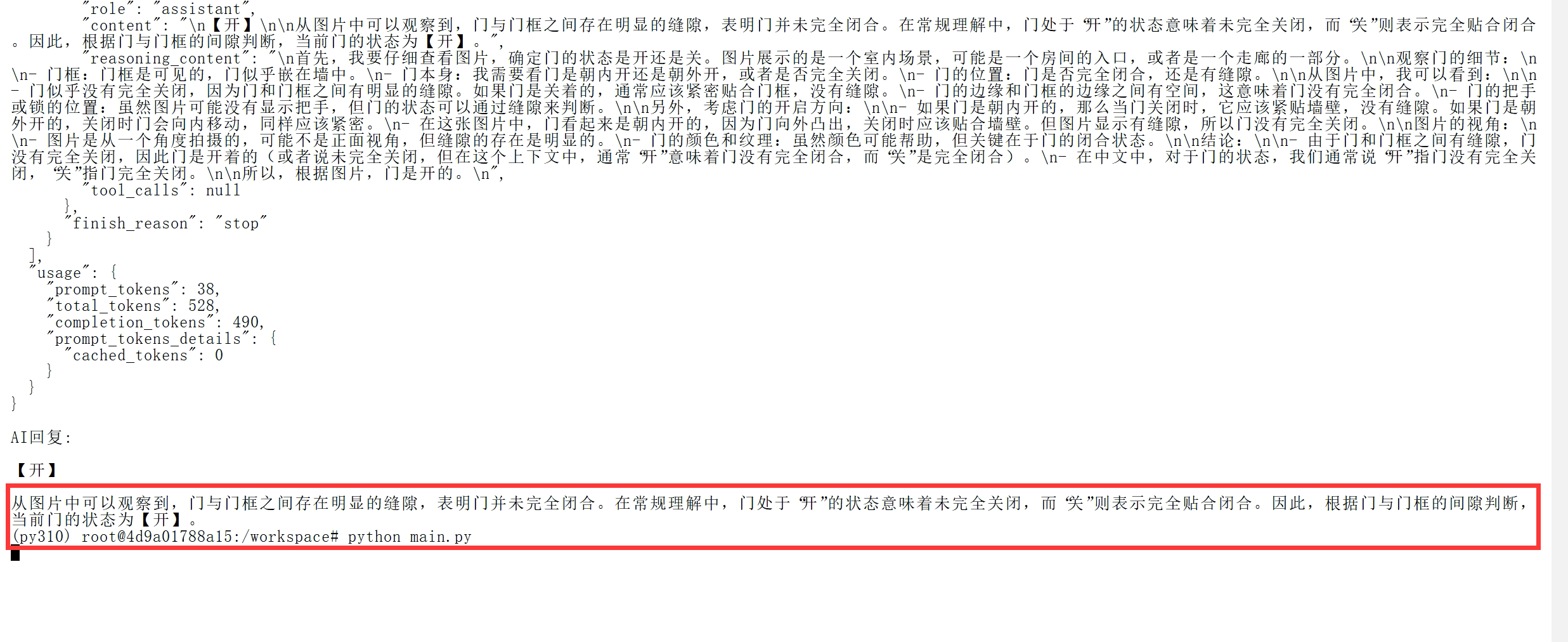

返回结果,从结果中说的【开】最开始我很迷茫,但是后来看了一下,竟然注意到最下面有条缝,并且高度很高。

理解能力相对来说是非常的高的,且很细致。

测试总结

整体测试了三个模型0.3B(文本)、21B(文本)、28B(多模态),其中0.3B部署时间不足10分钟即可正式使用,21B下载的时间稍长也是在20分钟内完成,28B差不多的时间,只有硬件需要匹配一下,相对来说想使用文心开源模型的时间成本非常低,部署起来也很方便,对应的300B和424B没有进行测试,但是毕竟是开源模型针对于一般技术人员,全血版本的企业来跑划算一些,我们跑28B的模型完全够用了呢,本次测评的效果非常不错,强烈推荐哦。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?