本文来源公众号“阿旭算法与机器学习”,仅用于学术分享,侵权删,干货满满。

原文链接:https://mp.weixin.qq.com/s/6o0WTHswc4mHD5VSFEgBQg

导读

Roboflow再度引领计算机视觉新潮流——继RF-DETR目标检测模型大获成功后,全新RF-DETR Seg(预览版)正式登场!它将强大的检测能力扩展至实例分割任务,为各类视觉应用带来更精细、更智能的场景理解。

引言

SOTA实例分割与RF-DETR Seg(预览版)

2025年,Roboflow在计算机视觉领域的突破从未停歇。3月发布了全新顶尖模型架构RF-DETR,初始仅含一个目标检测模型;后续又将其扩展为Nano、Small、Medium、Large四大家庭成员,覆盖不同场景需求。

而现在更令人兴奋的消息是:RF-DETR正式支持实例分割任务,RF-DETR Seg(预览版)重磅上线!

一、颠覆性表现:速度与精度双碾压YOLO11

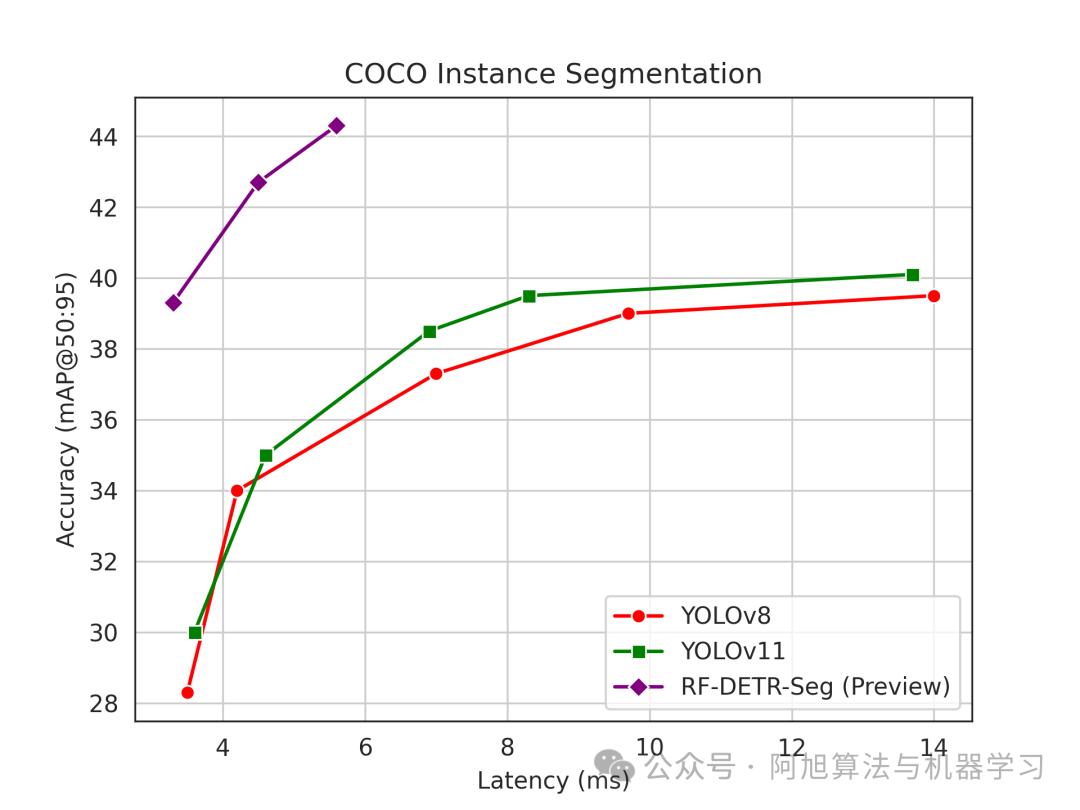

在业界公认的微软COCO分割基准测试中,RF-DETR Seg(预览版)交出了一份堪称“炸裂”的成绩单:

速度是最大型YOLO11的3倍,精度还更高,直接为实时分割模型重新定义了SOTA标准。

图片

更关键的是,它在不同分辨率(312/384/432)下,均能在速度与精度间找到最佳平衡。这里的延迟数据,是在T4 GPU(配备CUDA 12.4)上用TensorRT 10.4实测的端到端延迟,杜绝“理论值”水分。

看两个直观案例:

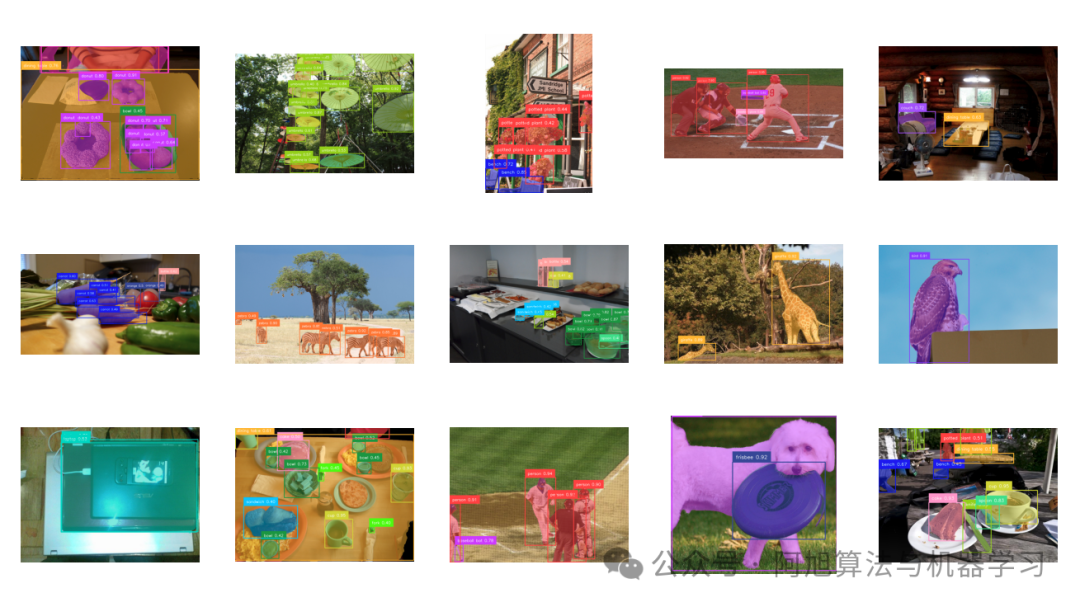

训练完成的RF-DETR Seg(预览版)能精准识别COCO数据集中的各类物体,甚至对细节复杂的场景,也能画出边缘清晰的掩码:

图片

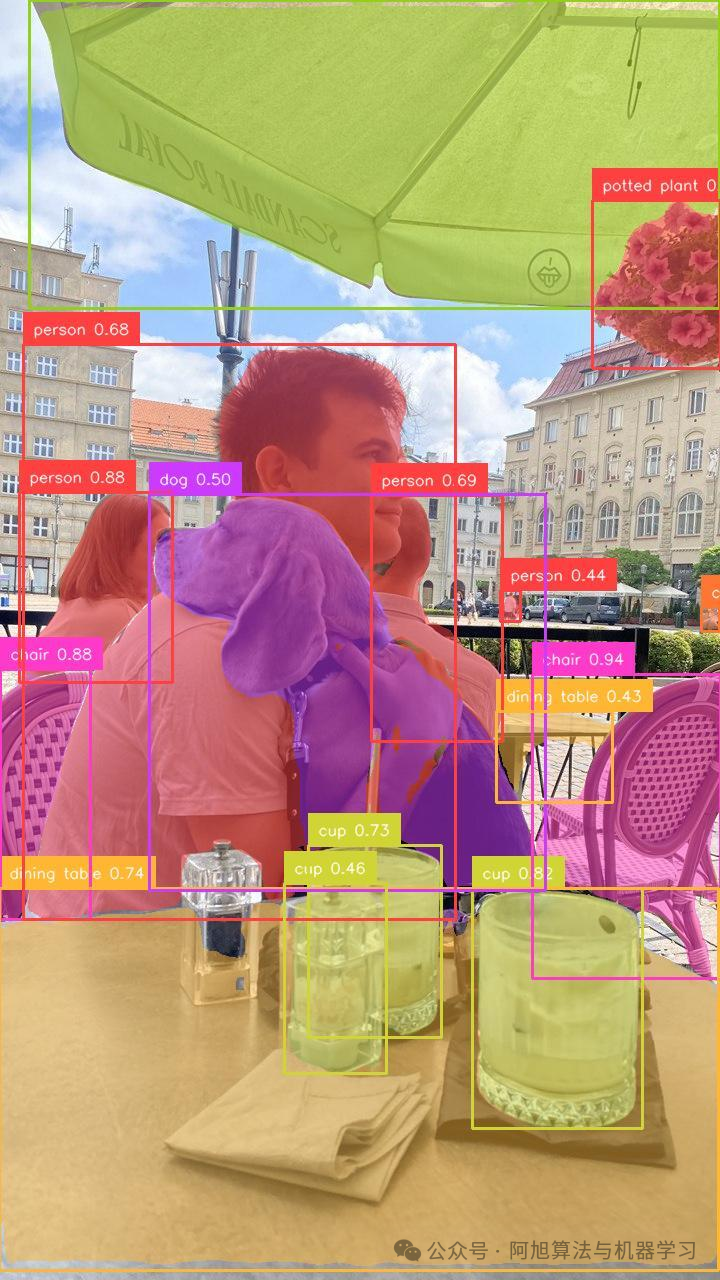

放大单张图像细节,掩码精度更是一目了然——无论是物体边缘的弧度,还是与背景的区分度,都达到了极高水准:

二、RF-DETR Seg核心技术

RF-DETR本身是基于Transformer的实时架构,能灵活适配不同领域、不同大小的数据集。而RF-DETR Seg(预览版)的核心突破,在于新增的“分割头”设计。

1. 首个突破30FPS的DETR系分割模型

在T4机器上,RF-DETR Seg(预览版)端到端延迟仅5.6ms,对应帧率超过170FPS——这是目前首个能在该硬件上达到30FPS以上的DETR类分割模型,彻底打破“高精度必慢”的刻板印象。

2. 两大核心技术创新

RF-DETR Seg的分割头借鉴了MaskDINO的设计,但做了两处关键优化:

-

上采样策略:不同于传统DETR依赖分层主干网络的高分辨率特征,RF-DETR用的是非分层的DINOv2(ViT)主干。我们发现,其目标解码器中的“可变形交叉注意力”会让后主干特征适合双线性插值——通过这种上采样方式,无需主干提供高分辨率特征,也能生成高质量掩码。

-

分层损失设计:现代DETR解码器每层都有独立损失函数优化边界框,RF-DETR Seg也给分割头每层加了“掩码损失”——基于解码器并行层的表示计算掩码,让分割头能逐层优化掩码效果,大幅提升学习效率。

3. 兼顾消费级硬件训练

虽然RF-DETR Seg训练时内存需求比YOLO高(最大批次大小更小),但它不依赖批归一化,支持通过“梯度累积”在消费级硬件上训练——只需比训练基础RF-DETR用更小的批次、更多的梯度累积步骤即可。

三、实测数据:全方位吊打YOLO11分割系列

我们对RF-DETR Seg(预览版)和YOLO11各分割模型做了公平对比:所有测试均用fp16精度,YOLO模型启用融合NMS和0.01置信度阈值,且延迟计算包含“非极大值抑制、掩码生成、掩码裁剪”等全流程(拒绝“后处理不算延迟”的文字游戏)。

结果如下表所示,RF-DETR Seg(预览版)的优势肉眼可见:

| 模型名称 | 报告 延迟 | 报告 mAP | 测量 延迟 | 测量 mAP |

|---|---|---|---|---|

| RF-DETR Seg-预览版@312 | - | - | 3.3 | 39.3 |

| YOLO11n-Seg | 1.8 | 32.0 | 3.6 | 30.0 |

| RF-DETR Seg-预览版@384 | - | - | 4.5 | 42.7 |

| YOLO11s-Seg | 2.9 | 37.8 | 4.6 | 35.0 |

| RF-DETR Seg-预览版@432 | - | - | 5.6 | 44.3 |

| YOLO11m-Seg | 6.3 | 41.5 | 6.9 | 38.5 |

| YOLO11l-Seg | 7.8 | 42.9 | 8.3 | 39.5 |

| YOLO11x-Seg | 15.8 | 43.8 | 13.7 | 40.1 |

划重点:

-

最高配的RF-DETR Seg-预览版@432,mAP(44.3)超过YOLO11x-Seg(40.1),延迟(5.6ms)却只有后者的1/2.4;

-

即使是低分辨率的RF-DETR Seg-预览版@312,也比YOLO11n-Seg快(3.3ms vs 3.6ms),mAP还高出9.3个点!

四、RF-DETR Seg模型训练

目前,RF-DETR Seg(预览版)已支持多平台训练,无论是云端还是本地,都能快速启动。

代码链接:https://github.com/roboflow/rf-detr

1. 安装环境与准备数据集

-

安装更新后的rfdetr Python包:

pip install rfdetr; -

准备数据集:需为COCO分割格式。

2. 开始训练

只需几行代码,就能启动训练(参数可根据需求调整):

from rfdetr import RFDETRSegPreview

# 初始化模型

model = RFDETRSegPreview()

# 启动训练

model.train(

dataset_dir=<你的数据集路径>,

epochs=100, # 训练轮次

batch_size=4, # 批次大小(建议根据硬件调整)

grad_accum_steps=4, # 梯度累积步骤

lr=1e-4, # 学习率

output_dir=<模型输出路径>

)

五、未来规划

RF-DETR Seg(预览版)只是一个开始,未来还有两大计划即将落地:

-

模型家族扩展:10月底前推出包含3个模型的完整RF-DETR Seg家族,覆盖更多场景需求;

-

技术细节公开:10月底前发布RF-DETR的官方论文,详细拆解模型设计思路与技术原理。

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

1661

1661

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?